Apache Hadoop完全分布式集群搭 建

第 1 节 虚拟机环境准备

1、VMware和centos的安装百度搜索相关资料

2. 三台虚拟机(静态IP,关闭防⽕墙,修改主机名,配置免密登录,集群时间同步)

3、安装JDK版本,推荐安装JDK8,并配置环境变量

第 2 节 安装Hadoop

1、将Hadoop安装包上传到Linux服务器,并解压到指定目录,路径可以根据自己的需要进行设置;

2、配置环境变量,添加Hadoop到环境变量 vim /etc/profile

##HADOOP_HOME

export HADOOP_HOME=/opt/lagou/servers/hadoop-2.9.2

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

3、环境变量⽣效

source /etc/profile

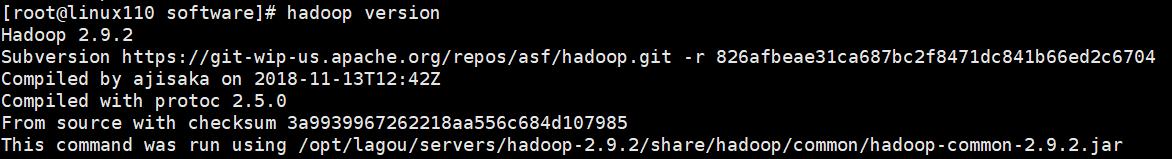

4、查看Hadoop版本是否安装成功

hadoop version

校验结果:

3.1 集群配置

Hadoop集群配置 = HDFS集群配置 + MapReduce集群配置 + Yarn集群配置

HDFS集群配置

1. 将JDK路径明确配置给HDFS(修改hadoop-env.sh)

2. 指定NameNode节点以及数据存储⽬录(修改core-site.xml)

3. 指定SecondaryNameNode节点(修改hdfs-site.xml)

4. 指定DataNode从节点(修改etc/hadoop/slaves⽂件,每个节点配置信息占⼀⾏)

MapReduce集群配置

1. 将JDK路径明确配置给MapReduce(修改mapred-env.sh)

2. 指定MapReduce计算框架运⾏Yarn资源调度框架(修改mapred-site.xml)

Yarn集群配置

1. 将JDK路径明确配置给Yarn(修改yarn-env.sh)

2. 指定ResourceManager⽼⼤节点所在计算机节点(修改yarn-site.xml)

3. 指定NodeManager节点(会通过slaves⽂件内容确定)

集群配置具体步骤:

HDFS集群配置

cd /opt/lagou/servers/hadoop-2.9.2/etc/hadoop

配置:hadoop-env.sh;将JDK路径明确配置给HDFS

vim hadoop-env.sh

export JAVA_HOME=/opt/lagou/servers/jdk1.8.0_231

指定NameNode节点以及数据存储⽬录(修改core-site.xml)

vim core-site.xml <!-- 指定HDFS中NameNode的地址 --> <property> <name>fs.defaultFS</name> <value>hdfs://linux111:9000</value> </property> <!-- 指定Hadoop运⾏时产⽣⽂件的存储⽬录 --> <property> <name>hadoop.tmp.dir</name> <value>/opt/lagou/servers/hadoop-2.9.2/data/tmp</value> </property>

指定secondarynamenode节点(修改hdfs-site.xml)

vim hdfs-site.xml <!-- 指定Hadoop辅助名称节点主机配置 --> <property> <name>dfs.namenode.secondary.http-address</name> <value>linux112:50090</value> </property> <!--副本数量 --> <property> <name>dfs.replication</name> <value>3</value> </property>

指定datanode从节点(修改slaves⽂件,每个节点配置信息占⼀⾏)

vim slaves

linux121

linux122

linux123

注意:该⽂件中添加的内容结尾不允许有空格,⽂件中不允许有空⾏。

MapReduce集群配置 指定MapReduce使⽤的jdk路径(修改mapred-env.sh)

vim mapred-env.sh

export JAVA_HOME=/opt/lagou/servers/jdk1.8.0_231

指定MapReduce计算框架运⾏Yarn资源调度框架(修改mapred-site.xml)

mv mapred-site.xml.template mapred-site.xml vim mapred-site.xml <!-- 指定MR运⾏在Yarn上 --> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property>

Yarn集群配置

指定JDK路径 vim yarn-env.sh export JAVA_HOME=/opt/lagou/servers/jdk1.8.0_231 指定ResourceMnager的master节点信息(修改yarn-site.xml)

vim yarn-site.xml <!-- 指定YARN的ResourceManager的地址 --> <property> <name>yarn.resourcemanager.hostname</name> <value>linux123</value> </property> <!-- Reducer获取数据的⽅式 --> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property>

指定NodeManager节点(slaves⽂件已修改)yarn的文件与hdfs文件公用

注意: Hadoop安装⽬录所属⽤户和所属⽤户组信息,默认是501 dialout,⽽我们操作Hadoop集群的⽤户使 ⽤的是虚拟机的root⽤户, 所以为了避免出现信息混乱,修改Hadoop安装⽬录所属⽤户和⽤户组!!

chown -R root:root /opt/lagou/servers/hadoop-2.9.2

浙公网安备 33010602011771号

浙公网安备 33010602011771号