Towards Open-World Recommendation: An Inductive Model-based Collaborative Filtering Approach阅读笔记

动机

本文是2021年ICML上的一篇论文。通常,推荐系统通过将用户对物品的评分矩阵分解为两个低维隐向量矩阵的乘积(不利用其他信息),然而这种方式使得很难即时处理新用户。作者针对以上问题,提出了为IDCF模型,它的核心思想是对数据集中一部分用户(例如有较多交互数据的用户)进行正常的训练得到embedding表示,再利用这些用户的embedding去加权组合表示其他用户(例如交互数据较少或者没有交互数据的新用户)的embedding,可以将该思想利用在用户冷启动等多个场景下。

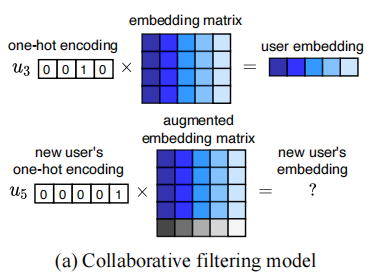

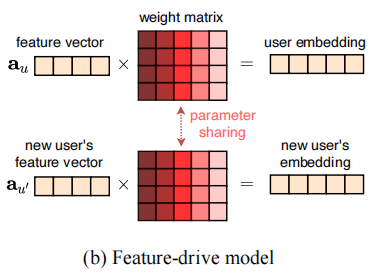

对于协同过滤模型,每个用户都有它们对应的embedding向量,一个新用户可能并没有交互数据,也就没有不会参与到模型训练中,传统的协同过滤模型就很难为新用户进行一个个性化推荐。(直推式学习)

对于基于特征驱动的模型,属性的特征空间是共享的,这可以得到新用户的embedding表示,但是由于隐私关系,高质量的属性很难获取,低质量的属性不足以体现出新用户的个性化特征(例如年龄,相同年纪的人兴趣爱好可能会差别很大)。(归纳式学习)

这里涉及到归纳学习与直推学习,可参考知乎上这个问题如何理解 inductive learning 与 transductive learning?。

算法

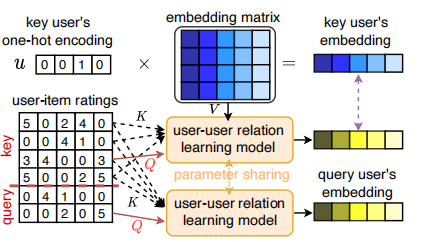

作者提出的IDCF模型吸收了上述两种模型的优点,在不影响表达能力的情况下进行了表示归纳学习。

该方法主要包括两个模型,第一个模型是一个传统的矩阵分解模型,它分解一组用户的评分矩阵,并且获得这组用户的嵌入表示,称其为元隐向量,这组用户称为key用户。在第二个模型中,我们另有一组用户称为query用户,第二个模型是用来学习key用户和query用户之间的关系,可以是一个多头注意力模型。

作者还提出在两种情况下的模型,第一种情况下key用户和query用户是完全不相交的,它适用于处理有少量交互物品的用户的推荐,第二种情况下key用户和query用户是同一批用户,它适用于处理没有交互物品的用户的推荐,这里只针对第一种情况进行介绍。

矩阵分解模型

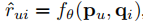

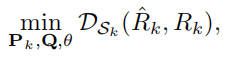

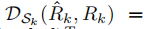

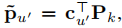

我们有key用户\(\mathcal U_k\),\(|\mathcal U_k|=M_k\),query用户\(\mathcal U_q\),\(|\mathcal U_q|=M_q\),N个物品,\(R_k\)和\(R_q\)分别表示key用户和query用户的评分矩阵。\(p_u\)是用户u的嵌入向量,\(q_i\)是物品i的嵌入向量。用户u对物品i的评分为 ,\(\hat R_k\)是预测评分矩阵,\(P_k\)和\(Q\)分别是key用户的embedding矩阵和物品embedding矩阵,我们的目标是

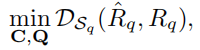

,\(\hat R_k\)是预测评分矩阵,\(P_k\)和\(Q\)分别是key用户的embedding矩阵和物品embedding矩阵,我们的目标是

,即求出物品和用户的embedding及评分函数的参数使得以上损失最小。

,即求出物品和用户的embedding及评分函数的参数使得以上损失最小。

归纳关系模型

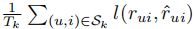

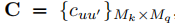

在这个模型中,我们需要求出一个关系矩阵 表示key用户和query用户之间的关系。假设

表示key用户和query用户之间的关系。假设 ,

, ,\(c_{u^{'}}\)表示C中的第\(u^{'}\)列,则query用户\(u^{'}\)可表示为

,\(c_{u^{'}}\)表示C中的第\(u^{'}\)列,则query用户\(u^{'}\)可表示为 ,这一部分我们的目标是

,这一部分我们的目标是

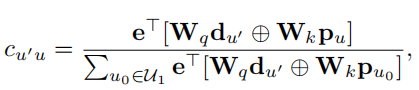

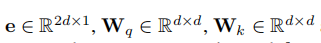

由于C参数较多,很难直接去学习,因此我们使用一个注意力网络来表示参数C

是可训练的参数,⊕表示连接。\(d_{u^{'}}\)是用户\(u^{'}\)交互物品的嵌入表示的和,如果该用户没有任何交互物品(zero-shot),就从所有物品候选集中随机选择一部分物品作为其交互物品。如果用户有辅助信息,例如社交关系、职业、兴趣爱好等等,我们可以利用这些辅助信息作为\(d_{u^{'}}\)。

是可训练的参数,⊕表示连接。\(d_{u^{'}}\)是用户\(u^{'}\)交互物品的嵌入表示的和,如果该用户没有任何交互物品(zero-shot),就从所有物品候选集中随机选择一部分物品作为其交互物品。如果用户有辅助信息,例如社交关系、职业、兴趣爱好等等,我们可以利用这些辅助信息作为\(d_{u^{'}}\)。

实验结果

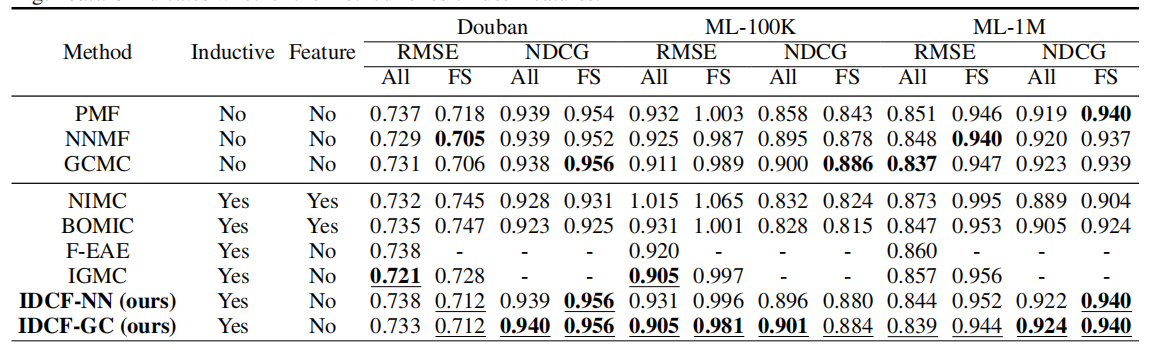

作者分别使用多层感知机和图卷积网络作为\(f_\theta\),即IDCF-NN和IDCF-GC,在五个数据集上做了实验。下面的三个数据集是显示反馈的数据集,作者所提出的归纳学习模型具有与直推学习模型相近的效果。

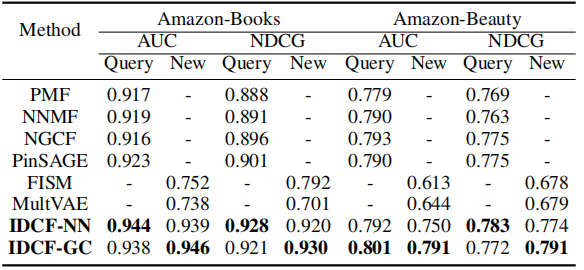

下面的两个数据集是隐式反馈数据集,在这两个数据集上,由于数据更为稀疏,作者所提出的模型效果相比与其他模型会更好一些。

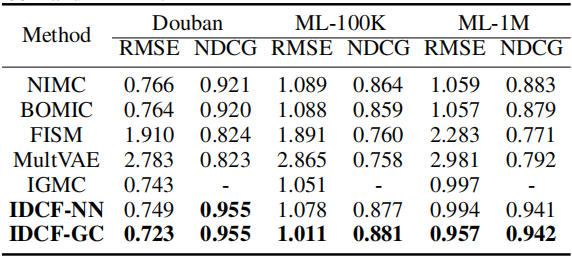

在对于没有参与到训练中的新用户来说,本文作者所提出的模型超越了所有基线模型,这表明IDCF在解决新用户推荐问题方面有更强的能力。

总结

本文核心思想就是利用一部分用户的embedding来计算另一部分用户的embedding,这需要首先选出一部分具有代表性的用户(比如有较多交互的用户)训练一个矩阵分解模型,得到这批用户的embedding,还需要训练一个关系矩阵,学习如何表示zero-shot或者few-shot用户的embedidng,本文的主要目标就是找到一种用户嵌入方法,使得即能使有足够的表达能力,又能在新用户上有较好的泛化能力。本文的这种想法可以用在推荐系统中冷启动场景或是在线推荐中处理新用户。

浙公网安备 33010602011771号

浙公网安备 33010602011771号