LobeChat搭建

说明

lobe-chat 只是一个调用模型服务商api的web ui,可以帮助我们更好的使用AI。

开源地址:https://github.com/lobehub/lobe-chat

步骤

docker search lobe-chat

docker pull lobehub/lobe-chat

docker run -d -p 3210:3210 --name lobe-chat lobehub/lobe-chat

docker ps

访问

相关的key进入网页再配置,不必加入到docker run中。

申请deepseek之后,余额为0会一直回复无效,连给个第一次检测的token都没,一直以为我配置错了,狠狠吐槽。

调试,查看端口是否监听

netstat -tuln

小马算力接入

使用OpenAI的模型,输入自己的key和api,点击检查的时候报错,显示所有的可用模型:

{

"error": "Invalid model: 未找到模型 'gpt-5-nano',可用模型: ['qwen3-32b', 'qwen3-8b', 'deepseek-v3-0324', 'deepseek-r1-0528', 'qwen3-coder-480b', 'glm-4.5', 'deepseek-v3.1', 'kimi-k2-instruct-0905', 'qwen3-next-instruct-svc', 'hunyuan-a13b-instruct']",

"endpoint": "https://api.to****ny.cn/v1",

"provider": "openai"

}

可以看到这个报错是未找到模型 'gpt-5-nano',那我们让他用支持的模型写入 模型列表 即可,直接在对话界面用,不检测。

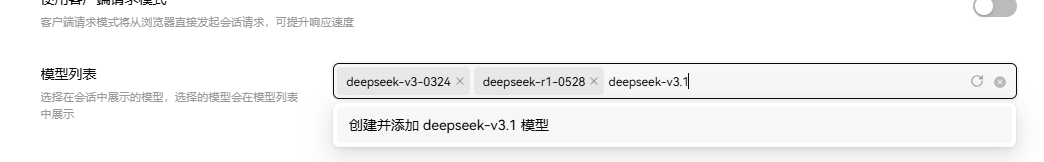

输入对应的模型名称创建即可

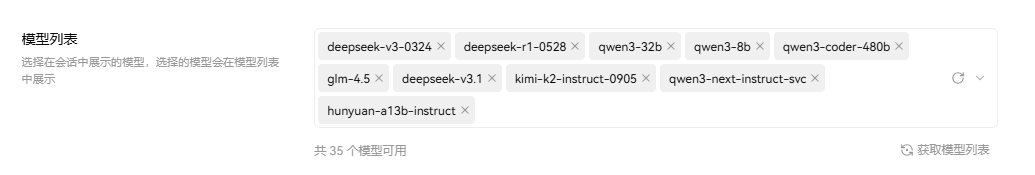

把所有可用的都加入进去:

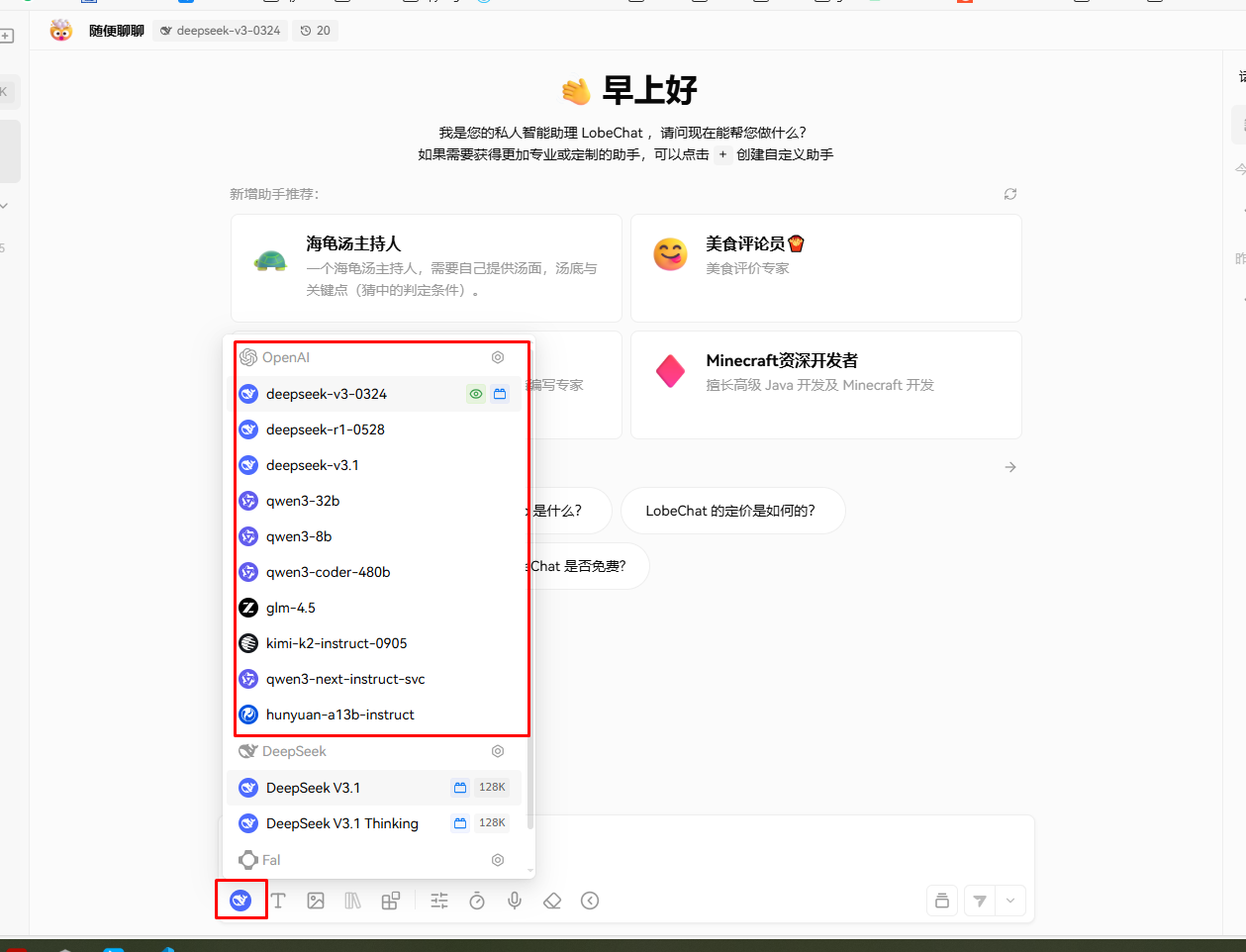

会在对话界面显示的

PS:没有对应模型也会报错。

实际上就是http协议的post请求,请求体中包含模型名称和api key 和模型名称。request即可。

有时候的会话太多,可以 默认话题 命名一下。

本文来自博客园,作者:杨旭0324,转载请注明原文链接:https://www.cnblogs.com/allalonewithyou/p/19100106,个人邮箱:yaonie4444@foxmail.com

浙公网安备 33010602011771号

浙公网安备 33010602011771号