最*调研了不少迁移学*的工作,分享给大家。因为我感觉迁移学*在NLP领域的很多任务中有很大的利用价值,毕竟高质量的标注数据是很少的,而人工标注费时费力,而且质量不一定好。

1. Domain Adaptation 领域自适应

1.1 动机

领域自适应是一种迁移学*,它将不同源领域的数据或特征映射到同一个特征空间,以便于利用其源领域数据或特征来增强目标领域的训练,进而达到更好的训练效果。领域自适应学*不要求训练数据和测试数据一定具有相同的分布。

1.2 目的

利用数据或特征更多的源领域来提升数据或特征相对较少的目标领域的模型性能。

1.3论文和代码

论文:https://arxiv.org/abs/1707.05956,ICCV 2017

代码:https://github.com/poppinace/TAISL

推荐理由:无监督的领域自适应和张量表示。传统的领域自适应一般是针对向量的本文换了一种方式,值得借鉴。

领域自适应在对话系统领域论文也不少,简单推荐几篇:

https://arxiv.org/abs/1609.02846

https://arxiv.org/abs/1808.02586

http://www.aclweb.org/anthology/C18-1103

https://arxiv.org/abs/1111.0048

http://ttic.uchicago.edu/~klivescu/papers/margolis_etal_danlp2010.pdf

2. Online transfer learning 在线迁移学*

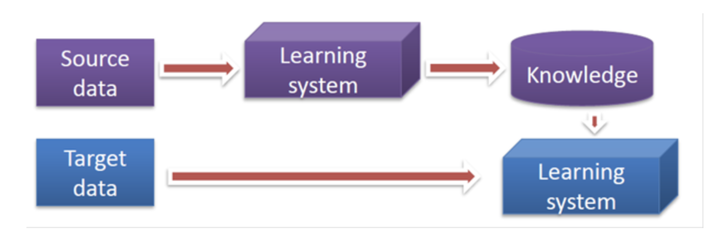

在线迁移学*的框架

2.1 动机

把在线学*和迁移学*相结合,用于训练的源领域的数据在开始训练前并不是全部确定的,而是随着时间的推移而不断增加。

2.2 目的

充分理由源领域的数据进行训练,以便于更好的迁移到目的领域。

2.3 论文和代码

论文:https://icml.cc/Conferences/2010/papers/219.pdf,AIJ 2014.

推荐理由:把在线学*和迁移学*相结合,这更符合很实际情况下源领域数据一点一点源源不断的积累的情况。这是在线迁移学*的第一个公开的研究成果,也是目前最值得学*的研究成果。

3. Lifelong transfer learning 终身迁移学*

3.1动机

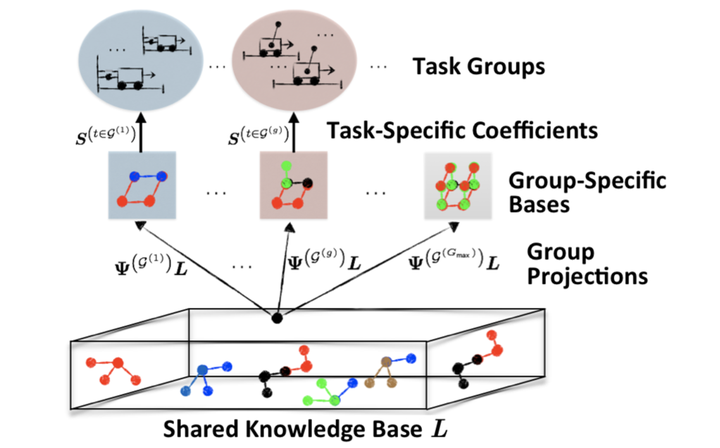

不再单单是在特定领域终身学*,而是通过终身不断的学*来提升源领域到目标领域的迁移效果。

3.2 目的

通过终身不断的学*来增强源领域到目标领域的迁移。

3.3 论文和代码

论文:http://www.cis.upenn.edu/~eeaton/papers/BouAmmar2015Autonomous.pdf, IJCAI 2015.

代码:https://github.com/haithamb/pginterella

推荐理由:终身策略梯度强化学*与自主跨领域知识转移相结合,很适合缺少训练数据的决策类任务,比如任务型对话系统中的DPL(对话策略学*)。目前这方面工作极少,感觉很适合研究。

4. Heterogeneous Transfer Learning 异构迁移学*

4.1 动机

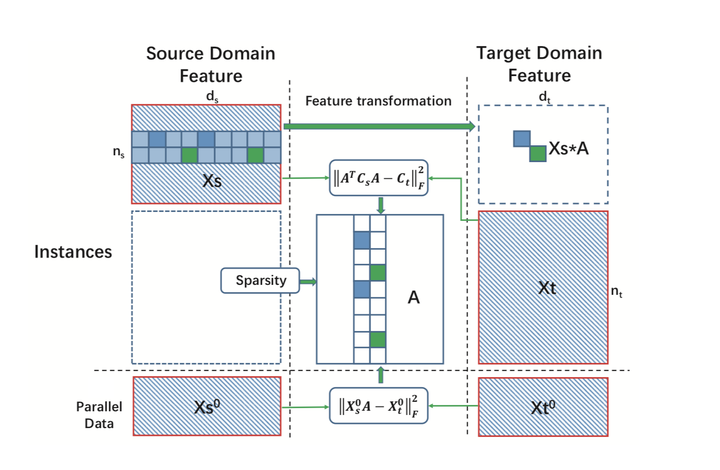

迁移学*一般不要求训练数据和测试数据有相同的分布,而异构迁移学*连训练数据和测试数据的特征维度也不再要求一样。

4.2 目的

训练数据和测试数据的特征维度也允许不同,这样更有利于扩大迁移学*的适用范围。

4.3 论文和代码

论文:http://proceedings.mlr.press/v95/shen18b/shen18b.pdf, ACML 2018。

代码:https://github.com/Isilendil/OSTL

推荐理由:基于稀疏特征变换的无监督异构域自适应,用稀疏特征变换来做异构迁移学*很贴*实际情况。

5. Deep Transfer Learning 深度迁移学*

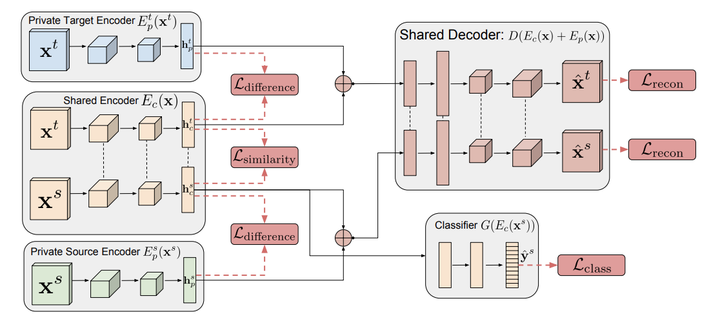

5.1 动机

深度学*具有非常强的数据拟合能力,可学*到泛化能力更强的特征表达,而迁移学*能学*到领域无关的特征表达。如果通过深度神经网络利用其他领域的知识,能充分利用神经网络来学*所有领域共同具有的特征表示。

5.2 目的

将深度学*与迁移学*相结合,同时利用深度学*和迁移学*的优势。

5.3 论文和代码

论文:https://arxiv.org/abs/1608.06019,NIPS 2016。

代码:https://github.com/tensorflow/models/tree/master/research/domain_adaptation

推荐理由:

6. Reinforcement Transfer Learning 强化迁移学*

6.1 动机

强化学*需要多步决策,其实在决策时如果数据较少,可能可以尝试策略的迁移学*。

6.2 目的

将强化学*与迁移学*相结合,同时利用强化学*和迁移学*的优势。

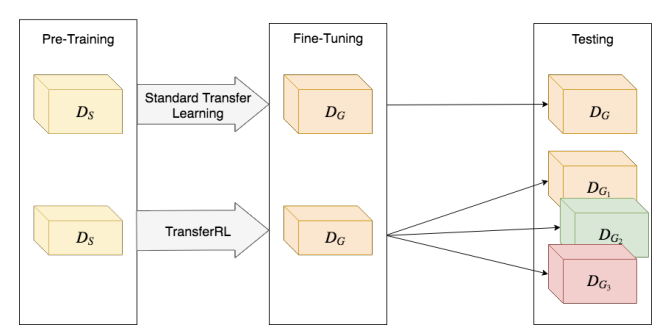

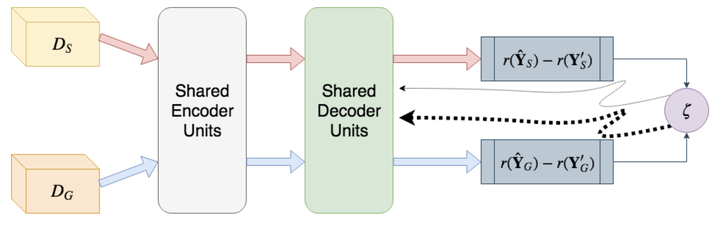

6.3 论文和代码

论文:https://arxiv.org/abs/1810.06667,arXiv 1810.06667。

代码:https://github.com/yaserkl/TransferRL

推荐理由:深度学*+强化学*+迁移学*做文本的自动摘要,充分理由三者的优势互补,很适合学*。

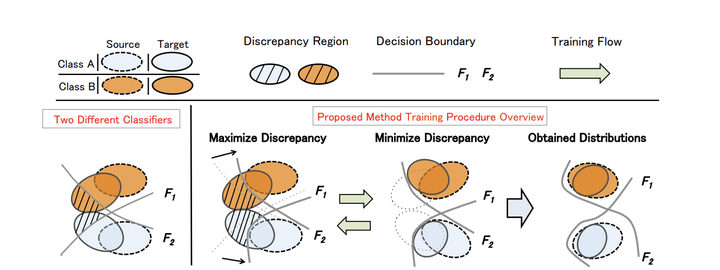

7. Adversarial transfer learning 对抗迁移学*

7.1 动机

迁移学*一般是单向的迁移,那么如果双向进行对抗的迁移学*的话,效果可能会更好,因为可以互相迁移而共享共有的数据和特征。

7.2 目的

双向对抗的迁移学*,尽最大努力的充分利用源领域和目标领域的数据和特征。

7.3 论文和代码

论文:https://arxiv.org/abs/1712.02560

代码:https://github.com/mil-tokyo/MCD_DA

推荐理由:无监督领域自适应的最大分类器差异,让分类器之间不断对抗迁移,以便于提升效果。

浙公网安备 33010602011771号

浙公网安备 33010602011771号