大模型测试评估

目录

概念

以一个例子,做一个分类器,判断是否为汉堡的图片

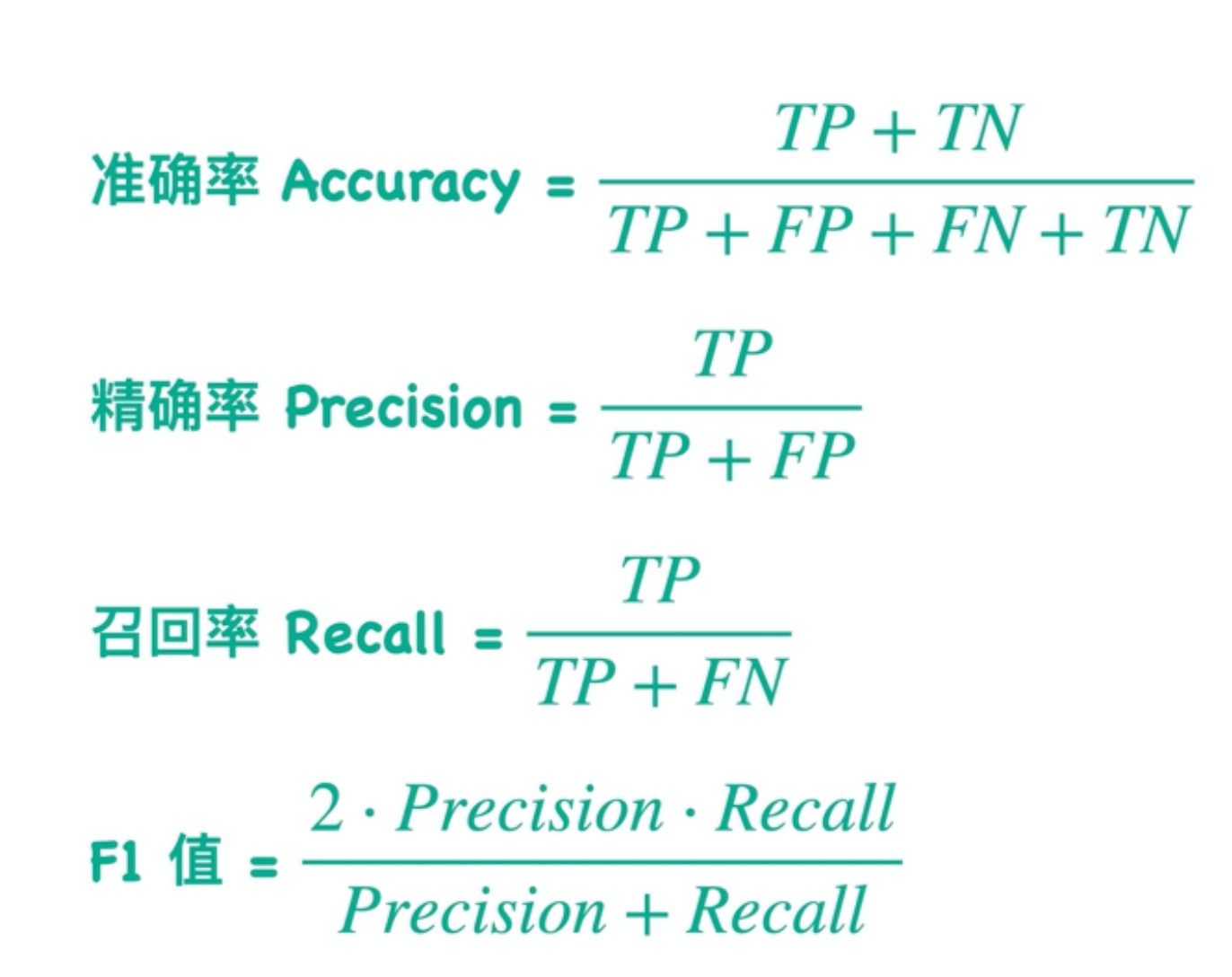

准确率

分对了多少的百分比。 把真实类别和预测样本相同的挑出来 / 测试集总体的样本总数

精确率

我有个搜索引擎,搜索汉堡,返回的所有汉堡的图片。我们关注返回汉堡里面正确的有多少,叫精确率

返回汉堡的图片 / 返回所有的图片数目

召回率

多少张应该返回多少张图片但是没有找到。

返回汉堡的数目/测试集所有汉堡的数目

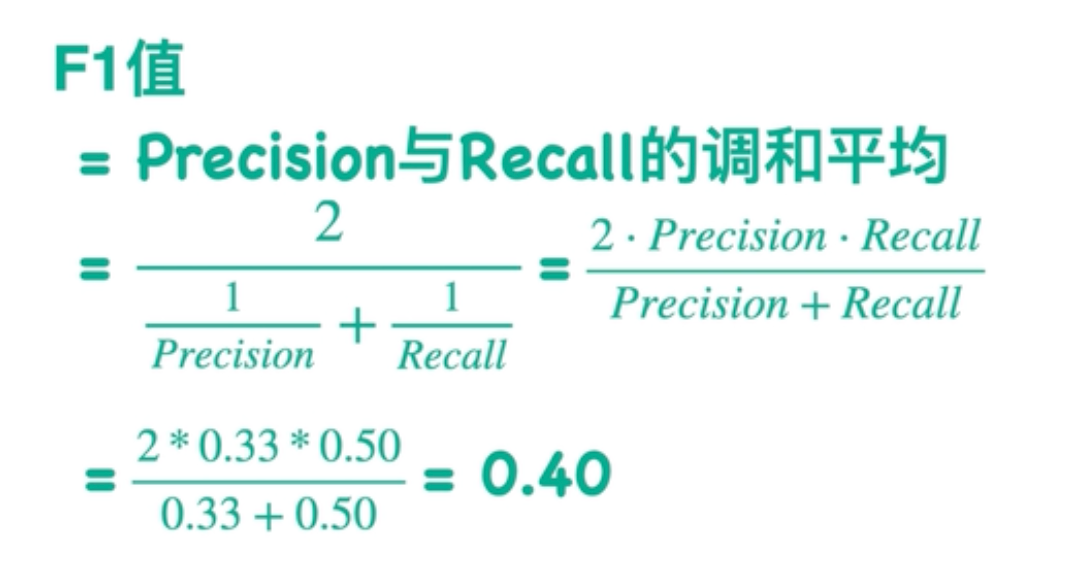

F1

精确率和准确率此消彼长,不能一位追求某个值,而是追求精确率和召回率的平衡。 比如我搜索汉堡的时候,把所有的图片都返回,这样没有意义了。

在不同的场景下F1值是不一样的。比如在医疗领域,我们希望不放过1个患者,recall 是1,

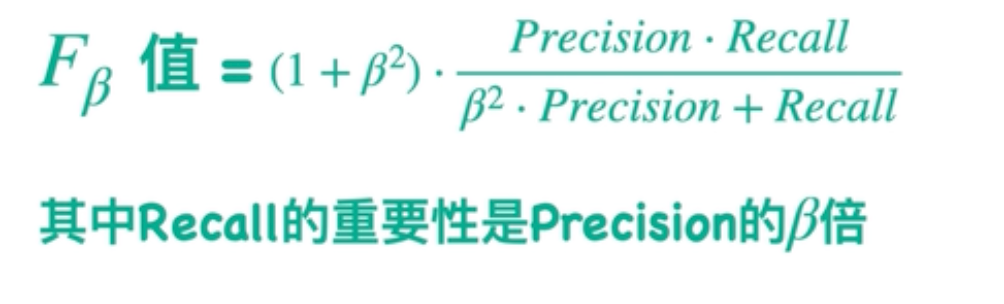

F1是Fb的特殊情况。

要理解 ( F_\beta ) 中 ( \beta ) 的取值范围,需从其定义和作用出发:

( \beta ) 是正实数,即 ( \beta > 0 )。

它的核心作用是调整“召回率(Recall)”相对于“精确率(Precision)”的重要性权重:

- 当 ( \beta = 1 ) 时,是最常用的 ( F_1 ) 分数,精确率和召回率权重相等;

- 当 ( \beta > 1 ) 时,召回率的重要性更高(如 ( \beta = 2 ) 时,召回率的权重是精确率的2倍);

- 当 ( 0 < \beta < 1 ) 时,精确率的重要性更高(如 ( \beta = 0.5 ) 时,精确率的权重是召回率的2倍)。

简言之,( \beta ) 可以取所有大于0的实数,根据业务场景对“精确率”和“召回率”的侧重灵活选择。

二分类的公式

基准测试

MLLU 综合知识评测

测试57个学科的多项选择题

HellaSwag详解:常识推理

- HellaSwag基准基于真实场景的完形填空,测试常识推理能力。

- 2025年更新为HellaSwag 2.0,纳入更多文化多样性场景。

- GPT-5在HellaSwag上得分95.2%。

场景还原:超市购物判断。

想象你在超市购物,需要判断合理的下一步行动。

正确选项:将商品放入购物篮中

错误选项:将商品直接扔在地上

模型可能选择不合理选项,显示常识推理不足。

HumanEval详解:代码生成准确度评估

- 想象一下,你是一个程序员,需要快速编写代码来解决实际问题。HumanEval基准就像一个严格的编程考试,测试AI模型能否生成正确的代码。

- 是一个专门评估代码生成的基准测试工具

- is a benchmark specifically for evaluating code generation.

GSM8K详解:数学推理

- 2025年推出GSM8K-Plus:增加更难的数学问题

TruthfulQA基准详解

- TruthfulQA是一个问答任务,评估模型是否生成虚假信息。它测试AI是否能避免编造事实,提供真实答案。

MT-Bench详解:对话能力

- 它专门评估AI模型的多轮对话能力。上下文一致性的能力评测

- It specifically assesses the multi-round conversation ability of AI models.

- 评分维度:

- 有用性:回答是否解决问题

- 相关性:回答是否贴合问题

- 安全性:回答是否安全无害

中文基准:C-Eval和SuperCLUE测试

- SuperCLUE:聚焦多任务综合能力

评估的挑战:基准过拟合评估

- Arena Hard:对抗性问题

- Arena Hard引入了更具挑战性的问题,

- 防止模型只针对简单基准进行优化,通过这种方式可以评估模型的真实泛化能力

- 多任务示例:阅读理解+数学推理

未来评测趋势

- 从静态基准转向动态基准

- 从单模态到多模态

浙公网安备 33010602011771号

浙公网安备 33010602011771号