RTX 5090 和 A100 怎么选:游戏卡与计算卡的真实差别

最近一段时间,很多人都会问同一个问题:

“同样两万出头,是买 RTX 5090,还是干脆上 A100?”

之所以会纠结,很简单:

在当前的二手和渠道市场里,这两张卡的价格已经非常接近了。

一张是消费级旗舰显卡,一张是数据中心计算卡。

定位完全不同,却被放进了同一张对比表里。

那它们到底差在什么地方?

各自适合什么样的 AI 场景?

这篇文章就围绕这个问题,把 5090 和 A100 的区别捋清楚。

一、为什么 5090 没有走出“4090 那条疯涨曲线”?

很多人还记得当年 RTX 4090 的行情:

- 首发一万多一点

- 很快被炒到两万,甚至更高

- 一段时间内价格都压不下来

对比之下,RTX 5090 的价格明显“涨不上去”。

原因其实并不复杂。

1. 物理结构对机房并不友好

5090 涡轮版的整体高度偏向 PC 端设计,比标准双插槽服务器显卡高出接近 2 cm。

这意味着大量 2U、4U 机箱都没法直接装,想用就得动机箱结构。

对于想拿它堆算力的人来说,这是一个非常现实的硬伤。

2. 多卡支持一度不理想

上市初期,5090 在多卡支持、多卡方案上并不算成熟。

而 A100 从诞生那天起,就是奔着多卡、集群去的。

在这两点叠加之下,5090 很难像 4090 那样“轻松上天”。

二、5090 也开始被推向多卡时代

随着不少人对 A100 多卡方案的成本和运维复杂度越来越敏感,

一部分算力需求又开始回流到消费卡阵营。

这也逼着 5090 逐步补齐多卡能力,现在市面上已经能见到:

- 双卡 5090

- 四卡 5090

- 乃至八卡整机方案

这让 5090 的热度和价格略微有所回升。

但这并不意味着它已经“替代”了 A100。

三、定位不同,决定了两张卡的气质

先把话说明白:

A100 是标准的计算卡,5090 仍然是游戏卡,只是今天的游戏卡已经顺带干了很多 AI 的活。

1. A100:为计算和集群而生

A100 是典型的数据中心 GPU,主要面向:

- 大模型训练

- 科学计算 / 工程仿真

- 高精度数值模拟

它的关键特征包括:

- 40GB HBM2E 显存

- 支持 NVLink 多卡高速互联

- FP64 双精度浮点性能约 19.5 TFLOPS

很多版本甚至没有独立风扇,而是依赖服务器整机的风道散热。

放在普通主机里使用,本身就不符合它的设计初衷。

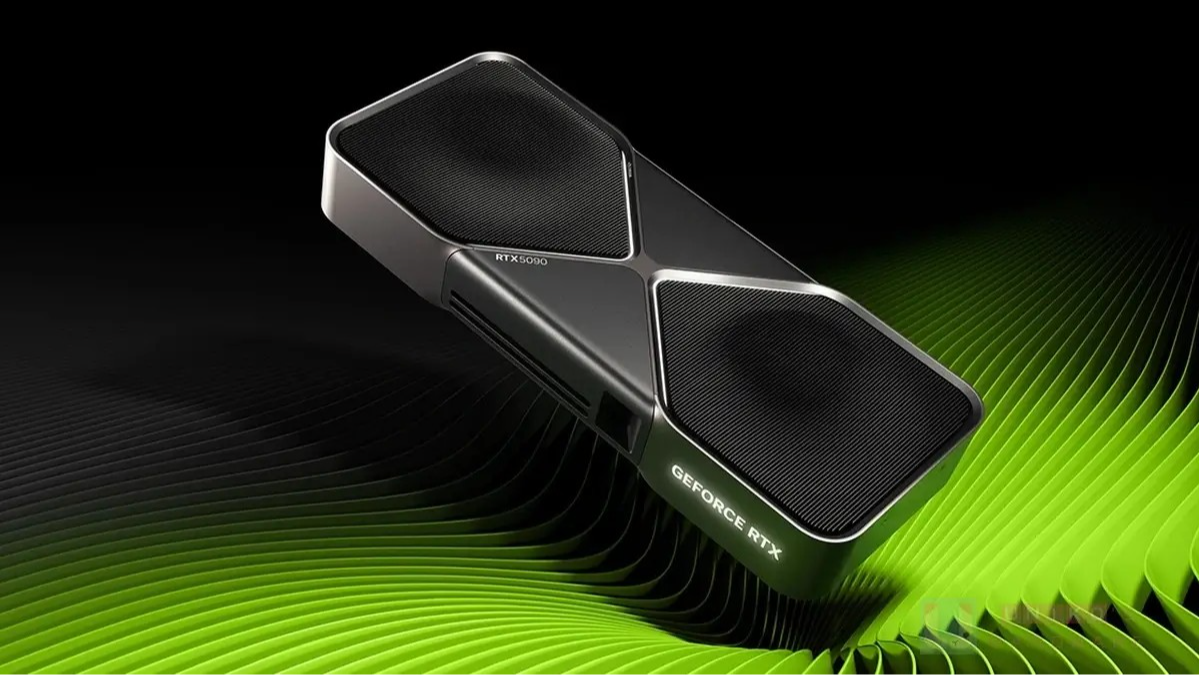

2. RTX 5090:消费级旗舰,但 AI 能力溢出

RTX 5090 的角色是消费级旗舰:

- 32GB GDDR7 显存

- 极强的 FP32 / FP16 单精度算力

- 同时兼顾游戏、内容创作和 AI 推理

它有完整的视频输出、独立散热器,单卡装在工作站或者游戏主机里就能用。

一句话概括:

A100 主要负责“算得对、算得稳”,5090 更偏向“算得快、用得顺”。

四、双精度场景:A100 完全碾压

如果你的工作和下面这些方向相关:

- 分子动力学

- 量子化学、材料模拟

- 气候模型、流体力学

- 高精度物理仿真

那么选择其实没有什么悬念。

A100 的 FP64 性能约为 19.5 TFLOPS,

而 5090 的 FP64 大致在 1.6 TFLOPS 左右,两者差了一个数量级。

在真实科研场景里,这个差距不是“多跑一会儿就行”的问题,而是:

- 算不算得动

- 算出来稳不稳

- 会不会出现数值发散

比如某些气候模拟任务,用 A100 可以把原本 10 小时的计算压缩到 4 小时以内,

换成 5090,很多时候根本就不是一个类型的工具。

五、单精度与推理:5090 才是主场

把视角换到 AI 推理和中小模型训练,5090 的优势立刻显现。

- FP32 性能可以达到 100 TFLOPS 以上

- 对 FP16 / BF16 推理支持也非常好

- 在不少 LLM 推理对比中,单卡性能明显优于 A100 40G

典型适用场景包括:

- 7B / 13B / 32B 级别的大模型推理

- 单卡 LoRA / QLoRA 微调

- 各类本地 Agent 应用、内容生成、在线视频处理

在这些任务里:

- 5090 的推理速度往往比 A100 快 10%–20%

- 使用门槛更低,搭一台高配工作站就能搞

- 不用时,还能回去干本职工作——打游戏、做视频

有朋友就开玩笑说过一句话:

“5090 不用了还能拿去打游戏,A100 不用了你能拿它干嘛?”

虽然有点夸张,但确实戳中了现实。

六、大模型训练:A100 依然有护城河

真正到大规模模型训练时,A100 的优势还是很明显的。

当你的任务升级到:

- 70B 级别乃至更大的稠密模型

- 多卡 / 多机分布式训练

- 长时间、大 batch 的持续训练

A100 在这些维度会明显胜出:

- 40GB HBM 显存,带宽和延迟表现优于 GDDR7

- NVLink 提供高带宽多卡互联,通信效率高

- 长时间高负载下的稳定性更好,适合“连跑一周不关机”

5090 即便在单卡 FP16 算力上有优势,

一旦进入多卡训练和大集群环境,通信、调度和稳定性都会让它处于下风。

七、到底怎么选?关键还是看场景

说了这么多,回到原始问题:同样两万左右,是买 5090 还是 A100?

其实并没有标准答案,只有更适合谁。

1. 更适合 A100 的人

- 科研院所、实验室

- 做分子动力学、量化模拟、工程仿真等高精度任务的团队

- 正式大模型训练项目,需要多卡 NVLink 集群

这类场景,对 FP64、HBM 和 NVLink 的需求非常刚性,A100 会是更稳妥的选择。

如果只是偶尔用用,也可以考虑用算力云租 A100,

比如 晨涧云AI算力平台 ,就提供了 A100 的显卡租赁。

2. 更适合 RTX 5090 的人

- 主要做 LLM 推理、RAG、Agent 应用

- 偏重 7B–32B 模型的训练与微调

- 既做 AI,又做游戏、视频、3D 等内容创作

- 预算有限,希望一台机器尽量“全活齐上”

这时,5090 会更像一张综合能力强、可玩性高的主力卡。

八、写在最后:边界在被打破,但定位还在

把 RTX 5090 和 A100 放在一块比较,本身就说明了一件事:

- 消费级显卡的 AI 能力,已经越来越接近专业计算卡

- 专业计算卡也在坚持守住自己最擅长的那块领域

在实际选择时,更重要的不是“哪张卡更强”,而是:

你要解决的问题到底是什么?

你是在做科研,还是在做产品?

你更在乎高精度和稳定集群,还是推理速度和日常灵活度?

想清楚这些,比每天盯着价格波动纠结,会更有意义。

本文围绕 RTX 5090 和 NVIDIA A100 展开对比,重点分析两者在定位、双精度计算、AI 推理性能和大模型训练中的差异。A100 依托 HBM 显存和 NVLink,在高精度科研与多卡训练场景中优势明显;RTX 5090 在单精度算力和推理速度上更有优势,更适合 7B–32B 模型、本地推理与内容创作。选择哪张卡,取决于具体业务场景和长期使用规划。

本文围绕 RTX 5090 和 NVIDIA A100 展开对比,重点分析两者在定位、双精度计算、AI 推理性能和大模型训练中的差异。A100 依托 HBM 显存和 NVLink,在高精度科研与多卡训练场景中优势明显;RTX 5090 在单精度算力和推理速度上更有优势,更适合 7B–32B 模型、本地推理与内容创作。选择哪张卡,取决于具体业务场景和长期使用规划。

浙公网安备 33010602011771号

浙公网安备 33010602011771号