魔改4090 48G显卡相比A100 40G在模型训练中性能如何

魔改4090 48G是基于原先4090 24G显卡进行增加显存之后的市面上的改装卡,面市之后热度一直挺高的。其基于4090本身强大的算力,补充24G的显存短板,使其能对参数量更大的模型进行训练、微调和推理。对有大上下文、需要更大显存空间的大语言模型推理或深度学习任务,拥有 48 GB 在某些场景下比 24 GB 卡有更大的使用空间。

但因为是魔改卡,所以很多用户也会担心其稳定性,以及魔改之后对之前的算力和性能是否有影响,这里就拿4090 48G对比算力和显存都相近的A100 40G,看看模型训练场景的性能差异。

之前对比过3090、4090和5090的算力差异:

基于ResNet-50模型训练场景下实测3090和4090的性能

模型训练场景实测5090和4090的算力比较

这里还是使用 ResNet-50 进行模型训练测试。

A100 40G和4090 48G参数对比

两张显卡的参数规格:

| A100 40G | 4090 48G | |

|---|---|---|

| 架构 | Ampere | Ada Lovelace |

| CUDA核心数 | 6,912 | 16,384 |

| 显存容量 | 40GB HBM2 | 48 GB GDDR6X |

| 显存带宽 | 1,555 GB/s | 1,008 GB/s |

| TDP功耗 | 250W | 450W |

| FP32 算力 | 19.5 TFLOPS | 82.6 TFLOPS |

| Tensor FP16 算力 | 312 TFLOPS | 330 TFLOPS |

-

显存方面:4090是魔改后翻倍的48G显存,要大于低版本A100的40G显存,但A100 40G用的HBM2显存,带宽可以接近1.6T/s

-

算力方面:4090在单精度计算上有绝对的优势,半精度Tensor算力两者接近

-

A100 PCIe版本的功耗做了限制,所以从耗电量上4090会更大

深度学习模型训练测试

在 晨涧云AI算力平台 分别租用A100 40G和4090 48G的云主机实例。

基于Pytorch框架来训练ResNet-50模型,使用CIFAR-10数据集进行测试对比。

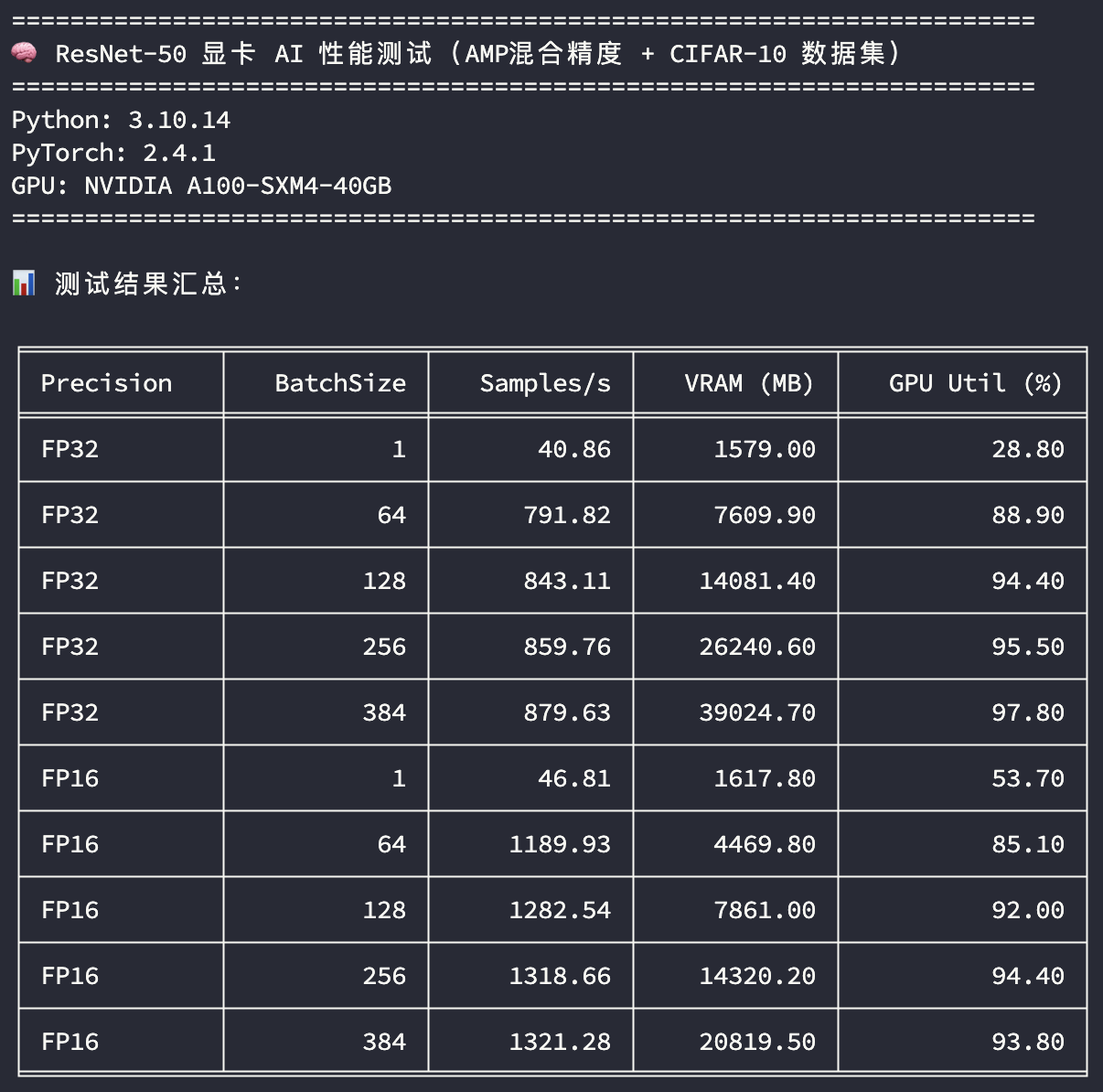

A100 40G测试

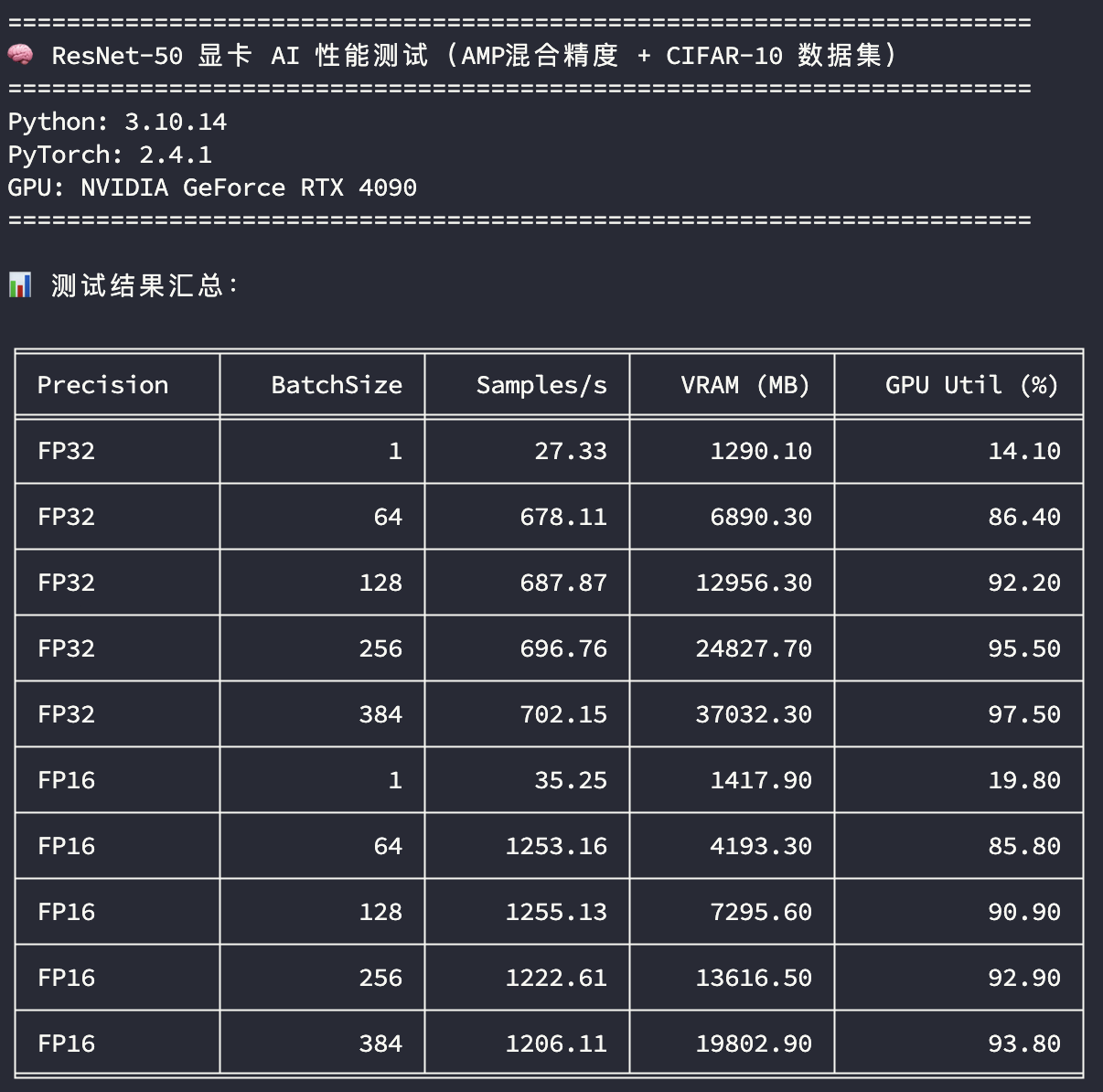

4090 48G测试

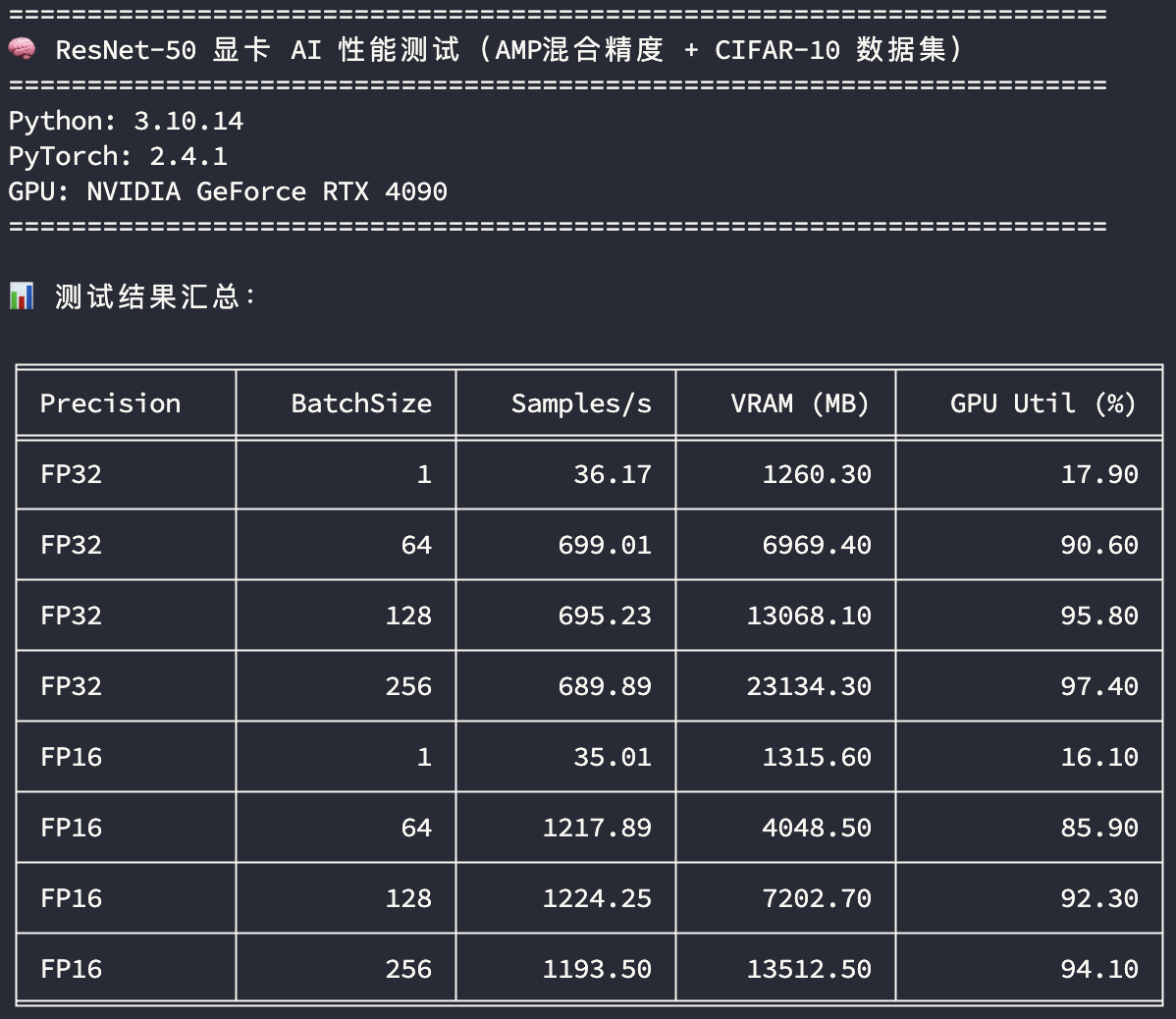

补充之前测试的4090 24G的结果:

4090 24G测试

可以看到魔改48G显存的4090显卡在算力方面并没有折损,并且48G显存提供了更多的BatchSize样本吞吐空间。

测试结果解释

使用了FP32和FP16混合训练精度,相比之前3090和4090的测试,因为A100 40G和4090 48G有更大的显存,训练批次在原先的基础上增加了384的BatchSize,看训练吞吐量的差异:

-

精度:FP32 表示使用单精度训练,FP16 表示使用混合精度训练

-

BatchSize:训练批次大小

-

Samples/s:每秒样本吞吐量

-

VRAM (MB):平均显存使用量

-

GPU Util (%):平均GPU利用率

看在GPU使用率比较高的场景下(BatchSize>=256),模型训练样本的吞吐速度比较;单精度训练A100 40G的样本吞吐速度是4090 48G的125%,半精度训练A100 40G的样本吞吐速度是4090 48G的105%。

根据测试结果,4090 48G相对专业计算卡A100 40G的算力差距并不明显,且4090还能兼顾图像、仿真计算等领域,加上48G的显存,在当前AI和高精度计算领域是比较全能的一张卡。但是个人用户购入也需谨慎,毕竟没有维保,稳定性也还没有长时间的市场考验;所以在GPU算力平台租用是个更好的选择。

魔改4090 48G是基于原先4090 24G显卡进行增加显存之后的市面上的改装卡,面市之后热度一直挺高的。其基于4090本身强大的算力,补充24G的显存短板,使其能对参数量更大的模型进行训练、微调和推理。这里就拿4090 48G对比算力和显存都相近的A100 40G,看看模型训练场景的性能差异。模型训练样本的吞吐速度比较:单精度训练A100 40G的样本吞吐速度是4090 48G的125%,半精度训练A100 40G的样本吞吐速度是4090 48G的105%。

魔改4090 48G是基于原先4090 24G显卡进行增加显存之后的市面上的改装卡,面市之后热度一直挺高的。其基于4090本身强大的算力,补充24G的显存短板,使其能对参数量更大的模型进行训练、微调和推理。这里就拿4090 48G对比算力和显存都相近的A100 40G,看看模型训练场景的性能差异。模型训练样本的吞吐速度比较:单精度训练A100 40G的样本吞吐速度是4090 48G的125%,半精度训练A100 40G的样本吞吐速度是4090 48G的105%。

浙公网安备 33010602011771号

浙公网安备 33010602011771号