Ollama大模型推理场景下3090和4090性能实测

Ollama 是一个开源的大型语言模型(LLM)部署服务工具,能让用户能够轻松地在本地运行、管理和与大型语言模型进行交互。

我们使用Ollama的快速模型部署,来实测英伟达的RTX 3090和RTX 4090这两张显卡,在大语言模型推理场景中的性能差异。

3090和4090的显卡参数对比

| RTX 3090 | RTX 4090 | |

|---|---|---|

| 架构 | Ampere | Ada Lovelace |

| CUDA核心数 | 10,496 | 16,384 |

| 显存容量 | 24 GB GDDR6X | 24 GB GDDR6X |

| 显存带宽 | 936 GB/s | 1,008 GB/s |

| TDP功耗 | 350W | 450W |

| FP32 算力 | 35.6 TFLOPS | 82.6 TFLOPS |

| Tensor FP16 算力 | 142 TFLOPS | 330 TFLOPS |

3090和4090的显存参数比较接近,显存容量都是24GB,显存带宽差异也不大;算力方面,4090的单精度和Tensor FP16算力差不多是3090的2.3倍。

Ollama大模型推理测试

大模型选择

这里选择 Qwen3的模型进行测试,考虑到3090和4090的显存都是24GB,分别选择一个FP16精度和一个Q4_K_M量化后的大模型进行测试:

| 模型 | 精度 | 大小 |

|---|---|---|

| qwen3:8b | fp16 | 16 GB |

| qwen3:14b | q4_K_M | 9.3 GB |

借助DeepSeek 生成测试脚本,使用复杂度近似的8个prompts;MAX_TOKENS配置256,让每次请求需要一定的生成时长便于采样显卡的使用指标,减少波动;同时需要模型预热,消除第一次推理响应延时过大的问题。

我们在GPU算力租赁平台 晨涧云 直接租用Ollama云容器进行测试,分别创建3090和4090两种显卡的容器实例,启动后访问Open WebUI 选择模型:

然后就可以执行推理性能测试脚本,查看输出结果。

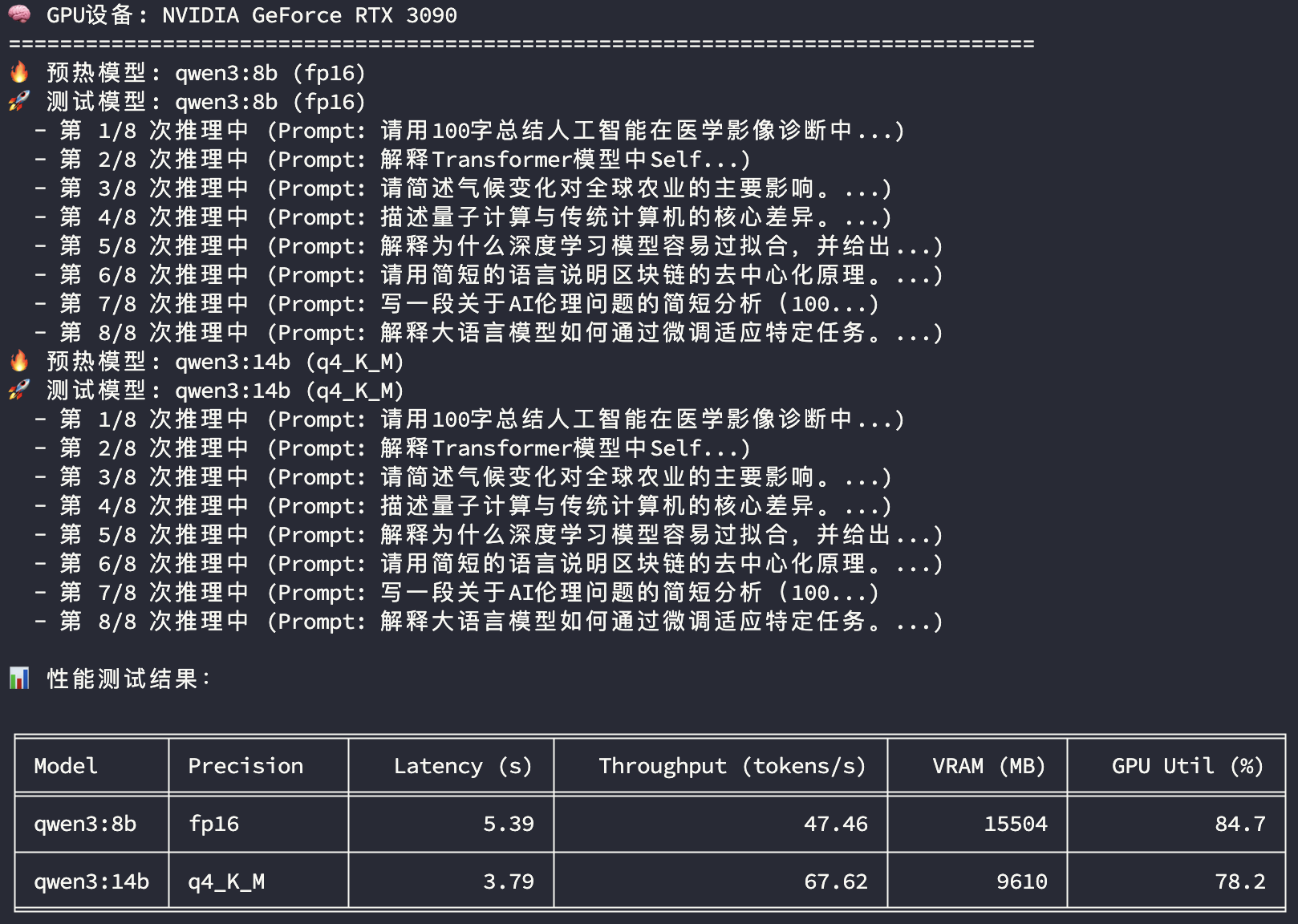

3090推理性能

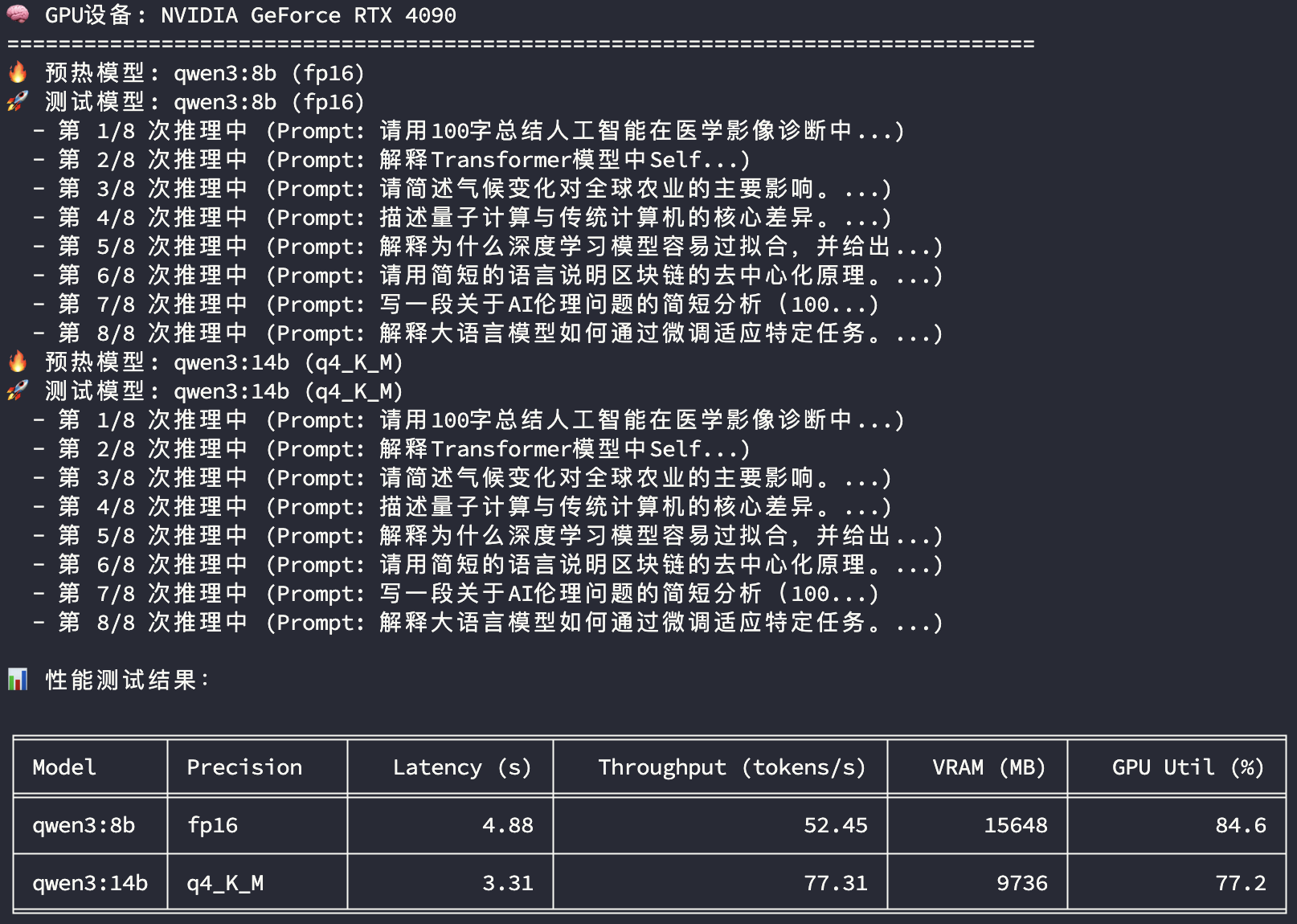

4090推理性能

测试结果解释

-

Latency (s):多次推理平均响应时长

-

Throughput (tokens/s):多次推理平均Token生成速度

-

VRAM (MB):多次推理平均显存使用量

-

GPU Util (%):多次推理平均GPU使用率

3090显卡和4090显卡在两个模型推理过程中的显存使用和GPU使用率都比较接近,所以主要比较平均响应时长及平均Token生成速度两个指标:

| qwen3:8b fp16 | qwen3:14b q4_K_M | ||

|---|---|---|---|

| 响应时长(s) | 3090 | 5.39 | 3.79 |

| 响应时长(s) | 4090 | 4.88 | 3.31 |

| 响应时长(s) | 差异 | 90.5% | 87.3% |

| Token生成速度(tokens/s) | 3090 | 47.46 | 67.62 |

| Token生成速度(tokens/s) | 4090 | 52.45 | 77.31 |

| Token生成速度(tokens/s) | 差异 | 110.5% | 114.3% |

4090在量化模型的推理性能相较FP16精度的模型会更突出一点,FP16精度模型推理性能4090比3090高10%左右,Q4_K_M量化模型4090比3090的推理性能高14%左右。

但相较显卡本身参数的算力值2.3倍的差异,在推理场景下4090的优势并没有想象中的那么明显。

Ollama因为更多考虑的是本地和边缘算力的轻量级快速部署场景,所以在推理性能,特别是多GPU高并发场景下,不如vLLM和SGLang等框架,后续准备比较在vLLM下不同显卡的推理性能,也可以跟Ollama比较下不同大模型推理框架的性能差异。

使用Ollama的快速模型部署,来实测英伟达的RTX 3090和RTX 4090这两张显卡,在大语言模型推理场景中的性能差异。

选择 Qwen3的模型进行测试,考虑到显存都是24GB,分别选择一个FP16精度和一个Q4_K_M量化后的大模型进行测试。

使用Ollama的快速模型部署,来实测英伟达的RTX 3090和RTX 4090这两张显卡,在大语言模型推理场景中的性能差异。

选择 Qwen3的模型进行测试,考虑到显存都是24GB,分别选择一个FP16精度和一个Q4_K_M量化后的大模型进行测试。

浙公网安备 33010602011771号

浙公网安备 33010602011771号