spark第四天

今天继续安装spqrk

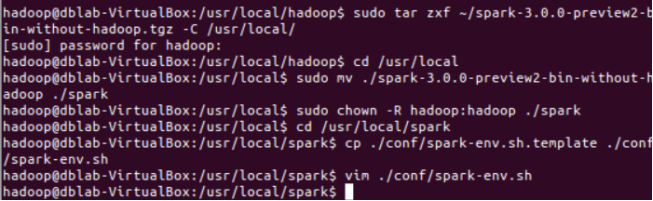

Spark安装

在Spark官网:http://spark.apache.org/downloads.html 下载Spark

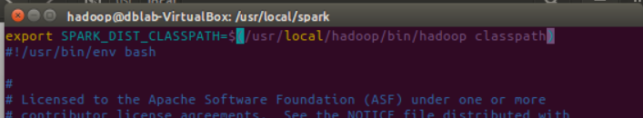

并在修改Spark的配置文件spark-env.sh添加输入下列命令:

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

如图:

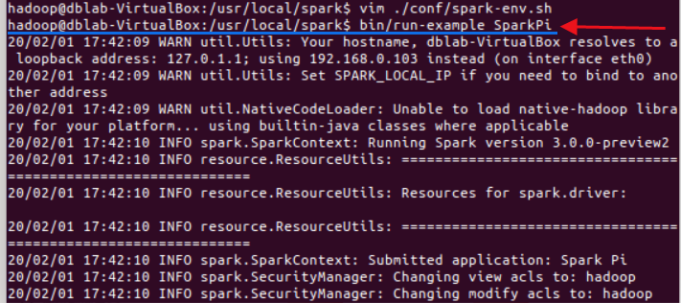

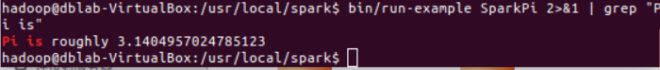

测试输入图中命令将输出大量信息

将得到一个π的近似数,说明安装成功

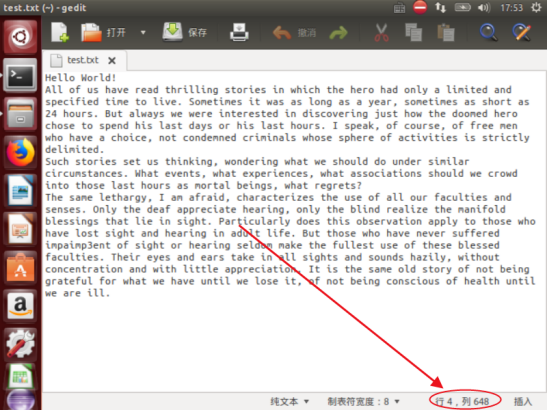

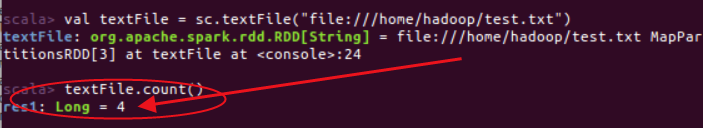

(1)在 spark-shell 中读取 Linux 系统本地文件“/home/hadoop/test.txt”,然后统计出文件的行数;

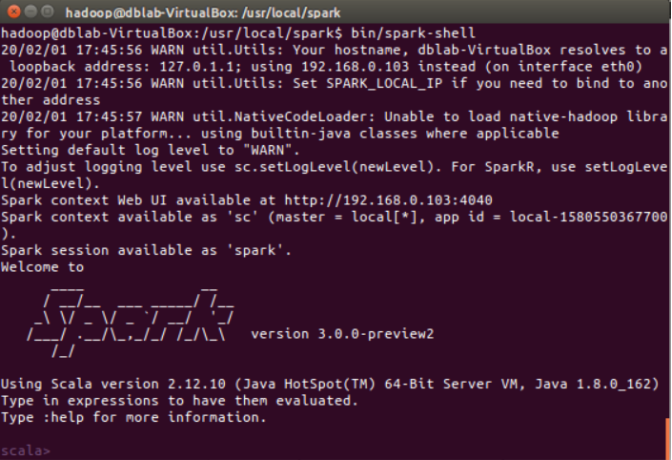

启动spark-shell

(2)在 spark-shell 中读取 HDFS 系统文件“/user/hadoop/test.txt”(如果该文件不存在,

请先创建),然后,统计出文件的行数;

统计结果

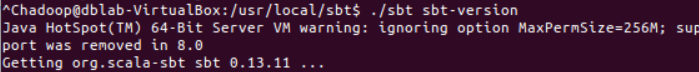

安装sbt

浙公网安备 33010602011771号

浙公网安备 33010602011771号