解决Pandas drop_duplicates()去重失败的可能问题之一

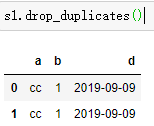

在我们利用Pandas进行数据清洗的时候,往往会用到drop_duplicates()进行去重,但是不知道大家有没有遇见过这一种现象:

按理说应该只有一条记录的,可是却仍然出现重复记录,这种情况的产生原因是数据里包含空格制表符等。处理方式是可以在excel表中用trim(clean())清理空白符隐藏符(其实这个可能是最稳妥的)

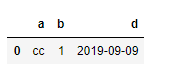

或者在DataFrame中先用正则替换掉空白符如下:

s1.replace('\s','',regex=True,inplace=True)

s1.drop_duplicates()

其中\s:表示匹配空白,即 空格,tab键等

浙公网安备 33010602011771号

浙公网安备 33010602011771号