ELMO模型—>解决向量一词多义

2024.3.11 ELMO模型—>解决向量一词多义

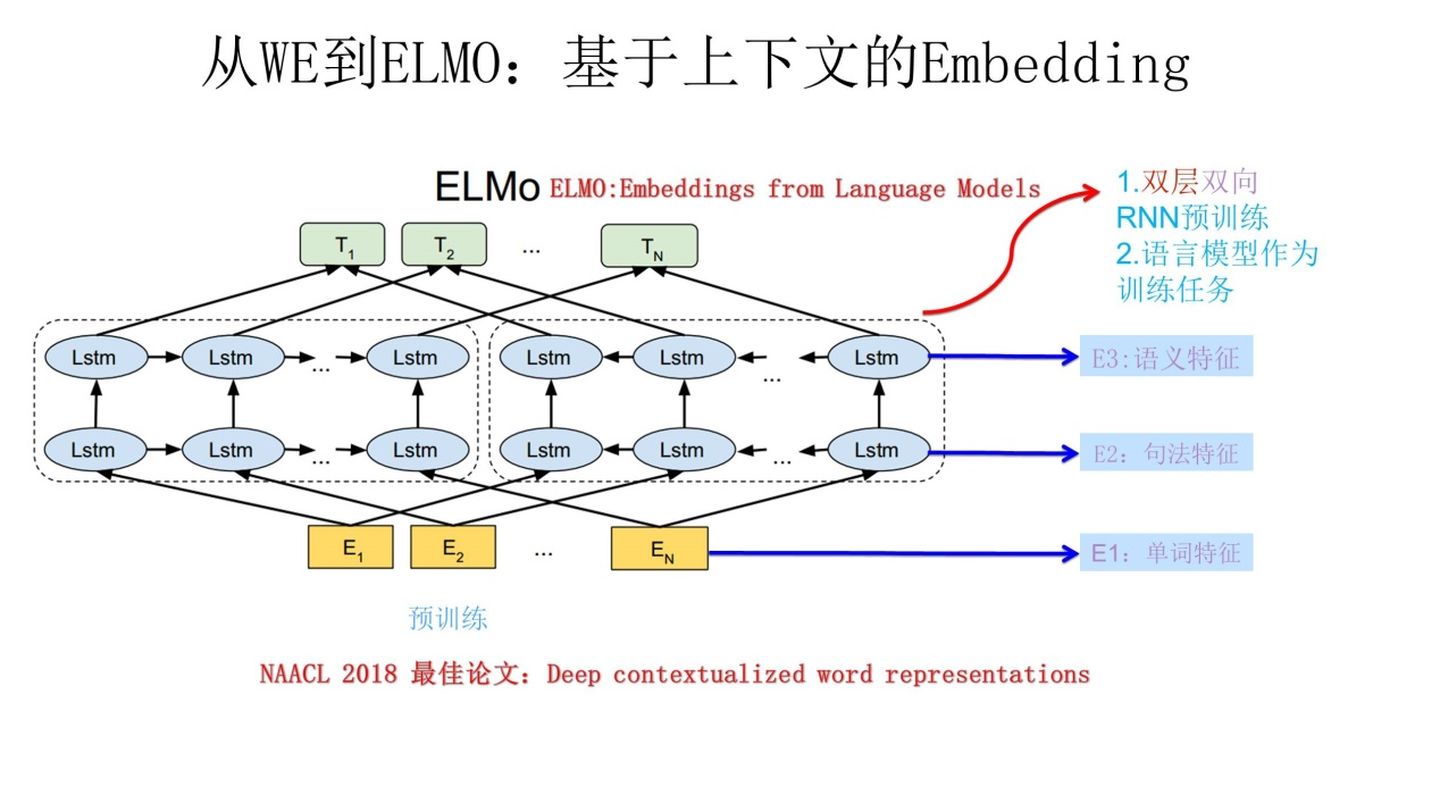

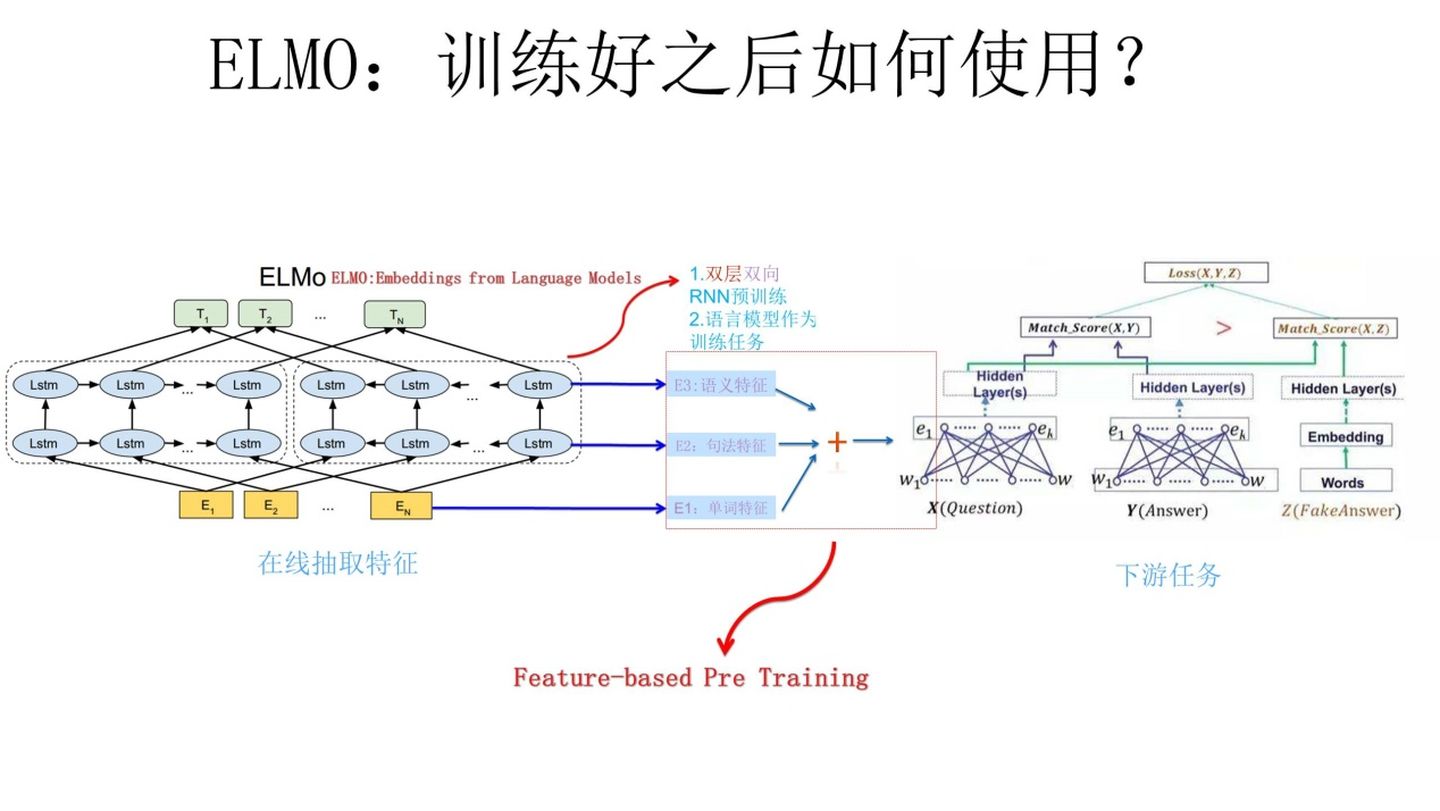

elmo解决一词多义问题,与Word2Vec不同的是,可以融合上下文信息

ElMO(专门做词向量,通过预训练)

不只是训练一个Q矩阵,我们还可以把这个词的上下文信息融入到这个Q矩阵中

上图中,左边的LSTM获取E2的上文信息,右边对应获取下文信息

怎么处理一词多义问题

通过连接上下文

apple---->我吃了一个苹果----->[1,20,10]

apple---->我在使用苹果手机----->[1,10,20]

RNN

RNN 解决了时序依赖问题,但这里的时序一般指的是短距离的,首先我们先介绍下短距离依赖和长距离依赖的区别:

- 短距离依赖:对于这个填空题 “我想看一场篮球____”,我们很容易就判断出 “篮球” 后面跟的是 “比赛”,这种短距离依赖问题非常适合 RNN。

- 长距离依赖:对于这个填空题 “我出生在中国的瓷都景德镇,小学和中学离家都很近,……,我的母语是____”,对于短距离依赖,“我的母语是” 后面可以紧跟着 “汉语”、“英语”、“法语”,但是如果我们想精确答案,则必须回到上文中很长距离之前的表述 “我出生在中国的瓷都景德镇”,进而判断答案为 “汉语”,而 RNN 是很难学习到这些信息的。

LSTM远距离梯度不至于完全消失,也就能够解决 RNN 中存在的梯度消失问题

浙公网安备 33010602011771号

浙公网安备 33010602011771号