8分钟教你快速掌握Python爬虫核心技术,批量爬取网络图片

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理

本文章来自腾讯云 作者:python学习教程

想要学习Python?有问题得不到第一时间解决?来看看这里“1039649593”满足你的需求,资料都已经上传至文件中,可以自行下载!还有海量最新2020python学习资料。

点击查看

本文主要实现一个简单的爬虫,目的是从一个百度贴吧页面下载图片。下载图片的步骤如下:

(1)获取网页html文本内容;

(2)分析html中图片的html标签特征,用正则解析出所有的图片url链接列表;

(3)根据图片的url链接列表将图片下载到本地文件夹中。

#!/usr/bin/python # coding:utf-8 # 实现一个简单的爬虫,爬取百度贴吧图片 import urllib import re # 根据url获取网页html内容 def getHtmlContent(url): page = urllib.urlopen(url) return page.read() # 从html中解析出所有jpg图片的url # 百度贴吧html中jpg图片的url格式为:<img ... src="XXX.jpg" width=...> def getJPGs(html): # 解析jpg图片url的正则 jpgReg = re.compile(r'<img.+?src="(.+?\.jpg)" width') # 注:这里最后加一个'width'是为了提高匹配精确度 # 解析出jpg的url列表 jpgs = re.findall(jpgReg,html) return jpgs # 用图片url下载图片并保存成制定文件名 defdownloadJPG(imgUrl,fileName): urllib.urlretrieve(imgUrl,fileName) # 批量下载图片,默认保存到当前目录下 def batchDownloadJPGs(imgUrls,path ='./'): # 用于给图片命名 count = 1 for url in imgUrls: downloadJPG(url,''.join([path,'{0}.jpg'.format(count)])) count = count + 1 # 封装:从百度贴吧网页下载图片 def download(url): html = getHtmlContent(url) jpgs = getJPGs(html) batchDownloadJPGs(jpgs) def main(): url = 'http://tieba.baidu.com/p/2256306796' download(url) if __name__ == '__main__': main()

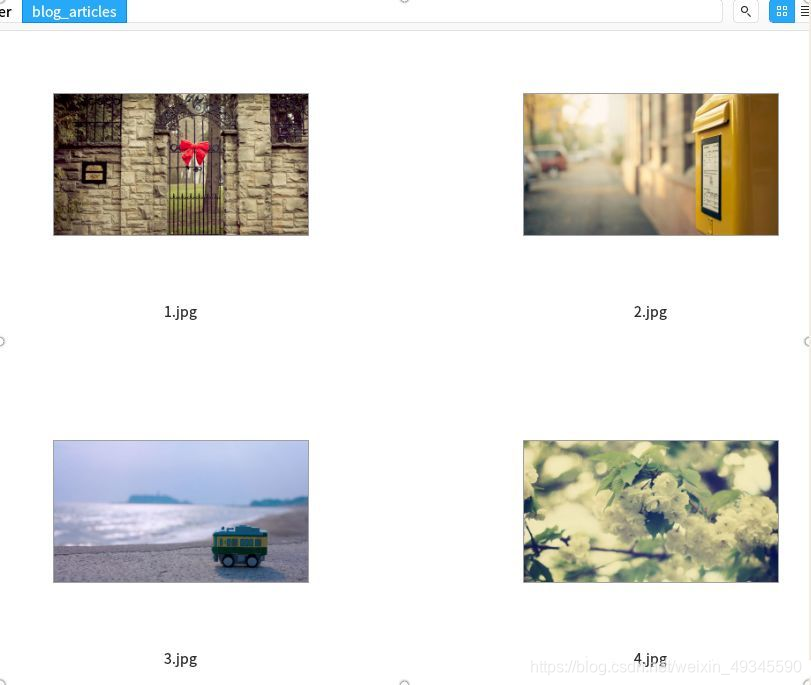

运行上面脚本,过几秒种之后完成下载,可以在当前目录下看到图片已经下载好了:

下面用requests库实现下载,把getHtmlContent和downloadJPG函数都用requests重新实现。

#!/usr/bin/python # coding:utf-8 # 实现一个简单的爬虫,爬取百度贴吧图片 import requests import re # 根据url获取网页html内容 def getHtmlContent(url): page = requests.get(url): return page.text # 从html中解析出所有jpg图片的url # 百度贴吧html中jpg图片的url格式为:<img ... src="XXX.jpg" width=...> def getJPGs(html): # 解析jpg图片url的正则 jpgReg = re.compile(r'<img.+?src="(.+?\.jpg)" width') # 注:这里最后加一个'width'是为了提高匹配精确度 # 解析出jpg的url列表 jpgs = re.findall(jpgReg,html) return jpgs # 用图片url下载图片并保存成制定文件名 def downloadJPG(imgUrl,fileName): # 可自动关闭请求和响应的模块 from contextlib import closing with closing(requests.get(imgUrl,stream = True)) as resp: with open(fileName,'wb') as f: for chunk in resp.iter_content(128): f.write(chunk) # 批量下载图片,默认保存到当前目录下 defbatchDownloadJPGs(imgUrls,path ='./'): # 用于给图片命名 count = 1 for url in imgUrls: downloadJPG(url,''.join([path,'{0}.jpg'.format(count)])) print '下载完成第{0}张图片'.format(count) count = count + 1 # 封装:从百度贴吧网页下载图片 def download(url): html = getHtmlContent(url) jpgs = getJPGs(html) batchDownloadJPGs(jpgs) def main(): url = 'http://tieba.baidu.com/p/2256306796' download(url) if __name__ == '__main__': main()

输出:和前面一样。

不知道这篇简单的python爬虫小案例有没有帮到你呢?无论你是零基础小白看不懂还是看懂了想体验高难度!小伙伴们都不用担心~

浙公网安备 33010602011771号

浙公网安备 33010602011771号