对比学习/表示学习/深度学习的一些细节内容

现在是2025年11月17日,在写论文的博客,顺带记录一下一些小细节的内容(因为没脑子,所以要记录):

1. 对比学习和度量学习:

概念:

度量学习:学习一个嵌入空间,使得该空间中的距离度量(欧氏距离、余弦距离或其他可学习的距离度量)能够反映样本之间的语义相似性。(语义上相似的样本距离近,不相似的样本距离远。)

对比学习:是度量学习中的一种具体实现方式,通过设计正样本对合负样本对,并使用一个如InfoNCE或Triplet Loss的对比损失函数来间接实现这个距离结构的学习。

优化目标:

度量学习:直接学习样本间的语义距离。

对比学习:通过数据增强和自监督信号学习特征空间。

目标空间属性:

度量学习:语义结构化(inter/intra-class distances)。

对比学习:表征一致性(instance-level semantics)

有监督/无监督:

度量学习:有监督的语义间距学习。(样本关系:明确语义标签)

对比学习:无监督的表征一致性学习(但隐含地也在优化语义结构)。(样本关系:正样本(同源增强)、负样本(不同实例))

语义目标差异:

度量学习:显式的语义一致性(例如同类样本)(通过标签定义语义一致性)

对比学习:隐式的语义一致性(通过数据增强或上下文约束推导出的语义)(通过数据生成过程和结构约束去逼近语义一致性)

2. 分布外泛化:

分布外泛化(Out-of-Distribution Generalization, OOD Generalization):是“模型泛化能力”中的一种更强、更严格的衡量标准,但不是泛化能力的全部。

泛化能力(generalization ability)是一个广义概念,而分布外泛化(OOD generalization)是其中一个特定情形或评估维度。

泛化能力:定义:模型在未见过的样本(但来自同一分布)上保持性能的能力,典型场景:训练集和测试集独立同分布(i.i.d.),如:训练和测试数据都来自同一传感器、同一环境。(泛化能力:同分布泛化+分布外泛化)

分布外泛化:定义:模型在分布发生变化(非i.i.d)的样本上仍能保持性能的能力,典型场景:存在域偏移(domain shift)或分布漂移,如:训练在晴天图像,测试在雨天图像;训练在A医院数据,测试在B医院数据。(分布外泛化:域泛化、分布漂移鲁棒性、数据扰动鲁棒性、因果不变性泛化...)

泛化能力测试模型是否没有过拟合,分布外泛化测试模型是否真的学到了语义或因果本质,而不是只记住分布特征。

3. Top-1指标:

(2025年11月23日,周日,继续.)

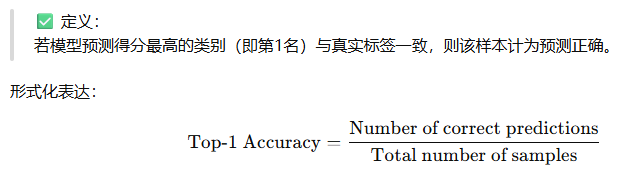

Top-1 Accurary(Top-1准确率)是分类任务中最常用的指标之一,用于衡量模型在图像分类任务重预测最可能类别的正确率。

Top-1指标本质上衡量的是:模型在区分输入图像语义类别方面的直接判别能力。

也就是:模型能否正确地将一张图片分到最可能的语义类别。

所以这个指标反映的能力是:

语义识别能力(semantic discrimination)、特征表征的判别性(feature separability)、模型最终决策层(softmax分类头)的有效性。

在ImageNet等视觉任务中,除了Top-1外,还常用Top-5指标。

Top-1指标是预测的第一个类别是否正确,反映模型的精确分类能力。

Top-5指标是真实类别是否出现在预测概率前5名中,反映模型的粗粒度语义识别能力(容错性)。

4. 少样本分类任务中的5-way 1-shot和5-way 5-shot setting:

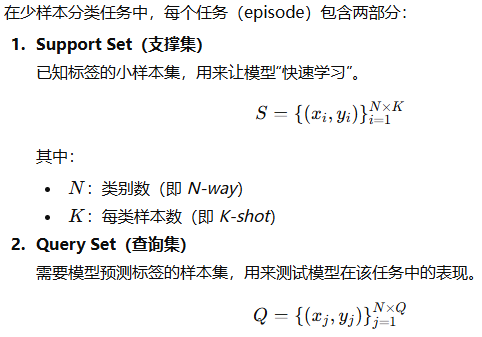

在少样本学习(Few-shot Learning)中,不是训练一个模型去识别所有类别,而是模拟模型在新任务中快速学习的能力。因此,每次训练或测试都会构造一个小任务(称为一个episode或few-shot task)。

5-way 1-shot,就描述了这个小任务的结构:5-way:这个任务中有5个类别,1-shot:每个类别只有1张带标签的样本可用于学习(support)。

模型需要用极少的样本去分类未见过的类别。

少样本任务中,模型并不是在传统意义上“泛化到测试集”,而是在测试时面对从未见过的新类别,仅用少量样本就能:学习区分这些新类别的语义结构,并在查询样本上正确分类。

因此它衡量的是:模型的快速泛化能力或跨任务迁移能力。比普通的泛化(in-distribution generalization)更严格,因为类别是新的,数据分布也不同。

(现在是11月23日,21:33,呜呜呜,没写完,我有罪,但是打算下班了,不强迫自己必须今晚写完,放过自己。)

浙公网安备 33010602011771号

浙公网安备 33010602011771号