卷积

卷积

一、卷积的基本原理

卷积(con·vol·ution)是CNN的核心数学操作,本质是通过滑动窗口对输入数据进行局部特征提取。其核心思想是:

- 局部感知:每个卷积核(滤波器)仅关注输入数据的局部区域(如3×3像素),而非全局信息,模拟人类视觉的局部特征捕捉机制。

- 参数共享:同一卷积核在整个输入数据上滑动时共享权重,大幅减少参数数量,提高计算效率。

- 特征映射:每个卷积核生成一个特征图(Feature Map),不同卷积核提取不同特征(如边缘、纹理、颜色等)。

-

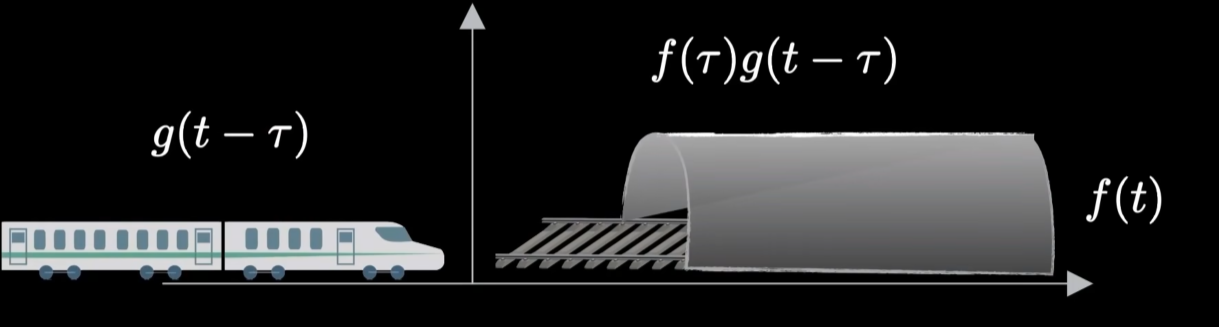

简单理解:一辆火车和山洞在同一方向,若火车要进山洞,需要火车旋转后才能进入。二者重叠互相作用的部分即为卷积。

-

数学表示:

$$f(t)*g(t) = \int_{-\infty}^{\infty} f(\tau) , g(t - \tau) , d\tau$$

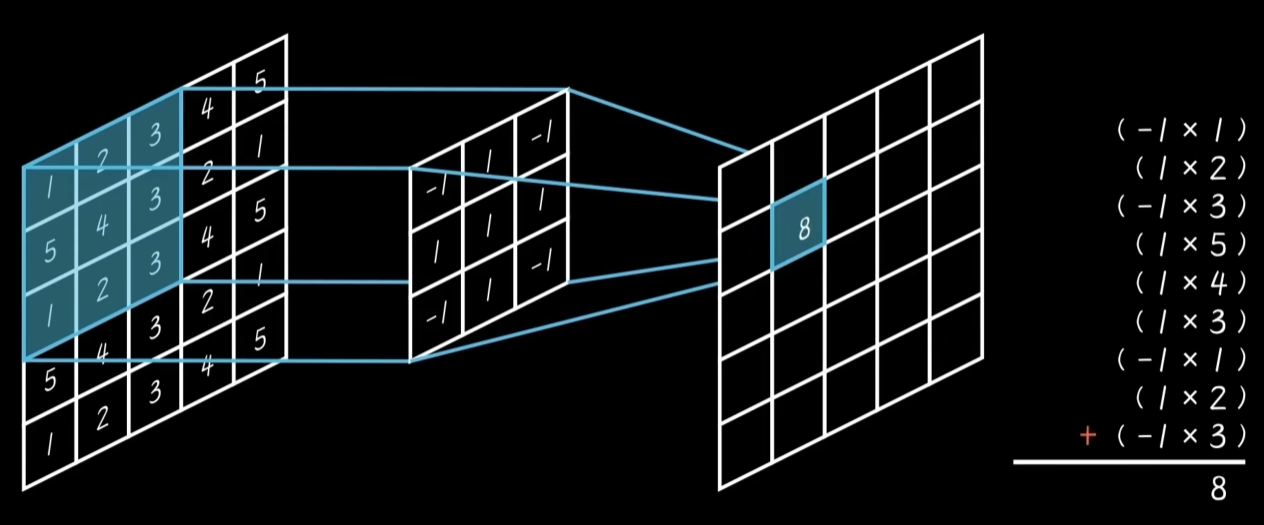

若输入为矩阵\(X\),卷积核为\(K\),则输出特征图\(Y\)中的每个元素为: $$ Y(i,j) = \sum_{m}\sum_{n} X(i+m, j+n) \cdot K(m,n) $$

二、卷积神经网络(CNN)的架构

-

先从具体例子出发:卷积神经网络应用于图像识别。

图像是有若干RGB像素点组成,于是储存图像的形式便是一个n*n的矩阵。

计算方式:\(\sum(输入信号f × 系统函数g)\)

CNN由多个层级构成,逐步从低级特征提取到高级语义理解:

1. 输入层与预处理

-

输入层:接收原始图像数据(如RGB三通道矩阵),并进行归一化、尺寸调整等预处理。

-

数据增强:通过旋转、裁剪、翻转等操作增加数据多样性,防止过拟合。

2. 卷积层(Convolutional Layer) [ 过滤器 ]

- 功能:提取局部特征。多个卷积核并行工作,生成多个特征图。

- 示例:第一个卷积层可能检测边缘,后续层组合边缘形成更复杂的形状(如轮子、眼睛)。

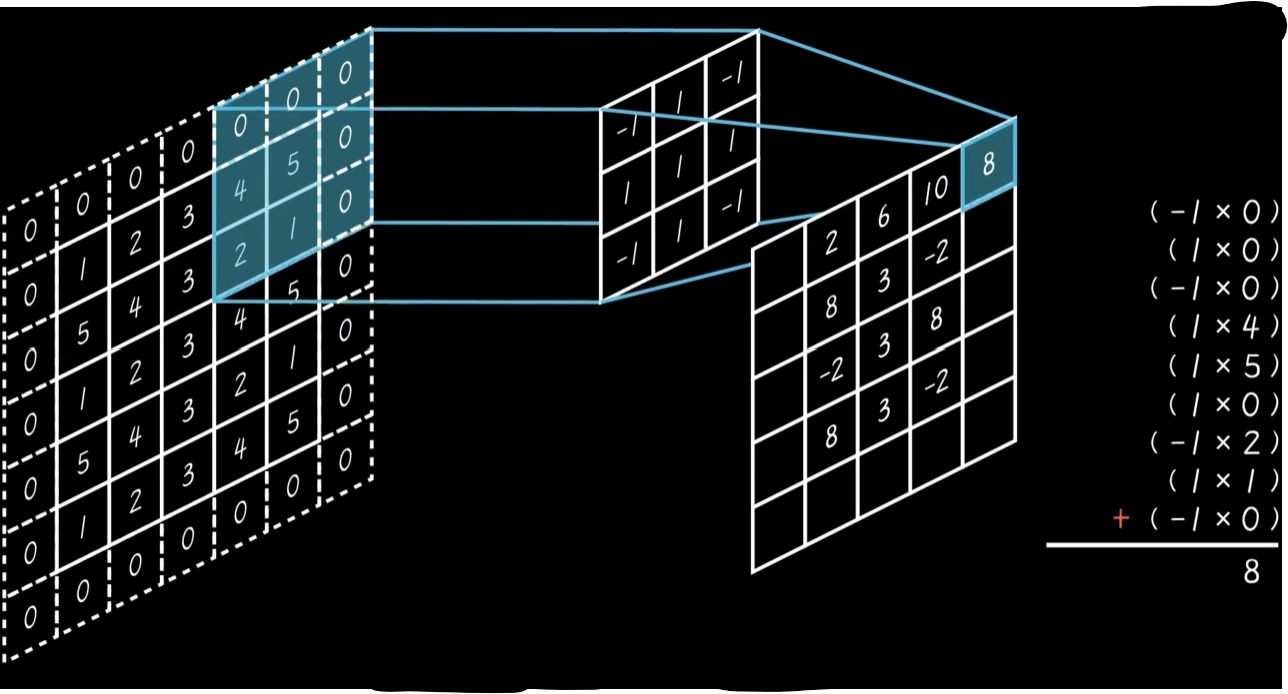

- 超参数:

- 核大小(如3×3、5×5)

- 步长(Stride):滑动窗口的移动间隔

- 填充(Padding):保持输出尺寸与输入一致,防止信息丢失。

3. 激活函数

- 作用:引入非线性,增强模型表达能力。常用ReLU(Rectified Linear Unit): \(\text{ReLU}(x) = \max(0, x)\)

- 优势:计算高效,缓解梯度消失问题。

4. 池化层(Pooling Layer)

- 功能:降低特征图维度,保留关键信息,增强模型鲁棒性。

- 最大池化(Max Pooling):取局部区域最大值,突出显著特征。

- 平均池化(Average Pooling):取局部区域平均值,保留背景信息。

- 优势:

- 减少计算量

- 增强平移不变性(对物体位置变化不敏感)。

5. 全连接层(Fully Connected Layer)

- 功能:整合全局特征,输出分类或回归结果。

- 流程:将池化层输出的多维特征展平为一维向量,通过全连接层映射到目标空间(如分类概率)。

- 与卷积层区别:全连接层每个神经元连接前一层的所有节点,参数多但缺乏空间感知能力。

三、CNN的核心优势

- 参数高效性:通过局部连接和权重共享,参数数量远少于全连接网络(如处理28×28图像时,全连接层需约40万参数,而卷积层仅需数百)。

- 平移不变性:池化操作使模型对目标位置变化具有鲁棒性。

- 分层特征学习:底层提取边缘/纹理,中层提取部件,高层组合为完整对象,模拟人类视觉分层处理机制。

四、CNN的实际应用

- 图像分类:如AlexNet在ImageNet挑战赛中显著降低错误率(从26%到15%)。

- 目标检测:YOLO、Faster R-CNN等模型定位并识别图像中的多目标。

- 医学影像:辅助诊断(如肿瘤检测)。

- 自然语言处理:文本分类、机器翻译(通过1D卷积处理序列数据)。

- 自动驾驶:实时识别道路、行人、交通标志。

五、经典CNN模型

- LeNet-5:首个成功应用于数字识别的CNN,结构为“卷积-池化-卷积-池化-全连接”)。

- AlexNet:引入ReLU和Dropout,推动深度学习复兴。

- ResNet:通过残差连接解决深层网络梯度消失问题,支持超百层网络。

六、代码示例(PyTorch实现)

import torch.nn as nn

class SimpleCNN(nn.Module):

def __init__(self):

super().__init__()

self.conv1 = nn.Conv2d(3, 32,kernel_size=3, padding=1) # 输入3通道,输出32特征图

self.pool = nn.MaxPool2d(2, 2) # 2×2最大池化

self.conv2 = nn.Conv2d(32, 64,kernel_size=3, padding=1)

self.fc1 = nn.Linear(64 * 8 * 8, 256) # 展平后全连接

self.fc2 = nn.Linear(256, 10) # 输出10分类

def forward(self, x):

x = self.pool(nn.ReLU()(self.conv1(x)))

x = self.pool(nn.ReLU()(self.conv2(x)))

x = x.view(-1, 64 * 8 * 8)

x = nn.ReLU()(self.fc1(x))

x = self.fc2(x)

return x

此模型展示了典型的CNN结构:卷积→激活→池化→全连接。

七、未来发展趋势

- 轻量化模型:MobileNet、EfficientNet等优化计算效率,适配移动端。

- 注意力机制:结合Transformer(如Vision Transformer),增强全局特征建模能力。

- 跨模态应用:CNN与自然语言处理结合,实现图文生成、视觉问答。

通过以上内容,可以看出CNN通过模拟生物视觉机制,结合数学优化,成为计算机视觉领域的基石技术。

卷积的基本介绍。

卷积的基本介绍。

浙公网安备 33010602011771号

浙公网安备 33010602011771号