驯服AI的“金箍棒”:深入浅出看懂大模型强化学习PPO

大家好,我是maoku。如果你一直关注大模型技术,一定听说过“RLHF”这个词——它被认为是让ChatGPT如此“善解人意”的关键一步。而RLHF背后那位默默出力、技术含金量最高的“打工人”,就是今天的主角:PPO(近端策略优化)算法。

很多朋友觉得强化学习(RL)和PPO深奥难懂,充斥着数学公式。今天,我就带你换一种视角,用“驯兽师训练海豚”的完整故事,把PPO的核心思想、流程和精妙之处,拆解得明明白白。你会发现,这个让大模型学会“对齐人类偏好”的魔法,其实有非常直观的逻辑。

引言:为什么大模型需要“强化学习”?

让我们先思考一个问题:经过海量文本预训练(学知识)和指令微调(学格式)后的大模型,为什么还不够好?

因为它还缺一点“灵性”和“分寸感”。比如:

- 你问:“帮我写一封辞职信。” SFT模型可能给你一篇语气激烈、抱怨连篇的范文。

- 你希望的是:一封专业、得体、保持风度的辞职信。

这就是问题所在:SFT(监督微调)教会模型“如何回答”,但没有教会它“什么是更好的回答”。它缺乏对回答质量的细粒度评判标准。

强化学习,特别是PPO,就是来补上这最后一课的。 它通过一种“试错-奖励”的机制,让模型自己去探索,并逐渐学会产出更符合我们复杂、主观偏好(如“有帮助”、“无害”、“风格得体”)的回答。你可以把它理解为给模型请了一位“高级私教”,不再只是对照答案抄写,而是通过不断的互动反馈来精进技艺。

技术原理:一场精心设计的“海豚训练秀”

理解PPO,最好的方式就是把它想象成一场驯兽师训练海豚完成高难度表演的过程。在这个过程中,有四个关键角色:

- 海豚(策略模型 / Actor):我们要训练的核心对象,它需要学会根据指令(驯兽师的手势)做出漂亮的动作(生成文本)。

- 驯兽师与小鱼(奖励模型 / Reward Model):驯兽师手里的小鱼代表“奖励”。当海豚做出一个漂亮的后空翻(生成一段好回答),就立刻给它一条鱼(高分)。奖励模型就是这位“驯兽师”,它被预先训练好,知道什么样的动作(回答)值得奖励。

- 场边预测员(价值模型 / Critic):这个角色负责预测。在海豚开始做一个动作序列(比如“助游-起跳-翻转”)时,预测员就根据当前状态(助游的速度、角度)来预测:“嗯,根据经验,这套动作做完大概能得8分。” 这个预测分就是“状态价值”。

- 海豚的本能(参考模型 / Reference Model):这是未经强化训练、只经过SFT的原始模型。它代表了海豚“原本、自然”的行为模式。它的作用是防止海豚为了吃鱼而走火入魔。比如,海豚发现疯狂拍打水面也能让驯兽师给鱼(奖励模型有漏洞),但参考模型会提醒:“这不像我平时会做的动作,太奇怪了,扣分!”

整个PPO的训练目标就是:让海豚(策略模型)在驯兽师(奖励模型)的引导下,做出更高分的表演,但同时不能偏离自己原本的自然姿态(参考模型)太远。

核心机制一:优势估计(GAE)——算清“这笔账”

海豚做完一套动作后,怎么判断它到底做得有多“好”?不是只看最后得到的鱼(最终奖励)。关键在于计算 “优势(Advantage)” :实际得分到底比预期高出多少?

这就是 GAE(广义优势估计) 干的事。它是一套精密的“算账系统”。

- 实际总收益 = 即时小鱼(当前Token的奖励) + 后续动作的折扣总收益。

- 预期收益 = 预测员在动作开始前的估值(状态价值)。

优势 = 实际总收益 - 预期收益

如果优势是正的,说明这套动作比预测的还要棒,以后要多做;如果是负的,说明不如预期,要减少。

这里有两个巧妙的“旋钮”:

- 折扣因子 γ:决定“未来收益”打多少折扣。γ越小,越“短视”,只在乎眼前的小鱼。

- λ参数:平衡“奖励信号”和“价值预测”的可靠性。训练初期,预测员(价值模型)不准,可以多依赖即时的小鱼(λ接近1);训练后期,预测员准了,可以多听它的(λ调低)。

核心机制二:近端策略优化—— “小步快跑”,防止“翻车”

这是PPO最精髓的设计,也是它名字中“近端(Proximal)”的由来。

如果没有约束,海豚为了多吃鱼,可能会突然做出极其夸张、扭曲甚至危险的动作(策略剧烈震荡,模型崩溃)。PPO的解决办法很聪明:给每次参数更新加上一个“紧箍咒”。

它引入了一个“重要性采样比率”,对比新旧策略对同一个动作的偏好差异。然后用一个clip函数,强行把这个变化比率限制在一个小范围(比如0.8到1.2)内。

这意味着: 每次更新,只允许模型参数发生微小、可控的变化。就像驯兽师每次只调整一点点手势,海豚每次只改进一点点动作角度。“小步快跑”保证了整个训练过程异常稳定。

核心机制三:多目标协同训练

PPO的损失函数是一个“三合一”的复合目标:

- 策略提升目标:基于优势信号,增大高优势动作的概率。

- 价值对齐目标:训练预测员(价值模型),让它的预测越来越准。

- KL散度约束:惩罚当前海豚(策略模型)的行为偏离其原始本能(参考模型)的程度,防止它变得“面目全非”。

这三个目标同时优化,才造就了一个既能力强又守规矩的AI。

实践步骤:拆解PPO训练的全流程

理论可能还有点抽象,我们结合具体操作步骤来看,PPO训练是如何一步步进行的。

阶段零:前期准备——训练“驯兽师”(奖励模型)

在PPO主循环开始前,我们必须先有一个能判断好坏的“驯兽师”。

- 数据:收集大量人类对模型回答的偏好数据。每条数据是一个

(指令, 更偏好的回答, 不被偏好的回答)三元组。 - 训练:用一个基础模型(通常就是SFT后的模型)加上一个回归头,训练它给

更偏好的回答打出比不被偏好的回答显著更高的分数。使用的损失函数是对比损失(如Pairwise Ranking Loss)。 - 输出:一个冻结的奖励模型,它能够给任何一段生成的文本输出一个标量分数。

阶段一:PPO主循环——“采样、表演、评估、优化”

这是一个不断重复的闭环,我们以一个Batch的数据为例:

步骤1:采样与表演(采样-生成)

- 从数据集中采样一批

指令。 - 海豚登场:将指令输入当前待训练的策略模型(Actor),让它自由生成完整的回答序列。

- 记录:完整记录下生成每个Token时,策略模型给出的概率分布。

步骤2:评估与算账(评估-计算优势)

- 驯兽师打分:将生成的完整回答送入奖励模型,得到一个最终奖励分。

- 预测员复盘:将生成过程中每个时间步的状态,送入价值模型(Critic),得到一系列状态价值预测。

- 本能参照:将同样的指令和生成过程,用参考模型(Reference,冻结的SFT模型) 也跑一遍,得到它每一步的概率分布。

- GAE算账:结合最终奖励分、各步价值预测,并计算策略模型与参考模型在每个Token上的KL散度(作为对“偏离本能”的惩罚,融入即时奖励),通过GAE公式计算出每一步动作的优势值(A_t) 和价值目标(V_target)。

步骤3:优化与更新(优化-小步更新)

- 更新海豚(策略模型):利用计算出的优势值

A_t,构造PPO-Clip损失函数。这个函数的核心是,根据优势正负调整动作概率,但通过clip严格限制调整幅度。然后反向传播,更新策略模型的参数。 - 更新预测员(价值模型):利用计算出的

V_target作为目标,通过均方误差损失训练价值模型,让它下次预测得更准。 - 这个过程会对一个Batch的数据进行多次(如2-4次)迭代更新,以提高数据利用率。

整个PPO训练非常消耗资源,因为它需要同时维护4个模型(策略、价值、参考、奖励),并在训练中动态生成数据、进行多轮复杂计算。想自己从头复现整个流程挑战巨大。对于想要快速实验RLHF效果的研究者或团队,可以借助【LLaMA-Factory Online】这类集成化平台。它内部已经实现了完整的PPO训练流程,你只需要准备好指令数据和偏好数据,配置好参数,就可以在云端直接启动RLHF训练,省去了令人头疼的工程化实现和环境调试工作。

效果评估:如何判断PPO训练成功了?

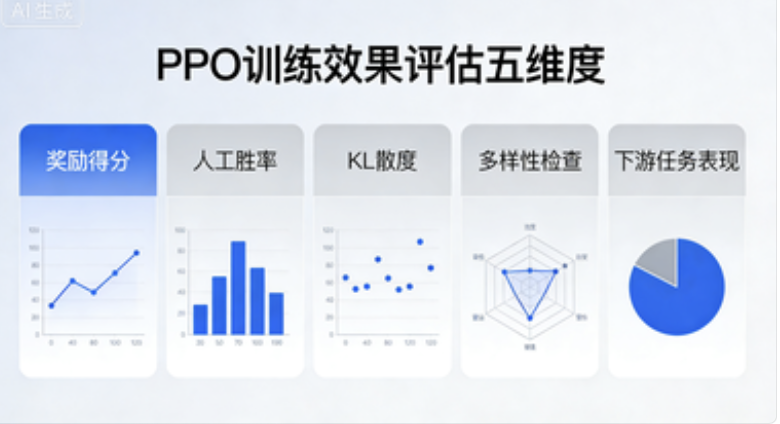

训练完成后,我们如何检验这只“海豚”是否真的变得更优秀了?不能只看损失曲线,需要多维度评估:

- 奖励得分上升:这是最直接的信号。用同一批测试指令让模型生成回答,然后送入奖励模型打分,平均奖励分应有显著且稳定的提升。

- 人工评估胜率:进行“盲测”。将PPO训练后的模型和SFT基线模型对同一批指令生成的回答打乱,让人类评估员选择哪个更好。PPO模型的胜率(赢/平/输)应明显高于50%。

- KL散度监控:观察训练过程中策略模型与参考模型之间的KL散度。它应该保持在一个相对稳定、可控的范围内(例如2-10 bits)。如果KL散度急剧飙升,说明模型正在“走火入魔”,偏离本质;如果几乎为零,说明PPO没起作用,模型根本没变。

- 多样性检查:避免“奖励黑客”。模型可能会为了刷高奖励分,学会一些“套路”,比如所有回答都以“当然,我很乐意…”开头,或者充斥无意义的恭维。需要人工检查生成内容的多样性、信息量和真实性。

- 下游任务表现:在一些需要理解与判断的基准测试集(如MT-Bench, AlpacaEval)上,PPO模型相比SFT模型也应有提升。

总结与展望

总结一下,PPO为大模型对齐提供了一套强大而稳定的框架:

- 核心价值:将难以直接建模的、主观的“人类偏好”,通过“奖励模型”这个中介,转化为模型可优化的目标。

- 核心创新:“近端”优化思想,通过Clipping等机制,确保了强化学习训练这个本来不稳定的过程,能够平稳进行。

- 关键角色:参考模型是“安全锚”,价值模型是“预测器”,与策略模型、奖励模型共同构成了一个精妙的四角平衡系统。

展望未来,PPO本身也在演进,更高效的算法(如DPO、KTO)在某些场景下可以绕过奖励模型训练,直接利用偏好数据。但PPO所确立的“基于偏好优化”和“稳定训练”的理念,将持续影响大模型对齐技术的发展。

理解PPO,不仅是理解一个算法,更是理解我们如何教会AI在拥有庞大知识的同时,也能具备符合人类期待的判断力与分寸感。这或许是通向更高级人工智能的必经之路。

希望这个“驯兽师与海豚”的故事,能帮你拨开PPO的迷雾。如果你对具体的实现细节或后续的DPO等算法感兴趣,欢迎在评论区留言讨论。我是maoku,我们下期见!

浙公网安备 33010602011771号

浙公网安备 33010602011771号