RAG全攻略:给大模型装个“外接大脑”,从此告别胡说八道!

大家好,我是AI技术博主maoku。你有没有遇到过这样的情况:问ChatGPT一个专业问题,它要么回答得模棱两可,要么干脆开始“编故事”?或者你想让AI帮你分析公司内部文档,但它完全不知道你在说什么?

别急,今天我要介绍的RAG技术,就是专门解决这些问题的“神器”。它能让大模型变得既专业又靠谱,就像给学生配了一台能随时查资料的电脑一样。

引言:为什么你的AI需要“参考资料”?

想象一下这个场景:你要写一篇关于“量子计算最新进展”的论文,但你的知识还停留在三年前。这时候你有两个选择:

- 硬着头皮写:凭记忆写,可能会出错或过时

- 先查最新资料:上网搜最新论文,然后基于这些资料写

正常人都会选第二个,对吧?但现在的很多大模型却在用第一种方式——它们只记得训练时的知识(可能已经过时了),不知道的事情就开始“猜”。

这就是RAG要解决的问题:给大模型配一个随时更新的“资料库”,让它回答前先查资料。

RAG能解决哪些实际问题?

让我用几个例子说明:

# 问题1:知识过时

query = "2024年最新的个税政策是什么?"

# 如果大模型训练数据只到2023年 → 不知道或给旧信息

# RAG方案:先查最新政策文件,再回答 → ✅ 准确

# 问题2:专业领域知识

query = "根据我司《员工手册》第3章,年假怎么计算?"

# 大模型没看过你的员工手册 → 瞎猜

# RAG方案:先检索员工手册相关内容 → ✅ 准确

# 问题3:需要溯源

query = "这个结论的依据是什么?"

# 普通大模型:说不清依据

# RAG方案:可以指出是哪个文档的哪一页 → ✅ 可解释

一、RAG核心原理:三句话讲清楚

RAG的全称是检索增强生成(Retrieval Augmented Generation)。名字有点绕,但原理很简单:

1.1 核心思想:先查资料,再写答案

你可以把RAG理解成一个学霸的工作流程:

def 学霸答题流程(问题):

# 第一步:查资料(检索)

相关资料 = 去图书馆查书(问题)

# 第二步:整理思路

思考笔记 = 整理(相关资料)

# 第三步:写答案(生成)

答案 = 根据笔记写回答(问题)

return 答案

对应到RAG技术就是:

- 检索(Retrieval):从知识库中找到相关文档

- 增强(Augmented):把这些文档作为上下文

- 生成(Generation):基于上下文生成答案

1.2 传统方法 vs RAG:直观对比

为了让你们更清楚,我画了个对比图:

传统方法(直接问大模型):

用户问题 → 大模型 → 答案(可能出错)

RAG方法(先查再答):

用户问题 → 检索知识库 → 相关文档 + 问题 → 大模型 → 答案(有依据)

关键区别:RAG在中间加了一个“查资料”的步骤,确保答案有据可查。

1.3 RAG能解决大模型的三大痛点

-

知识过时问题

- 大模型训练后知识就固定了

- RAG可以随时更新知识库

-

幻觉问题(编造事实)

- 大模型不知道时会“猜”

- RAG要求基于实际文档回答

-

数据安全问题

- 敏感数据不想上传到云端

- RAG可以在本地部署知识库

二、RAG如何工作:从文档到答案的全流程

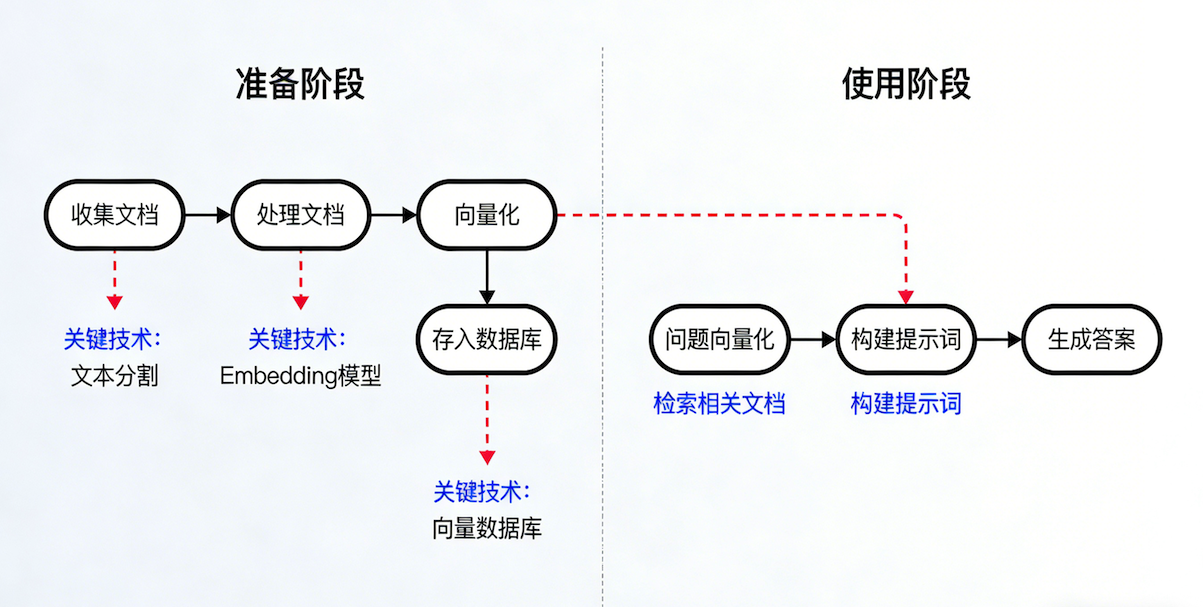

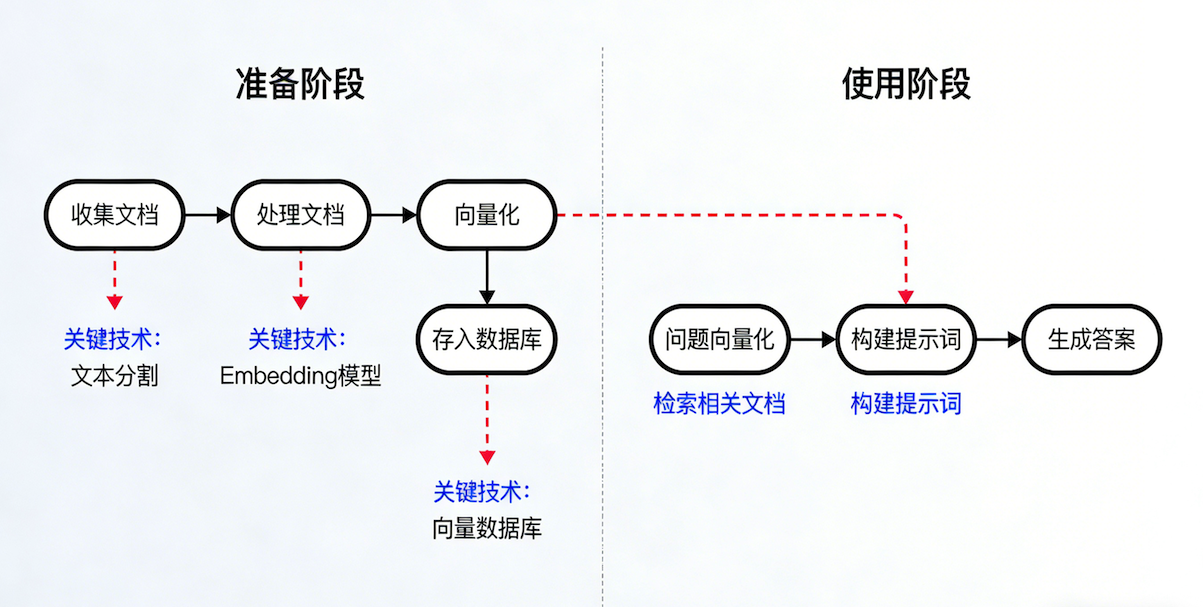

现在我们来深入看看,RAG系统具体是怎么工作的。整个过程分为两个阶段:准备阶段和使用阶段。

2.1 准备阶段:建立你的“数字图书馆”

就像建图书馆一样,你需要先把书整理好、编上号、放上书架。

# 第一步:收集文档(买书)

documents = [

"公司员工手册.pdf",

"产品技术文档.docx",

"客户常见问题.txt",

"行业研究报告.pdf"

]

# 第二步:处理文档(整理书籍)

def 准备知识库(文档列表):

for 文档 in 文档列表:

# 1. 提取文字(把书从箱子里拿出来)

文字内容 = 读取文档(文档)

# 2. 切分文本(把书分成章节)

# 为什么要切分?因为一本书太厚,找信息不方便

文本块列表 = 智能切分(文字内容)

# 3. 向量化(给每章写摘要卡片)

# 向量 = 用数字表示文本含义

向量列表 = 转换为向量(文本块列表)

# 4. 存入数据库(把卡片放进卡片柜)

存入向量数据库(向量列表, 文本块列表)

return 知识库

关键技术点详解:

1. 文本分割:怎么切才合理?

切文本是个技术活,切不好会影响检索效果:

# 不好的切法:按固定字数切

text = "张三于2020年加入公司,担任技术总监。他负责AI产品研发..."

# 切成:["张三于2020年加入公司,担任技术", "总监。他负责AI产品研发..."]

# 问题:"技术总监"被切开了,检索时可能找不到

# 好的切法:按语义切分

# 1. 按句子切(最常用)

["张三于2020年加入公司,担任技术总监。", "他负责AI产品研发..."]

# 2. 按段落切

["张三于2020年加入公司,担任技术总监。他负责AI产品研发..."]

# 3. 重叠切分(避免切断重要信息)

chunk1 = "张三于2020年加入公司,担任技术总监。"

chunk2 = "担任技术总监。他负责AI产品研发..." # 重叠"担任技术总监"

2. 向量化:文字怎么变成数字?

这是RAG的核心技术之一。简单说,就是用Embedding模型把文字转换成一串数字:

# 文字变向量过程

text = "人工智能"

vector = embedding_model.encode(text)

# 结果:[-0.12, 0.45, 0.23, ..., 0.67] # 通常是几百或几千维

# 为什么能比较?

vector1 = embedding_model.encode("人工智能")

vector2 = embedding_model.encode("AI")

# 这两个向量会很接近,因为意思相似

# 计算相似度(常用余弦相似度)

相似度 = 计算余弦相似度(vector1, vector2) # 值接近1表示很相似

常用的Embedding模型选择:

对于中文场景,我推荐这几个:

embedding_models = {

"追求效果": {

"模型": "BGE(智源研究院)",

"特点": "中文优化好,效果顶尖",

"适合": "企业级应用,要求高准确率"

},

"追求速度": {

"模型": "M3E(moka-ai)",

"特点": "速度快,资源占用少",

"适合": "实时性要求高的场景"

},

"不想本地部署": {

"模型": "OpenAI Embedding",

"特点": "调用API即可,不用关心部署",

"适合": "快速原型验证"

}

}

3. 向量数据库:怎么存和查?

存向量和查向量需要专门的数据库:

# 常用向量数据库对比

vector_databases = {

"FAISS(Facebook)": {

"优点": "速度快,内存效率高",

"缺点": "功能相对简单",

"适合": "中小规模数据(百万级以内)"

},

"ChromaDB": {

"优点": "易用,文档齐全",

"缺点": "性能不如FAISS",

"适合": "快速开发,学习使用"

},

"Milvus": {

"优点": "功能强大,支持大规模数据",

"缺点": "部署复杂",

"适合": "企业级,数据量巨大"

}

}

2.2 使用阶段:用户提问到获得答案

知识库建好后,就可以回答问题了:

def RAG问答系统(用户问题, 知识库):

# 第一步:理解问题(把问题也变成向量)

问题向量 = embedding_model.encode(用户问题)

# 第二步:检索相关资料(在卡片柜里找相关卡片)

相关文本块 = 知识库.检索(问题向量, top_k=3)

# top_k=3 表示取最相关的3个文本块

# 第三步:构建提示词(把问题和资料整理好)

提示词 = f"""

请基于以下信息回答问题:

相关资料:

{相关文本块}

问题:

{用户问题}

要求:

1. 只基于提供的信息回答

2. 如果信息不足,就说不知道

3. 回答要简洁明了

"""

# 第四步:生成答案(让大模型写答案)

答案 = 大模型.generate(提示词)

return {

"答案": 答案,

"参考来源": 相关文本块 # 可以告诉用户答案的依据

}

三、实践教程:手把手搭建RAG系统

理论讲完了,我们来真的动手搭建一个。我会带你用Python一步步实现。

3.1 环境准备

# 创建虚拟环境(推荐)

python -m venv rag_env

source rag_env/bin/activate # Linux/Mac

# 或 rag_env\Scripts\activate # Windows

# 安装必要库

pip install langchain langchain-community

pip install sentence-transformers # Embedding模型

pip install faiss-cpu # 向量数据库(CPU版本)

pip install pypdf2 # 处理PDF文件

pip install openai # 如果需要用ChatGPT

3.2 完整代码实现

下面是一个完整的RAG系统实现,我加了详细注释:

# rag_system.py

import os

from typing import List, Dict

import PyPDF2

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.embeddings import HuggingFaceEmbeddings

from langchain.vectorstores import FAISS

from langchain.chains import RetrievalQA

from langchain.llms import OpenAI # 也可以用其他LLM

class SimpleRAG:

def __init__(self):

"""初始化RAG系统"""

# 1. 初始化Embedding模型(使用开源的all-MiniLM-L6-v2)

# 这个模型不大,效果不错,适合学习用

self.embeddings = HuggingFaceEmbeddings(

model_name="all-MiniLM-L6-v2",

model_kwargs={'device': 'cpu'} # 用CPU运行

)

# 2. 初始化向量数据库

self.vectorstore = None

# 3. 初始化大模型(这里用OpenAI,你需要自己的API key)

# 也可以换成其他开源模型

self.llm = OpenAI(

api_key=os.getenv("OPENAI_API_KEY"),

temperature=0 # 温度设为0,减少随机性

)

def load_documents(self, file_paths: List[str]) -> List[str]:

"""加载文档,支持PDF和TXT"""

all_texts = []

for file_path in file_paths:

if file_path.endswith('.pdf'):

# 读取PDF

with open(file_path, 'rb') as file:

pdf_reader = PyPDF2.PdfReader(file)

text = ""

for page in pdf_reader.pages:

text += page.extract_text()

all_texts.append(text)

elif file_path.endswith('.txt'):

# 读取TXT

with open(file_path, 'r', encoding='utf-8') as file:

all_texts.append(file.read())

else:

print(f"不支持的文件格式: {file_path}")

return all_texts

def create_knowledge_base(self, documents: List[str]):

"""创建知识库:文本分割 -> 向量化 -> 存储"""

# 1. 文本分割

print("正在分割文本...")

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=500, # 每个块500字符

chunk_overlap=50, # 重叠50字符

length_function=len,

separators=["\n\n", "\n", "。", ",", " "]

)

chunks = []

for doc in documents:

chunks.extend(text_splitter.split_text(doc))

print(f"共分割为 {len(chunks)} 个文本块")

# 2. 向量化并存储

print("正在生成向量并存储...")

self.vectorstore = FAISS.from_texts(

texts=chunks,

embedding=self.embeddings

)

print("✅ 知识库创建完成!")

return len(chunks)

def query(self, question: str, top_k: int = 3) -> Dict:

"""查询答案"""

if self.vectorstore is None:

return {"error": "请先创建知识库"}

# 1. 检索相关文档

relevant_docs = self.vectorstore.similarity_search(

question,

k=top_k

)

# 2. 构建问答链

qa_chain = RetrievalQA.from_chain_type(

llm=self.llm,

chain_type="stuff", # 简单合并所有文档

retriever=self.vectorstore.as_retriever(

search_kwargs={"k": top_k}

)

)

# 3. 获取答案

result = qa_chain.run(question)

# 4. 返回结果和来源

return {

"answer": result,

"sources": [doc.page_content for doc in relevant_docs]

}

# 使用示例

if __name__ == "__main__":

# 设置OpenAI API密钥

os.environ["OPENAI_API_KEY"] = "你的API密钥"

# 创建RAG系统

rag = SimpleRAG()

# 1. 加载文档(把你的文档放在这里)

documents = rag.load_documents([

"data/员工手册.pdf",

"data/产品介绍.txt"

])

# 2. 创建知识库

rag.create_knowledge_base(documents)

# 3. 提问

while True:

question = input("\n请输入问题(输入'退出'结束): ")

if question == "退出":

break

result = rag.query(question)

print(f"\n🤖 答案:{result['answer']}")

print(f"\n📚 参考来源:")

for i, source in enumerate(result['sources'], 1):

print(f"{i}. {source[:100]}...") # 只显示前100字符

3.3 更简单的方案:使用现成工具

如果你觉得写代码太麻烦,或者想快速验证想法,可以考虑用现成的工具。【[LLaMA-Factory Online]( https://www.llamafactory.online/register?promoteID=user-kNG1qsdQ1e

)】就是一个很好的选择,它提供了可视化的界面,上传文档就能立即搭建RAG系统,特别适合非技术人员使用。

四、高级技巧:让RAG更聪明

基本的RAG系统建好了,但你可能发现它还不够聪明。别急,下面这些高级技巧能让你的RAG系统更上一层楼。

4.1 查询优化:让问题问得更清楚

用户的问题往往不完整或不清晰:

# 原始问题可能:

# "那个多少钱?" (哪个?)

# "还有别的吗?" (和什么比?)

# "哪个更好?" (比较什么?)

def 优化查询(原始问题, 对话历史):

"""用大模型优化查询"""

提示词 = f"""

请优化以下查询,使其更清晰完整:

对话历史:

{对话历史}

原始查询:{原始问题}

优化要求:

1. 补充缺失的上下文

2. 明确指代词的具体指向

3. 保持原意不变

只返回优化后的查询。

"""

优化后问题 = 调用大模型(提示词)

return 优化后问题

# 示例

对话历史 = ["用户:iPhone 15多少钱?", "AI:起售价5999元"]

原始问题 = "那个Pro版呢?"

# 优化后:"iPhone 15 Pro版多少钱?"

4.2 混合检索:关键词+语义双管齐下

有时候只靠语义检索不够,结合关键词检索效果更好:

def 混合检索(问题, 知识库):

"""同时使用语义检索和关键词检索"""

# 1. 语义检索(找意思相似的)

语义结果 = 知识库.语义检索(问题, top_k=3)

# 2. 关键词检索(找包含关键词的)

关键词 = 提取关键词(问题)

关键词结果 = 知识库.关键词检索(关键词, top_k=3)

# 3. 合并结果(去重,按相关性排序)

所有结果 = 合并去重(语义结果, 关键词结果)

# 4. 重新排序(用更复杂的模型评估相关性)

最终结果 = 重排序模型.排序(问题, 所有结果)

return 最终结果[:3] # 返回最相关的3个

4.3 多轮对话:记住之前的对话

让RAG系统能进行连贯的对话:

class 对话式RAG:

def __init__(self):

self.对话历史 = [] # 保存对话记录

def 对话(self, 用户输入):

# 1. 从历史中提取相关信息

相关历史 = self.获取相关历史(用户输入)

# 2. 优化查询(结合历史)

完整查询 = self.优化查询(用户输入, 相关历史)

# 3. 检索

相关文档 = self.检索(完整查询)

# 4. 生成(考虑历史)

答案 = self.生成答案(用户输入, 相关文档, 相关历史)

# 5. 保存到历史

self.对话历史.append({

"用户": 用户输入,

"AI": 答案

})

return 答案

4.4 重排序:挑出最相关的内容

有时候检索到的内容太多或不够相关,需要重新排序:

def 重排序(问题, 检索结果):

"""对检索结果进行重新排序"""

# 方法1:用更强大的模型重新计算相关性

# 比如用更大的Embedding模型

# 方法2:用专门的rerank模型

# 如Cohere的rerank API或开源的cross-encoder

# 方法3:规则过滤

# 比如过滤掉太短的、时间太旧的等

return 排序后的结果

五、效果评估:你的RAG系统合格吗?

搭建好RAG系统后,怎么知道它好不好用?我教你几个评估方法。

5.1 自动评估指标

def 评估RAG系统(测试问题集, 标准答案集, rag系统):

"""自动化评估"""

结果 = {

"准确率": 0,

"召回率": 0,

"响应时间": [],

"相关文档准确率": 0

}

for 问题, 标准答案 in zip(测试问题集, 标准答案集):

# 记录时间

开始时间 = time.time()

回答 = rag系统.查询(问题)

结束时间 = time.time()

结果["响应时间"].append(结束时间 - 开始时间)

# 评估答案准确性

if 评估答案相似度(回答["答案"], 标准答案) > 0.8:

结果["准确率"] += 1

# 评估检索到的文档是否相关

相关文档数 = 计算相关文档数(回答["来源"], 问题)

结果["相关文档准确率"] += 相关文档数 / len(回答["来源"])

# 计算平均值

结果["准确率"] = 结果["准确率"] / len(测试问题集) * 100

结果["相关文档准确率"] = 结果["相关文档准确率"] / len(测试问题集) * 100

结果["平均响应时间"] = sum(结果["响应时间"]) / len(结果["响应时间"])

return 结果

5.2 人工评估(重要!)

自动化评估不够,还需要人工评估:

def 人工评估():

"""人工评估检查清单"""

检查项 = [

"✅ 答案是否准确?",

"✅ 答案是否完整?",

"✅ 答案是否有依据?",

"✅ 响应速度是否可接受?",

"✅ 对于不知道的问题,是否诚实说不知道?",

"✅ 多轮对话是否连贯?"

]

# 让3-5个人独立评估,取平均分

return 平均分

5.3 常见问题诊断

如果你的RAG效果不好,可能是这些问题:

问题诊断指南 = {

"检索不到相关内容": {

"可能原因": [

"1. Embedding模型不适合你的领域",

"2. 文本分割太大或太小",

"3. 查询不够清晰"

],

"解决方案": [

"尝试不同的Embedding模型",

"调整分割大小(试试300-800字)",

"添加查询优化功能"

]

},

"答案不准确": {

"可能原因": [

"1. 检索到的文档质量差",

"2. 大模型没有正确利用上下文",

"3. 文档内容有冲突"

],

"解决方案": [

"清理知识库文档",

"优化Prompt,明确要求基于上下文",

"添加冲突检测和处理"

]

}

}

六、总结与展望

6.1 RAG的核心价值

通过这篇文章,我希望你理解了RAG的三大价值:

- 知识实时性:让大模型拥有最新知识

- 答案可靠性:基于真实文档,减少幻觉

- 可解释性:答案有据可查

6.2 技术发展趋势

RAG技术正在快速发展,未来会有这些变化:

- 更智能的检索:不仅能找相关内容,还能理解上下文关系

- 多模态RAG:不仅能处理文字,还能处理图片、表格甚至音视频

- 个性化RAG:根据用户的历史和偏好调整检索策略

- 端到端优化:检索、生成、评估一体化优化

6.3 给不同读者的建议

如果你是开发者:

- 先从简单的项目开始,比如个人文档助手

- 掌握LangChain等框架,提高开发效率

- 多实验不同的Embedding模型和分块策略

如果你是产品经理:

- 明确业务场景,RAG不是万能的

- 设计用户友好的交互界面

- 考虑知识库的维护和更新机制

如果你是学生或研究者:

- 理解基本原理,不要被各种框架搞晕

- 关注最新的论文和技术进展

- 尝试复现经典的RAG改进方法

6.4 开始行动的建议

我建议你按照这个步骤开始:

学习路径 = [

"第一周:搭建最简单的RAG系统",

"第二周:优化文本分割策略",

"第三周:尝试不同的Embedding模型",

"第四周:实现查询优化功能",

"第五周:添加多轮对话支持",

"第六周:进行系统评估和优化"

]

记住:最好的学习方式是动手实践。选一个你熟悉的领域(比如整理你的学习笔记、公司文档等),从简单的RAG系统开始,逐步添加功能。

6.5 最后的思考

RAG技术让大模型从“凭记忆答题”变成了“查资料答题”,这是一个重要的进步。但它也不是银弹,需要根据具体场景选择合适的方案。

什么时候该用RAG?

- ✅ 需要实时更新的知识

- ✅ 有大量专业文档

- ✅ 要求答案可溯源

- ✅ 数据隐私敏感

什么时候可能不需要RAG?

- ❌ 简单的闲聊对话

- ❌ 创意写作任务

- ❌ 实时性要求极高的场景

技术永远在进步,今天的RAG可能明天就被更好的技术替代。但核心思想——让AI基于可靠信息回答问题——会一直有价值。

我是maoku,希望这篇文章能帮助你理解和应用RAG技术。如果你在实践过程中遇到问题,或者有更好的经验分享,欢迎在评论区交流讨论。让我们一起学习,一起进步!

浙公网安备 33010602011771号

浙公网安备 33010602011771号