软件工程第二次代码练习

软件工程第二次代码练习

视频学习

-

深度学习

- 搭建神经网络结构

- 找到合适的损失函数

- 找到合适的优化函数,更新参数

-

损失函数

- 用来衡量吻合度

-

传统神经网络 VS 卷积神经网络

- 参数太多,导致过拟合

- 使用卷积,达到局部关联,参数共享

-

卷积神经网络具体层

- 卷积层(CONV)

- 池化层(POOL)

- 全连接层(FC)

-

各层的理解

- 卷积层用来做矩阵间的内积运算,达到基本输出

- 池化层保留主要特征的同时,减少了参数和计算量防止过拟合,提高模型泛化能力

- 全连接一般出现在卷积神经网络的最后

-

ReLU函数

- 解决了梯度消失的问题

- 计算速度的特别快

- 收敛速度特别快

代码练习

- MNIST 数据集分类

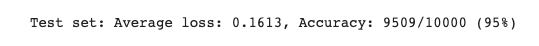

这个就是先用个库搞一些数据,然后构建了两个神经网络,一个是传统的,一个是卷积的,对比了一下二者的区别,在原题像素矩阵下,卷积神经网络的准确率是较高的,但是在改变了原图的像素矩阵后,卷积神经网络的准确度偏低。这是因为对于卷积神经网络,会利用像素的局部关系,但是打乱顺序以后,这些像素间的关系将无法得到利用。

但人们研究的都是有规律的吧,没人会故意把它打乱吧,如果是研究方向的话。

截图:

传统为上,卷积为下

![]()

-

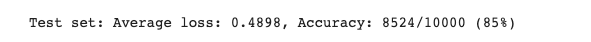

CIFAR10 数据集分类

这是个用来做图片分类的网络,最后的确会错几个

![]()

-

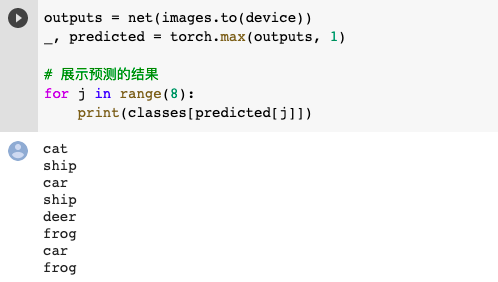

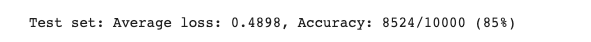

使用 VGG16 对 CIFAR10 分类

最后运行结果是识别图片的正确率

比较简单的网络,就可以达到80%左右的正确率。

![]()

浙公网安备 33010602011771号

浙公网安备 33010602011771号