《Enhancing the Locality and Breaking the Memory Bottleneck of Transformer on Time Series Forecasting》

0.摘要

本文用Transformer(TF)来解决时间序列预测问题。尽管性能不错,但还是有两个主要缺点:(1)locality-agnostics:规范的TF对局部上下文不敏感,可能导致异常;(2)memory bottleneck:规范TF的空间复杂度为O(L^2)。本文的解决方案为;(1)因果卷积self-attention;(2)对数稀疏TF。

1.介绍

传统的时序预测模型,比如:SSMs和AR,有两个缺点:单独拟合每个时序、需要手动选择专业知识,这些阻碍在大规模时序预测任务中更多应用。

RNN存在梯度消失和爆炸的问题,难以训练;LSTM和GRU难以捕捉长期依赖关系;另外,现实世界的预测通常具有长期和短期相重复的模式。在这种情况下,如何对长期依赖关系建模成为实现良好性能的关键步骤。

图穷匕见,提出TF解决时序预测,实验效果真不错,反正比RNN好。问题就是摘要中说的两个:局部不可知和内存瓶颈。那么这篇文章的贡献就很显然了:(1)实验论证TF效果不错;(2)因果卷积self-attention;(3)对数稀疏TF。

2.相关工作

3.背景

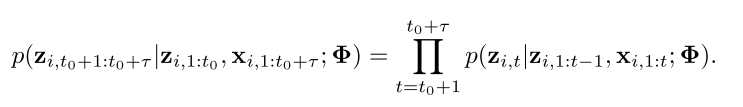

问题定义:有N条相关的时间序列 ,每条时间序列有t0个采样,每次采样都是一个实数,即维度为1。另外,还有N个协变量序列,每个采样是d维向量。我们根据t时刻之前的z以及x(x包括当前t时刻的)来预测当前的z。我们的目标是对下面的条件分布建模:

,每条时间序列有t0个采样,每次采样都是一个实数,即维度为1。另外,还有N个协变量序列,每个采样是d维向量。我们根据t时刻之前的z以及x(x包括当前t时刻的)来预测当前的z。我们的目标是对下面的条件分布建模:

Trandsformer:

4.解决缺点的方法

4.1增强TF的局部性

浙公网安备 33010602011771号

浙公网安备 33010602011771号