OMG-LLaVA学习记录---跑代码前置准备(AutoDL平台)

OMG-LLaVA学习记录---跑代码前置准备(AutoDL平台)

这里我选择了一个显存32GB的GPU,因为我的电脑是8GB,加载模型显存直接爆了(即使加上了4-bit量化)。然后用了一个24GB的GPU,加载模型时也爆了,所以才用了一个32GB的GPU,但是最后实测运行时显存占用实际为15GB左右,稍后再去24GB的GPU上试一试

AutoDL显卡租用

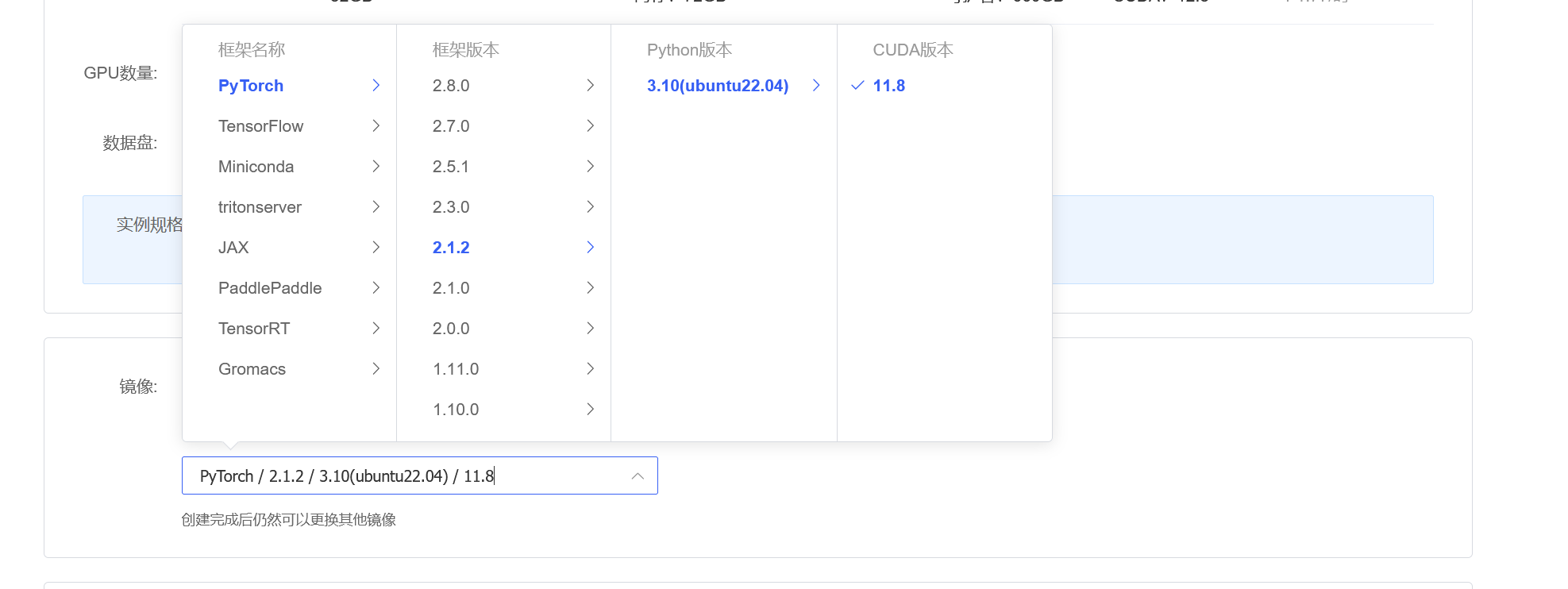

- 首先在AutoDL平台租用个张显存32GB的GPU,(根据搜到的网友反馈)建议西北B区,按量计费,注意这里我们最好不要选择RTX 5090显卡,我们的这个模型要求CUDA==11.8,但是RTX 5090要求的CUDA比较新。

然后我们选择PyTorch框架

按照项目要求选择对应的版本就好

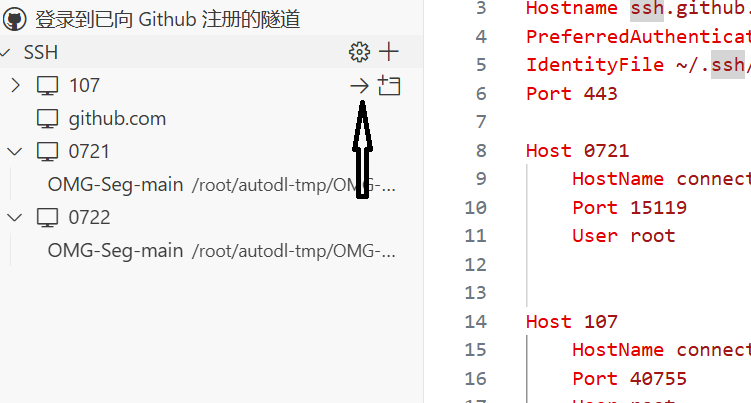

VScode 远程连接

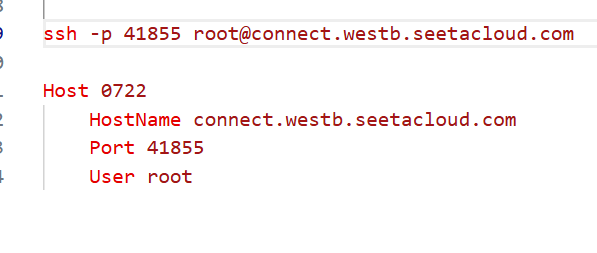

在这里复制登录指令和密码

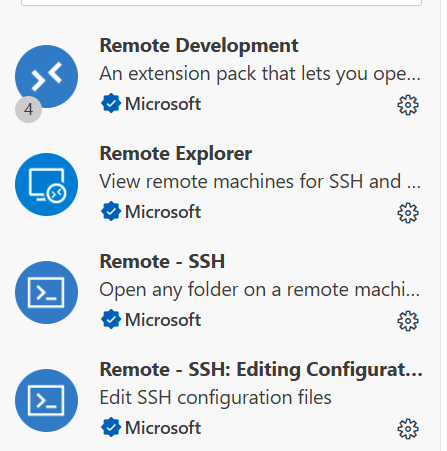

然后打开VS Code, 如果没有下载 这个插件就下载一下

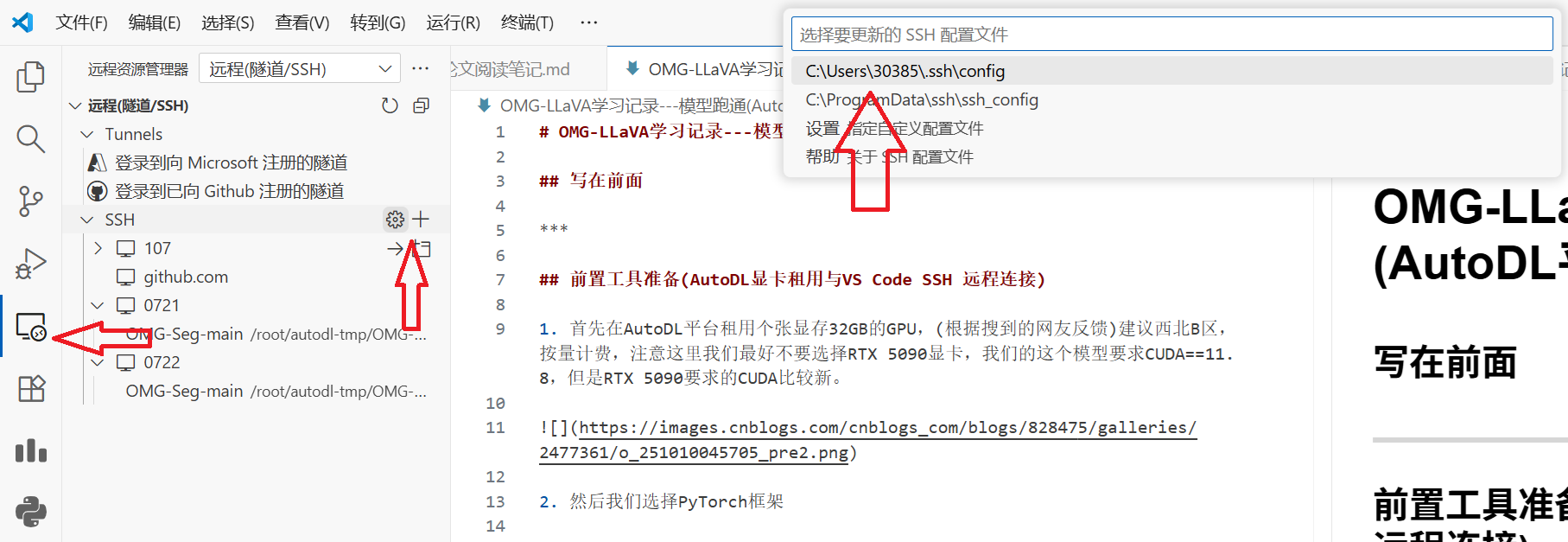

然后配置ssh的config文件

按照这样配置,host可以自己指定

格式写好后把上面那个登录指令删掉

然后点击这个就可以连接到远程了,过程中需要输入密码的话输进去就好了

修改AutoDL的Conda的默认存储路径

系统盘存储空间有限,我们尽量存到数据盘中,数据盘不够可以扩容

首先打开一个终端,创建数据盘存储目录

mkdir -p /root/autodl-tmp/conda/{envs,pkgs}

然后使用vim指令修改配置文件

vim /root/.condarc

在最后写入

envs_dirs:

- /root/autodl-tmp/conda/envs

pkgs_dirs:

- /root/autodl-tmp/conda/pkgs

然后保存退出即可

补充

vim常见指令

:w # 保存文件

:q # 退出 Vim

:wq # 保存并退出

:q! # 强制退出不保存

:w # 保存文件

:q # 退出 Vim

:wq # 保存并退出

:q! # 强制退出不保存

浙公网安备 33010602011771号

浙公网安备 33010602011771号