3.Hadoop_Spak (Hadoop Single Node)

-

安装JDK

Hadoop 用Java开发的,所以需要安装Java环境

在Linux下 使用组合件 Ctrl+Alt+t 呼出终端

ctrl+shft+v 组合键可以粘贴到终端,利用这个和第二节里的共用粘贴板可直接复制指令

“#” 代表注释

输入指令:

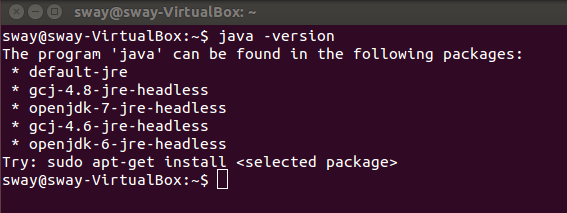

#查询当前java版本

java -version

显示未安装

#安装Java之前更新软件包信息

sudo apt-get update

#安装JDK

sudo apt-get install default-jdk

#可再查询Java版本

java -version

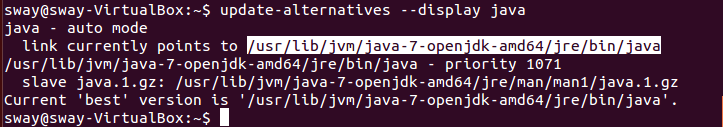

#查询java安装路径,后续需要设置全局变量(白色部分为路径)

update-alternatives --display Java

-

设置SSH无密码登录

在集群之间通过SSH(Secure Shell)连接

后续会通过这个镜像复制多个节点,为方便操作,设置为无密码。

#安装SSH

sudo apt-get install ssh

#安装rsync

sudo apt-get install rysnc

#产生SSH Key 密钥

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

#查看产生的密钥

ll ~/.ssh

#将产生的密钥放到许可文件中

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

-

下载安装hadoop

#下载hadoop-2.6.4tar.gz

wget https://archive.apache.org/dist/hadoop/common/hadoop-2.6.4/hadoop-2.6.4.tar.gz

#解压至hadoop-2.6.4目录

sudo tar -zxvf hadoop-2.6.4.tar.gz

#移动到 /usr/local

sudo mv hadoop-2.6.4 /usr/local/hadoop

-

设置Hadoop环境变量

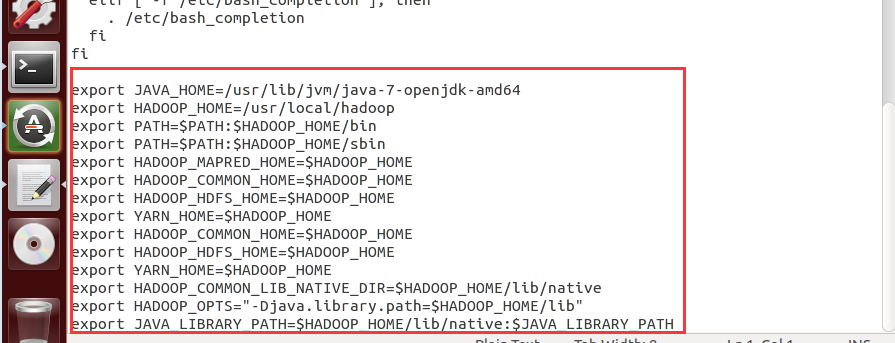

#编辑bashrc

sudo gedit ~/.bashrc

#输入下列内容

export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-amd64

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"

export JAVA_LIBRARY_PATH=$HADOOP_HOME/lib/native:$JAVA_LIBRARY_PATH

#让~/.bashrc修改生效

source ~/.bashrc

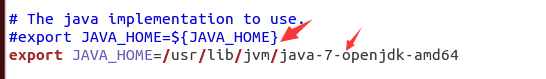

#修改Hadoop-env.sh配置文件

sudo gedit /usr/local/hadoop/etc/hadoop/hadoop-env.sh

#修改下列内容:

export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-amd64

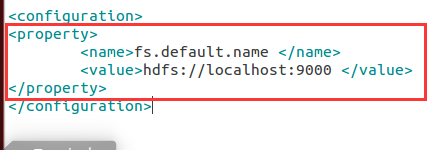

#修改core-site.xml

sudo gedit /usr/local/hadoop/etc/hadoop/core-site.xml

#输入下列内容:

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

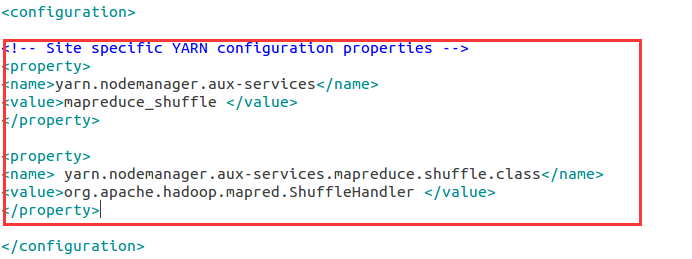

#修改yarn-site.xml

sudo gedit /usr/local/hadoop/etc/hadoop/yarn-site.xml

#输入下列内容

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

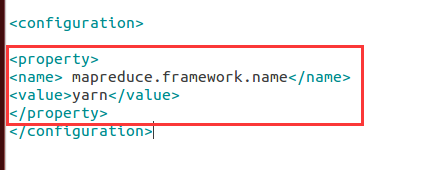

#修改mapred-site.xml

sudo cp /usr/local/hadoop/etc/hadoop/mapred-site.xml.template /usr/local/hadoop/etc/hadoop/mapred-site.xml

sudo gedit /usr/local/hadoop/etc/hadoop/mapred-site.xml

#输入下列内容

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

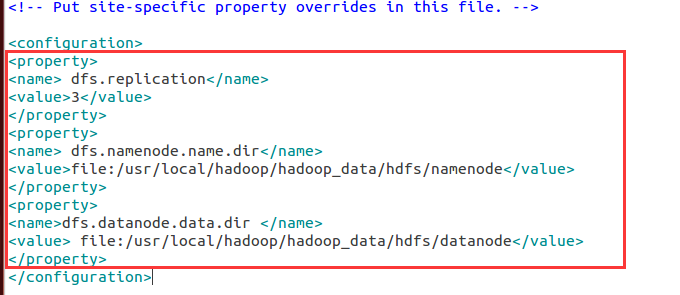

# 修改hdfs-site.xml

sudo gedit /usr/local/hadoop/etc/hadoop/hdfs-site.xml

#输入下列内容:

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/hadoop_data/hdfs/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir </name>

<value>file:/usr/local/hadoop/hadoop_data/hdfs/datanode</value>

</property>

-

创建并格式化HDFS目录

sudo mkdir -p /usr/local/hadoop/hadoop_data/hdfs/namenode

sudo mkdir -p /usr/local/hadoop/hadoop_data/hdfs/datanode

sudo chown sway:sway -R /usr/local/hadoop

#hadoop指令

hadoop namenode -format

-

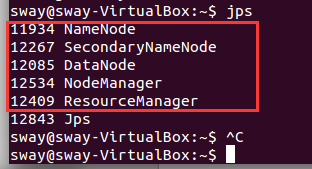

启动Hadoop

#启动start-dfs.sh,再启动 start-yarn.sh

start-dfs.sh

start-yarn.sh

#或者一次性启动

start-all.sh

#查看目前所执行的行程

jps

如果启动的进程少了(包含:NameNode,DataNode,SecondaryNode ResourceManager,NodeManager 共五个)

很有可能是前面的文件配置有问题

注意:<> 前后不要加空格

-

通过网页查看Resource-Manager 和 HDFS

在虚拟机的浏览器中输入:

http://localhost:8088/

http://localhost:50070/

浙公网安备 33010602011771号

浙公网安备 33010602011771号