神经网络 基础

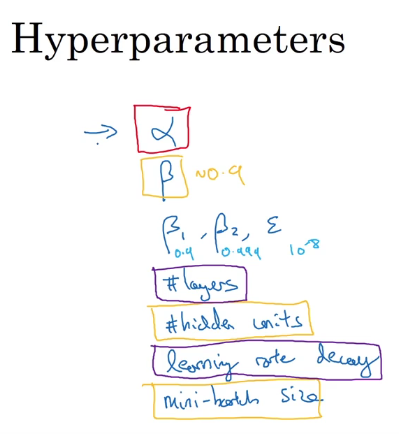

初始参数 & 超参数

神经网络初始值的设置,可以避免多层数的梯度消失

早期的深度学习中,如果存在两个超参数,可以使用 网格法进行调参(网格调参),但是现在尽量不要使用网格法。

在深度学习领域,推荐随机选点,可以选择同等数量的点,用这些随机选取的点作为超参数进行训练。

对于不同优先级的超参数,随机选点可以选取更多优先级的超参数。在实践中,你确定的超参数可能是高维度的,因此,合适的方法是比较重要的。

- 调试处理

吴恩达

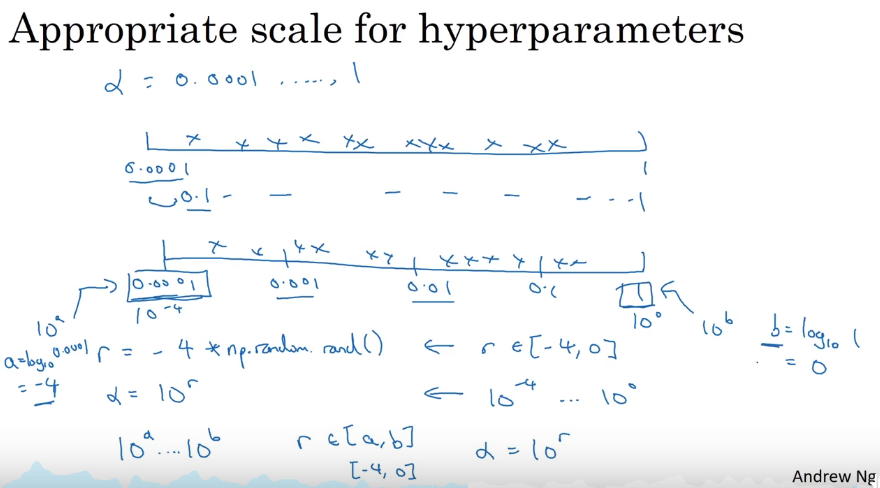

- Log法则

吴恩达

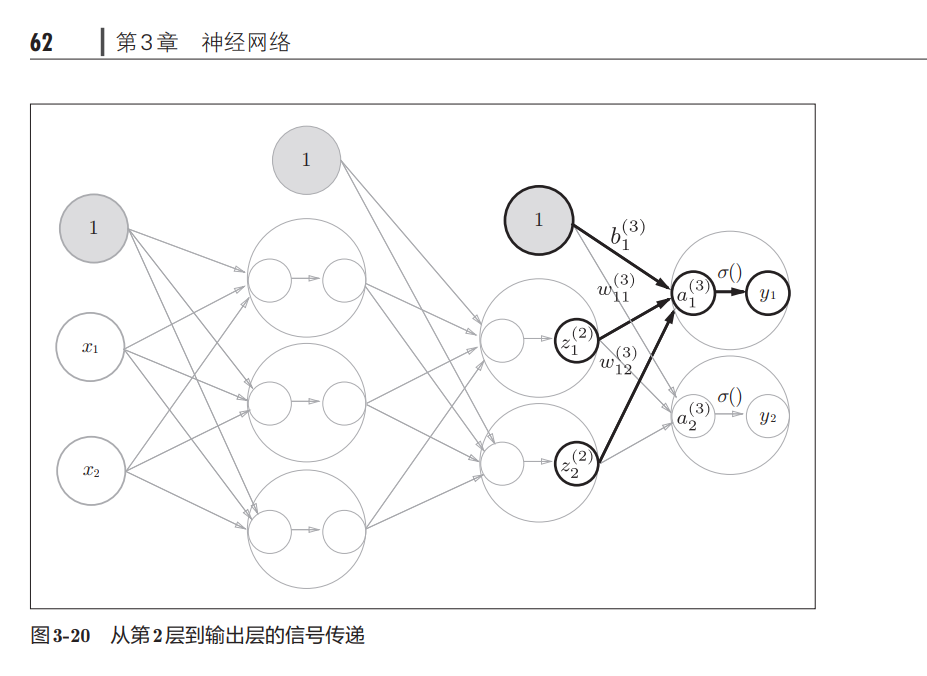

神经网络的常用激活函数

- Sigmoid激活函数

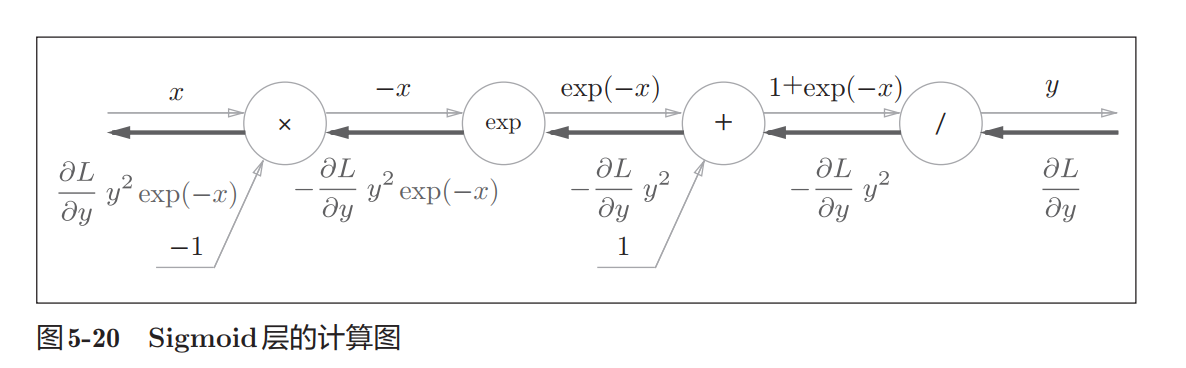

反向传播:

- Relu激活函数

一些技巧:

浙公网安备 33010602011771号

浙公网安备 33010602011771号