MySQL数据库导入或者同步大量数据时数据丢失解决方案

相信大家都经常遇到这样的情况,我们在编码的过程中经常需要在调试代码的时候切换到本地的数据库上做修改调试,如果当测试数据库的数据在几十万或者上百万数据的时候,我们无论是通过恢复备份/导入SQL的方式来把数据导入到本地的MySQL数据库的时候,数据都是无法导入完成的,经常会遇到丢失数据的情况。解决方案:

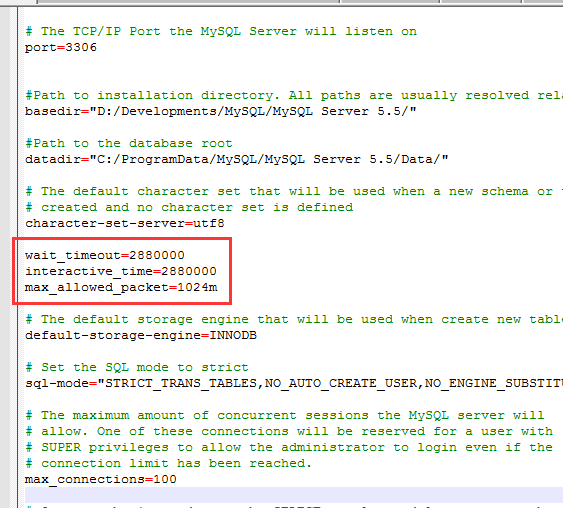

解决方案:在mysql的配置文件my.ini的文件中新增以下3个配置选项:

1、wait_timeout=2880000

2、interactive_time=2880000

3、max_allowed_packet=1024m

如图所示:

添加完成以后保存配置文件,然后重启mysql服务就好了!

出现这类情况的原因蛀牙是因为某些表的数据太多,解析时间太长导致写入超时,然后就会直接跳入下一个表;导致数据不全,max_allowed_packet主要是调整MySQL的最大导入容量,不是越大越好哦! 一般256M就可以了。

浙公网安备 33010602011771号

浙公网安备 33010602011771号