第四期书生大模型实战营【基础岛】—— 书生大模型全链路开源体系

书生大模型全链路开源体系

书生·浦语概览

书生·浦语发展历程

核心技术思路

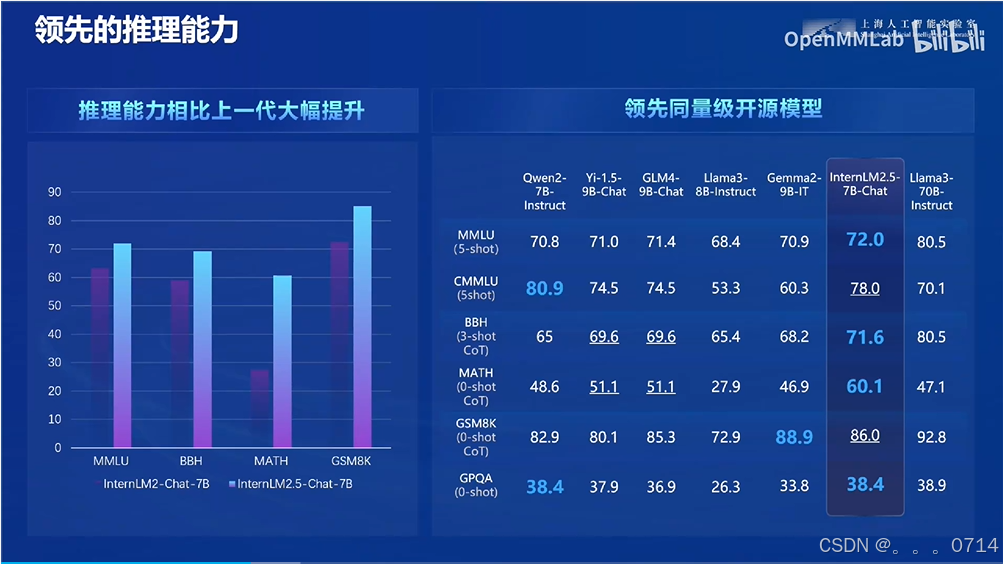

领先的推理能力

(1)数学推理

(2)大海捞针

大海捞针测试(灵感来自NeedleInAHaystack)是一种评估方法,它通过在长文本中随机插入关键信息,形成大型语言模型(LLM)的Prompt。该测试旨在检测大型模型是否能从长文本中提取出这些关键信息,从而评估模型处理长文本信息提取的能力,这可以反映LLM对长文本的理解基础能力。

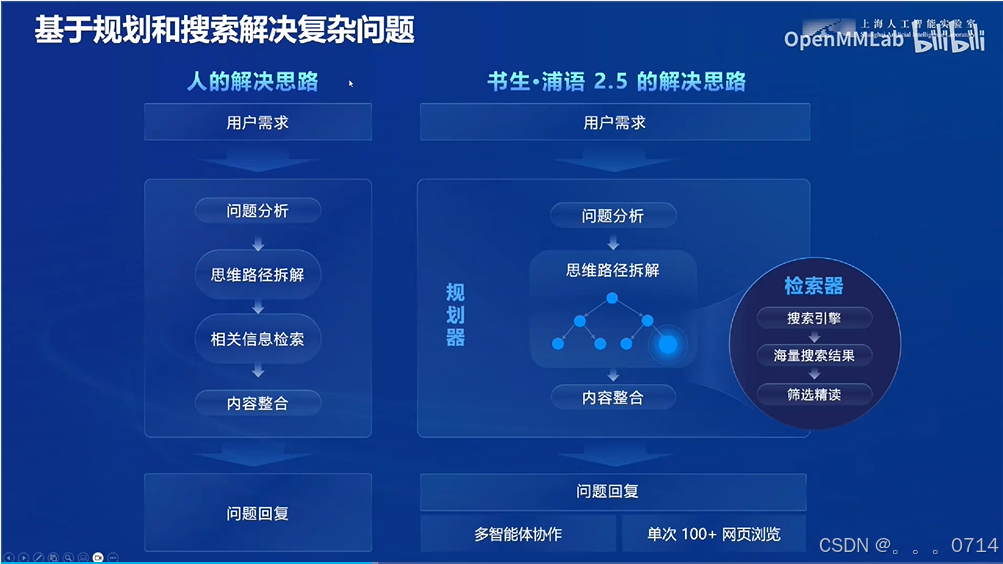

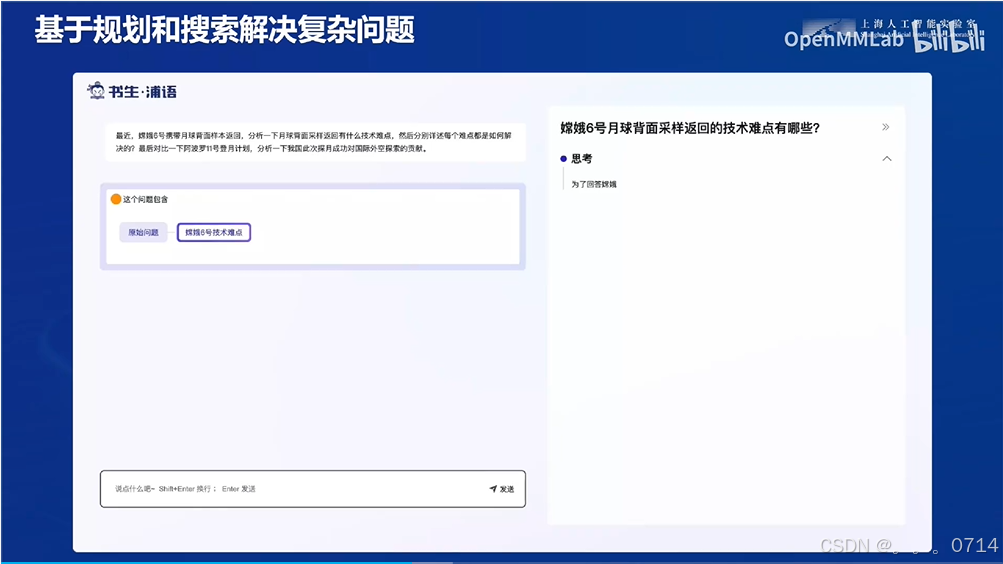

(3)基于规划搜索解决复杂问题

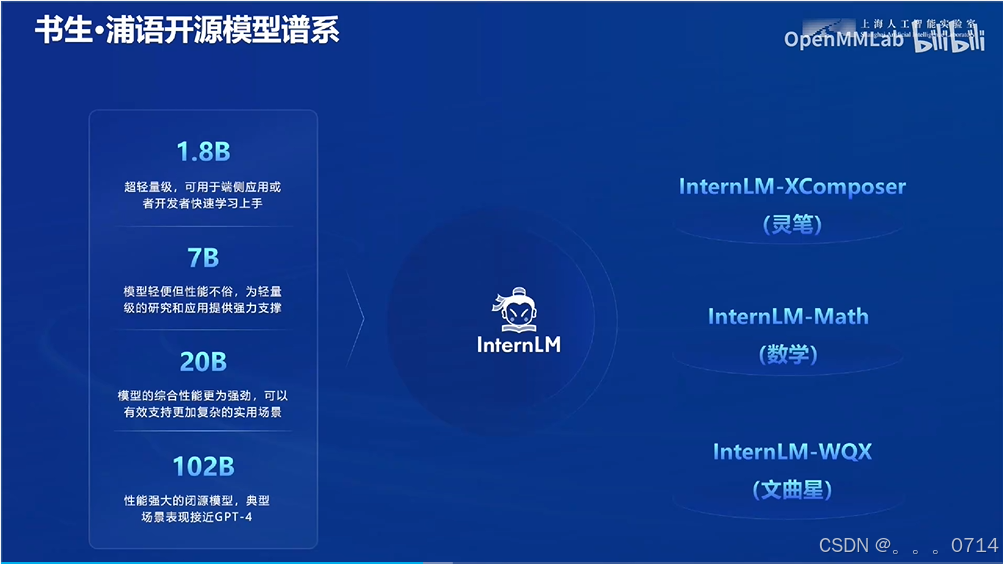

书生大模型全链路开源体系

开源数据处理工具箱

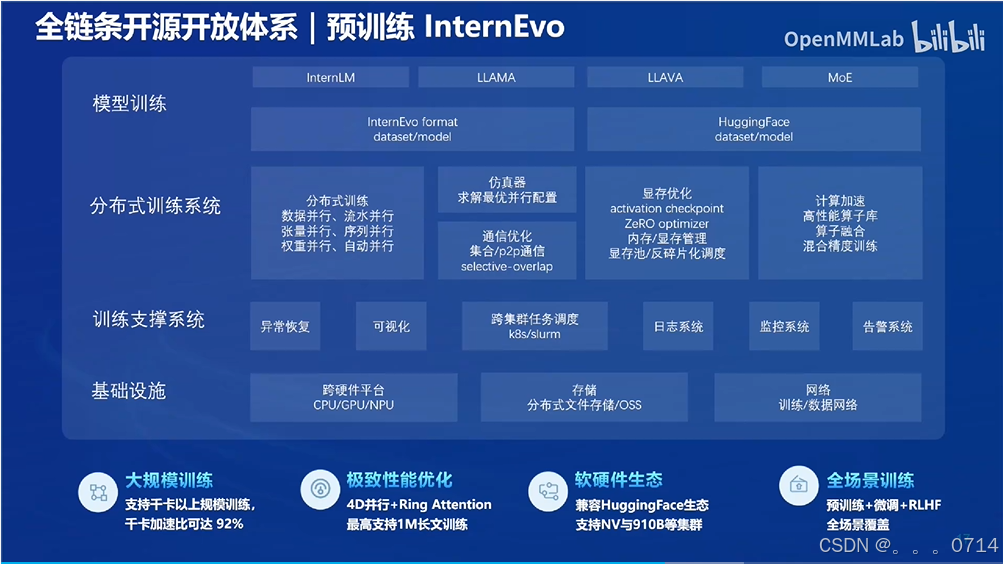

预训练InternEvo

InternEvo是一个开源的轻量级训练框架,旨在支持无需大量依赖关系的模型预训练。凭借单一代码库,InternEvo支持在具有上千GPU的大规模集群上进行预训练,并在单个GPU上进行微调,同时可实现显著的性能优化。当在1024个GPU上进行训练时,InternEvo可实现近90%的加速效率。

基于InternEvo训练框架,我们累计发布了一系列大语言模型,包括InternLM-7B系列和InternLM-20B系列,这些模型在性能上显著超越了许多知名的开源LLMs,如LLaMA和其他模型。

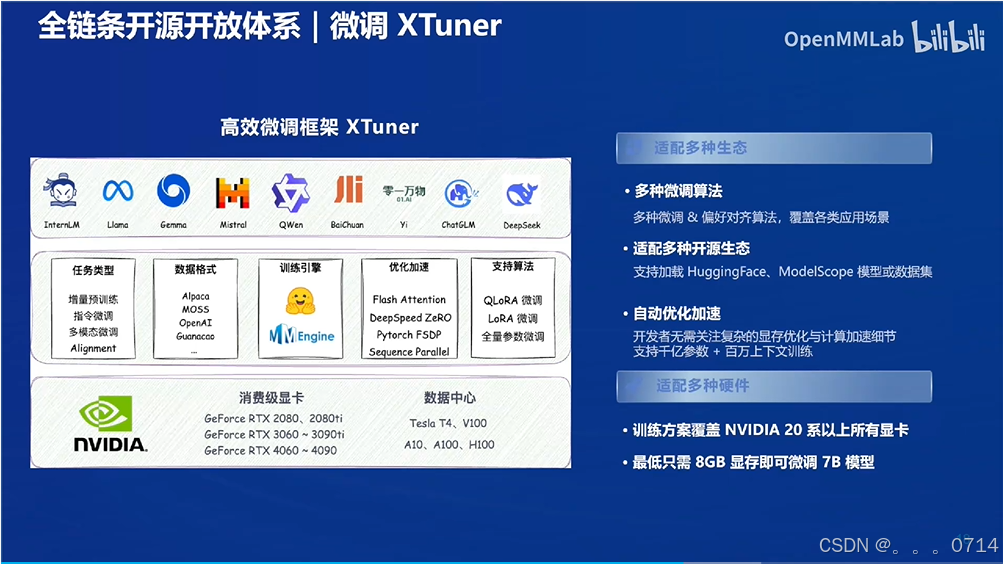

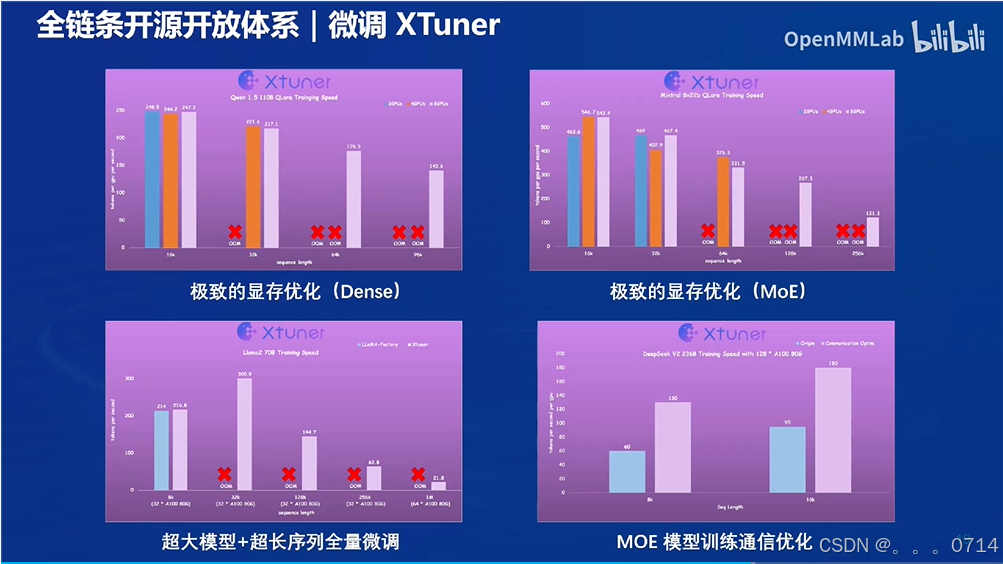

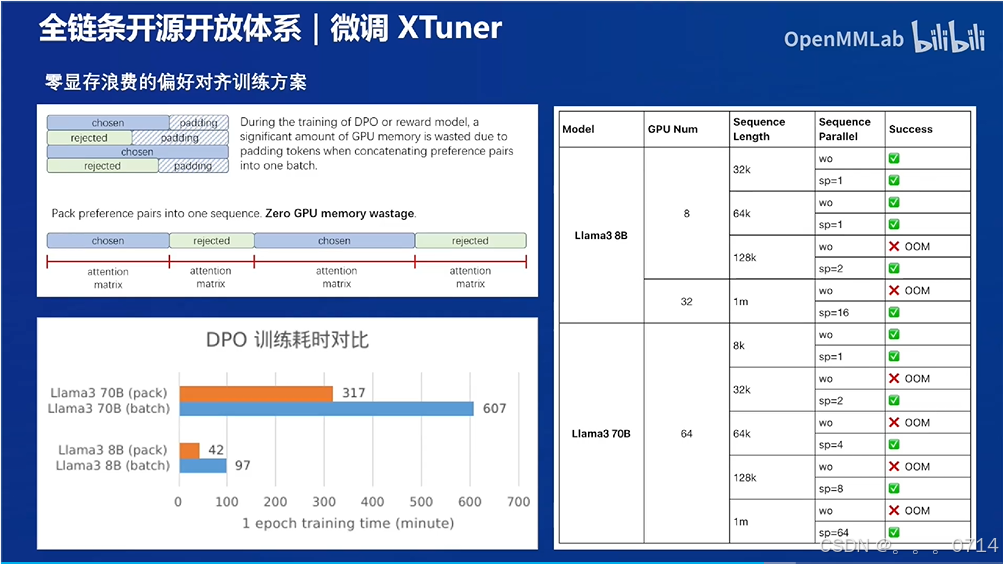

微调XTuner

XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。

高效

- 支持大语言模型 LLM、多模态图文模型 VLM 的预训练及轻量级微调。XTuner 支持在 8GB 显存下微调 7B模型,同时也支持多节点跨设备微调更大尺度模型(70B+)。 自动分发高性能算子(如 FlashAttention、Tritonkernels 等)以加速训练吞吐。

- 兼容 DeepSpeed 🚀,轻松应用各种 ZeRO 训练优化策略。

灵活

- 支持多种大语言模型,包括但不限于 InternLM、Mixtral-8x7B、Llama 2、ChatGLM、Qwen、Baichuan。

- 支持多模态图文模型 LLaVA 的预训练与微调。利用 XTuner 训得模型 LLaVA-InternLM2-20B 表现优异。

- 精心设计的数据管道,兼容任意数据格式,开源数据或自定义数据皆可快速上手。 支持QLoRA、LoRA、全量参数微调等多种微调算法,支撑用户根据具体需求作出最优选择。

全能

- 支持增量预训练、指令微调与 Agent 微调。 预定义众多开源对话模版,支持与开源或训练所得模型进行对话。

- 训练所得模型可无缝接入部署工具库 LMDeploy、大规模评测工具库OpenCompass 及 VLMEvalKit。

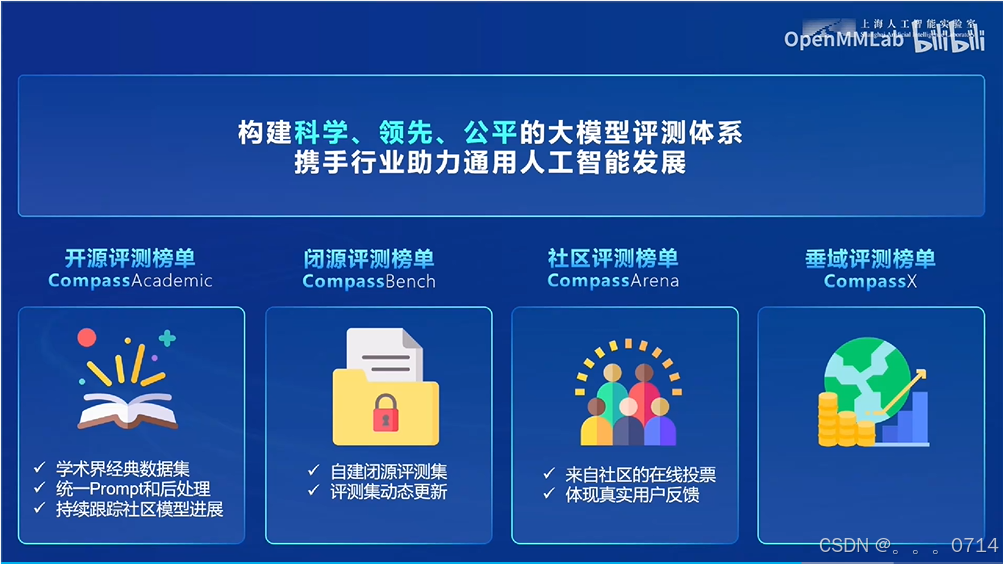

OpenCompass评测

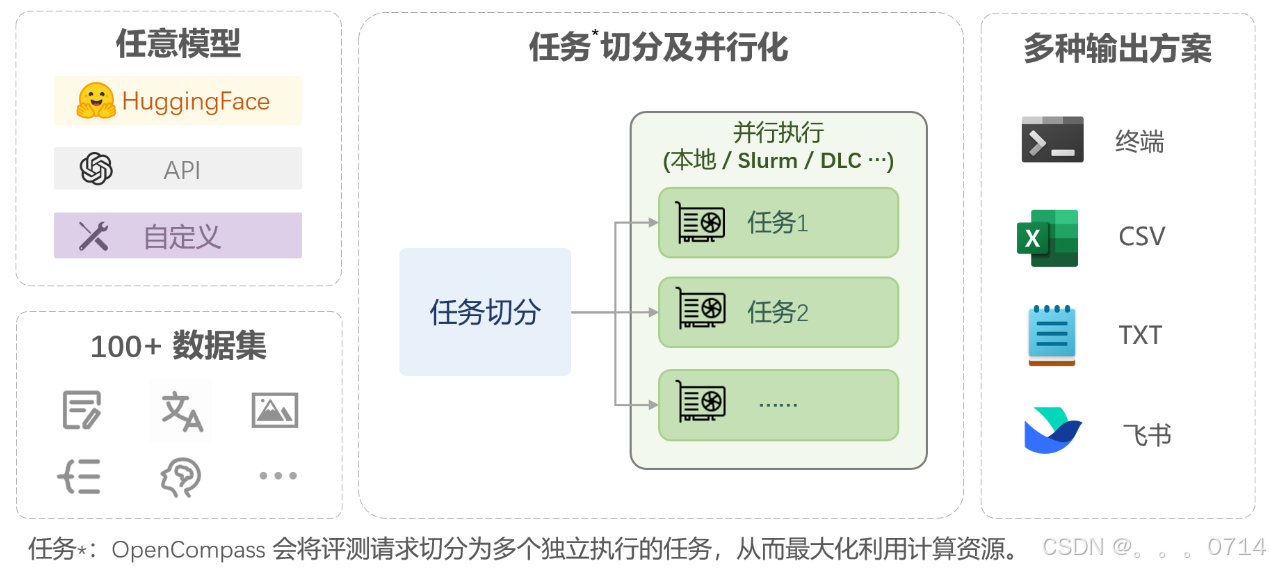

OpenCompass 是面向大模型评测的一站式平台。其主要特点如下:

- 开源可复现:提供公平、公开、可复现的大模型评测方案。

- 全面的能力维度:五大维度设计,提供 70+ 个数据集约 40 万题的的模型评测方案,全面评估模型能力。

- 丰富的模型支持:已支持 20+ HuggingFace 及 API 模型。

- 分布式高效评测:一行命令实现任务分割和分布式评测,数小时即可完成千亿模型全量评测。

- 多样化评测范式:支持零样本、小样本及思维链评测,结合标准型或对话型提示词模板,轻松激发各种模型最大性能。

- 灵活化拓展:想增加新模型或数据集?想要自定义更高级的任务分割策略,甚至接入新的集群管理系统?OpenCompass 的一切均可轻松扩展!

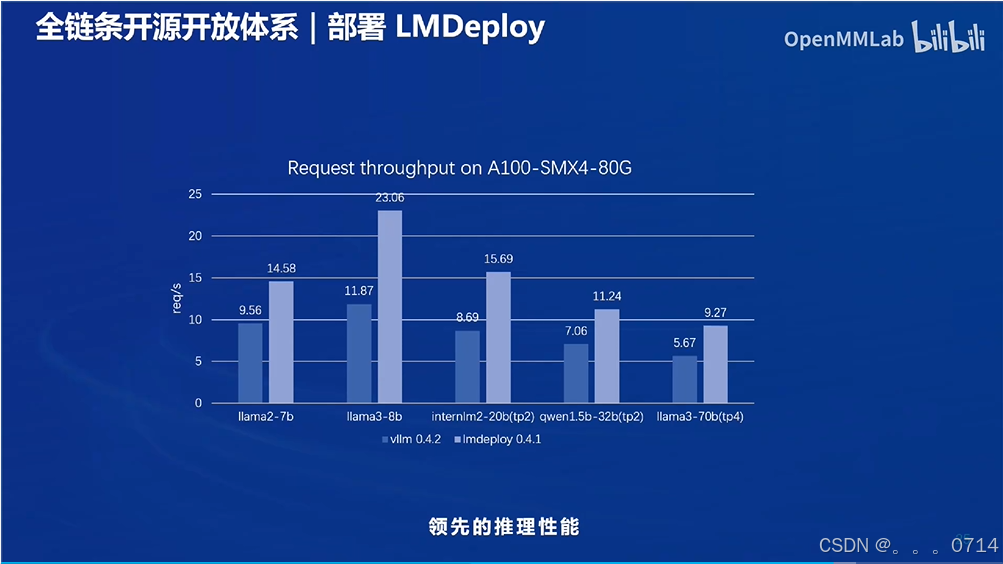

部署LMDeploy

LMDeploy 由 MMDeploy 和 MMRazor 团队联合开发,是涵盖了 LLM 任务的全套轻量化、部署和服务解决方案。 这个强大的工具箱提供以下核心功能:

- 高效的推理:LMDeploy 开发了 Persistent Batch(即 Continuous Batch),Blocked K/V Cache,动态拆分和融合,张量并行,高效的计算 kernel等重要特性。推理性能是 vLLM 的 1.8 倍。

- 可靠的量化:LMDeploy 支持权重量化和 k/v 量化。4bit 模型推理效率是 FP16 下的 2.4 倍。量化模型的可靠性已通过OpenCompass 评测得到充分验证。

- 便捷的服务:通过请求分发服务,LMDeploy 支持多模型在多机、多卡上的推理服务。

- 有状态推理:通过缓存多轮对话过程中 attention 的k/v,记住对话历史,从而避免重复处理历史会话。显著提升长文本多轮对话场景中的效率。

- 卓越的兼容性: LMDeploy 支持 KV Cache 量化, AWQ 和 Automatic Prefix Caching 同时使用。

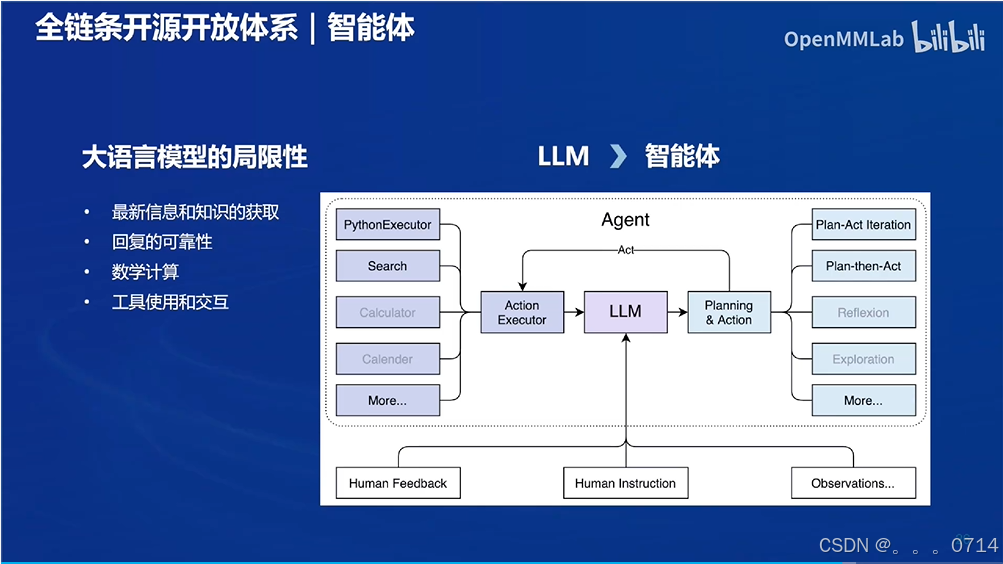

智能体

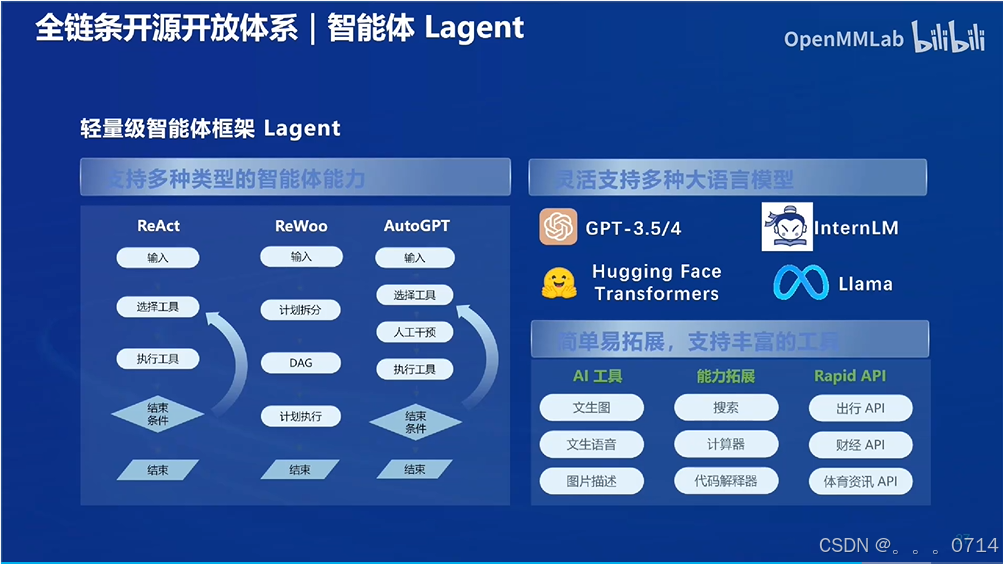

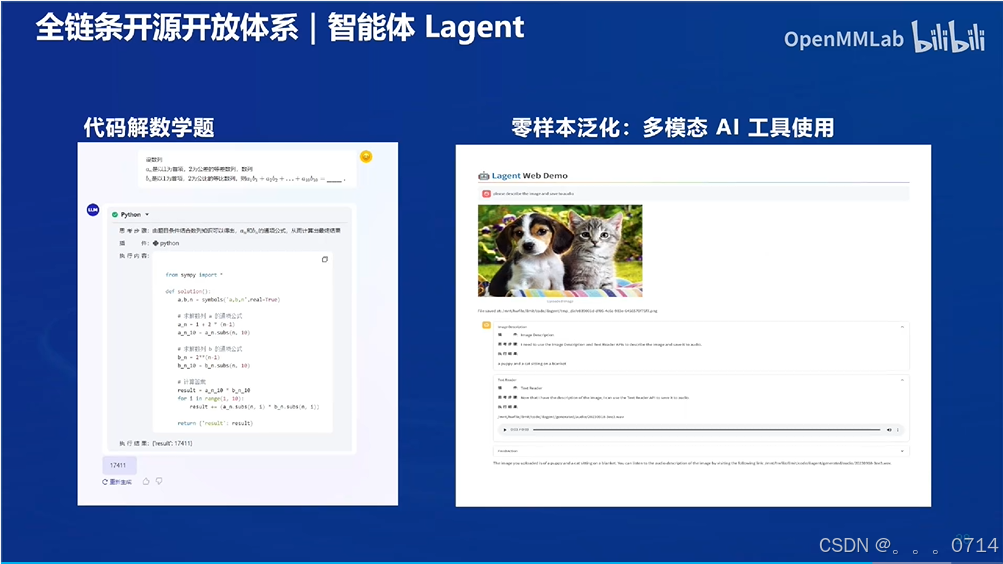

Lagent

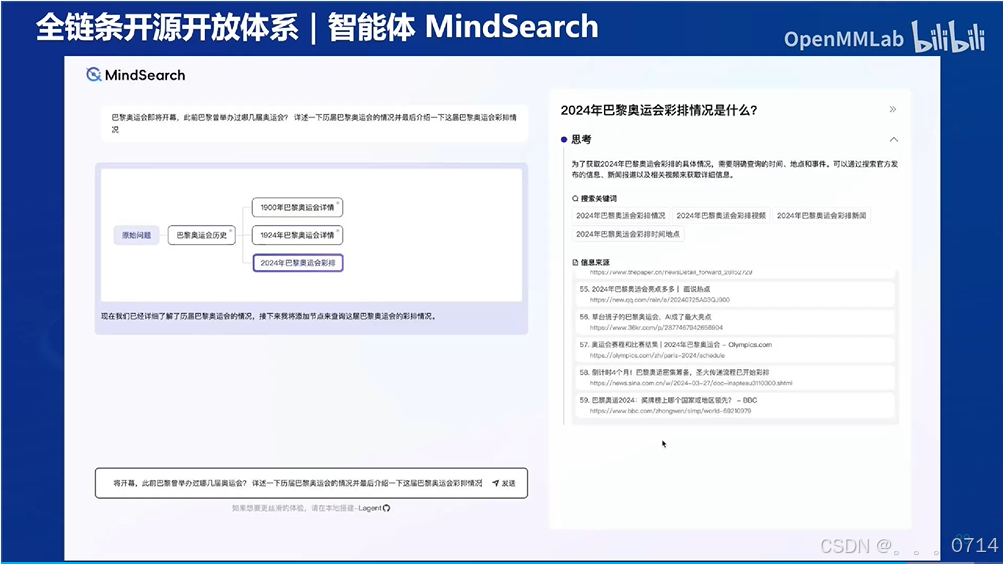

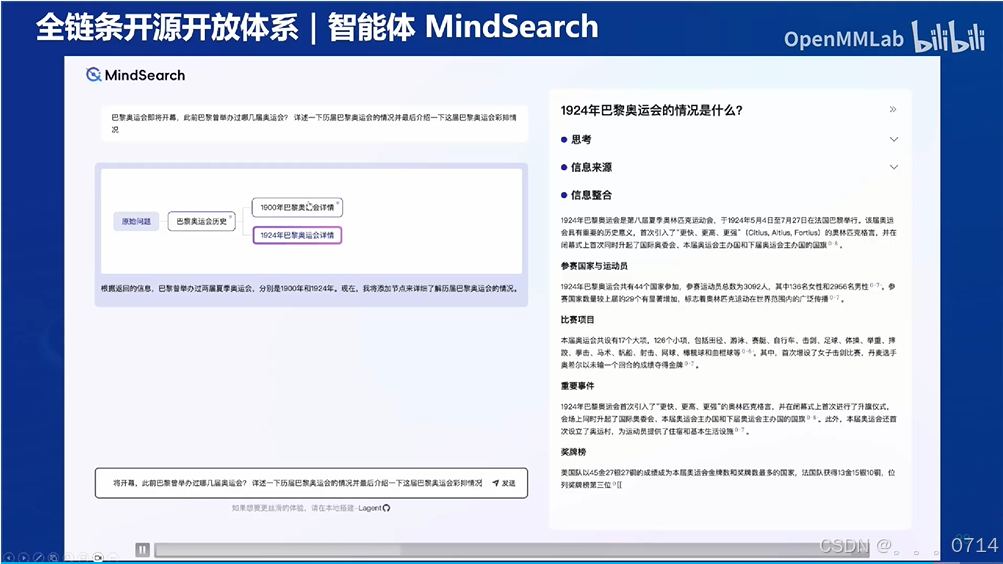

MindSearch

MindSearch 是一个开源的 AI 搜索引擎框架,具有与 Perplexity.ai Pro 相同的性能。您可以轻松部署它来构建您自己的搜索引擎,可以使用闭源 LLM(如 GPT、Claude)或开源 LLM(InternLM2.5 系列模型经过专门优化,能够在 MindSearch 框架中提供卓越的性能;其他开源模型没做过具体测试)。其拥有以下特性:

- 🤔 任何想知道的问题:MindSearch 通过搜索解决你在生活中遇到的各种问题

- 📚 深度知识探索:MindSearch通过数百网页的浏览,提供更广泛、深层次的答案

- 🔍 透明的解决方案路径:MindSearch提供了思考路径、搜索关键词等完整的内容,提高回复的可信度和可用性。

- 💻 多种用户界面:为用户提供各种接口,包括React、Gradio、Streamlit 和本地调试。根据需要选择任意类型。

- 🧠 动态图构建过程:MindSearch将用户查询分解为图中的子问题节点,并根据 WebSearcher 的搜索结果逐步扩展图。

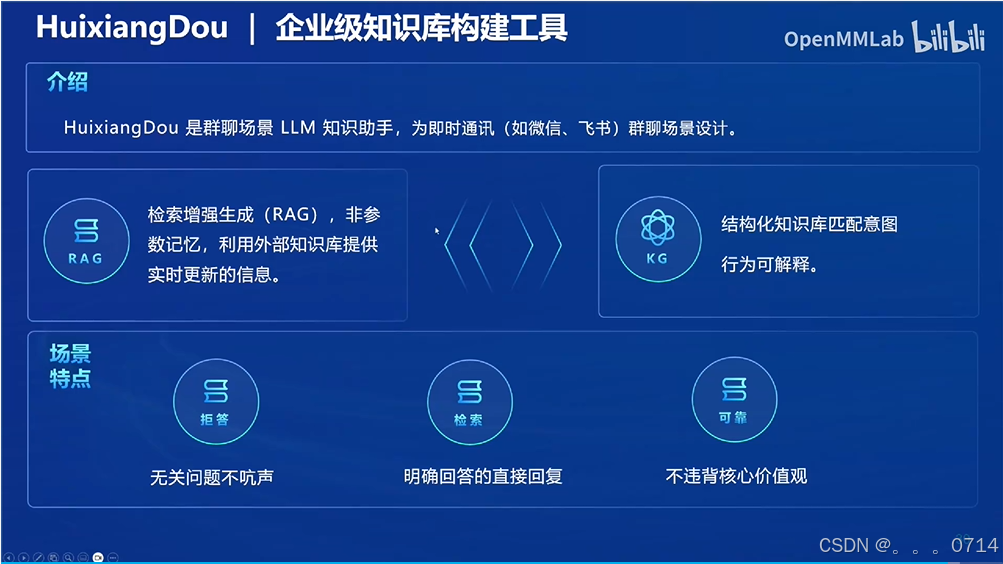

HuixiangDou

浙公网安备 33010602011771号

浙公网安备 33010602011771号