第四期书生大模型实战营【进阶岛】—— Lagent 自定义你的 Agent 智能体

Lagent 自定义你的 Agent 智能体

任务描述

- 使用 Lagent 复现文档中 “制作一个属于自己的Agent” 和 “Multi-Agents博客写作系统的搭建”两部分内容,记录复现过程并截图。

- 将你的Agent部署到 Hugging Face 或 ModelScope 平台,应用名包含 Lagent 关键词(优秀学员必做,注意千万别泄露了 API Key,不要在上传到 Hugging Face 的代码里面明文写 Key 而是使用环境变量的方式获取。)

以下所有内容参考教程。

Agent 动手实践

环境配置

创建虚拟环境并安装依赖。

# 创建环境

conda create -n lagent python=3.10 -y

# 激活环境

conda activate lagent

# 安装 torch

conda install pytorch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 pytorch-cuda=12.1 -c pytorch -c nvidia -y

# 安装其他依赖包

pip install termcolor==2.4.0

pip install streamlit==1.39.0

pip install class_registry==2.1.2

pip install datasets==3.1.0

源码安装Lagent。

# 创建目录以存放代码

mkdir -p /root/agent_camp4

cd /root/agent_camp4

git clone https://github.com/InternLM/lagent.git

cd lagent && git checkout e304e5d && pip install -e . && cd ..

pip install griffe==0.48.0

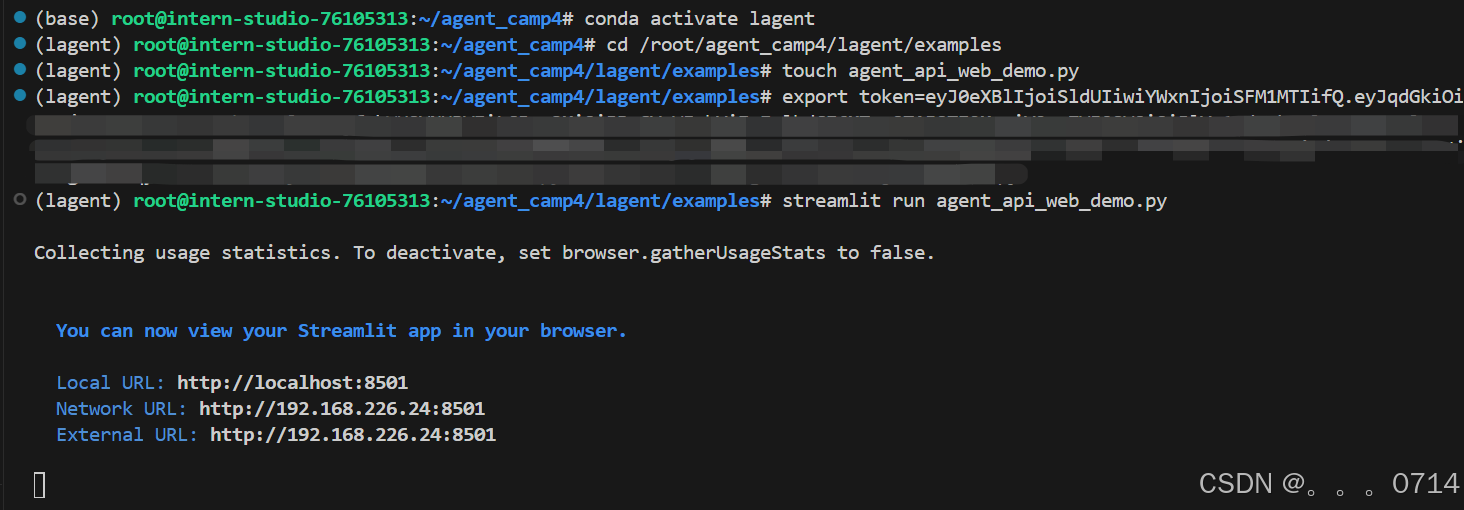

Lagent 框架中 Agent 的使用

conda activate lagent

cd /root/agent_camp4/lagent/examples

touch agent_api_web_demo.py

Action,也称为工具,Lagent中集成了很多好用的工具,提供了一套LLM驱动的智能体用来与真实世界交互并执行复杂任务的函数,包括谷歌文献检索、Arxiv文献检索、Python编译器等。具体可以查看文档。

让LLM调用Arxiv文献检索这个工具。

在agent_api_web_demo.py中写入下面的代码,这里利用 GPTAPI 类,该类继承自 BaseAPILLM,封装了对 API 的调用逻辑,然后利用Streamlit启动Web服务。

import copy

import os

from typing import List

import streamlit as st

from lagent.actions import ArxivSearch

from lagent.prompts.parsers import PluginParser

from lagent.agents.stream import INTERPRETER_CN, META_CN, PLUGIN_CN, AgentForInternLM, get_plugin_prompt

from lagent.llms import GPTAPI

class SessionState:

"""管理会话状态的类。"""

def init_state(self):

"""初始化会话状态变量。"""

st.session_state['assistant'] = [] # 助手消息历史

st.session_state['user'] = [] # 用户消息历史

# 初始化插件列表

action_list = [

ArxivSearch(),

]

st.session_state['plugin_map'] = {action.name: action for action in action_list}

st.session_state['model_map'] = {} # 存储模型实例

st.session_state['model_selected'] = None # 当前选定模型

st.session_state['plugin_actions'] = set() # 当前激活插件

st.session_state['history'] = [] # 聊天历史

st.session_state['api_base'] = None # 初始化API base地址

def clear_state(self):

"""清除当前会话状态。"""

st.session_state['assistant'] = []

st.session_state['user'] = []

st.session_state['model_selected'] = None

class StreamlitUI:

"""管理 Streamlit 界面的类。"""

def __init__(self, session_state: SessionState):

self.session_state = session_state

self.plugin_action = [] # 当前选定的插件

# 初始化提示词

self.meta_prompt = META_CN

self.plugin_prompt = PLUGIN_CN

self.init_streamlit()

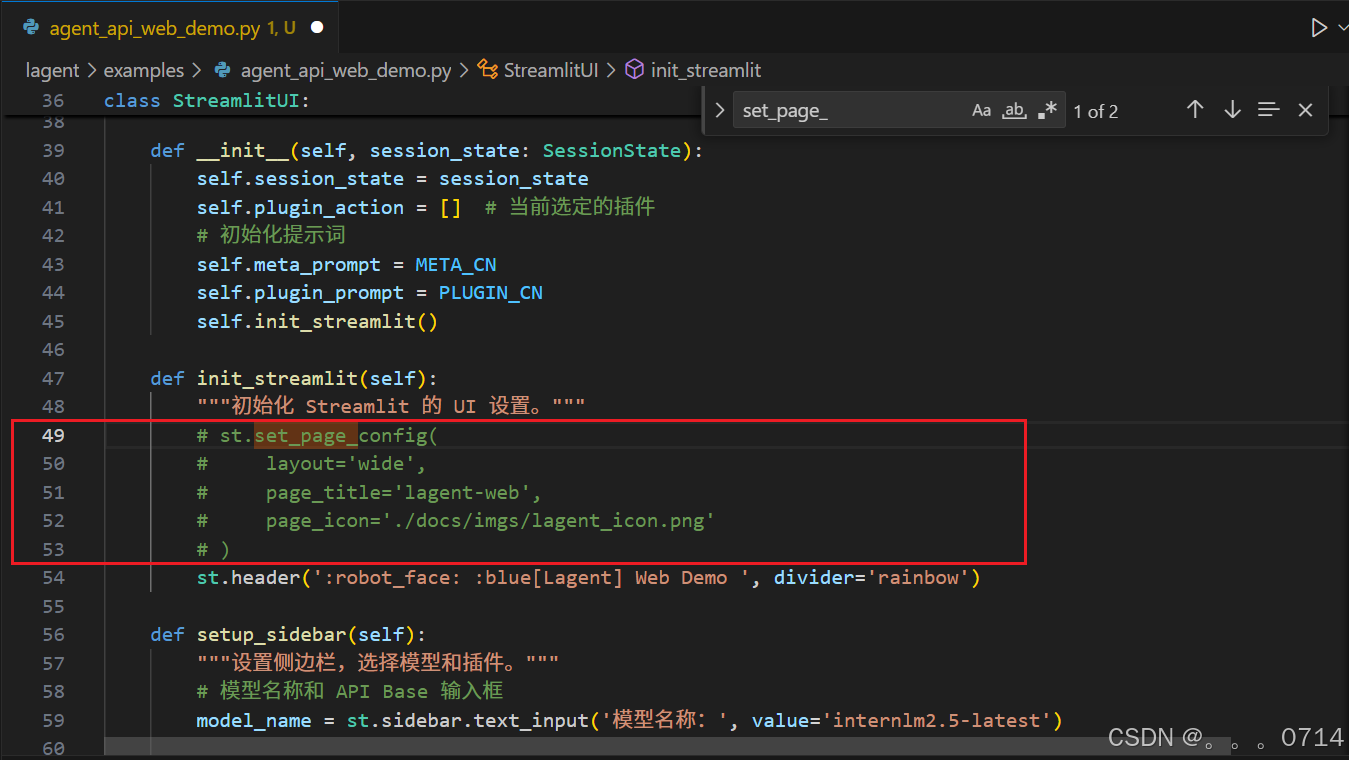

def init_streamlit(self):

"""初始化 Streamlit 的 UI 设置。"""

st.set_page_config(

layout='wide',

page_title='lagent-web',

page_icon='./docs/imgs/lagent_icon.png'

)

st.header(':robot_face: :blue[Lagent] Web Demo ', divider='rainbow')

def setup_sidebar(self):

"""设置侧边栏,选择模型和插件。"""

# 模型名称和 API Base 输入框

model_name = st.sidebar.text_input('模型名称:', value='internlm2.5-latest')

# ================================== 硅基流动的API ==================================

# 注意,如果采用硅基流动API,模型名称需要更改为:internlm/internlm2_5-7b-chat 或者 internlm/internlm2_5-20b-chat

# api_base = st.sidebar.text_input(

# 'API Base 地址:', value='https://api.siliconflow.cn/v1/chat/completions'

# )

# ================================== 浦语官方的API ==================================

api_base = st.sidebar.text_input(

'API Base 地址:', value='https://internlm-chat.intern-ai.org.cn/puyu/api/v1/chat/completions'

)

# ==================================================================================

# 插件选择

plugin_name = st.sidebar.multiselect(

'插件选择',

options=list(st.session_state['plugin_map'].keys()),

default=[],

)

# 根据选择的插件生成插件操作列表

self.plugin_action = [st.session_state['plugin_map'][name] for name in plugin_name]

# 动态生成插件提示

if self.plugin_action:

self.plugin_prompt = get_plugin_prompt(self.plugin_action)

# 清空对话按钮

if st.sidebar.button('清空对话', key='clear'):

self.session_state.clear_state()

return model_name, api_base, self.plugin_action

def initialize_chatbot(self, model_name, api_base, plugin_action):

"""初始化 GPTAPI 实例作为 chatbot。"""

token = os.getenv("token")

if not token:

st.error("未检测到环境变量 `token`,请设置环境变量,例如 `export token='your_token_here'` 后重新运行 X﹏X")

st.stop() # 停止运行应用

# 创建完整的 meta_prompt,保留原始结构并动态插入侧边栏配置

meta_prompt = [

{"role": "system", "content": self.meta_prompt, "api_role": "system"},

{"role": "user", "content": "", "api_role": "user"},

{"role": "assistant", "content": self.plugin_prompt, "api_role": "assistant"},

{"role": "environment", "content": "", "api_role": "environment"}

]

api_model = GPTAPI(

model_type=model_name,

api_base=api_base,

key=token, # 从环境变量中获取授权令牌

meta_template=meta_prompt,

max_new_tokens=512,

temperature=0.8,

top_p=0.9

)

return api_model

def render_user(self, prompt: str):

"""渲染用户输入内容。"""

with st.chat_message('user'):

st.markdown(prompt)

def render_assistant(self, agent_return):

"""渲染助手响应内容。"""

with st.chat_message('assistant'):

content = getattr(agent_return, "content", str(agent_return))

st.markdown(content if isinstance(content, str) else str(content))

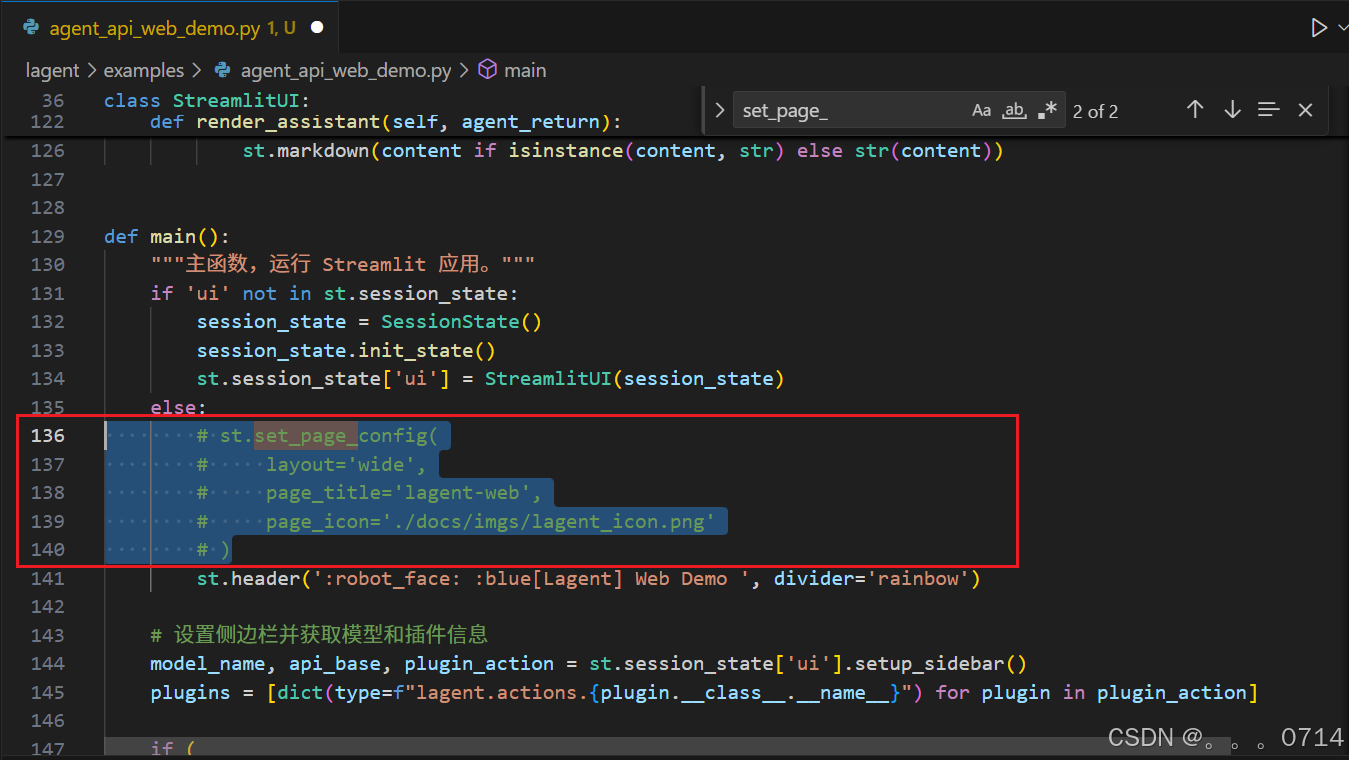

def main():

"""主函数,运行 Streamlit 应用。"""

if 'ui' not in st.session_state:

session_state = SessionState()

session_state.init_state()

st.session_state['ui'] = StreamlitUI(session_state)

else:

st.set_page_config(

layout='wide',

page_title='lagent-web',

page_icon='./docs/imgs/lagent_icon.png'

)

st.header(':robot_face: :blue[Lagent] Web Demo ', divider='rainbow')

# 设置侧边栏并获取模型和插件信息

model_name, api_base, plugin_action = st.session_state['ui'].setup_sidebar()

plugins = [dict(type=f"lagent.actions.{plugin.__class__.__name__}") for plugin in plugin_action]

if (

'chatbot' not in st.session_state or

model_name != st.session_state['chatbot'].model_type or

'last_plugin_action' not in st.session_state or

plugin_action != st.session_state['last_plugin_action'] or

api_base != st.session_state['api_base']

):

# 更新 Chatbot

st.session_state['chatbot'] = st.session_state['ui'].initialize_chatbot(model_name, api_base, plugin_action)

st.session_state['last_plugin_action'] = plugin_action # 更新插件状态

st.session_state['api_base'] = api_base # 更新 API Base 地址

# 初始化 AgentForInternLM

st.session_state['agent'] = AgentForInternLM(

llm=st.session_state['chatbot'],

plugins=plugins,

output_format=dict(

type=PluginParser,

template=PLUGIN_CN,

prompt=get_plugin_prompt(plugin_action)

)

)

# 清空对话历史

st.session_state['session_history'] = []

if 'agent' not in st.session_state:

st.session_state['agent'] = None

agent = st.session_state['agent']

for prompt, agent_return in zip(st.session_state['user'], st.session_state['assistant']):

st.session_state['ui'].render_user(prompt)

st.session_state['ui'].render_assistant(agent_return)

# 处理用户输入

if user_input := st.chat_input(''):

st.session_state['ui'].render_user(user_input)

# 调用模型时确保侧边栏的系统提示词和插件提示词生效

res = agent(user_input, session_id=0)

st.session_state['ui'].render_assistant(res)

# 更新会话状态

st.session_state['user'].append(user_input)

st.session_state['assistant'].append(copy.deepcopy(res))

st.session_state['last_status'] = None

if __name__ == '__main__':

main()

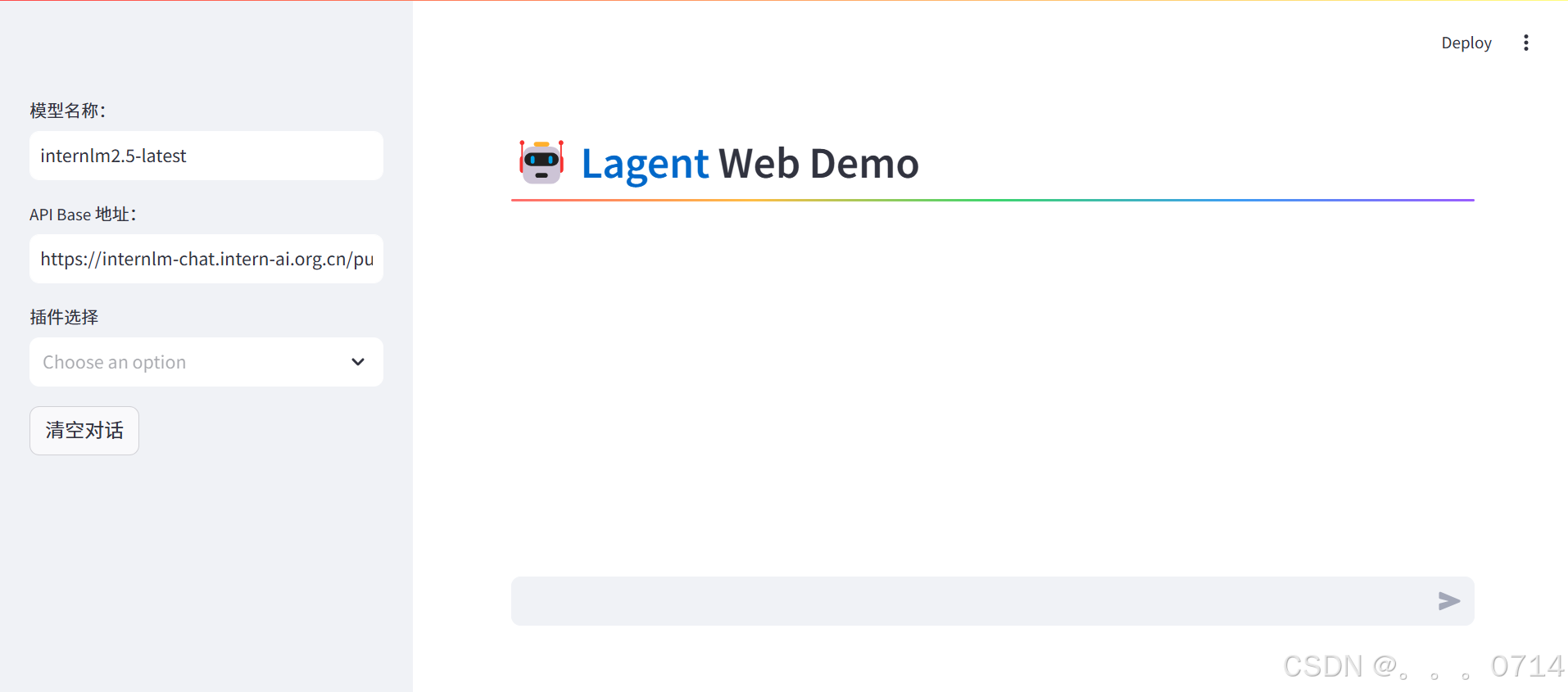

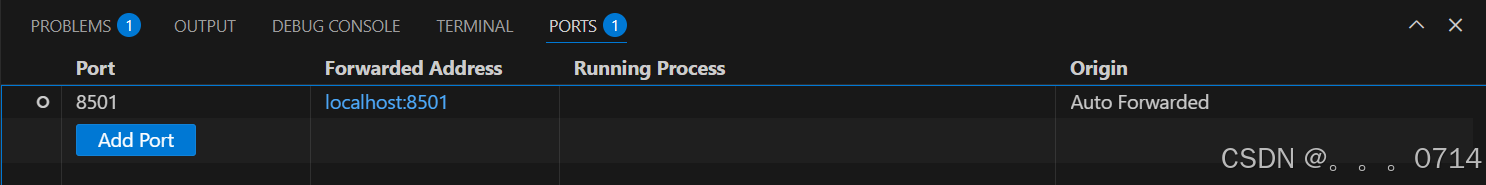

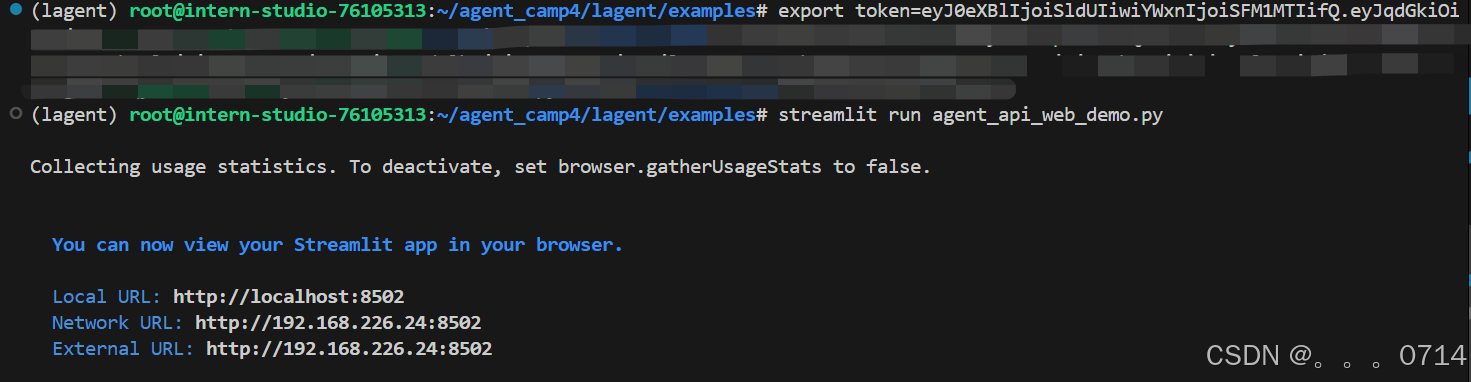

运行以下命令后跳出弹窗,点击转到 Web UI 页面。

export token='your_token_here'

streamlit run agent_api_web_demo.py

若使用VScode远程连接,则VScode会自动建立端口映射。

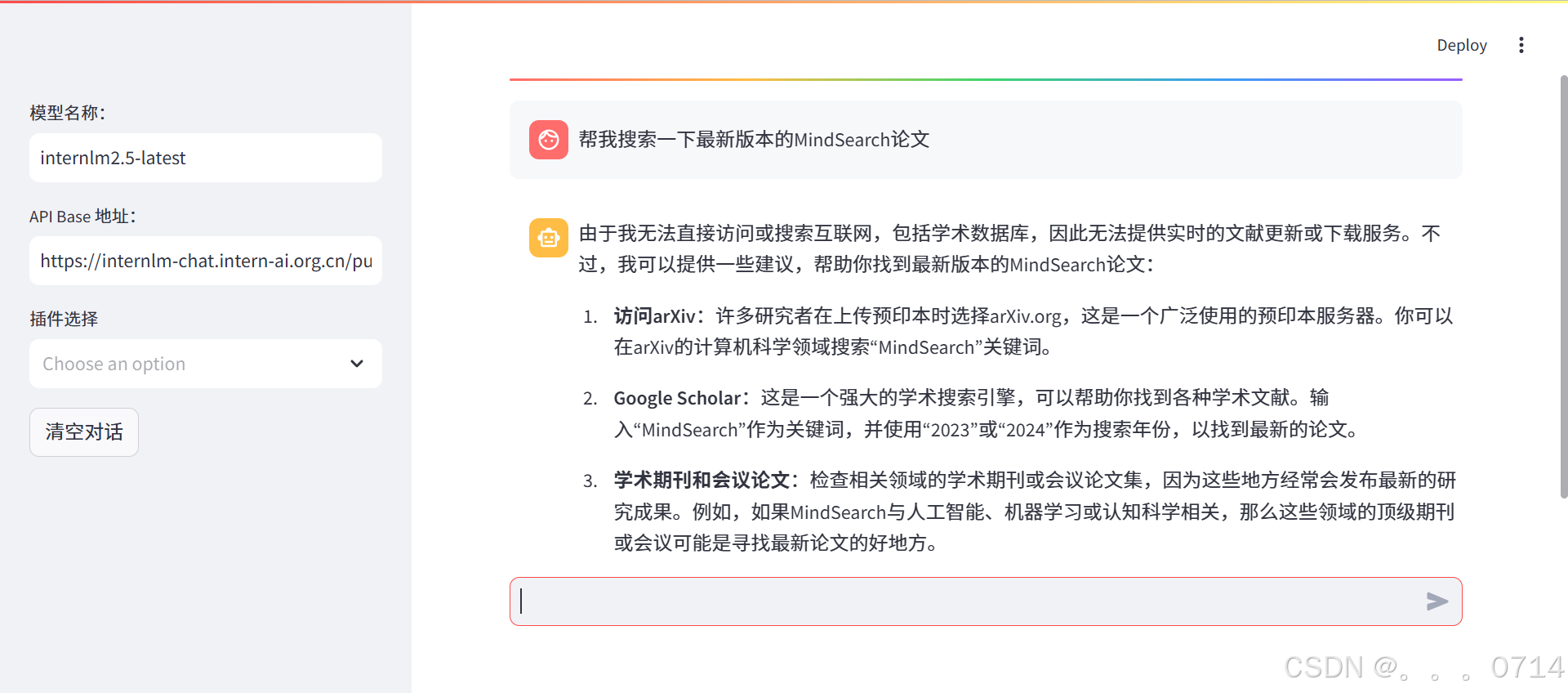

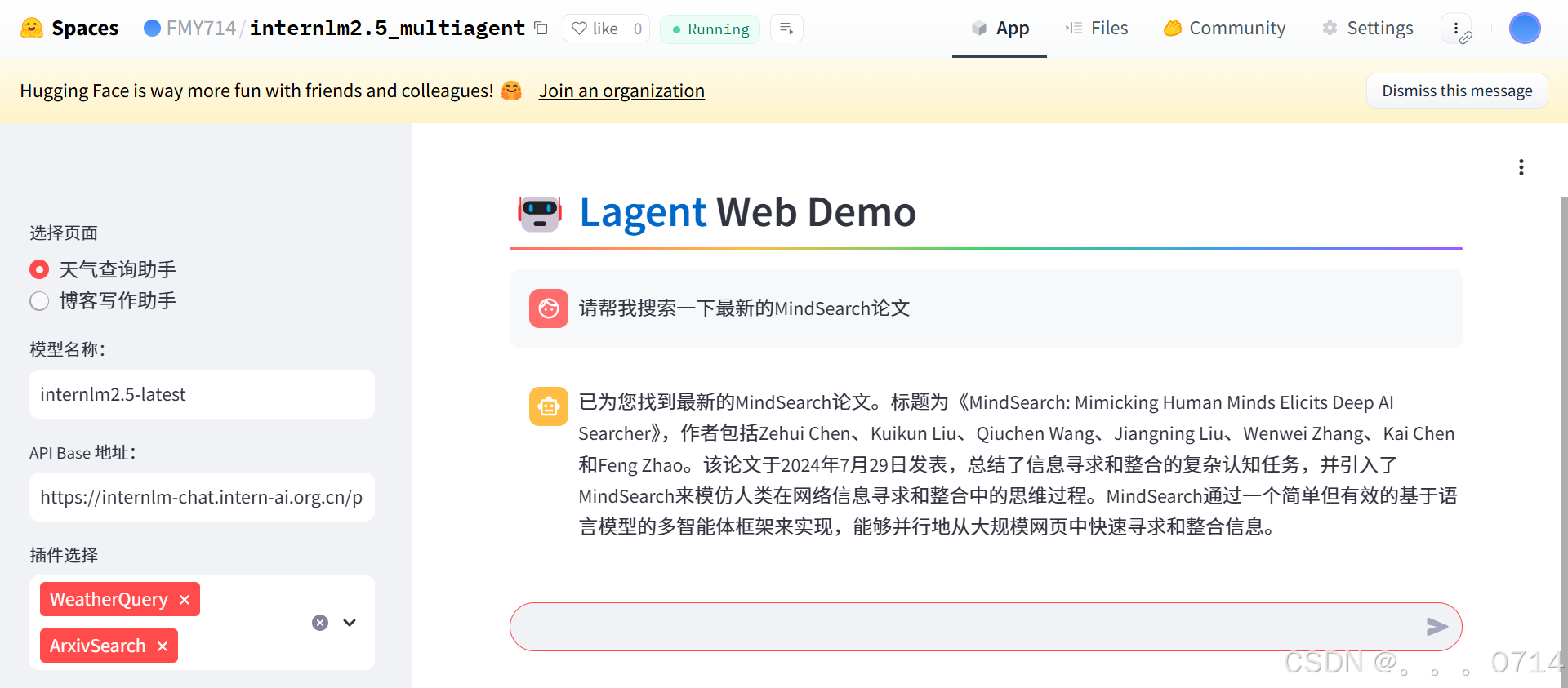

不使用ArxivSearch插件,尝试提问“帮我搜索一下最新版本的MindSearch论文”。

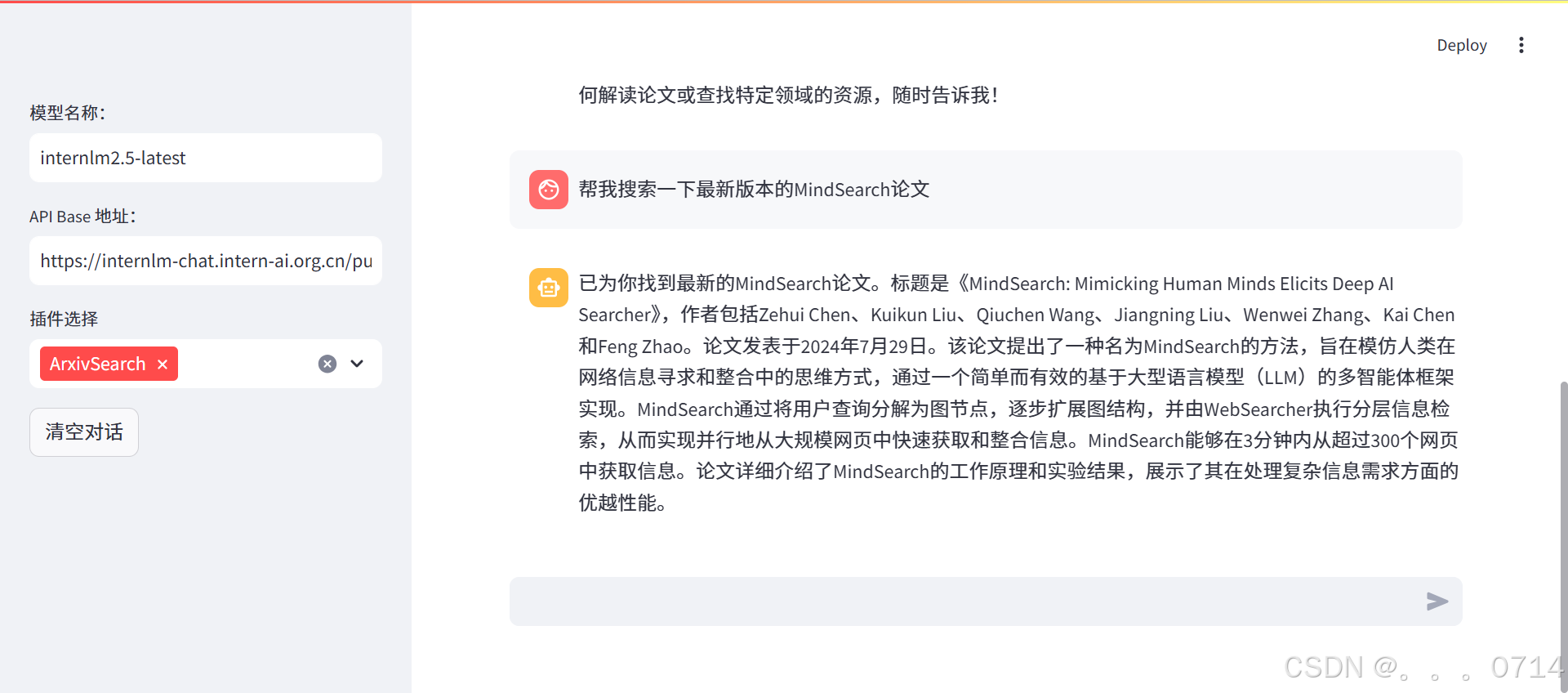

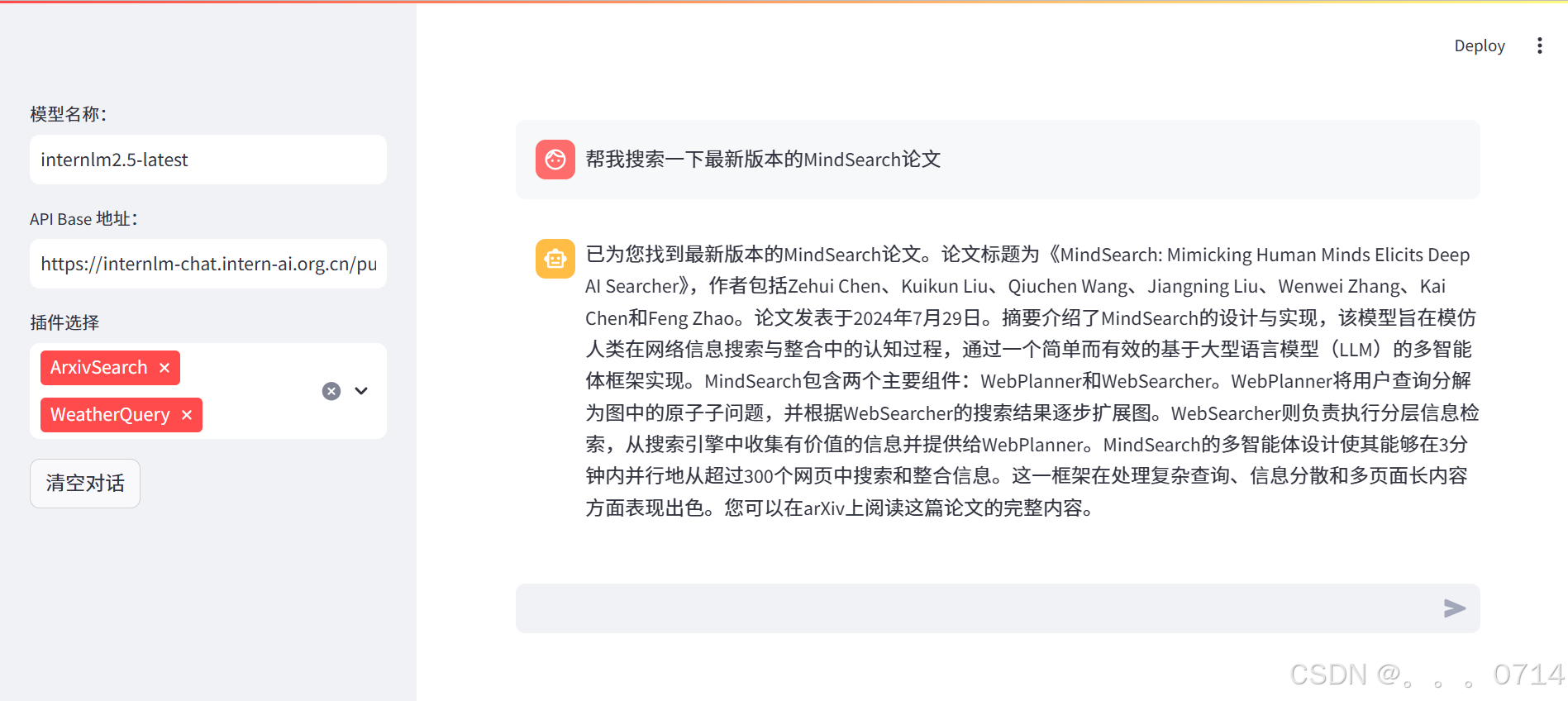

现在将ArxivSearch插件选择上,再次输入指令“帮我搜索一下最新版本的MindSearch论文”,可以看到,通过调用外部工具,大模型成功理解了我们的任务,得到了我们需要的文献。

代码解析

制作天气查询 Agent

获取和风天气服务的API KEY

(1)访问和风天气 API 文档,点击页面右上角的“控制台”,需要注册账号。

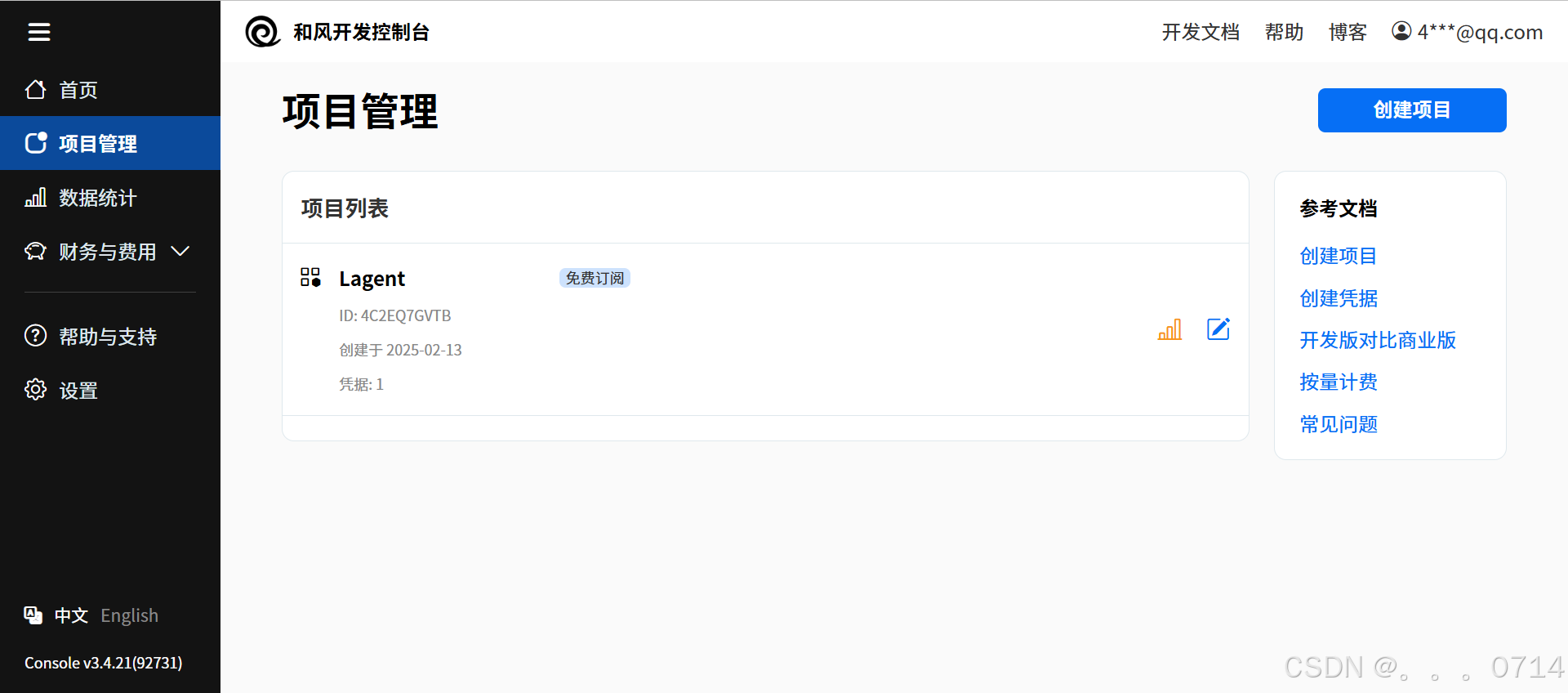

(3)在控制台中,点击左侧的“项目管理”,然后点击右上角“创建项目”。

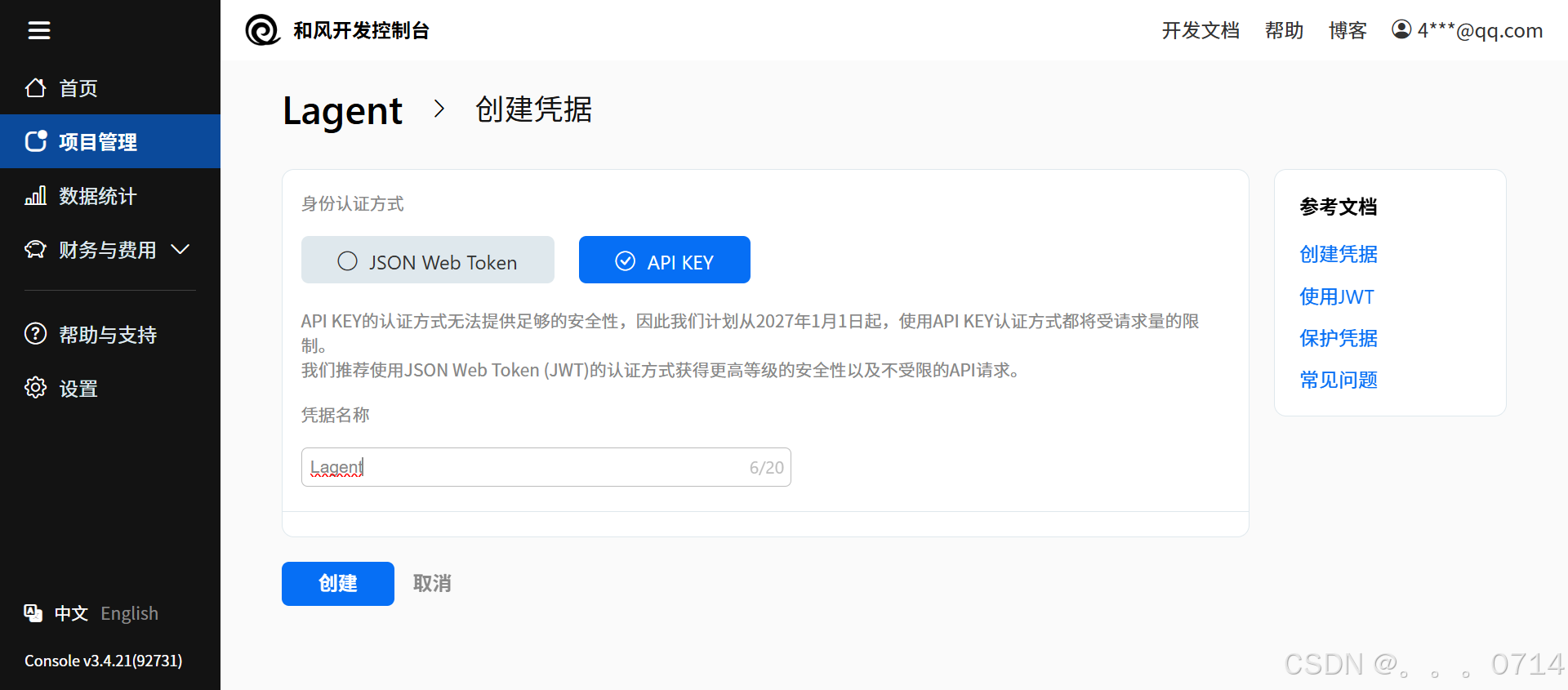

(4)输入项目名称(可以使用“Lagent”),选择免费订阅,并在凭据设置中创建新的凭据。

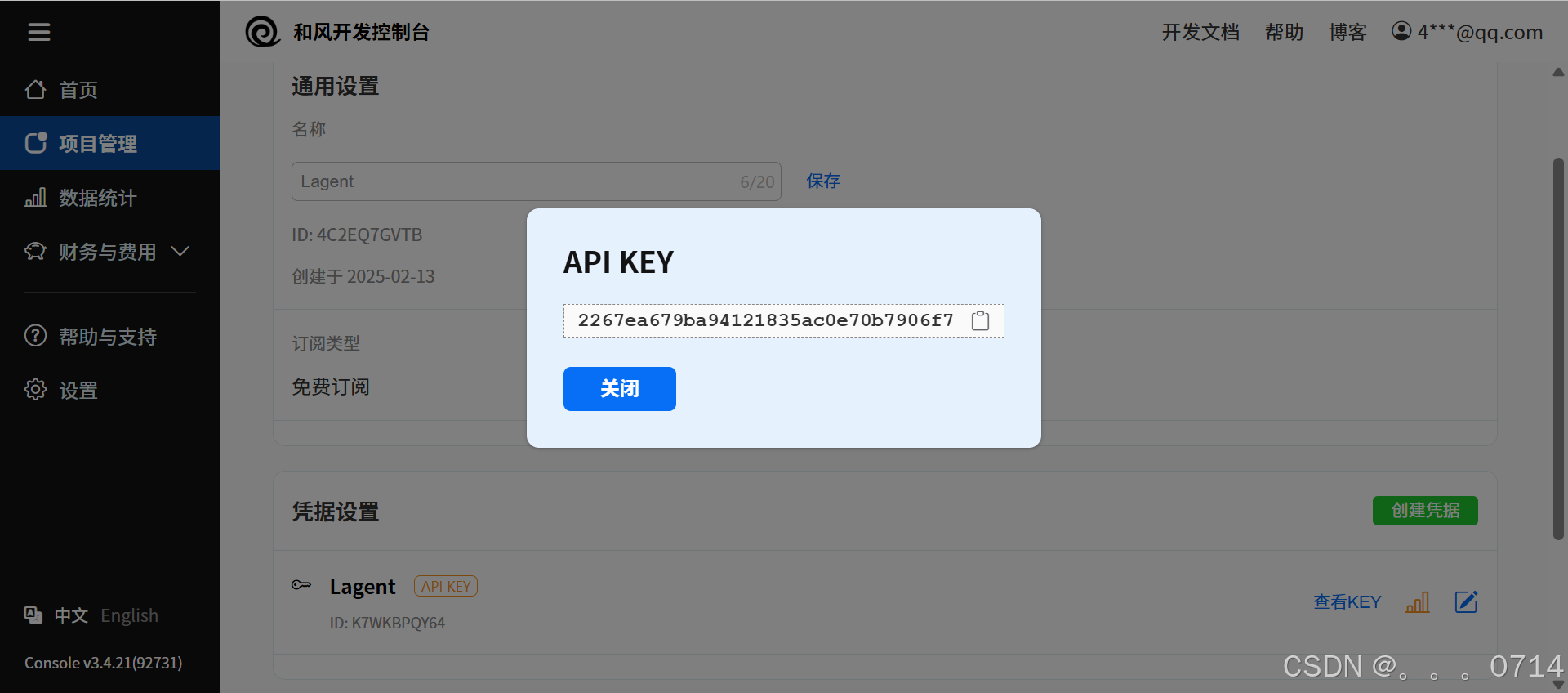

(5)创建凭据时即可复制API KEY。又或者创建后,回到“项目管理”页面,点击刚创建的项目–>查看KEY。

Lagent 自定义 WeatherQuery 工具

使用 Lagent 自定义工具主要分为以下3步:

(1)继承 BaseAction 类

(2)实现简单工具的 run 方法;或者实现工具包内每个子工具的功能

(3)简单工具的 run 方法可选被 tool_api 装饰;工具包内每个子工具的功能都需要被 tool_api 装饰

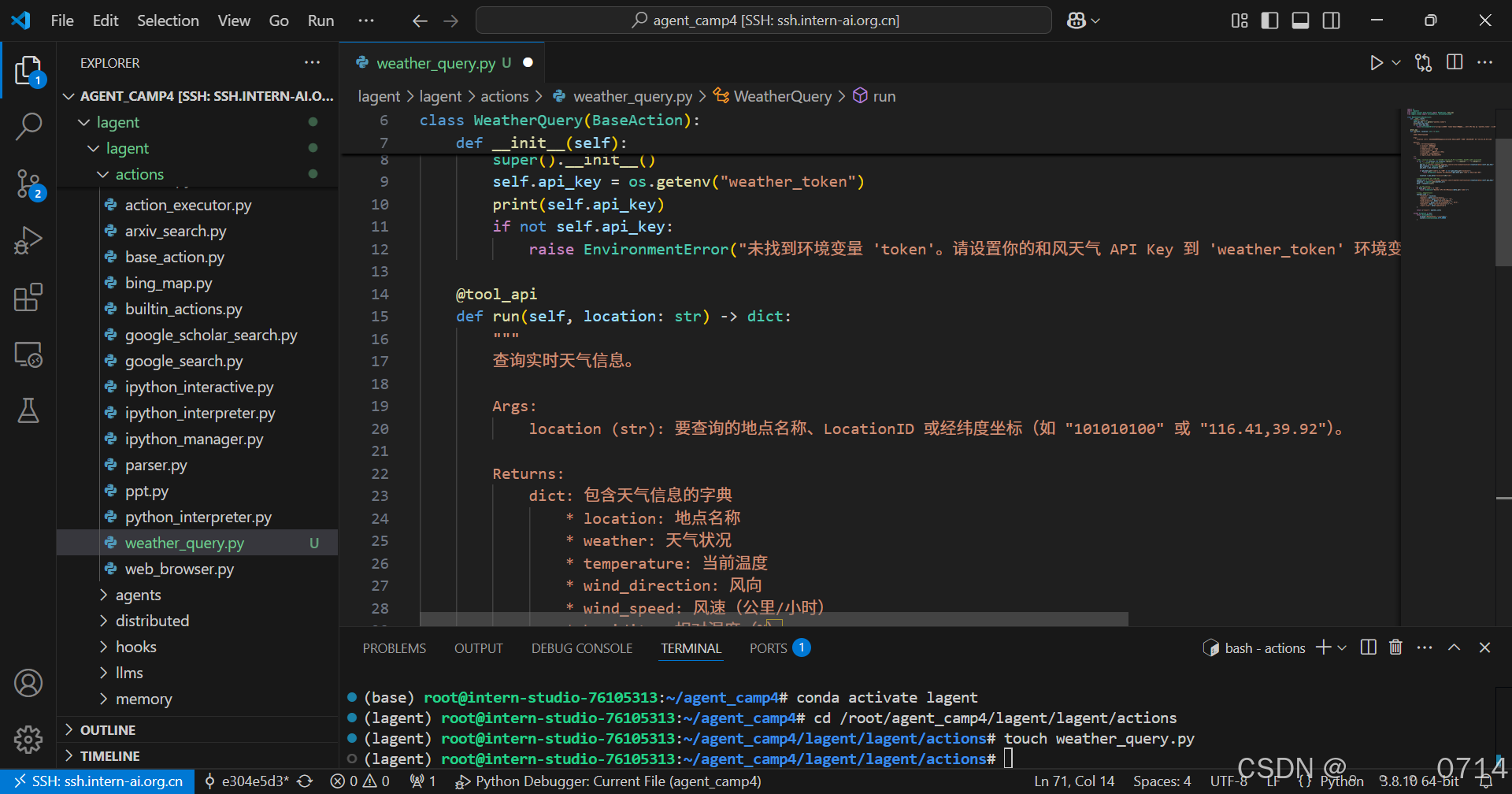

在laegnt/actions文件夹下面创建一个天气查询的工具程序。

conda activate lagent

cd /root/agent_camp4/lagent/lagent/actions

touch weather_query.py

程序代码如下:

import os

import requests

from lagent.actions.base_action import BaseAction, tool_api

from lagent.schema import ActionReturn, ActionStatusCode

class WeatherQuery(BaseAction):

def __init__(self):

super().__init__()

self.api_key = os.getenv("weather_token")

print(self.api_key)

if not self.api_key:

raise EnvironmentError("未找到环境变量 'token'。请设置你的和风天气 API Key 到 'weather_token' 环境变量中,比如export weather_token='xxx' ")

@tool_api

def run(self, location: str) -> dict:

"""

查询实时天气信息。

Args:

location (str): 要查询的地点名称、LocationID 或经纬度坐标(如 "101010100" 或 "116.41,39.92")。

Returns:

dict: 包含天气信息的字典

* location: 地点名称

* weather: 天气状况

* temperature: 当前温度

* wind_direction: 风向

* wind_speed: 风速(公里/小时)

* humidity: 相对湿度(%)

* report_time: 数据报告时间

"""

try:

# 如果 location 不是坐标格式(例如 "116.41,39.92"),则调用 GeoAPI 获取 LocationID

if not ("," in location and location.replace(",", "").replace(".", "").isdigit()):

# 使用 GeoAPI 获取 LocationID

geo_url = f"https://geoapi.qweather.com/v2/city/lookup?location={location}&key={self.api_key}"

geo_response = requests.get(geo_url)

geo_data = geo_response.json()

if geo_data.get("code") != "200" or not geo_data.get("location"):

raise Exception(f"GeoAPI 返回错误码:{geo_data.get('code')} 或未找到位置")

location = geo_data["location"][0]["id"]

# 构建天气查询的 API 请求 URL

weather_url = f"https://devapi.qweather.com/v7/weather/now?location={location}&key={self.api_key}"

response = requests.get(weather_url)

data = response.json()

# 检查 API 响应码

if data.get("code") != "200":

raise Exception(f"Weather API 返回错误码:{data.get('code')}")

# 解析和组织天气信息

weather_info = {

"location": location,

"weather": data["now"]["text"],

"temperature": data["now"]["temp"] + "°C",

"wind_direction": data["now"]["windDir"],

"wind_speed": data["now"]["windSpeed"] + " km/h",

"humidity": data["now"]["humidity"] + "%",

"report_time": data["updateTime"]

}

return {"result": weather_info}

except Exception as exc:

return ActionReturn(

errmsg=f"WeatherQuery 异常:{exc}",

state=ActionStatusCode.HTTP_ERROR

)

WeatherQuery类继承自BaseAction,这是 Lagent 的基础工具类,提供了工具的框架逻辑。tool_api是一个装饰器,用于标记工具中具体执行逻辑的函数,使得 Lagent 智能体能够调用该方法执行任务。run方法是工具的主要逻辑入口,通常会根据输入参数完成一项任务并返回结果。

在具体函数实现上,利用GeoAPI 获取 LocationID,当用户输入的 location 不是经纬度坐标格式(如 116.41,39.92),则使用和风天气的 GeoAPI 将位置名转换为 LocationID,并通过 Weather API 获取目标位置的实时天气数据。最后,解析返回的 JSON 数据,并格式化为结构化字典。

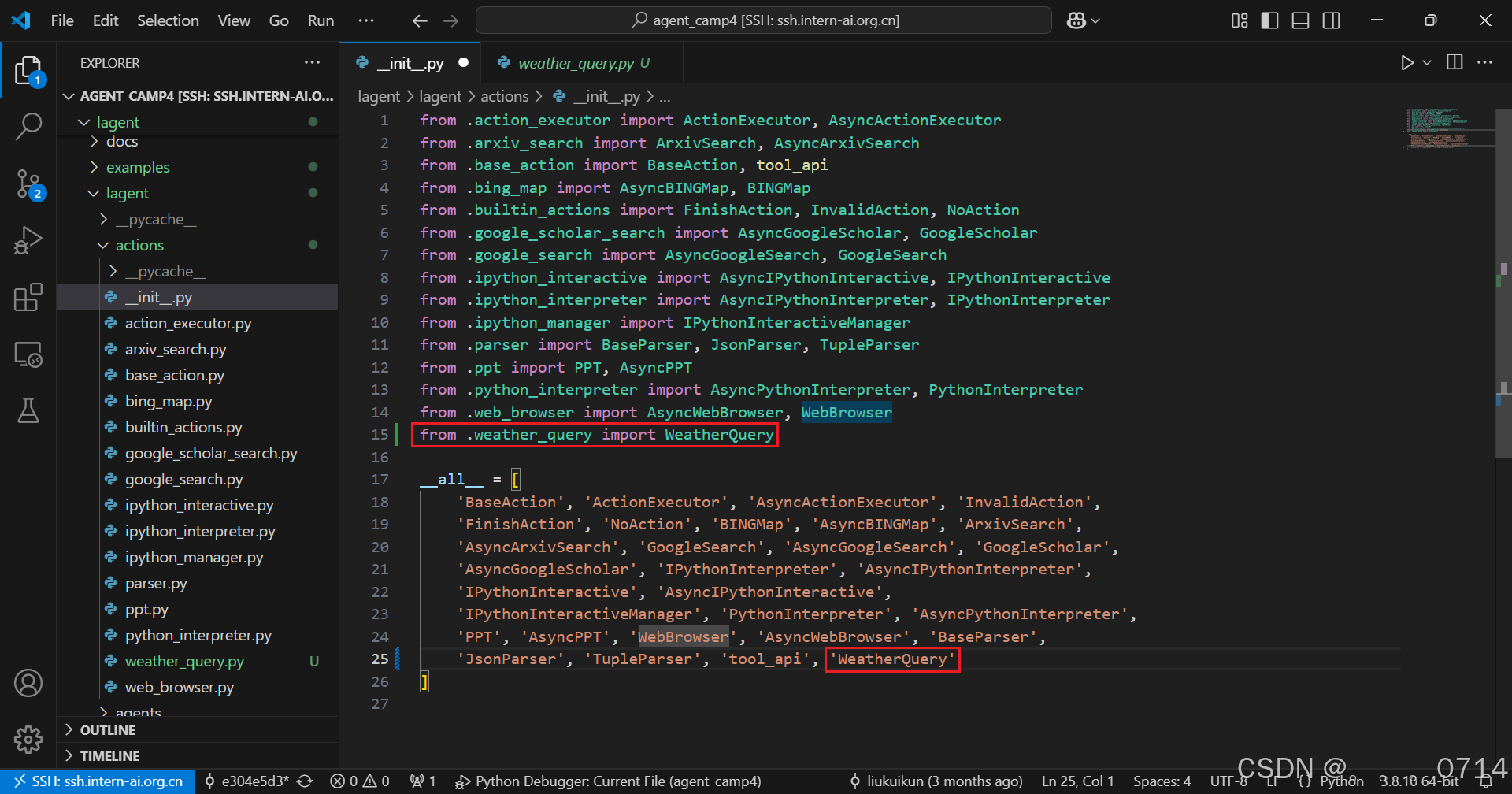

在/root/agent_camp4/lagent/lagent/actions/__init__.py中初始化WeatherQuery方法,主要是导入刚刚创建的WeatherQuery方法,并将工具的名称加入到__all__列表中。

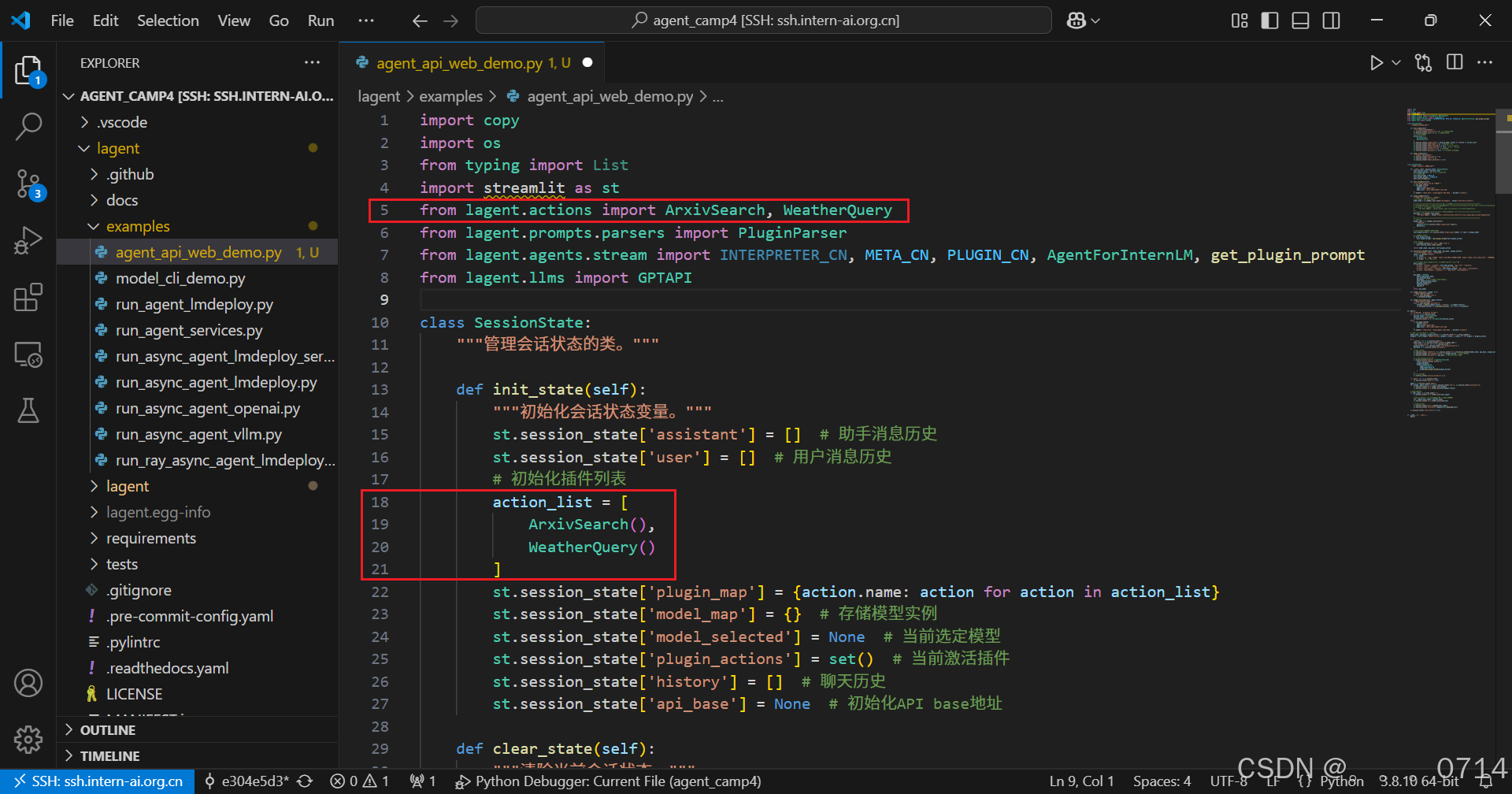

打开agent_api_web_demo.py,将该工具注册进大模型的插件列表中。

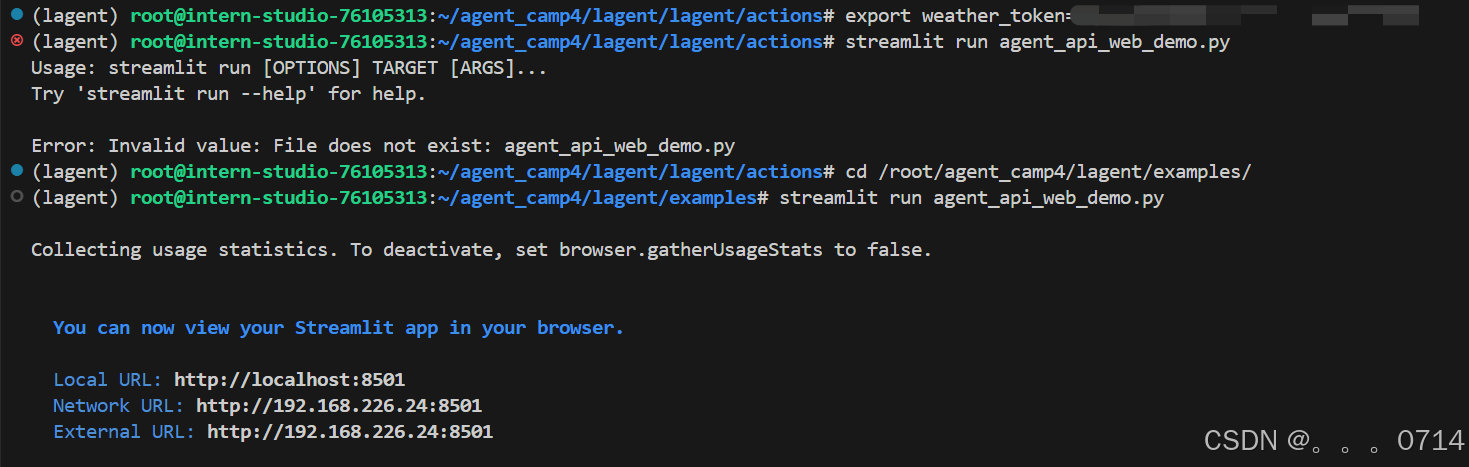

运行streamlit命令,注意要将刚刚申请的API Key在终端中输入进去。

export weather_token='your_token_here'

cd /root/agent_camp4/lagent/examples/

streamlit run agent_api_web_demo.py

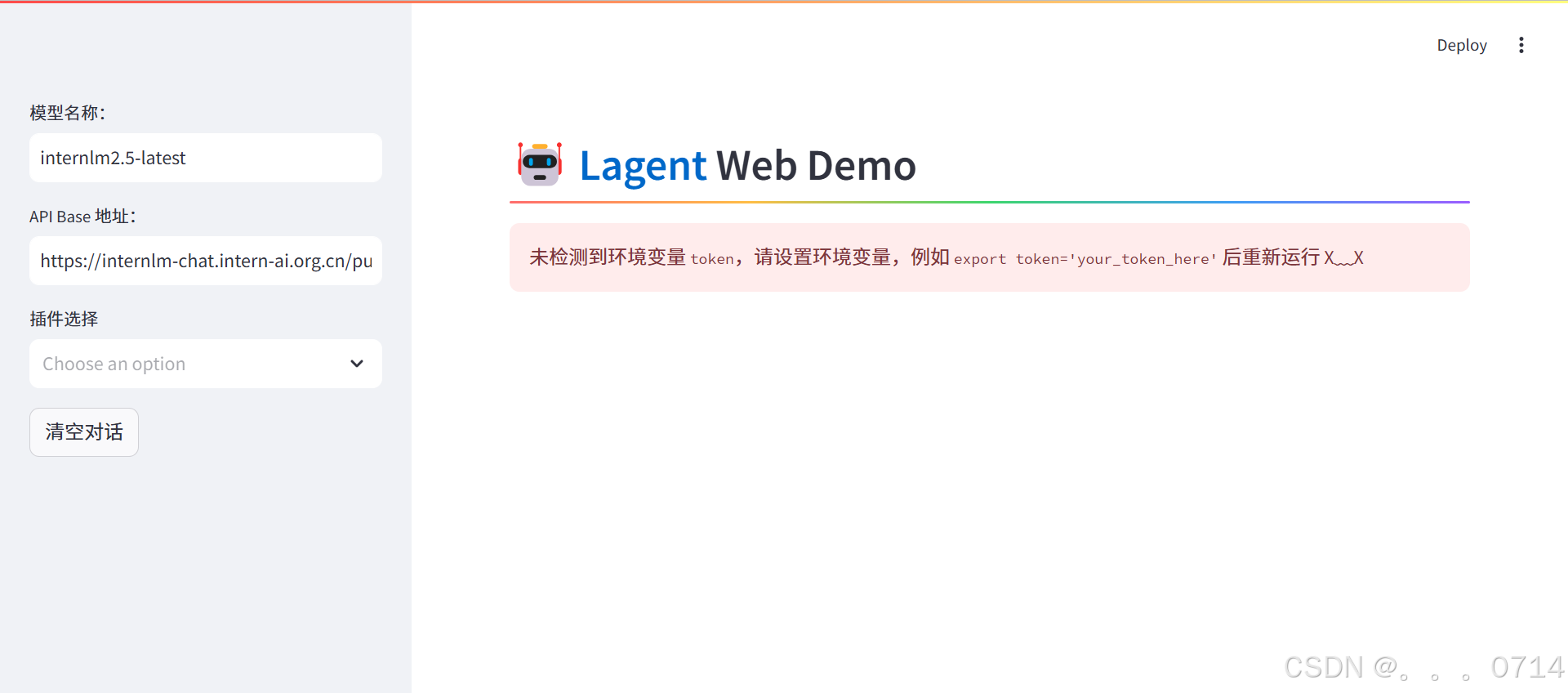

页面提示未检测到环境变量token,命令行重新设置后再次运行。

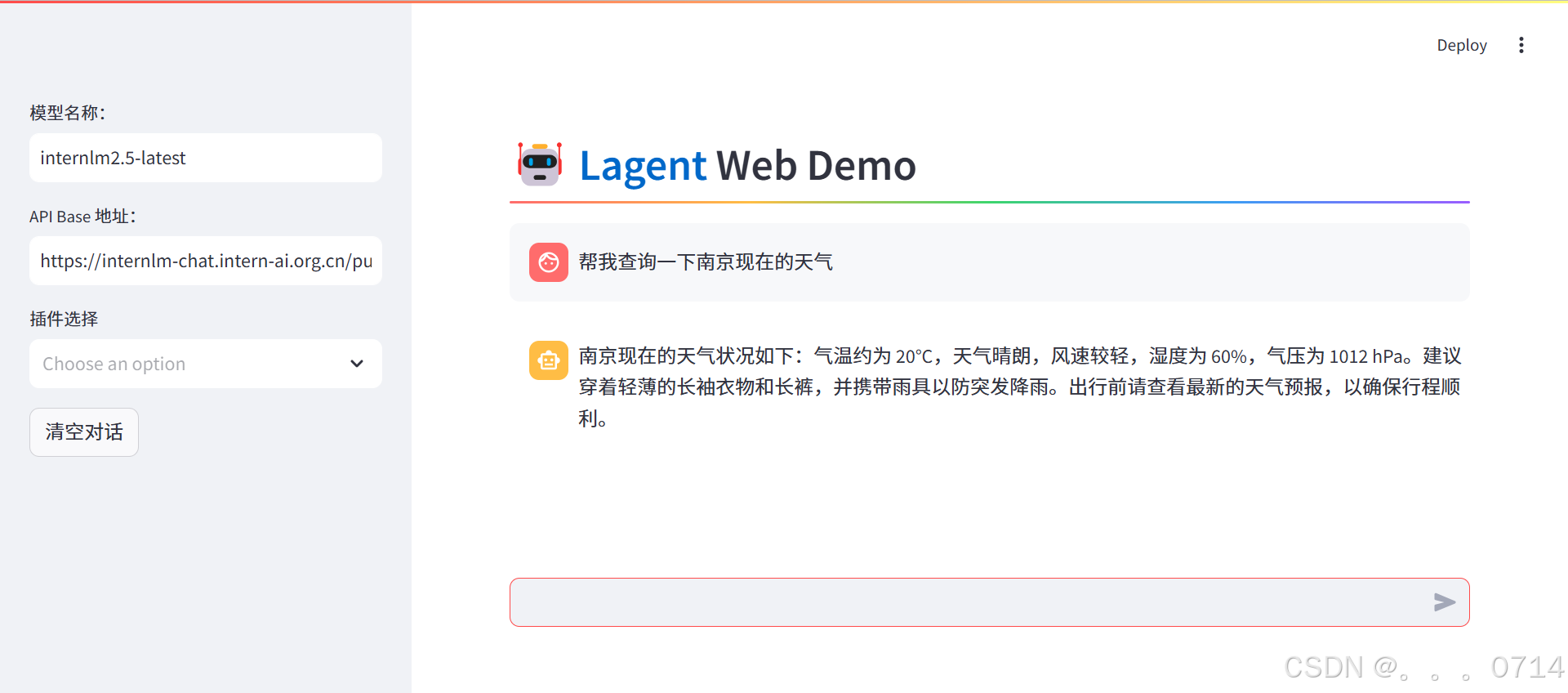

不适用天气查询工具,输入“帮我查询一下南京现在的天气”进行测试。

可以看到,模型虽然有输出,但输出内容与实际不符。

这次同时选中两个工具,验证模型对于不同工具的识别与调用能力。

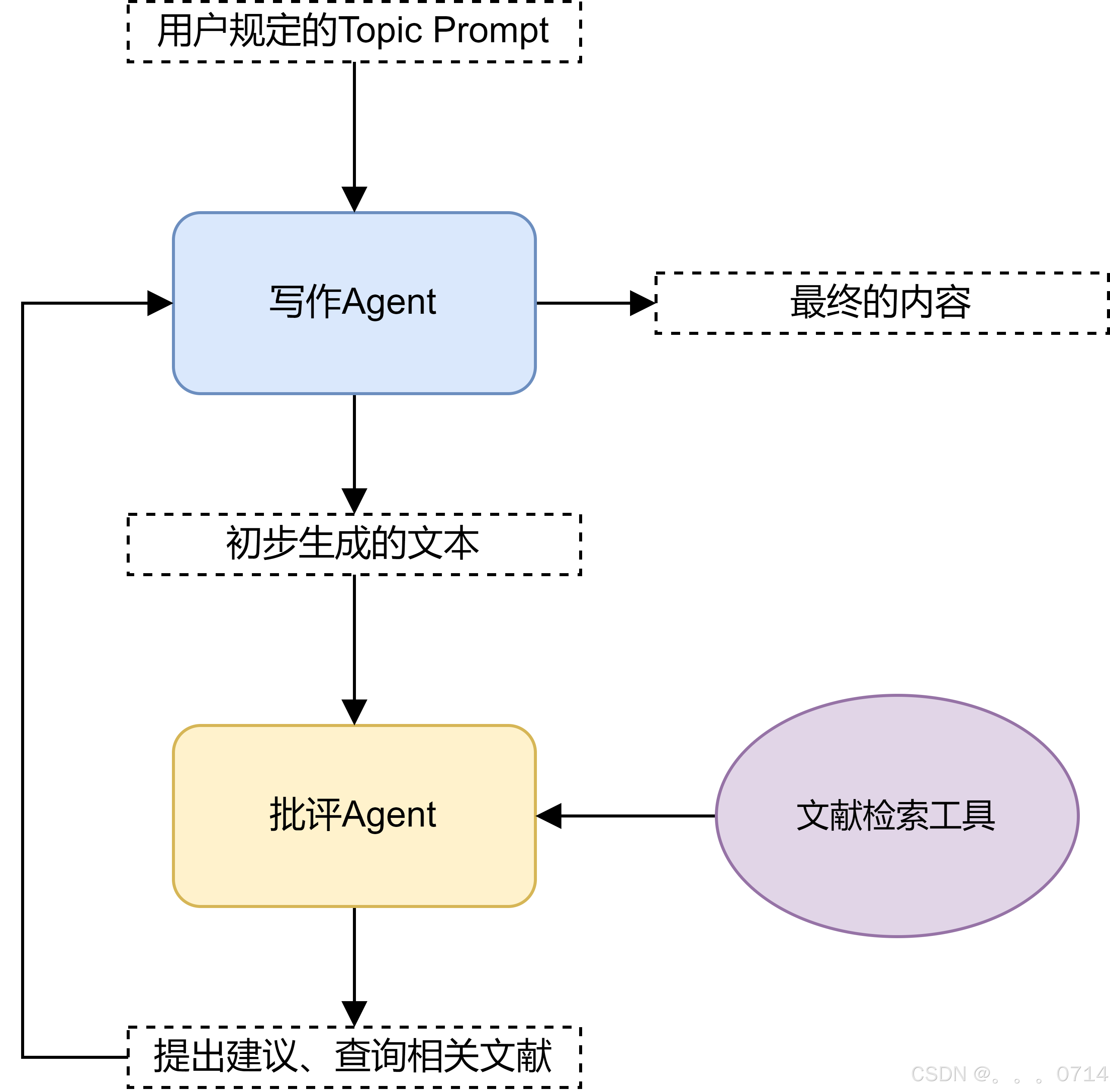

Multi-Agents 博客写作系统的搭建

系统流程设计

使用 Lagent 来构建一个多智能体系统 (Multi-Agent System),展示如何协调不同的智能代理完成内容生成和优化的任务。多智能体系统由两个主要代理组成:

(1)内容生成代理:负责根据用户的主题提示生成一篇结构化、专业的文章或报告。

(2)批评优化代理:负责审阅生成的内容,指出不足,推荐合适的文献,使文章更加完善。

代码实现

创建新的 web demo 文件multi_agents_api_web_demo.py。

cd /root/agent_camp4/lagent/examples

touch multi_agents_api_web_demo.py

文件内容如下:

import os

import asyncio

import json

import re

import requests

import streamlit as st

from lagent.agents import Agent

from lagent.prompts.parsers import PluginParser

from lagent.agents.stream import PLUGIN_CN, get_plugin_prompt

from lagent.schema import AgentMessage

from lagent.actions import ArxivSearch

from lagent.hooks import Hook

from lagent.llms import GPTAPI

YOUR_TOKEN_HERE = os.getenv("token")

if not YOUR_TOKEN_HERE:

raise EnvironmentError("未找到环境变量 'token',请设置后再运行程序。")

# Hook类,用于对消息添加前缀

class PrefixedMessageHook(Hook):

def __init__(self, prefix, senders=None):

"""

初始化Hook

:param prefix: 消息前缀

:param senders: 指定发送者列表

"""

self.prefix = prefix

self.senders = senders or []

def before_agent(self, agent, messages, session_id):

"""

在代理处理消息前修改消息内容

:param agent: 当前代理

:param messages: 消息列表

:param session_id: 会话ID

"""

for message in messages:

if message.sender in self.senders:

message.content = self.prefix + message.content

class AsyncBlogger:

"""博客生成类,整合写作者和批评者。"""

def __init__(self, model_type, api_base, writer_prompt, critic_prompt, critic_prefix='', max_turn=2):

"""

初始化博客生成器

:param model_type: 模型类型

:param api_base: API 基地址

:param writer_prompt: 写作者提示词

:param critic_prompt: 批评者提示词

:param critic_prefix: 批评消息前缀

:param max_turn: 最大轮次

"""

self.model_type = model_type

self.api_base = api_base

self.llm = GPTAPI(

model_type=model_type,

api_base=api_base,

key=YOUR_TOKEN_HERE,

max_new_tokens=4096,

)

self.plugins = [dict(type='lagent.actions.ArxivSearch')]

self.writer = Agent(

self.llm,

writer_prompt,

name='写作者',

output_format=dict(

type=PluginParser,

template=PLUGIN_CN,

prompt=get_plugin_prompt(self.plugins)

)

)

self.critic = Agent(

self.llm,

critic_prompt,

name='批评者',

hooks=[PrefixedMessageHook(critic_prefix, ['写作者'])]

)

self.max_turn = max_turn

async def forward(self, message: AgentMessage, update_placeholder):

"""

执行多阶段博客生成流程

:param message: 初始消息

:param update_placeholder: Streamlit占位符

:return: 最终优化的博客内容

"""

step1_placeholder = update_placeholder.container()

step2_placeholder = update_placeholder.container()

step3_placeholder = update_placeholder.container()

# 第一步:生成初始内容

step1_placeholder.markdown("**Step 1: 生成初始内容...**")

message = self.writer(message)

if message.content:

step1_placeholder.markdown(f"**生成的初始内容**:\n\n{message.content}")

else:

step1_placeholder.markdown("**生成的初始内容为空,请检查生成逻辑。**")

# 第二步:批评者提供反馈

step2_placeholder.markdown("**Step 2: 批评者正在提供反馈和文献推荐...**")

message = self.critic(message)

if message.content:

# 解析批评者反馈

suggestions = re.search(r"1\. 批评建议:\n(.*?)2\. 推荐的关键词:", message.content, re.S)

keywords = re.search(r"2\. 推荐的关键词:\n- (.*)", message.content)

feedback = suggestions.group(1).strip() if suggestions else "未提供批评建议"

keywords = keywords.group(1).strip() if keywords else "未提供关键词"

# Arxiv 文献查询

arxiv_search = ArxivSearch()

arxiv_results = arxiv_search.get_arxiv_article_information(keywords)

# 显示批评内容和文献推荐

message.content = f"**批评建议**:\n{feedback}\n\n**推荐的文献**:\n{arxiv_results}"

step2_placeholder.markdown(f"**批评和文献推荐**:\n\n{message.content}")

else:

step2_placeholder.markdown("**批评内容为空,请检查批评逻辑。**")

# 第三步:写作者根据反馈优化内容

step3_placeholder.markdown("**Step 3: 根据反馈改进内容...**")

improvement_prompt = AgentMessage(

sender="critic",

content=(

f"根据以下批评建议和推荐文献对内容进行改进:\n\n"

f"批评建议:\n{feedback}\n\n"

f"推荐文献:\n{arxiv_results}\n\n"

f"请优化初始内容,使其更加清晰、丰富,并符合专业水准。"

),

)

message = self.writer(improvement_prompt)

if message.content:

step3_placeholder.markdown(f"**最终优化的博客内容**:\n\n{message.content}")

else:

step3_placeholder.markdown("**最终优化的博客内容为空,请检查生成逻辑。**")

return message

def setup_sidebar():

"""设置侧边栏,选择模型。"""

model_name = st.sidebar.text_input('模型名称:', value='internlm2.5-latest')

api_base = st.sidebar.text_input(

'API Base 地址:', value='https://internlm-chat.intern-ai.org.cn/puyu/api/v1/chat/completions'

)

return model_name, api_base

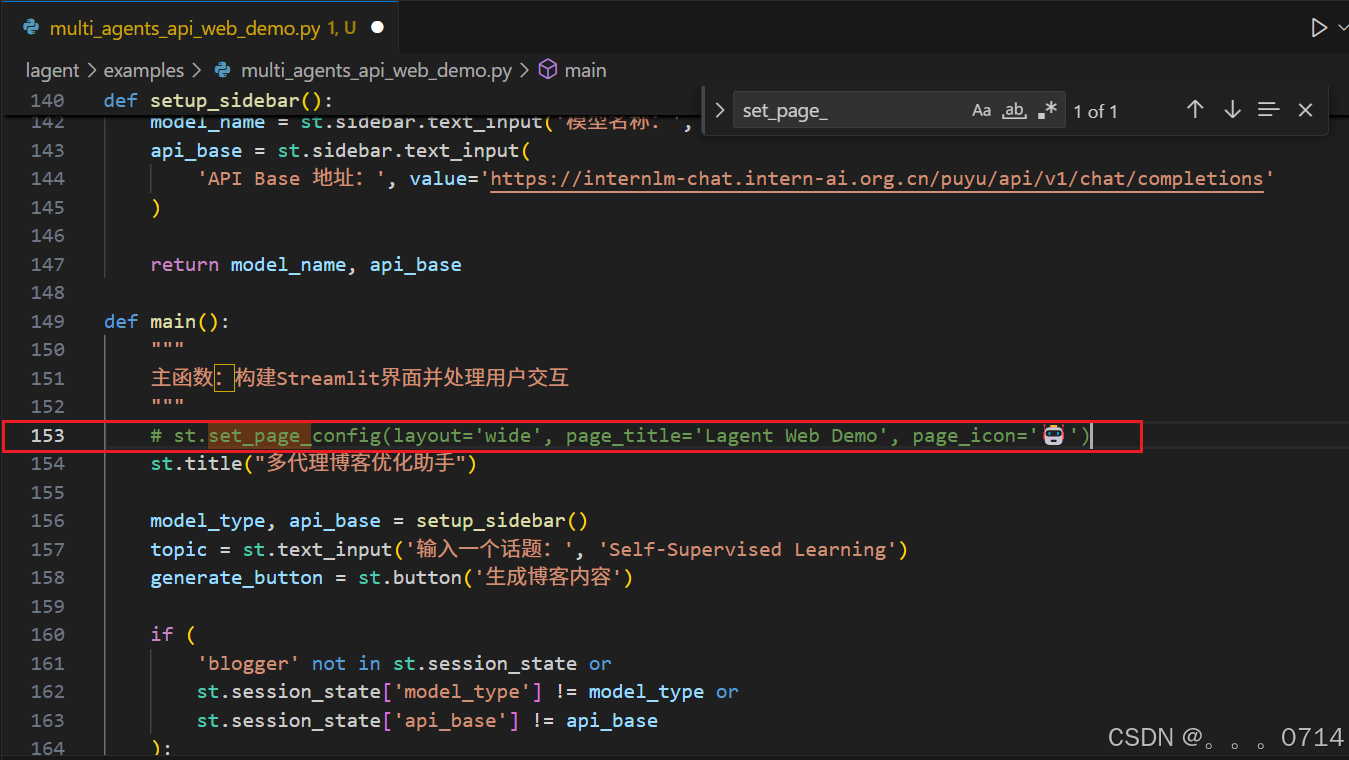

def main():

"""

主函数:构建Streamlit界面并处理用户交互

"""

st.set_page_config(layout='wide', page_title='Lagent Web Demo', page_icon='🤖')

st.title("多代理博客优化助手")

model_type, api_base = setup_sidebar()

topic = st.text_input('输入一个话题:', 'Self-Supervised Learning')

generate_button = st.button('生成博客内容')

if (

'blogger' not in st.session_state or

st.session_state['model_type'] != model_type or

st.session_state['api_base'] != api_base

):

st.session_state['blogger'] = AsyncBlogger(

model_type=model_type,

api_base=api_base,

writer_prompt="你是一位优秀的AI内容写作者,请撰写一篇有吸引力且信息丰富的博客内容。",

critic_prompt="""

作为一位严谨的批评者,请给出建设性的批评和改进建议,并基于相关主题使用已有的工具推荐一些参考文献,推荐的关键词应该是英语形式,简洁且切题。

请按照以下格式提供反馈:

1. 批评建议:

- (具体建议)

2. 推荐的关键词:

- (关键词1, 关键词2, ...)

""",

critic_prefix="请批评以下内容,并提供改进建议:\n\n"

)

st.session_state['model_type'] = model_type

st.session_state['api_base'] = api_base

if generate_button:

update_placeholder = st.empty()

async def run_async_blogger():

message = AgentMessage(

sender='user',

content=f"请撰写一篇关于{topic}的博客文章,要求表达专业,生动有趣,并且易于理解。"

)

result = await st.session_state['blogger'].forward(message, update_placeholder)

return result

loop = asyncio.new_event_loop()

asyncio.set_event_loop(loop)

loop.run_until_complete(run_async_blogger())

if __name__ == '__main__':

main()

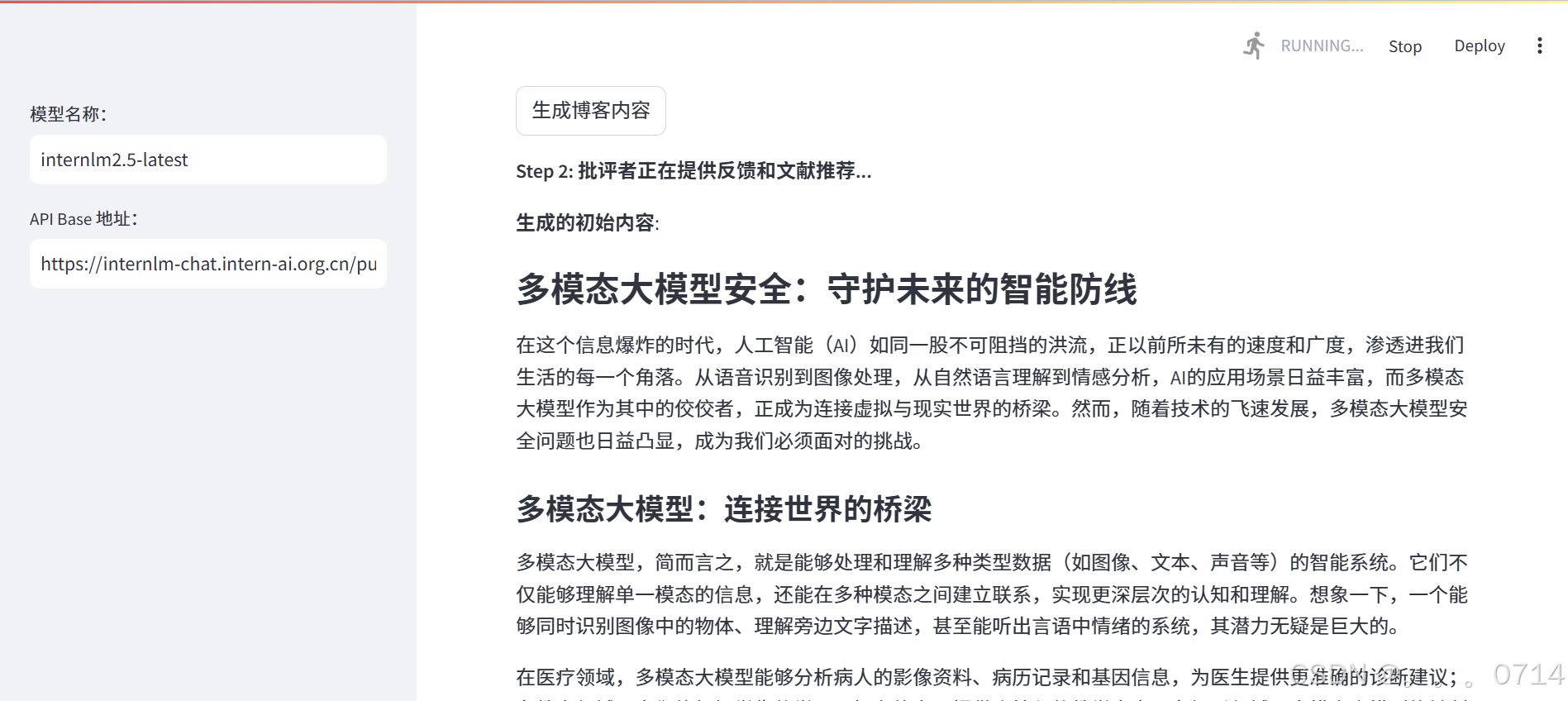

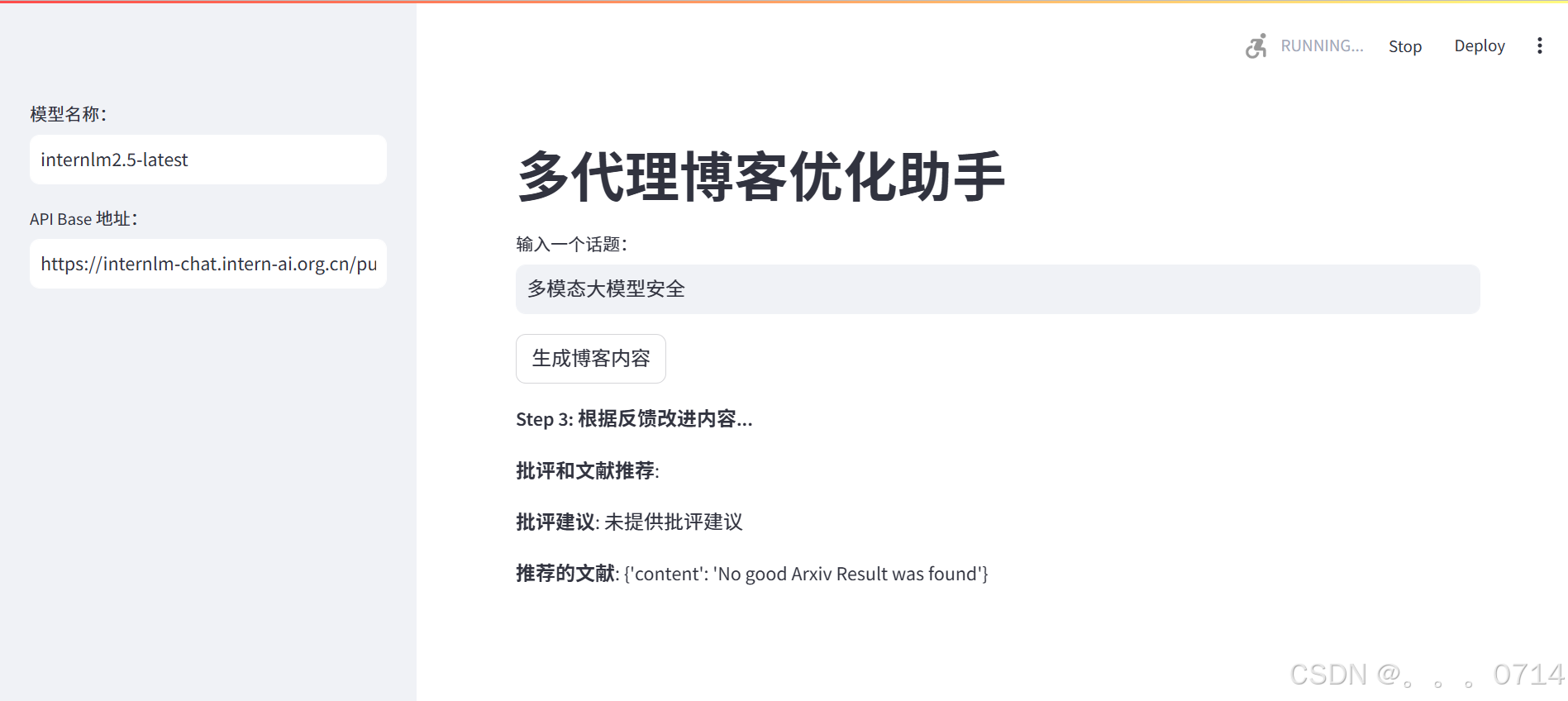

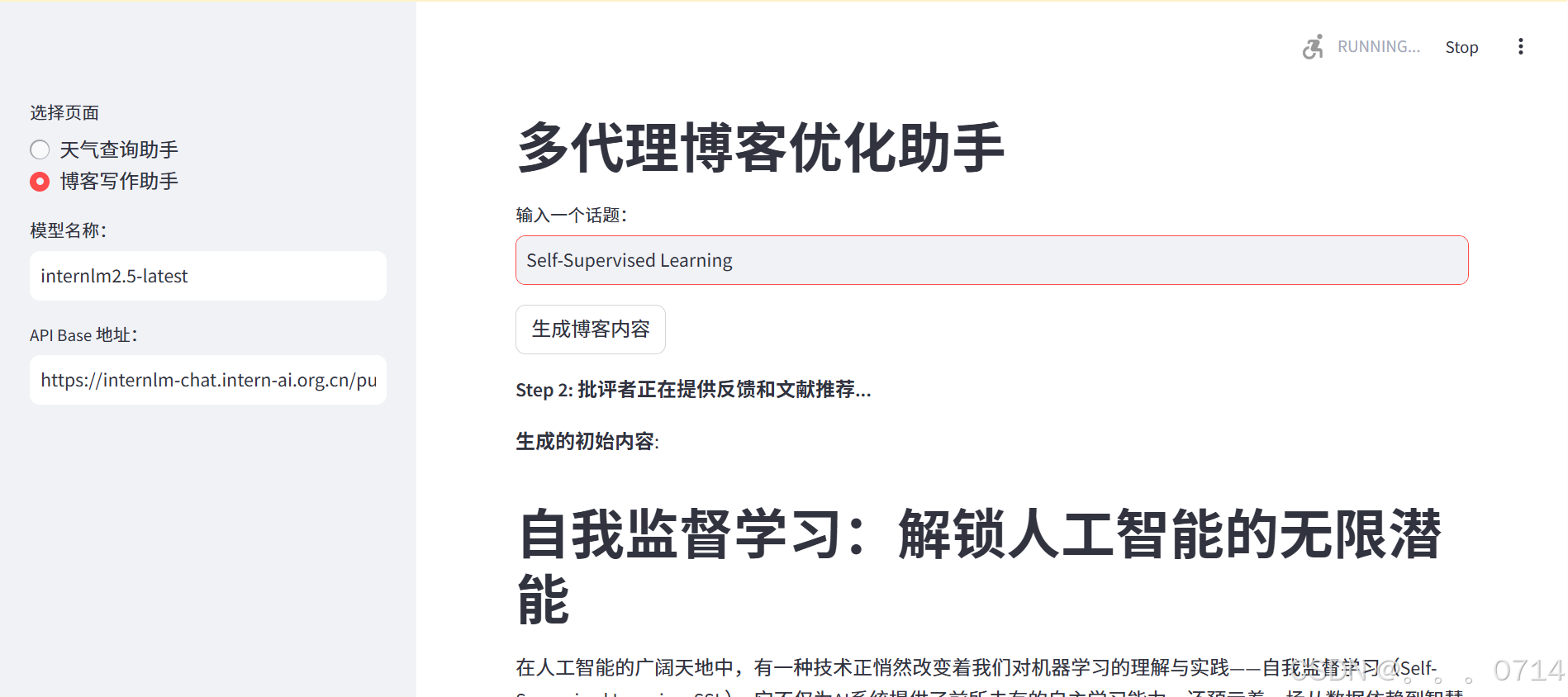

运行命令启动Web服务,并输入话题。

streamlit run multi_agents_api_web_demo.py

可以看到,Multi-Agents博客写作系统正在按照下面的3步骤,生成、批评和完善内容。

-

Step 1:写作者根据用户输入生成初稿。

-

Step 2:批评者对初稿进行评估,提供改进建议和文献推荐(通过关键词触发 Arxiv 文献搜索)。

-

Step 3:写作者根据批评意见对内容进行改进。

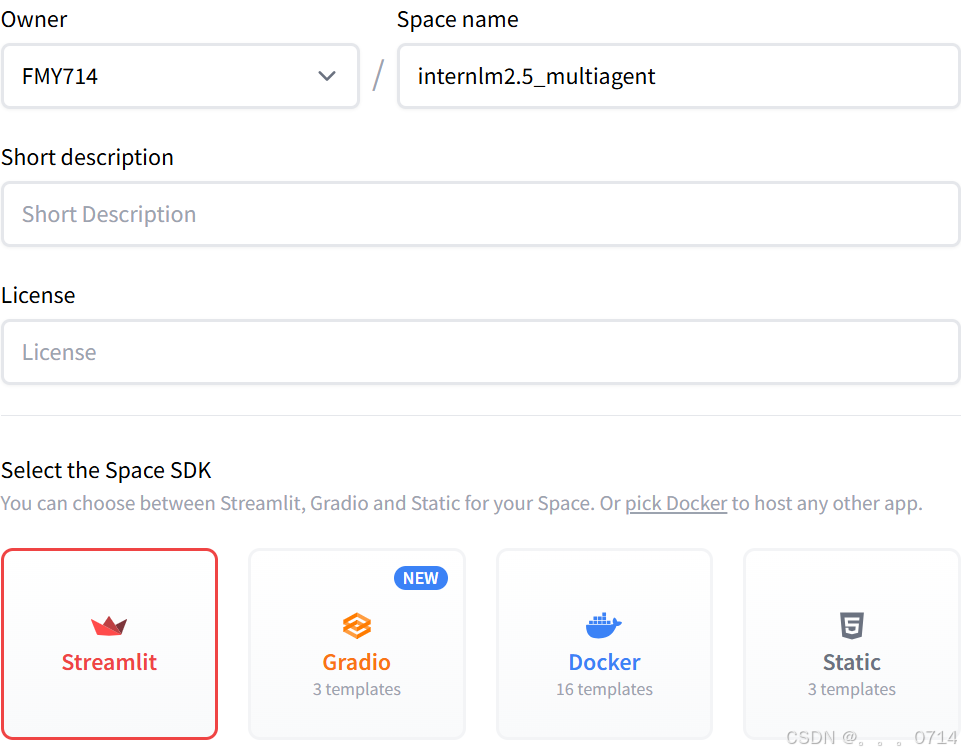

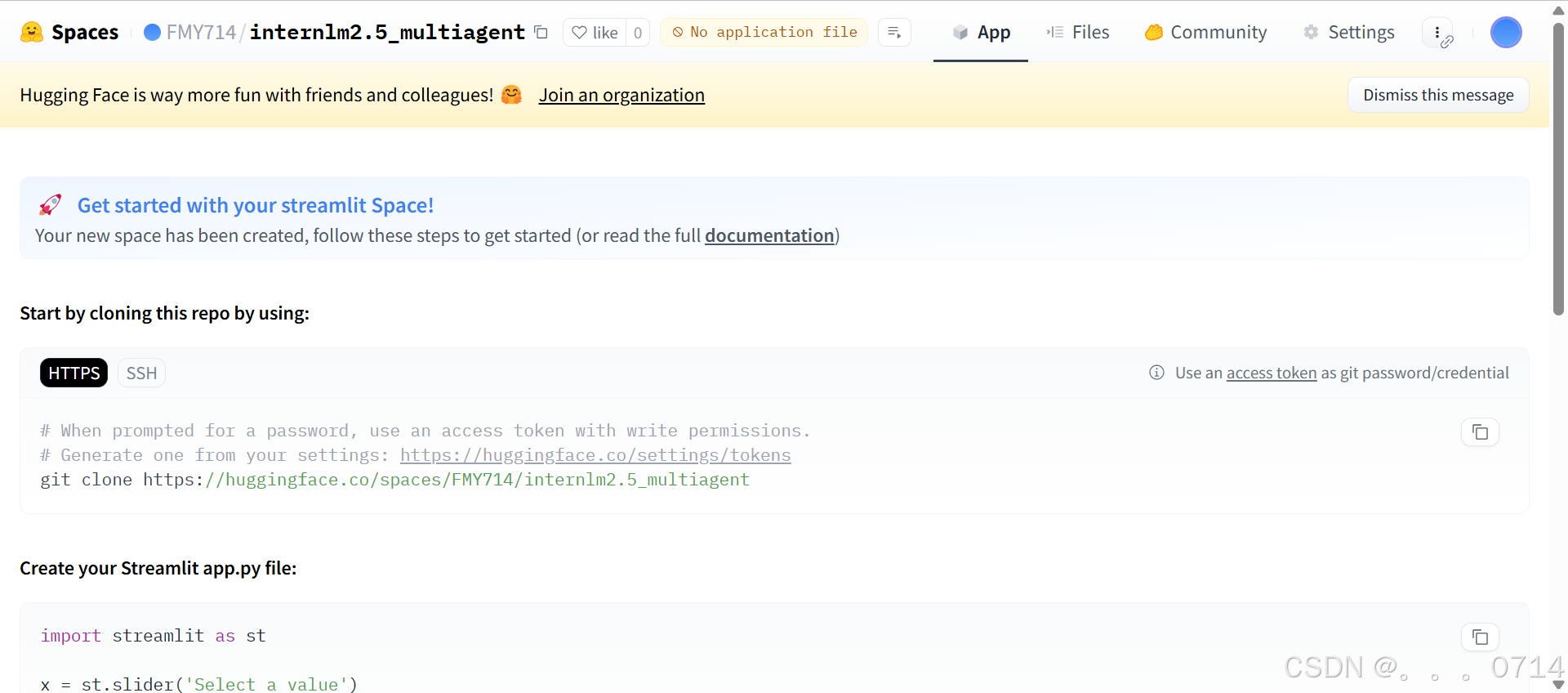

HF Spaces 部署 Multi-Agent 应用

创建 HF Spaces。

准备需要上传的文件,包括 Web UI 页面multi_agents_api_web_demo.py、agent_api_web_demo.py和依赖文件requirements.txt。

修改 /root/agent_camp4/lagent/requirements.txt ,在其中添加如下 python 包。

torch==2.1.2

torchvision==0.16.2

torchaudio==2.1.2

termcolor==2.4.0

streamlit==1.39.0

class_registry==2.1.2

datasets==3.1.0

# -r requirements/optional.txt

google-search-results

lmdeploy>=0.2.5

pillow

python-pptx

timeout_decorator

torch

transformers>=4.34,<=4.40

vllm>=0.3.3

# -r requirements/runtime.txt

aiohttp

arxiv

asyncache

asyncer

distro

duckduckgo_search==5.3.1b1

filelock

func_timeout

griffe<1.0

json5

jsonschema

jupyter==1.0.0

jupyter_client==8.6.2

jupyter_core==5.7.2

pydantic==2.6.4

requests

termcolor

tiktoken

timeout-decorator

typing-extensions

griffe==0.48.0

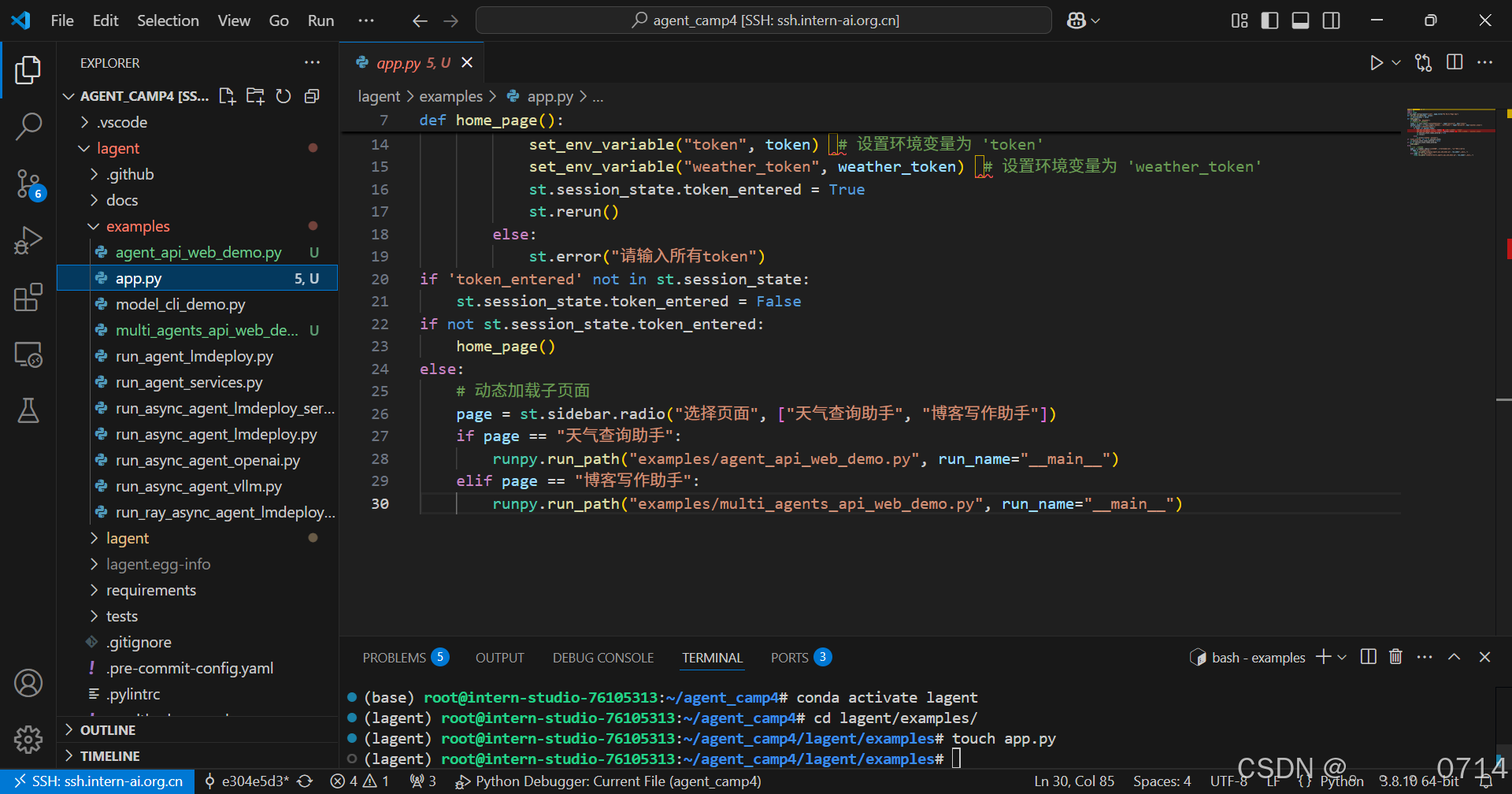

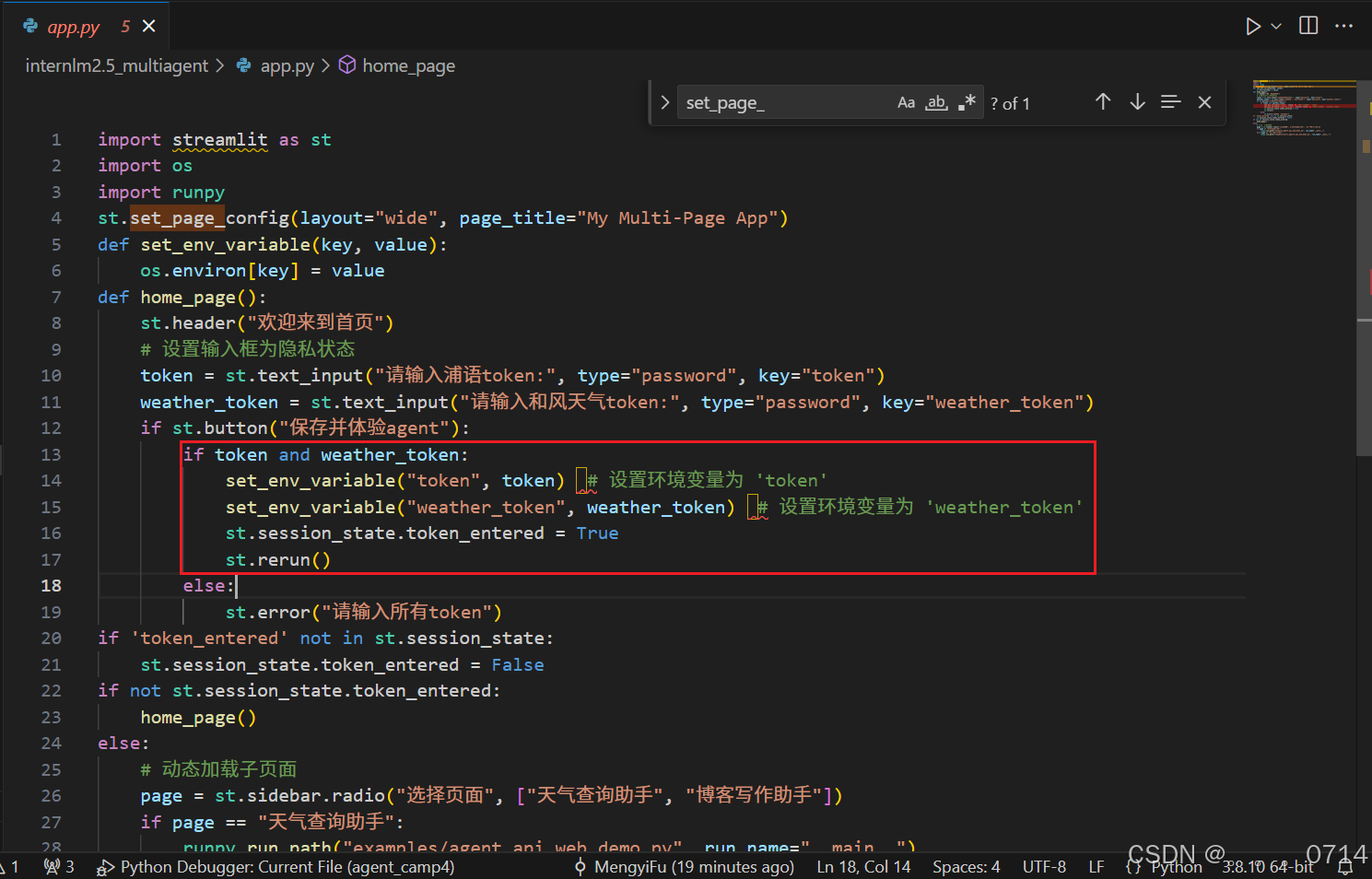

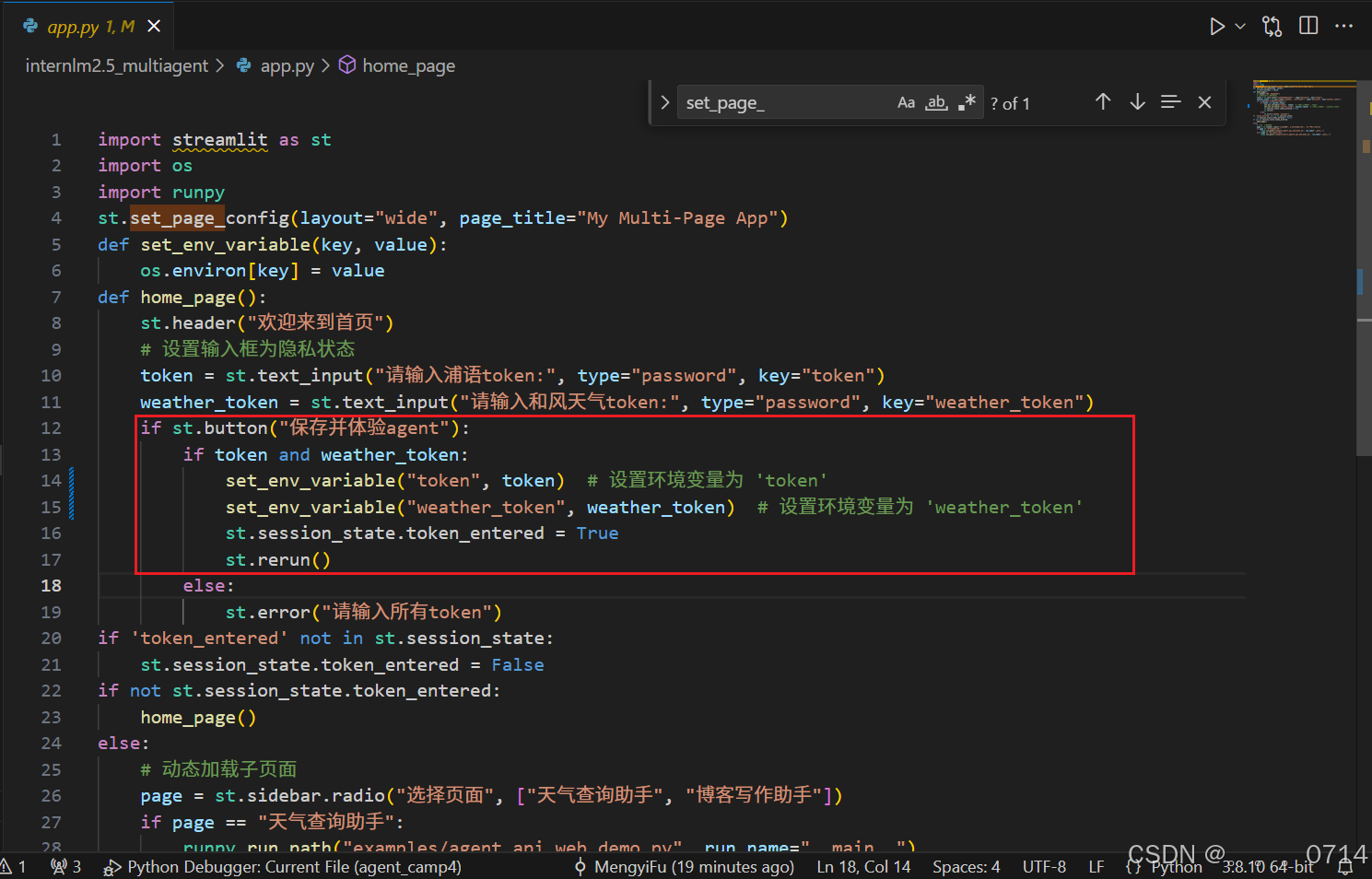

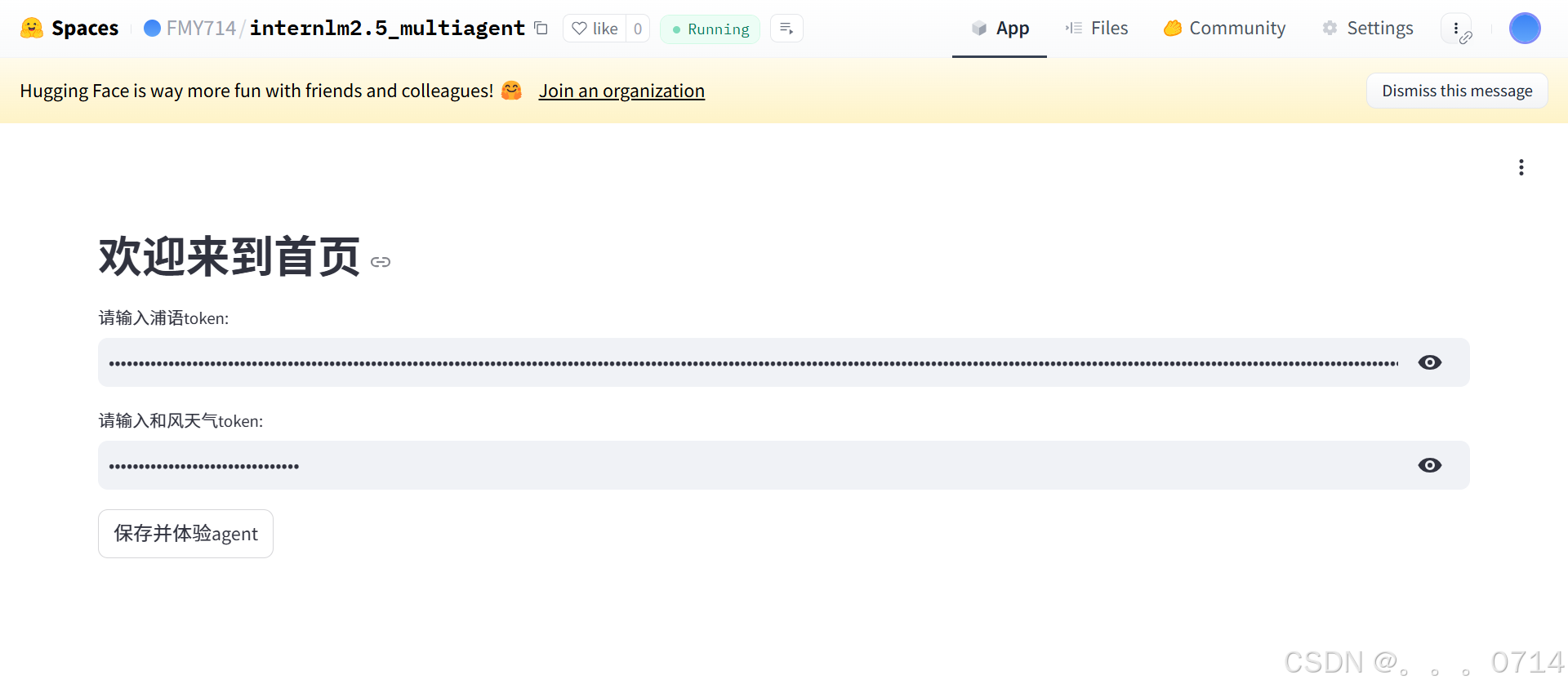

在 agent_camp4/lagent 文件夹下新创建一个 app.py 的入口文件当作 HomePage,编写一个多页面的 streamlit 首页实现对天气查询小助手和博客写作小助手两个 agent 的导航,代码如下:

import streamlit as st

import os

import runpy

st.set_page_config(layout="wide", page_title="My Multi-Page App")

def set_env_variable(key, value):

os.environ[key] = value

def home_page():

st.header("欢迎来到首页")

# 设置输入框为隐私状态

token = st.text_input("请输入浦语token:", type="password", key="token")

weather_token = st.text_input("请输入和风天气token:", type="password", key="weather_token")

if st.button("保存并体验agent"):

if token and weather_token:

set_env_variable("token", token) # 设置环境变量为 'token'

set_env_variable("weather_token", weather_token) # 设置环境变量为 'weather_token'

st.session_state.token_entered = True

st.rerun()

else:

st.error("请输入所有token")

if 'token_entered' not in st.session_state:

st.session_state.token_entered = False

if not st.session_state.token_entered:

home_page()

else:

# 动态加载子页面

page = st.sidebar.radio("选择页面", ["天气查询助手", "博客写作助手"])

if page == "天气查询助手":

runpy.run_path("examples/agent_api_web_demo.py", run_name="__main__")

elif page == "博客写作助手":

runpy.run_path("examples/multi_agents_api_web_demo.py", run_name="__main__")

此外由于 streamlit 要求一个页面内只能有一个 st.set_page_config() 函数,因此需要把 agent_api_web_demo.py 和 multi_agents_api_web_demo.py 中的相应代码注释掉。

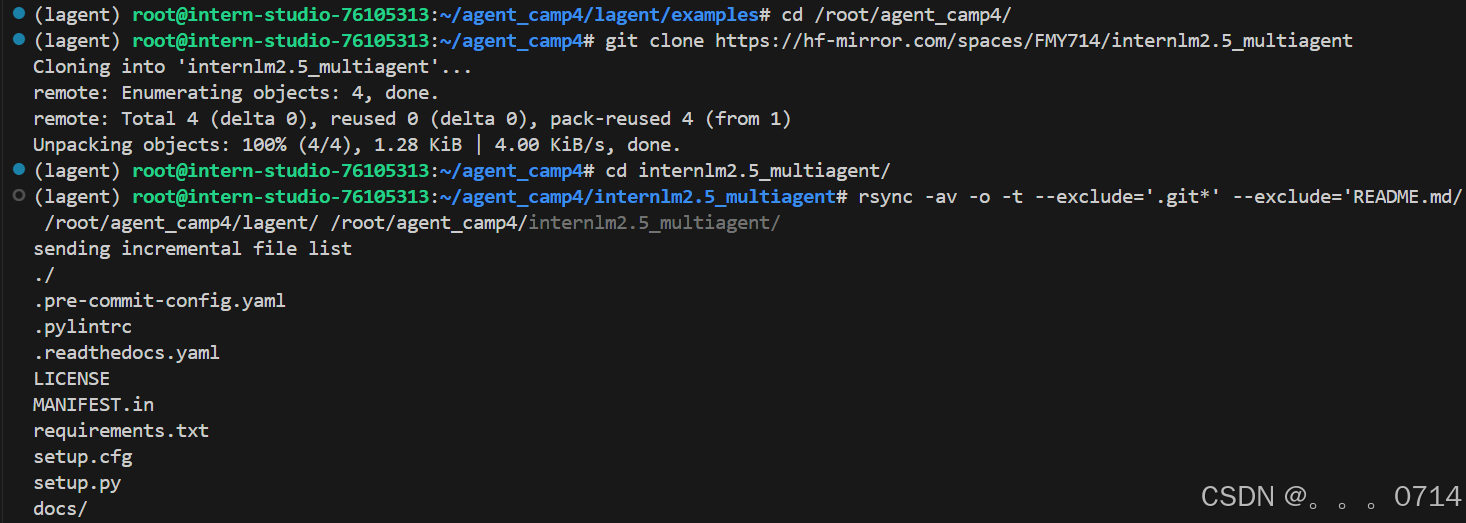

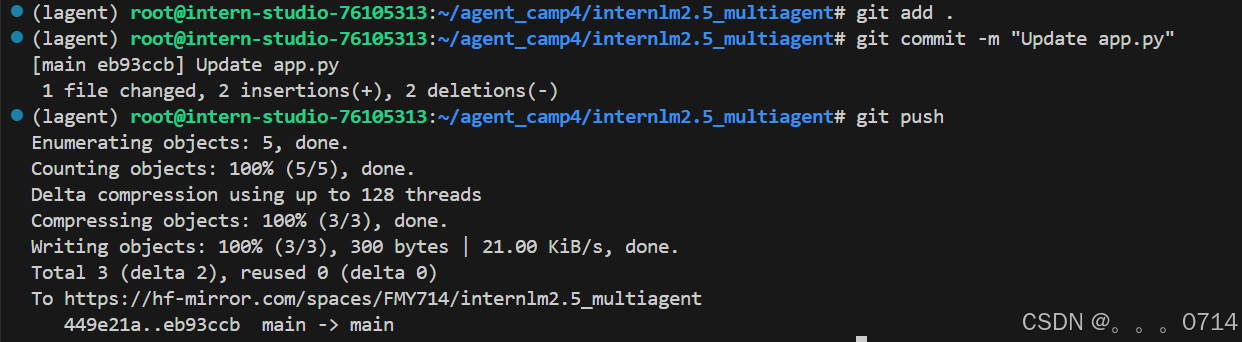

由于 git 文件和 README 中有仓库的配置信息,因此将 agent_camp4/lagent 文件夹下需要的文件用 rsync 全都拷贝到自己新建的 huggingface Spaces 仓库下。

cd /root/agent_camp4/

git clone https://hf-mirror.com/spaces/FMY714/internlm2.5_multiagent

cd internlm2.5_multiagent/

rsync -av -o -t --exclude='.git*' --exclude='README.md' /root/agent_camp4/lagent/ /root/agent_camp4/internlm2.5_multiagent/

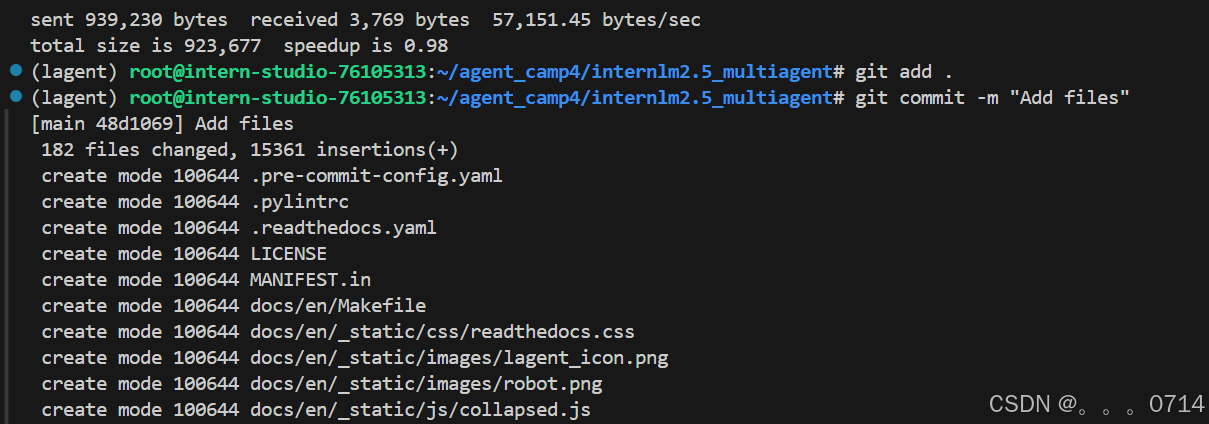

git add .

git commit -m "Add files"

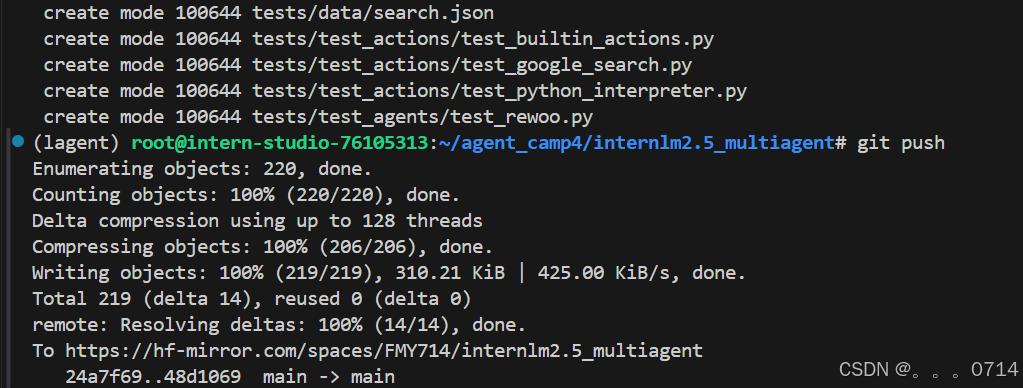

git push

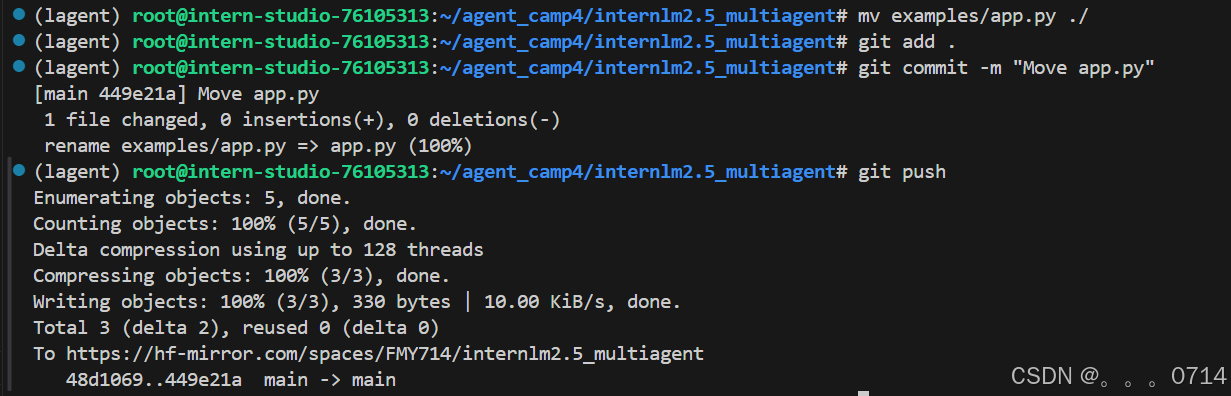

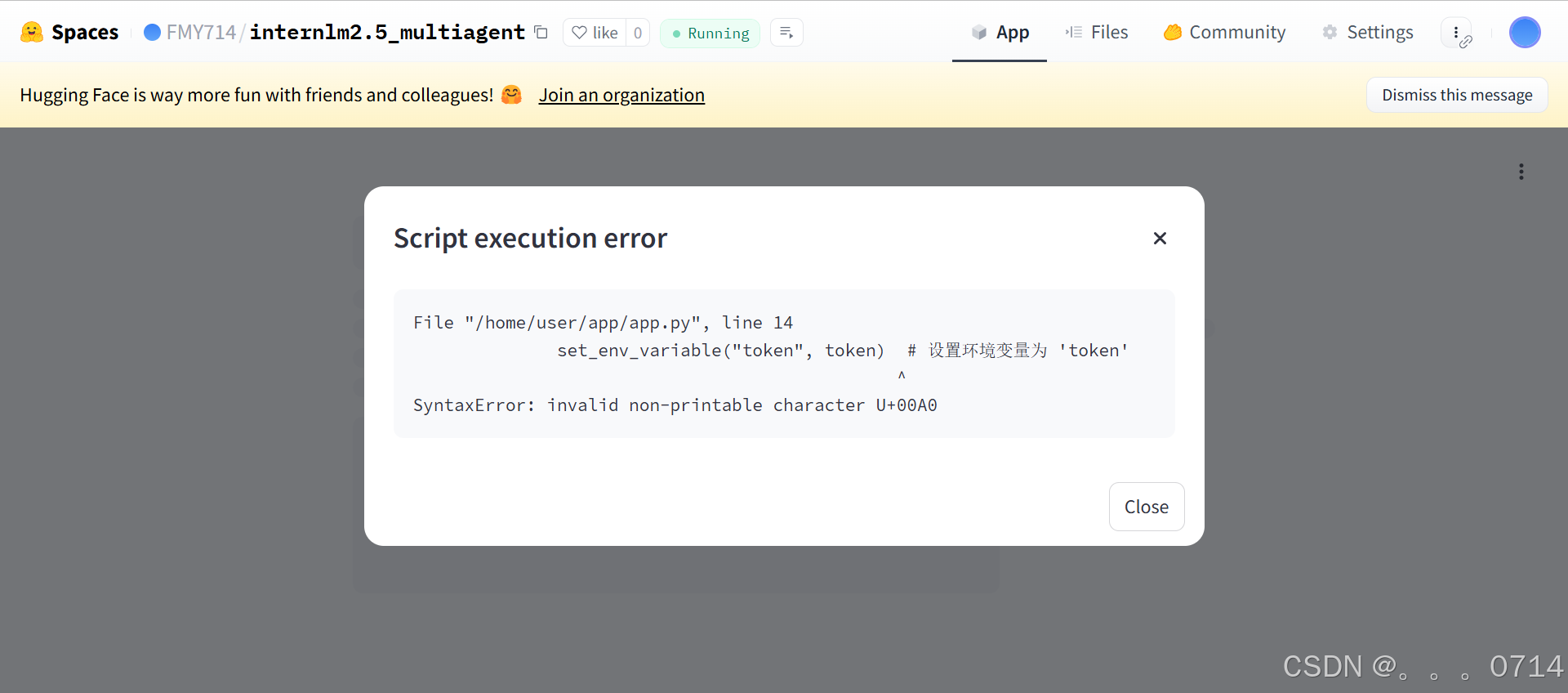

出现“No application file”报错,排查问题出在app.py的路径不对。

mv examples/app.py ./

git add .

git commit -m "Add files"

git push

浙公网安备 33010602011771号

浙公网安备 33010602011771号