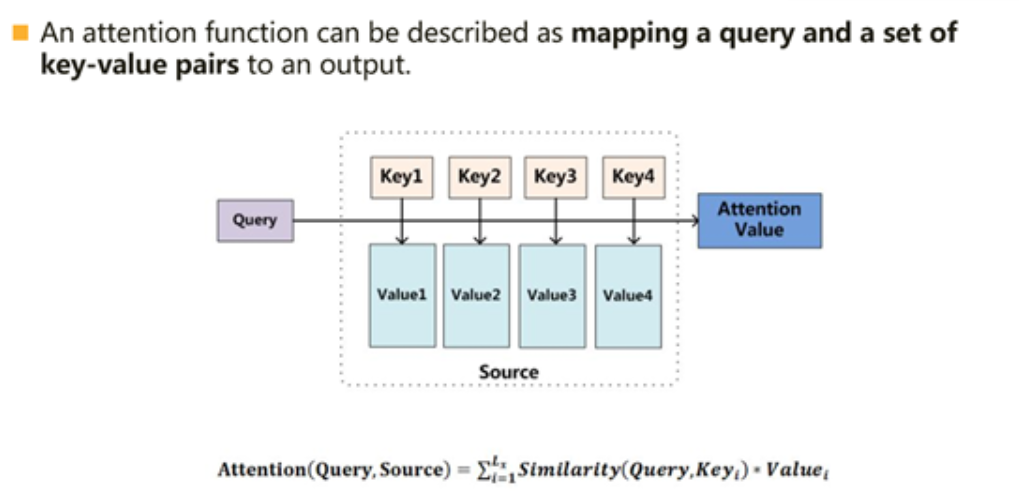

Attention函数的本质是:一个query到一系列key-value的映射

实际是Query和key的相似度*value

lightgbm:

cart树 classification and regression tree

ID 3例子在李航书里

C4.5算法很好的例子

决策树剪枝:

ADD:

1.SMOTE

2.lightgbm xgboost异同

https://posts.careerengine.us/p/5d94b5cdeedf7562926544dd

long也是整形,只不过保存的位数多,所以如果像小于0的概率,用long一转化会直接为0

直接用relu做激活函数很有风险,易导致输出全0的情况

愿为天下目,萃聚六路华

浙公网安备 33010602011771号

浙公网安备 33010602011771号