使用Ollama本地部署大模型

准备运行环境

安装模型

以7b的deepseek-r1为例。注意,deepseek除了671b的模型,其他的都是蒸馏模型。

- 打开Ollama模型下载

- 选择合适的模型,并复制模型名称(比如deepseek-r1:7b)

- 打开终端(PowerShell),输入命令

ollama run deepseek-r1:7b,下载并运行模型。 - 在终端可以输入文字与模型对话即安装成功

安装Open WebUI图形界面

- 在开始菜单或者终端打开

Anaconda PowerShell Prompt - 创建一个虚拟环境,命令

conda create -n open-webui python=3.11 - 进入open-webui环境,命令

conda activate open-webui - 安装Open WebUI,命令

pip install open-webui - 启动Open WebUI,命令

open-webui serve - 打开浏览器,输入地址

localhost:8080,设置用户名、邮箱、密码,即可开始使用

后续启动方法

- 启动Ollama(从开始菜单启动即可,启动后没有图形界面,右下角托盘有Ollama图标)

- 打开

Anaconda PowerShell Prompt命令行,启动Open WebUI

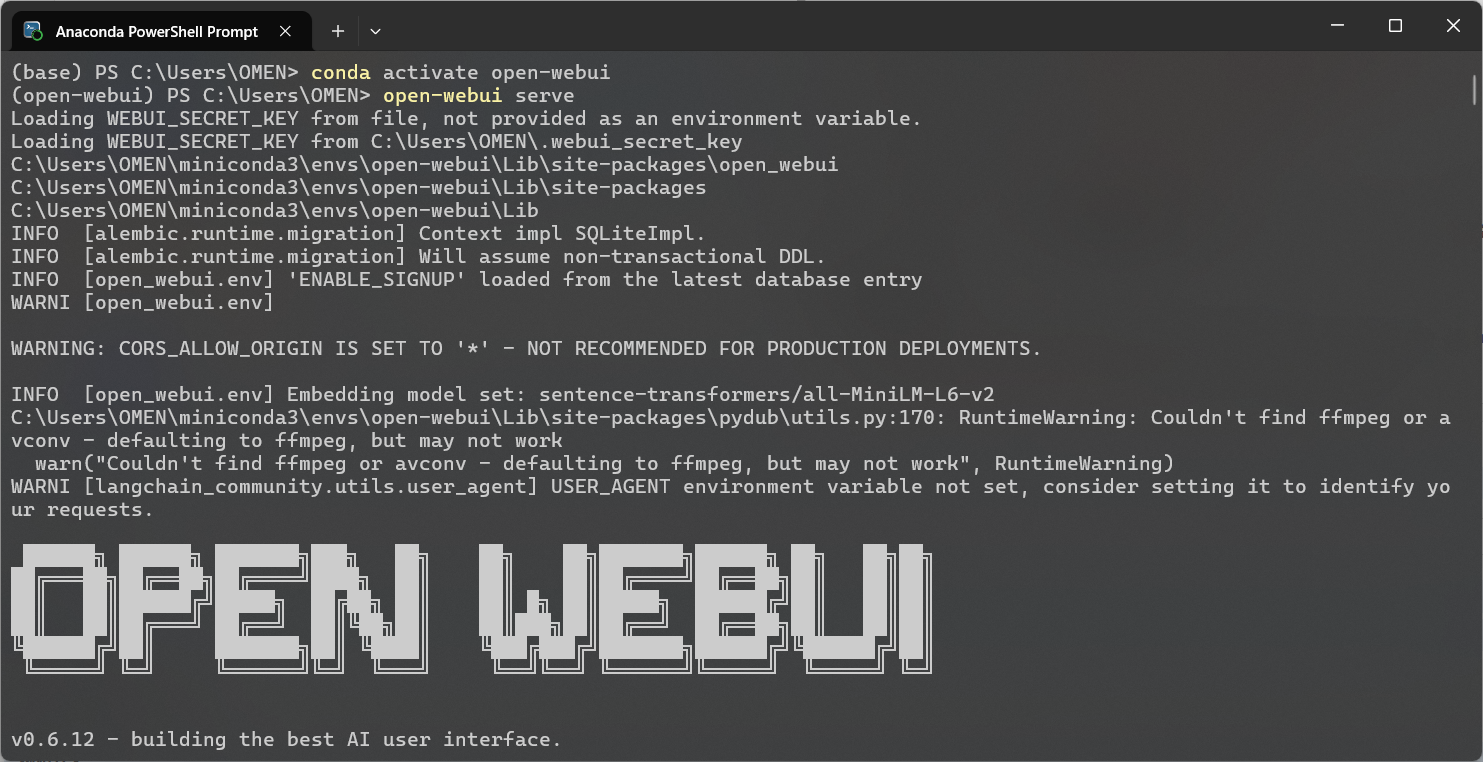

conda activate open-webui

open-webui serve

- 打开浏览器

localhost:8080即可使用

附图

Open WebUI启动成功

效果演示

补充资料

- 模型蒸馏(Knowledge Distillation,简称 KD)是一种模型压缩技术,其核心思想是利用一个大规模、高性能的教师模型(Teacher Model)训练一个较小的学生模型(Student Model),使得学生模型能够以接近教师模型的能力进行推理。

参考资料:大语言模型的模型蒸馏:概念、方法与应用 - 模型大小的选择一般根据显存大小选择,比如8G显存可以选择8b以下的模型,16G显存可以选择14b模型。超过显存大小也可以使用,Ollama会使用CPU进行推理,生成速度会大幅下降。

浙公网安备 33010602011771号

浙公网安备 33010602011771号