[强化学习论文笔记(8)]:DDPG

CONTINUOUS CONTROL WITH DEEP REINFORCEMENT LEARNING

论文地址

笔记

出发点:

DQN的成功让人么意识到非线性的神经网络可以很好的拟合value function(过去认为是不可行的).

于是David Silver把自己过去的DPG 拿出来用神经网络修改了一番就成了DeepDPG.

文章总结DQN的成功原因:

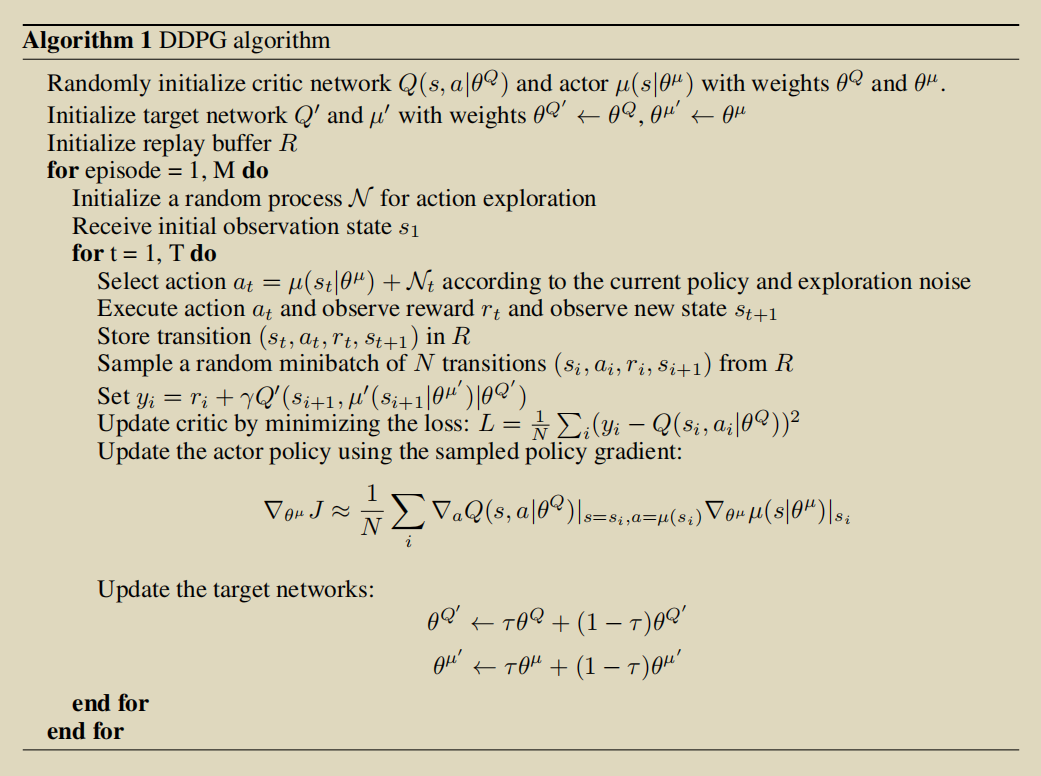

- off-policy, sample from a replay buffer to minimize correlations between samples.

- 使用了target Q-network.

注意点:

- DDPG behavior policy 是\(\mu(s_t|\theta^mu)+N_t\),(确定性策略加噪声).

- 用了replay buffer.

- target network 是soft update的.

DDPG很适合高维连续动作空间.

在Atrai上DDPG比DQN需要的样本少.

浙公网安备 33010602011771号

浙公网安备 33010602011771号