BOOST-对误差的再次拟合模型与多模型组合方法

0.

决策树的生成就是递归地构建二叉决策树的过程,对回归树用平方误差最小化准则,对分类树用基尼指数最小化准则,进行特征选择,生成二叉树。

1.

Boost方法是一种弱模型的提升方法,从弱学习算法出发,反复学习,得到一系列弱分类器,然后组合这些弱分类器,构成一个强分类器。

提升方法有两大关键问题,一是在每一轮如何改变训练数据的权值或概率分布,二是如何将弱分类器组合成一个强分类器。

2.

AdaBoost算法用于二类分类学习,对于第一个问题,AdaBoost提高那些前一轮分类错误的样本的权值,而降低那些被正确分类的样本的权值,这样错误分类样本在后一轮学习中受到更大的关注。对于第二个问题,AdaBoost采取加权多数表决的方法。

3.Boosting Tree

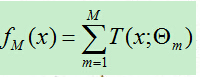

提升方法采用加法模型(即基函数的线性组合)与前向分步算法,以决策树为基函数的提升方法称为提升树。

提升树采用线性模型+前向分步算法+CART树(基函数)。提升树的加法模型可表示为:

(此时树前面并没有权重!!下面有分析)

1)基函数是分类树(二叉分类树)

对于基函数是分类树时,我们使用指数损失函数,此时正是AdaBoost算法的特殊情况,即将AdaBoost算法中的基分类器使用分类树即可。

2)基函数是回归树

若基函数是回归树,则使用平方误差损失函数。每次提升时,实际上是对当前模型的残差进行再次拟合,并将新的模型与原模型组合得到下一轮模型。

4.梯度提升GB

当损失函数是平方损失和指数损失函数时,每一步优化是很简单的,但对于一般损失函数而言,往往每一步的优化并不容易。因此采用梯度提升算法,利用损失函数在当前模型的的负梯度值作为提升算法中的残差近似值,拟合一个回归树。

浙公网安备 33010602011771号

浙公网安备 33010602011771号