cv学习总结(10.31-11.6)

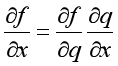

这一周主要焦点在于实现反向传播和全连接两层神经网络的具体代码以及书写博客记录课程学习的心得体会,目前完成了反向传播的具体代码以及相应博客的书写,完成了assignment1中figure的SVM版提取特征的线性分类器。反向传播能够很好的解决我们的映射函数特别复杂,无法手动求解梯度进行计算时的情况:反向传播的原理是链式法则:

所以我们在当前节点的梯度值是下游传递过来的梯度值乘以当前节点的梯度值。更加具体的思路和具体的实现过程在博客https://www.cnblogs.com/Lbmttw/p/16844897.html中体现的比较全面。

此外本周完成的two_layer_net的两层全连接神经网络在图片分类的任务上测试集的准确度能够达到0.5即有50%的正确率,相比于SVM的36.5%准确率提高了13.5%。我设定的参数是;learning_rate=1e-7,正则项为1.5e4,隐藏层为50,达到50%的准确度。本次实现的两层全连接神经网络相较于SVM而言仅仅多了一个隐藏层,但是精确度提高了13.5%,是非常客观的一个提升。

本周学习遇到的瓶颈可以说是非常多,在周一的时候忽然写不明白SVM算法了,又回去重新复习了一遍过后,写了一个全新的SVM和Softmax,这也算是第一次不查阅资料,自己书写明白cv相关的算法,让我非常的兴奋,开心了很长时间。在周三的时候开始写神经网络相关的内容,但是一开始就遇到了麻烦,cs231n中介绍神经网络仅仅用了10分钟左右,以至于我对于神经网络的各个名词的解释不是很明白,就导致了我书写代码的过程是特别困惑的,哪怕到现在,仍有很多问题需要思考解决。包括不同的激活函数的适用场景,为什么有的时候换一个激活函数整体的性能就会发生很大的变化等等。其实整个神经网络我没有理解的部分就是为什么要添加一个或者多个隐藏层,隐藏层的作用是什么,以及为什么增加隐藏层内参数的个数会导致模型过拟合,整体神经网络的各个部分的功能还不是很明确。争取今天晚上我能完成两层全连接神经网络所有部分的理解,并完成相应博客的书写https://www.cnblogs.com/Lbmttw/p/16858127.html。

目前开始学习视觉和机器学习部分最重要的几个知识点了,神经网络,我觉得如果这方面掌握的不牢固对后续的研究过程是不利的,所以我尽量多思考,多理解,多去看别人的实现思路以及解释,跟自己的理解相对照,争取彻底明白神经网络。这一部分我打算进度稍微放缓一些,这周完成两层神经网络,下周完成卷积神经网络。

浙公网安备 33010602011771号

浙公网安备 33010602011771号