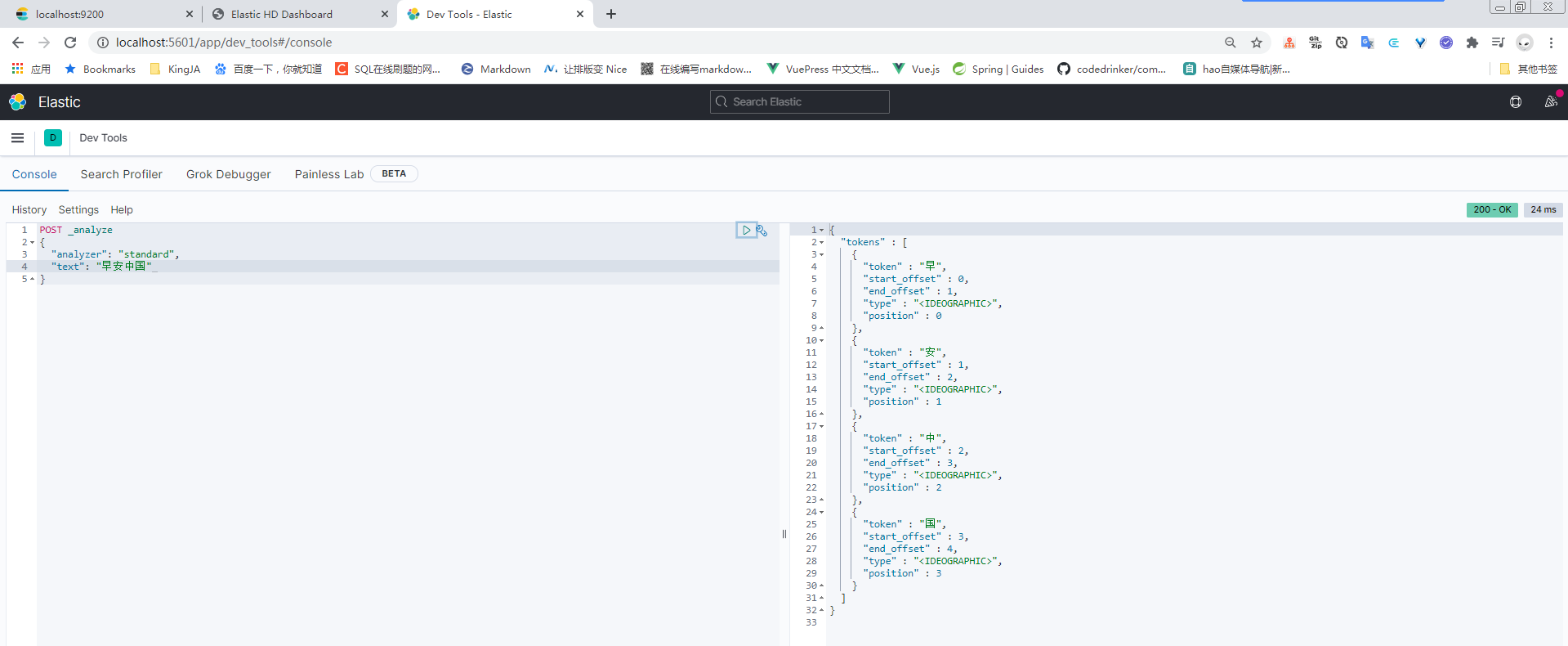

ElasticSearch--分词器

中文分词器

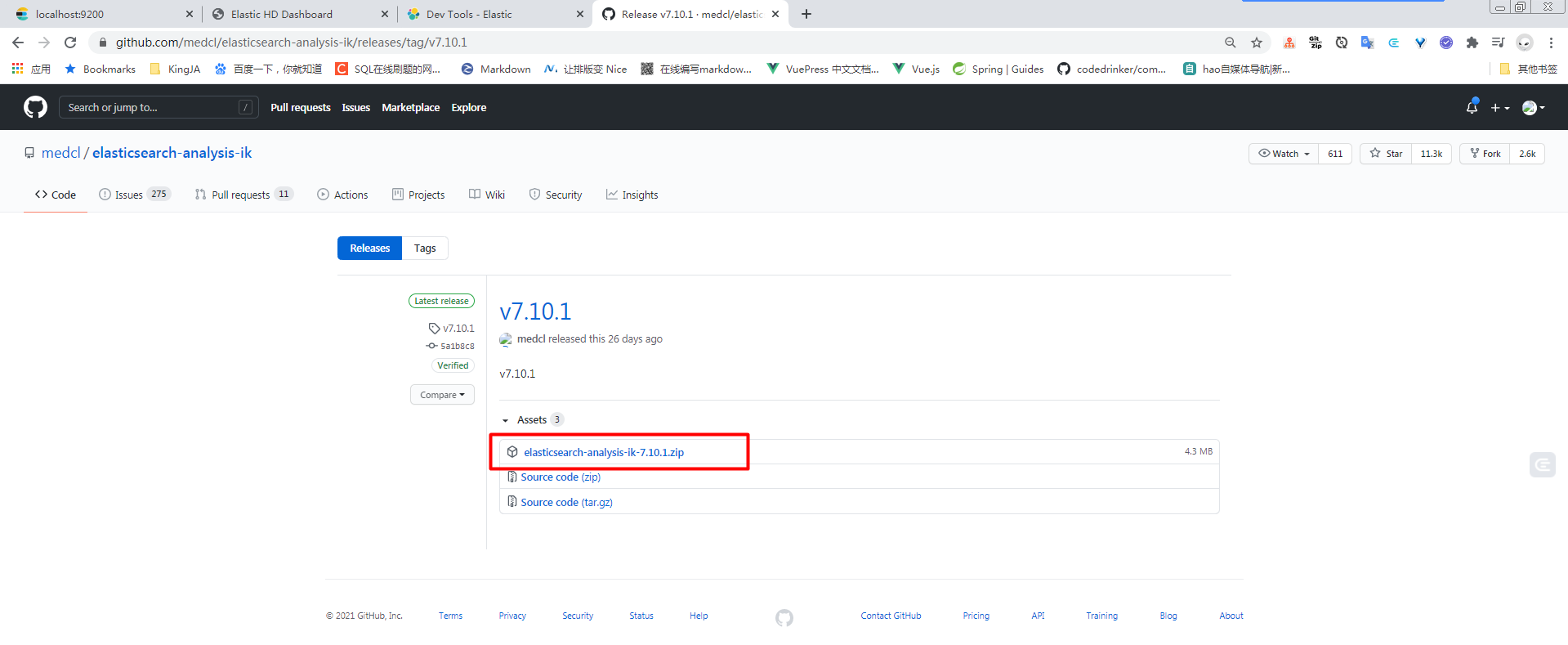

https://github.com/medcl/elasticsearch-analysis-ik

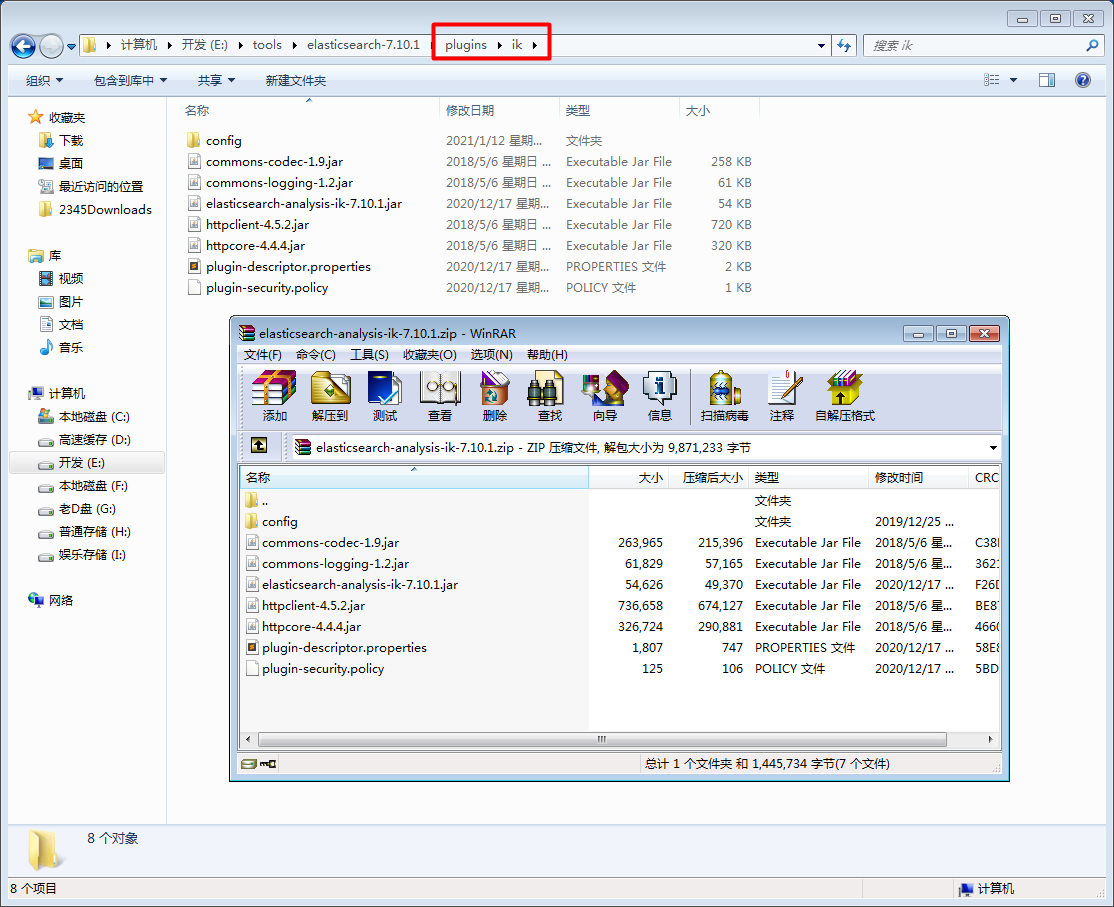

下载对应版本的压缩包

在ES根目录下的plugins新建一个文件夹,把压缩包的东西解压缩到该文件夹下

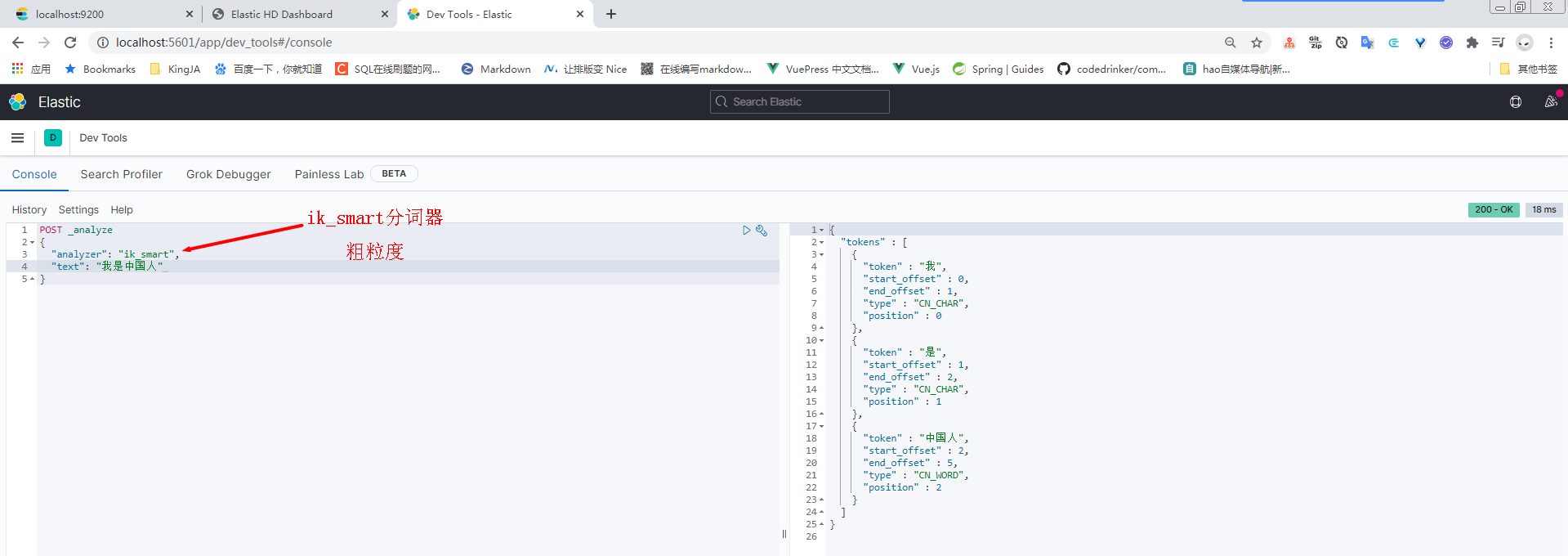

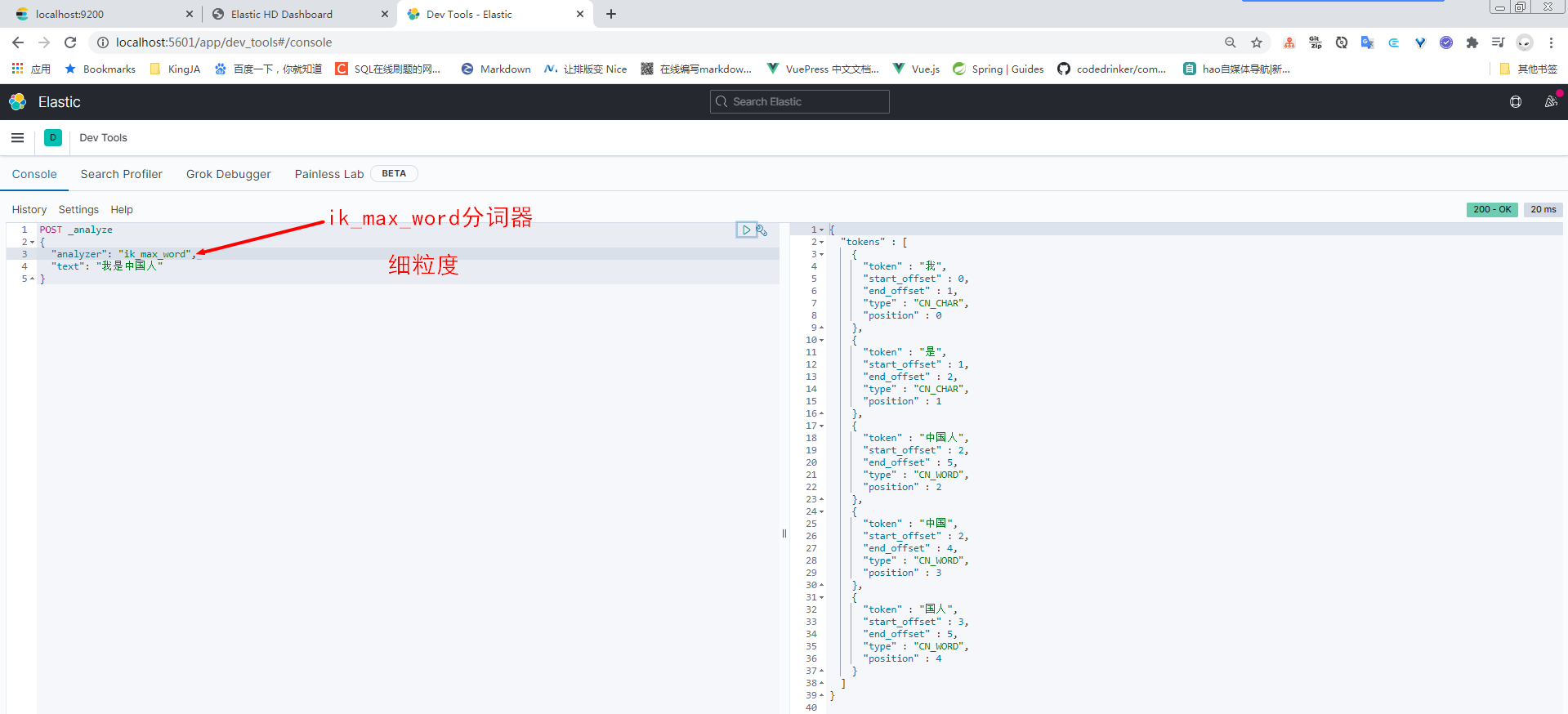

ik分词器下有2个分词器

分别是

- ik_smart

- ik_max_word

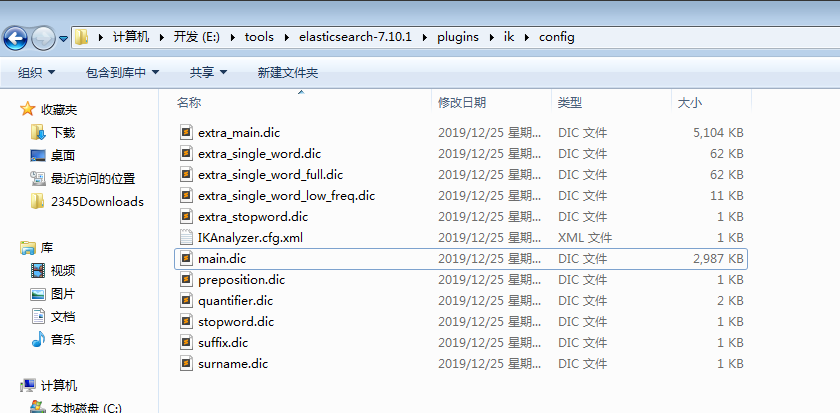

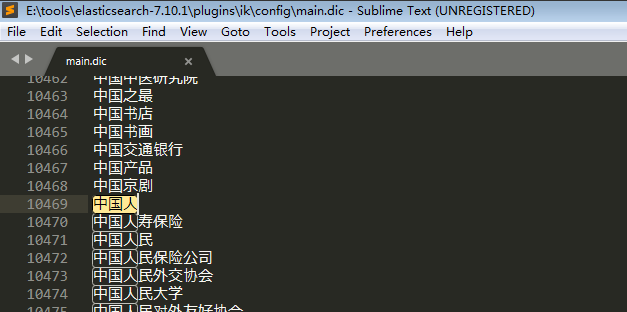

大概的工作原理是,ik分词器的config文件夹下有很多中文字典,ik分词器会从字典中寻找文本中是否对应,如果有则作为分词返回。

因此如果想要添加新的分词,比如自定义分词,只需要在字典里添加词组即可。

浙公网安备 33010602011771号

浙公网安备 33010602011771号