AI:部署模型

工具

vllm

vllm serve deepseek-ai/DeepSeek-R1-Distill-Qwen-32B --tensor-parallel-size 2 -–max-model-len 32768 -–enforce-eager

vllm serve:启动vllm推荐服务的命令

deepseek-ai/DeepSeek-R1-Distill-Qwen-32B:HuggingFace模型库中的名称,vllm会深度从HuggingFace下载模型

--tensor-parallel-size 2:启用张量并行,在2个GPU上分布式支行模型

--max-model-len 32768:设置模型的最大上下文长度(32k tokens)

--enforce-eager:禁用CUDA Graph优化

下载模型

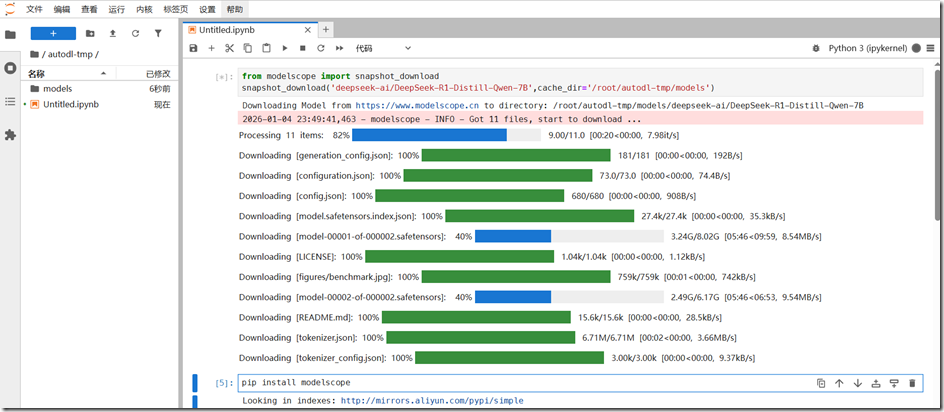

从modelscope下载

from modelscope import snapshot_download snapshot_download('deepseek-ai/DeepSeek-R1-Distill-Qwen-7B',cache_dir='/root/autodl-tmp/models')

系统

推荐Ubuntu

框架

PyTorch

算力云

AutoDL

浙公网安备 33010602011771号

浙公网安备 33010602011771号