08 学生课程分数的Spark SQL分析

读学生课程分数文件chapter4-data01.txt,创建DataFrame。

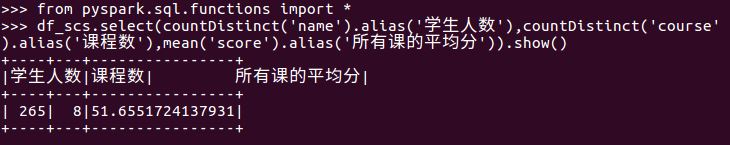

一、用DataFrame的操作或SQL语句完成以下数据分析要求,并和用RDD操作的实现进行对比:

- 每个分数+5分。

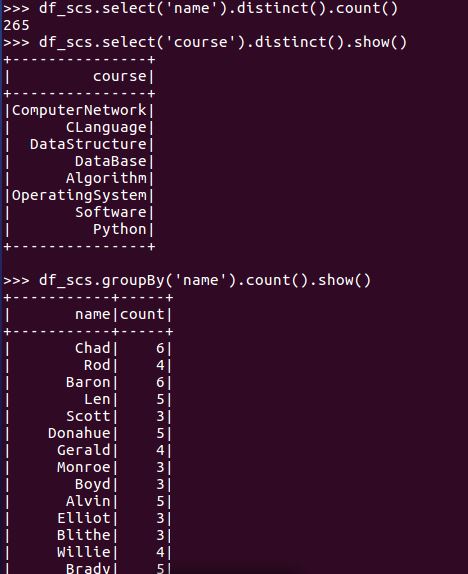

- 总共有多少学生?

- 总共开设了哪些课程?

- 每个学生选修了多少门课?

- 每门课程有多少个学生选?

- 每门课程大于95分的学生人数?

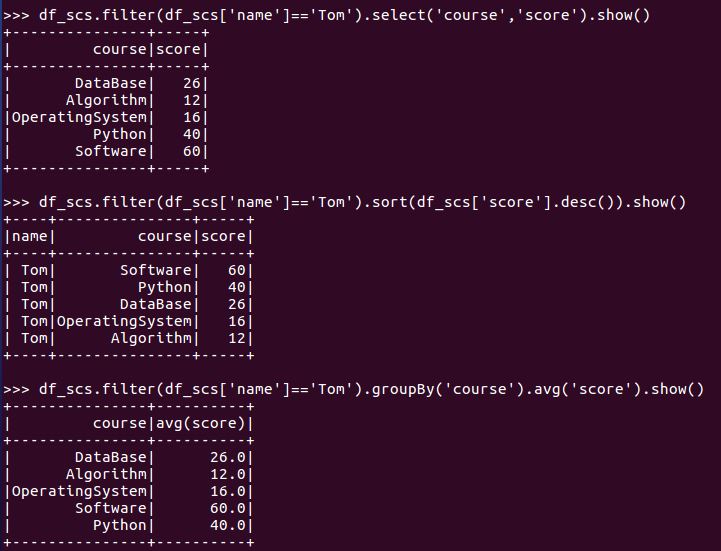

- Tom选修了几门课?每门课多少分?

- Tom的成绩按分数大小排序。

- Tom的平均分。

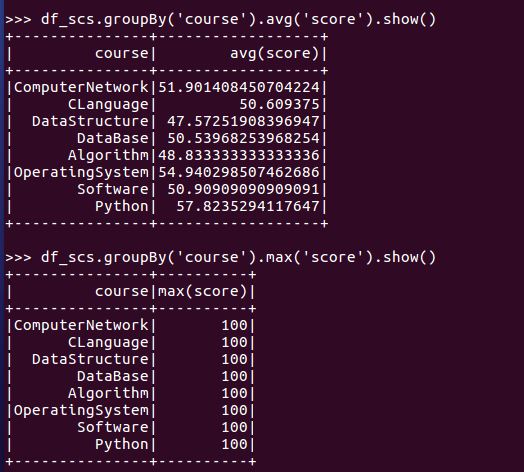

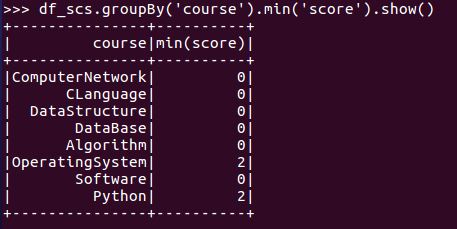

- 求每门课的平均分,最高分,最低分。

- 求每门课的选修人数及平均分,精确到2位小数。

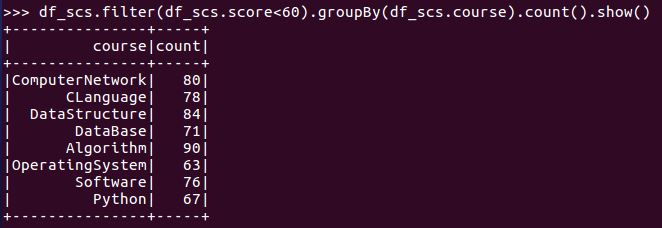

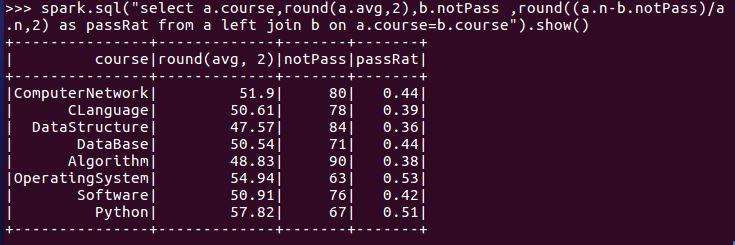

- 每门课的不及格人数,通过率

- 结果可视化。

二、用SQL语句完成以上数据分析要求

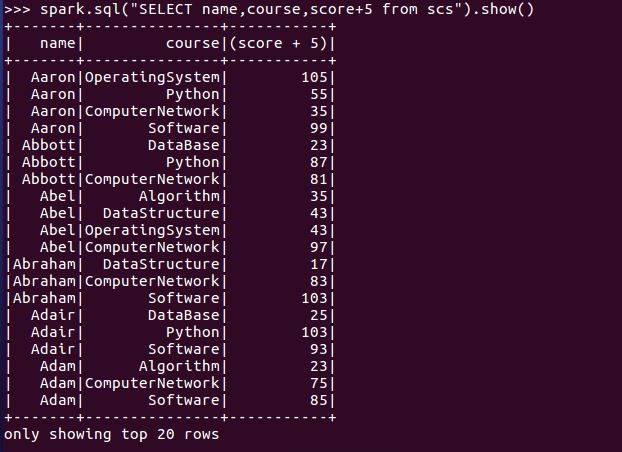

- 每个分数+5分。

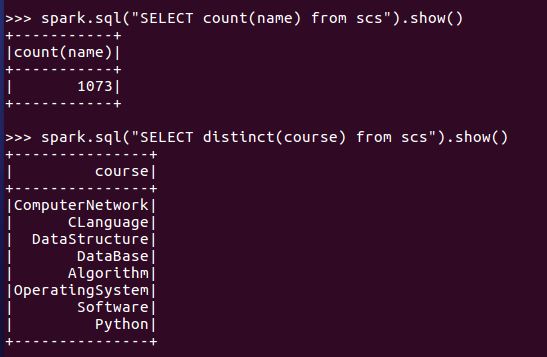

- 总共有多少学生?

- 总共开设了哪些课程?

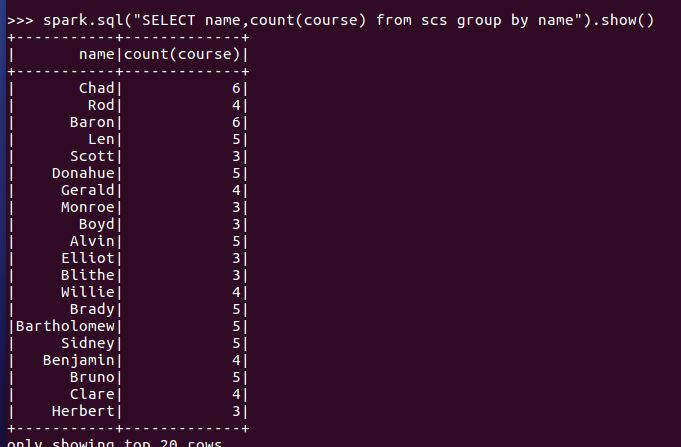

- 每个学生选修了多少门课?

- 每门课程有多少个学生选?

- 每门课程大于95分的学生人数?

- Tom选修了几门课?每门课多少分?

- Tom的成绩按分数大小排序。

- Tom的平均分。

- 求每门课的平均分,最高分,最低分。

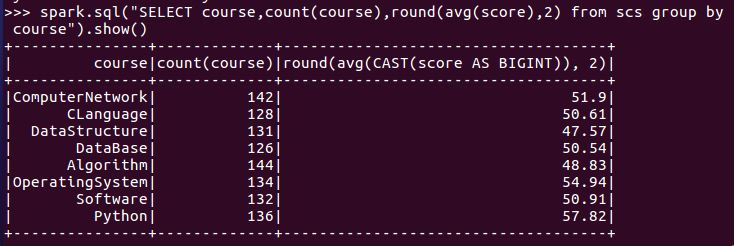

- 求每门课的选修人数及平均分,精确到2位小数。

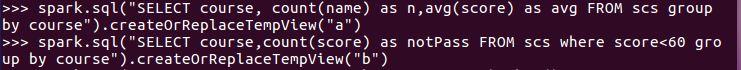

- 每门课的不及格人数,通过率

三、对比分别用RDD操作实现、用DataFrame操作实现和用SQL语句实现的异同。(比较两个以上问题)

1.每个分数+5分

(1)sql实现

spark.sql("SELECT name,course,score+5 from scs").show()

(2)DataFrame操作实现

df_scs.select('name','course',df_scs.score+5).show()

(3)RDD实现

words = words.map(lambda x:(x[0],int(x[1])))

words.mapValues(lambda x:x+5).foreach(print)

2.总共有多少学生?

(1)sql实现

spark.sql("SELECT count(name) from scs").show()

(2)DataFrame操作实现

df_scs.select('name').distinct().count()

(3)RDD实现

lines.map(lambda line : line.split(',')[0]).distinct().count()

3.求每门课的选修人数及平均分,精确到2位小数。

(1)sql实现

spark.sql("SELECT course, count(name) as n,avg(score) as avg FROM scs group by course").show() #每门课的选修人数与平均分

(2)DataFrame操作实现

df_scs.groupBy('course').agg({'name':'count',"score": "mean"}).withColumnRenamed("avg(score)","'avg').withColumnRenamed("count(name)",'n').show()

df_scs.groupBy("course").avg("score").show()

df_scs.groupBy("course").count().show()

四、结果可视化。