京东零售基于国产芯片的AI引擎技术

一、前言

随着大模型的广泛应用,作为人工智能三大支柱之一的AI算力,已经成为竞争的焦点。从模型训练到推理,算力存在于大模型生命周期的每一环,极大程度地影响着模型在实际业务场景的性能与效果。面对京东海量数据的各种场景,缺乏坚实的算力基础就犹如高楼大厦没有稳固的地基,上层的算法/数据无法发挥其作用。

而随着美国相继出台的高端AI芯片禁令,如何保障集团的算力安全成为一个我们无法回避的问题。2024年12月3日,中国半导体行业协会、中国汽车工业协会、中国互联网协会、中国通信企业协会集体发布声明,针对美国对华采取的出口限制表示坚决反对,认为美国相关芯片产品不再安全、不再可靠。四协会建议相关企业谨慎采购美国芯片,扩大与其他国家和地区芯片企业合作,积极使用内外资企业在华生产制造的芯片,呼吁中国政府支持可靠半导体产品供应商的稳定发展。

如何在京东业务场景让国产芯片可用、好用,是一个亟需解决的问题。然而,我们发现这并非易事,存在着以下挑战:

1. 硬件架构差异显著

在过去,京东底层算力集群主要围绕GPU进行建设,而国产NPU与GPU硬件架构差异大,且京东零售业务场景诉求多样、数据与模型体量庞大,需提升集群对多种异构芯片的兼容性及统一灵活调度能力,充分挖掘国产芯片算力,从而保障集群中不同类型的国产芯片被最大化利用的同时,能够有序、高效地为业务提供算力支持。

2. 软件生态尚未成熟

当前各开源模型或训练推理框架并不直接提供针对国产NPU的解决方案,而国产NPU软件生态尚不成熟。这意味着开发人员从 GPU 迁移至国产NPU包含精度校验、性能调优等复杂的适配工作,面临着巨大的迁移成本,严重影响算法开发与业务迭代效率。

我们看到,GPU芯片能成为大多数人第一选择的原因,核心并不在于其产品硬件性能更强,而是因为他们构建了十分完善的CUDA生态。开发人员基于GPU的开发工作无需感知底层硬件的架构,能够更加关注模型开发与业务逻辑。

3. 业务场景需求多样且复杂

京东零售业务场景丰富复杂,各场景在模型选型、性能要求等方面差异巨大,解决方案不仅需要高效、统一,还必须能够灵活适配各业务场景,实现“1套方案、N种应用”。

以PyTorch为例,通用模型从GPU迁移至华为昇腾NPU流程示例,图像来自昇腾官网模型开发文档

以上痛点的核心在于,缺乏一套基于国产NPU的端到端训练推理解决方案,支持算法人员无感知地从GPU迁移至国产NPU。在此背景下,九数算法中台从集群网络到训练推理引擎建设,推出了高效、统一、灵活的基于国产芯片的AI引擎技术。在接下来的章节,将为您详细介绍九数算法中台如何搭建起这样的生态系统,使得国产芯片在京东零售“落地有声”。

二、基于国产芯片的AI引擎技术

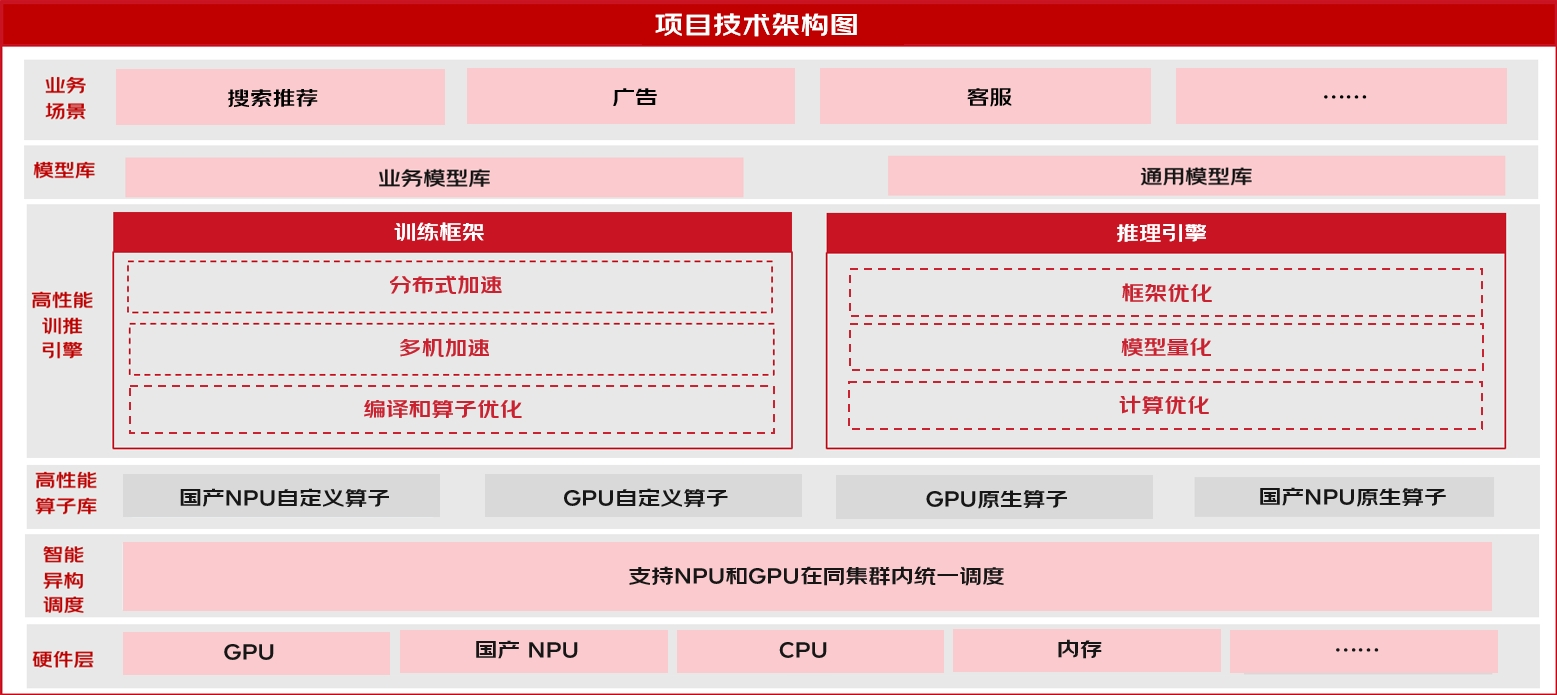

2.1 整体技术架构

项目架构图

2.2 GPU与NPU异构混合调度系统

为了保障京东零售业务场景多样复杂的芯片使用诉求,九数算法中台基于高性能计算网络搭建千卡规模集群,支持国产NPU与GPU相同的调度能力,通过统一的配额分配、调拨体系支持开发人员无感知灵活调度国产NPU与GPU。由于算力资源长期处于满负荷运行状态,九数算法中台采取了多种措施来最大程度助力算法同学极致利用算力资源、更高效地完成算法工作,在保证业务稳定、易用基础上提升资源利用率,节约集团IT资源成本,充分挖掘NPU硬件能力,实现国产NPU芯片到从“单片可用”跨越至“集群好用”:

2.3 高性能训练引擎

九数高性能训练引擎,经过深度优化和架构升级,完成对超过40种涵盖LLM、多模态等主流底座模型的全面适配和优化,包括但不限于LLM、多模态系列和文生图、文生视频系列,实现了对NPU算力的全面兼容。该引擎采用高度抽象的API接口,实现了一套API下NPU和GPU用户无感、0成本无缝切换训练,为京东零售算力提供了坚实的安全保障;同时通过集成模型并行、序列并行,低精度通信,通信计算融合等技术,大幅提升了模型训练的吞吐量,为京东零售的智能计算提供了强有力的支撑。其主要特性如下:

| 模型 | 规模 | 离线训练 | 高效离线推理 | ||

| GPU | 国产NPU | GPU | 国产NPU | ||

| SR1.5 搜推电商领域大模型 | 3B/7B/15B | ✅ | ✅ | ✅ | ✅ |

| Qwen2.5 | 0.5B/1.5B/3B/7B/14B | ✅ | ✅ | ✅ | ✅ |

| Qwen2.5 | 34B/72B | ✅ | ✅ | ✅ | ✅ |

| ChatGLM2 | 6B | ✅ | ✅ | ✅ | ✅ |

| ChatGLM3 | 6B | ✅ | ✅ | ✅ | ✅ |

| GLM4 | 9B | ✅ | ✅ | ✅ | ✅ |

| Qwen | 1.8B/7B/14B | ✅ | ✅ | ✅ | ✅ |

| Qwen-1.5 | 0.5B/1.8B/4B/7B/14B | ✅ | ✅ | ✅ | ✅ |

| Qwen-1.5 | 32B/72B/110B | ✅ | ✅ | ✅ | ✅ |

| Qwen-2 | 0.5B/1.5B/7B | ✅ | ✅ | ✅ | ✅ |

| Qwen-2 | 72B | ✅ | ✅ | ✅ | ✅ |

| LLama2 | 7B/13B | ✅ | ✅ | ✅ | ✅ |

| LLama3 | 8B | ✅ | ✅ | ✅ | ✅ |

| LLama3 | 70B | ✅ | ✅ | ✅ | ✅ |

| LLama3.1 | 8B | ✅ | ✅ | ✅ | ✅ |

| LLama3.1 | 70B | ✅ | ✅ | ✅ | ✅ |

| YI | 6B/34B | ✅ | ✅ | ✅ | ✅ |

| YI-1.5 | 6B/9B | ✅ | ✅ | ✅ | ✅ |

| YI-1.5 | 34B | ✅ | ✅ | ✅ | ✅ |

| Baichuan2 | 7B/13B | ✅ | ✅ | ✅ | ✅ |

| Bloom-z | 7B | ✅ | ✅ | ✅ | ✅ |

| Gemma | 2B/7B | ✅ | ✅ | ✅ | ✅ |

九数训练引擎LLM模型支持概况

在使用NPU进行模型训练时,开发人员无需进行精度对齐、框架适配等工作,仅需基于实际业务诉求,关注数据准备、参数配置、验证评估等训练流程,选择NPU对应型号,即可快速提交训练任务,实现基于NPU业务的高效迭代优化。

2.4 高性能推理引擎

与训练引擎类似,九数算法中台针对国产NPU建设高性能推理引擎,支持MaaS开箱即用部署(服务化部署托管),实现基于国产NPU的一键部署,内置20+业界通用LLM大模型。通过模型量化、编译优化等手段进行推理加速,满足业务在大模型场景下对于高效问答的诉求,性能相比业界开源框架提升20%。

| 类别 | 当前支持模型 |

| LLM | Baichuan2-7B |

| Baichuan2-13B | |

| ChatGLM2-6B | |

| ChatGLM2-13B | |

| ChatGLM3-6B | |

| Qwen-1.8B | |

| Qwen-7B | |

| Qwen-14B | |

| Qwen-72B | |

| Qwen-VL | |

| Qwen1.5-1.8B | |

| Qwen1.5-7B | |

| Qwen1.5-14B | |

| Qwen1.5-72B | |

| Qwen2-7B | |

| Qwen2-72B | |

| Llama2-7B | |

| Llama2-13B | |

| Llama2-70B | |

| Llama3-8B | |

| BLOOM-7B | |

| Gemma-7B | |

| internlm | |

| 多模态 | SD1.5 |

| SDXL | |

| Mistral-7B |

九数推理引擎NPU支持模型概况

同时,在大规模搜推广场景,本项目也支持基于NPU的搜推广模型推理,通过开发融合Pass及融合kernel,满足搜索推荐广告系统对于在线推理服务高吞吐、低延迟的诉求。

三、落地场景

多模态大模型在京东零售业务场景存在广泛的应用,而算力是影响图像、视频计算任务的关键卡点。其中,数字内容相关业务期望基于NPU,利用Qwen2 VL模型对视频的多模态信息进行分析,抽取能够表征视频的一系列关键词。但当前Qwen2 VL开源代码仅支持GPU推理,暂未提供NPU解决方案,Qwen2 VL运行在国产NPU上存在算子优化、推理加速等适配工作。

通过使用九数算法中台的NPU高性能推理框架,业务可将模型快速部署至线上场景。业务仅需选择模型与NPU资源量,即可完成模型的在线部署,无需关心Qwen2 VL从GPU迁移至NPU的繁琐流程。

目前,该案例共部署数十卡国产NPU,用于内容Tag云标签生成工作,与GPU比对效果无明显差异。在输出Token数量一致的前提下,二者平均响应时长基本保持一致。

如何将国产芯片和物流场景有机结合,是电商领域亟需解决的问题。

在京东物流大模型场景中,业务方期望基于910B将Qwen2-7B在地址解析、地址编码、地址分类等任务进行上训练。由于Qwen2-7B开源项目未提供NPU训练方案,该业务利用九数算法中台提供的统一训练框架,基于框架底座开源模型进行了Pretrain、SFT、RL适配。

基于NPU微调的模型与基于GPU微调的模型在地址解析等任务的训练结果分别达到了91.03%与91.08%,二者表现基本一致。目前,基于NPU的训练产物已应用在多个业务场景中。在预分拣分单场景已上线多个省份,在地址分类任务上已经刷新4600万条母库POI数据的多级分类标签,在人工预分拣地址异常识别中每天识别3万条以上地址。

#Input_1

青海省西宁市城北区三其村。 可以发圆通吗 谢谢。

#Output-NPU(国产NPU)

青海省_1,西宁市_3A,城北区_3A,三其村_4B, _5A-1,可以发圆通吗 谢谢_UNK,

#Output-GPU(GPU)

青海省_1,西宁市_3A,城北区_3A,三其村_4B, _5A-1,可以发圆通吗 谢谢 _UNK

基于大模型的客服Agent已成为电商领域的新趋势。其中,在商家侧智能助手的案例中,业务侧期望使用过往沉淀QA数据,基于Qwen1.5 7B进行微调,实现模型针对商家问题进行分析,并将任务分配给下游工具处理。

由于Qwen1.5系列开源模型暂未提供针对NPU的微调方案,该案例利用九数算法中台提供统一训练框架,基于框架底座开源模型进行微调。

通过测试对比,国产NPU微调的模型与基于GPU微调的模型分析结果相似,且96%问题分配下游工具相同。对比模型分配的工具(pred_tool)和人工标注的工具(tool_gt)并综合打分,二者得分相近。

#Input_1

上架宝贝数怎么看?

#Output-国产NPU

{...'tool_name':' business_expert, 'query':'如何查看已上架的商品数量?'...}

#Output-GPU

{...'tool_name':' business_expert, 'query':'如何查看已上架的商品数量?'...}

#Input_2

为啥我不能提报活动了?

#Output-国产NPU

{...'tool_name':' business_expert, 'query':'为什么商家不能提报活动,以及如何解决提报问题?'...}

#Output-GPU

{...'tool_name':' business_expert, 'query':'商家无法提报活动的可能原因及解决方案是什么?'...}

四、应用价值

目前,京东零售基于国产芯片的AI引擎技术已在十余个业务场景落地,为加速国产芯片破局、打造开放生态探寻新思路。

五、行业影响力

在实现了基于国产算力的一系列技术突破后,我们将沉淀的技术经验进一步转化为在集团内外的影响力,彰显京东零售的技术领先性和行业责任感:

24年7月,昇腾大模型推理解决方案正式发布暨五大场景优秀实践,图源昇腾官网新闻资讯:https://www.hiascend.com/activities/dynamic-news/451

六、未来规划

随着业界主流模型体量不断扩大,百B甚至千B级模型的训推诉求愈发迫切。为了满足京东零售在大规模计算场景的诉求,集群将在25年实现万卡级别高性能网络及调度能力,助力大体量模型业务发展。同时,九数算法中台将持续扩充集群支持的芯片类型,允许GPU、国产NPU在集群内被混合调度。通过这样的集群生态建设,一方面能够让京东算法业务不依赖于单家厂商,保障了集团的算力安全和可持续发展;另一方面,也让算法业务在算力调度上有更加多元的选择。

除了进行集群的升级,九数算法中台还将进一步优化国产芯片的调度策略,通过应急资源池、资源智能预测、动态扩缩容等手段保障各业务都能够合理、高效地用上国产芯片,全面挖掘国产芯片算力性能。

京东零售将在2025年持续深入与国产头部芯片厂商的合作,共同助力京东零售AI数智化,作为华为昇腾AI解决方案竞争力和软件生态核心贡献者。

针对自研训练引擎在LLM场景的支持,九数算法中台将深入HCCL底层通信优化,建立融合算子库全面优化性能,达到百卡/千卡MFU可至60%。针对CTR训练场景,九数算法中台将建设业界首个同时支撑昇腾 NPU和GPU的性能领先的CTR大规模训练框架,并考虑建立开源生态,支持业务无感迁移,落地在主站推荐精排、主站搜索精排场景。

针对自研推理引擎在LLM场景的支持,九数算法中台将通过共建昇腾加速ATB算子库,扩展LLM前后处理能力及LVM等模型,性能能够达到业界SOTA;针对CTR推理场景,建设9N-Predictor NPU推理引擎,支持GPU/NPU异构推理,并通过共建GE自动融合优化引擎编译能力,最大程度发挥NPU在推荐场景的极致性能。

浙公网安备 33010602011771号

浙公网安备 33010602011771号