本次学习学习Spark集群环境的搭建

Spark集群环境搭建

首先下载Spark安装包

选取一个节点为Master,后进行配置:

vim ~/.bashrc

在.bashrc添加如下配置

export SPARK_HOME=/usr/local/spark // 注意路径 export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

运行source命令使得配置立即生效:

source ~/.bashrc

配置workers文件,将 workers.template 拷贝到 workers

cd /usr/local/spark/

cp ./conf/workers.template ./conf/workers

workers文件设置Worker节点。编辑workers内容,把默认内容localhost替换成Worker节点名称

hadoop103

hadoop10

配置spark-env.sh文件

将 spark-env.sh.template 拷贝到 spark-env.sh

cp ./conf/spark-env.sh.template ./conf/spark-env.sh

编辑spark-env.sh,添加如下内容:

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath) // 修改为自己路径 export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop export SPARK_MASTER_IP=192.168.10.1

配置好后,将Master主机上的/usr/local/spark文件夹复制到各个节点上在Master主机上执行如下命令:

cd /usr/local/ tar -zcf ~/spark.master.tar.gz ./spark cd ~ scp ./spark.master.tar.gz hadoop103:/home/atguigu scp ./spark.master.tar.gz hadoop104:/home/atguigu

在hadoop103,hadoop104节点上分别执行下面同样的操作

sudo rm -rf /usr/local/spark/ sudo tar -zxf ~/spark.master.tar.gz -C /usr/local sudo chown -R hadoop /usr/local/spark

(1)首先启动Hadoop集群。在Master节点主机上运行如下命令:

cd /usr/local/hadoop/

sbin/start-all.sh

(2)启动Master节点

在Master节点主机上运行如下命令:

cd /usr/local/spark/

sbin/start-master.sh

(3)启动所有Worker节点

在Master节点主机上运行如下命令:

sbin/start-workers.sh

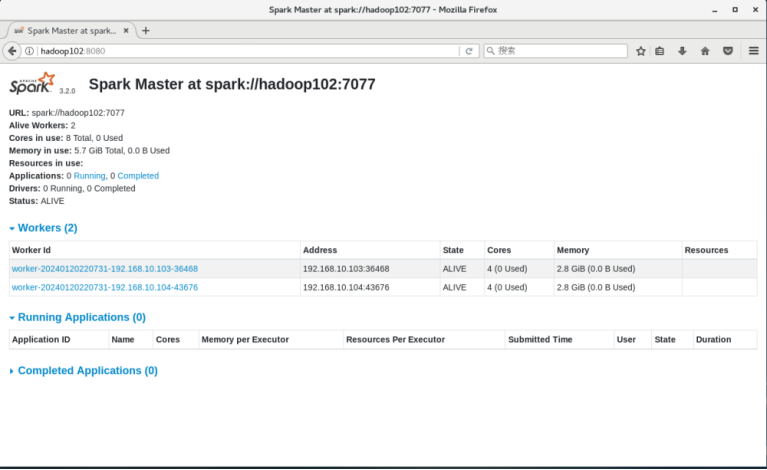

在浏览器上查看Spark独立集群管理器的集群信息

在Master主机上打开浏览器,访问http://hadoop102:8080,如下图:

在Master节点上执行下面命令

(1)关闭Master节点

sbin/stop-master.sh

(2)关闭Worker节点

sbin/stop-workers.sh

(3)关闭Hadoop集群

cd /usr/local/hadoop/

sbin/stop-all.sh

浙公网安备 33010602011771号

浙公网安备 33010602011771号