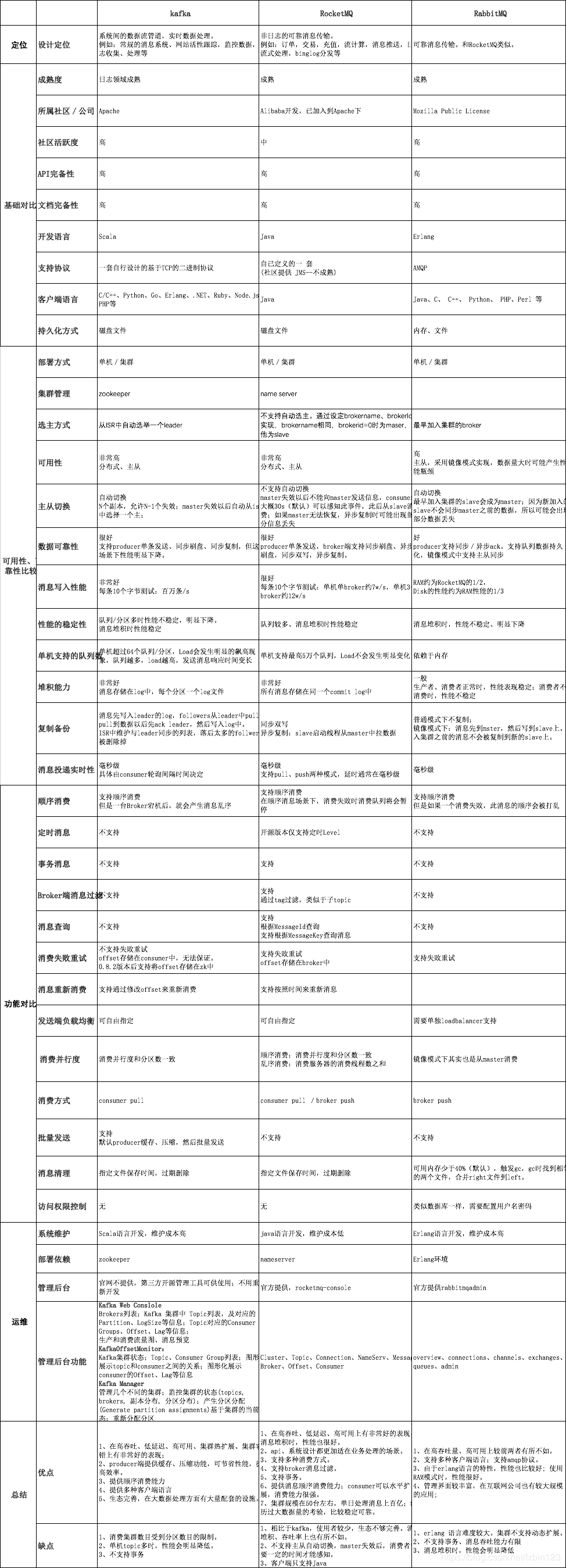

常用MQ产品的对比

一、MQ产品对比图:

二、应用场景

1、异步处理

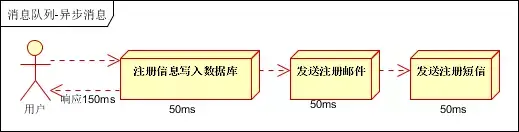

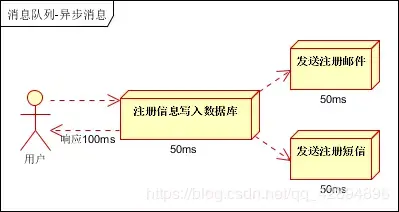

场景说明:用户注册后,需要发注册邮件和注册短信。传统的做法有两种:串行的方式和并行方式。

串行方式:将注册信息写入数据库成功后,发送注册邮件,再发送注册短信。以上三个任务全部完成后,返回给客户。

并行方式:将注册信息写入数据库成功后,发送注册邮件的同时,发送注册短信。以上三个任务完成后,返回给客户端。与串行的差别是,并行的方式可以提高处理的时间。

假设三个业务节点每个使用50毫秒钟,不考虑网络等其他开销,则串行方式的时间是150毫秒,并行的时间可能是100毫秒。

因为CPU在单位时间内处理的请求数是一定的,假设CPU1秒内吞吐量是100次。则串行方式1秒内CPU可处理的请求量是7次(1000/150)。并行方式处理的请求量是10次(1000/100)。

小结:如以上案例描述,传统的方式系统的性能(并发量,吞吐量,响应时间)会有瓶颈。如何解决这个问题呢?

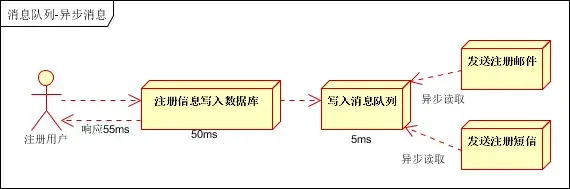

引入消息队列,将不是必须的业务逻辑,异步处理。改造后的架构如下:

按照以上约定,用户的响应时间相当于是注册信息写入数据库的时间,也就是50毫秒。注册邮件,发送短信写入消息队列后,直接返回,因此写入消息队列的速度很快,基本可以忽略,因此用户的响应时间可能是50毫秒。因此架构改变后,系统的吞吐量提高到每秒20QPS。比串行提高了3倍,比并行提高了两倍

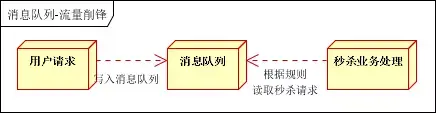

2、流量削峰、秒杀

流量削锋也是消息队列中的常用场景,一般在秒杀或团抢活动中使用广泛!

应用场景:秒杀活动,一般会因为流量过大,导致流量暴增,应用挂掉。为解决这个问题,一般需要在应用前端加入消息队列。

可以控制活动的人数,可以缓解短时间内高流量压垮应用。

用户的请求,服务器接收后,首先写入消息队列。假如消息队列长度超过最大数量,则直接抛弃用户请求或跳转到错误页面。秒杀业务根据消息队列中的请求信息,再做后续处理。

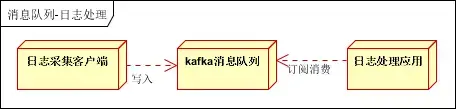

3、日志处理,推荐kafka

日志处理是指将消息队列用在日志处理中,比如Kafka的应用,解决大量日志传输的问题。架构简化如下:

日志采集客户端,负责日志数据采集,定时写受写入Kafka队列;Kafka消息队列,负责日志数据的接收,存储和转发;日志处理应用:订阅并消费kafka队列中的日志数据。

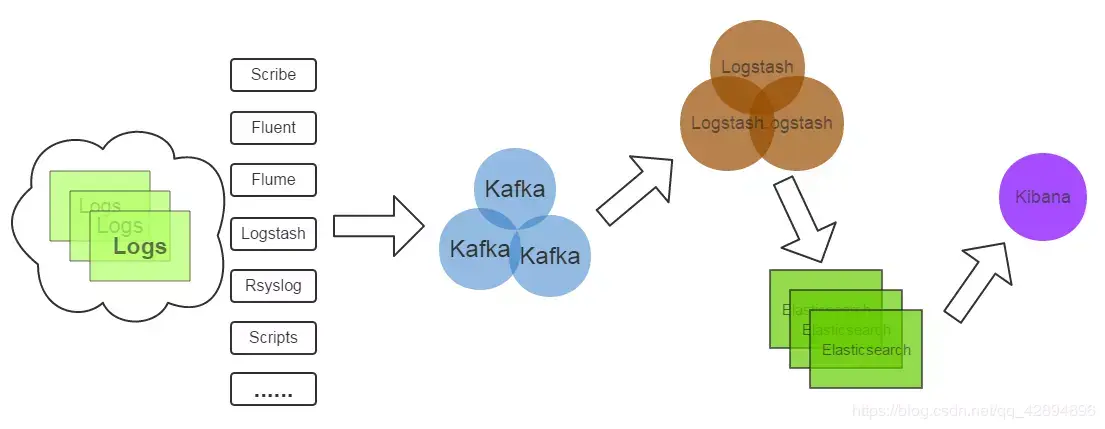

以下是新浪kafka日志处理应用案例:

- Kafka:接收用户日志的消息队列;

- Logstash:做日志解析,统一成JSON输出给Elasticsearch;

- Elasticsearch:实时日志分析服务的核心技术,一个schemaless,实时的数据存储服务,通过index组织数据,兼具强大的搜索和统计功能;

- Kibana:基于Elasticsearch的数据可视化组件,超强的数据可视化能力是众多公司选择ELK stack的重要原因。

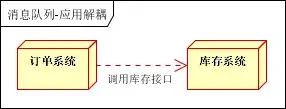

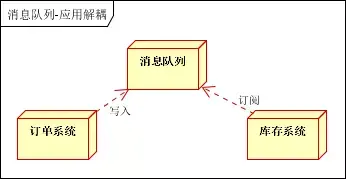

4、应用解耦

场景说明:用户下单后,订单系统需要通知库存系统。传统的做法是,订单系统调用库存系统的接口。如下图:

传统模式的缺点:

假如库存系统无法访问,则订单减库存将失败,从而导致订单失败,订单系统与库存系统耦合。

如何解决以上问题呢?引入应用消息队列后的方案,如下图:

订单系统:用户下单后,订单系统完成持久化处理,将消息写入消息队列,返回用户订单下单成功

库存系统:订阅下单的消息,采用拉/推的方式,获取下单信息,库存系统根据下单信息,进行库存操作

假如:在下单时库存系统不能正常使用。也不影响正常下单,因为下单后,订单系统写入消息队列就不再关心其他的后续操作了。实现订单系统与库存系统的应用解耦

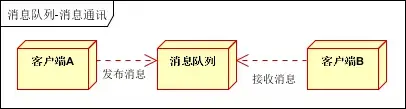

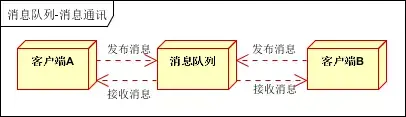

5、消息通讯

消息通讯是指,消息队列一般都内置了高效的通信机制,因此也可以用在纯的消息通讯。比如实现点对点消息队列,或者聊天室等。

点对点通讯:

客户端A和客户端B使用同一队列,进行消息通讯。

聊天室通讯:

客户端A,客户端B,客户端N订阅同一主题,进行消息发布和接收。实现类似聊天室效果。

三、衡量指标

我们从服务性能、数据存储、集群结构三个方面去对比,选择适合自己项目的消息中间件

1、ActiveMQ

特点:

早期主流的消息中间件,包括ZeroMQ,但是这几年使用的很少了,主要在长期维护的项目中使用。API丰富,本身很成熟但是在高并发、大数据

环境下的性能不够出色,主要试用于中小型项目,有较低的概率丢失数据,最主要是的,官方现在维护的频率一直在降低,好几个月才发布一个版本。

架构:

- Master-Slave模式,通过Zookeeper实现节点切换和故障转移

- NetWork模式,相当于多套Master-Slave模式,通过NetWork网关进行集成

2、kafka

特点:

基于pull模式来处理消息消费,追求高吞吐量,开始的目的是日志采集和传输,0.8版本开始支持复制,不支持事务,对消息的重复、丢失

、错误没有严格要求,适合大数据服务的数据计算、日志采集业务

topic数量从几十到几百的时候,吞吐量会大幅度下降,本身支持的功能比较简单,可能有消息重复消费

集群:

通过zookeeper集群管理多个kafka节点,节点之间相互replication

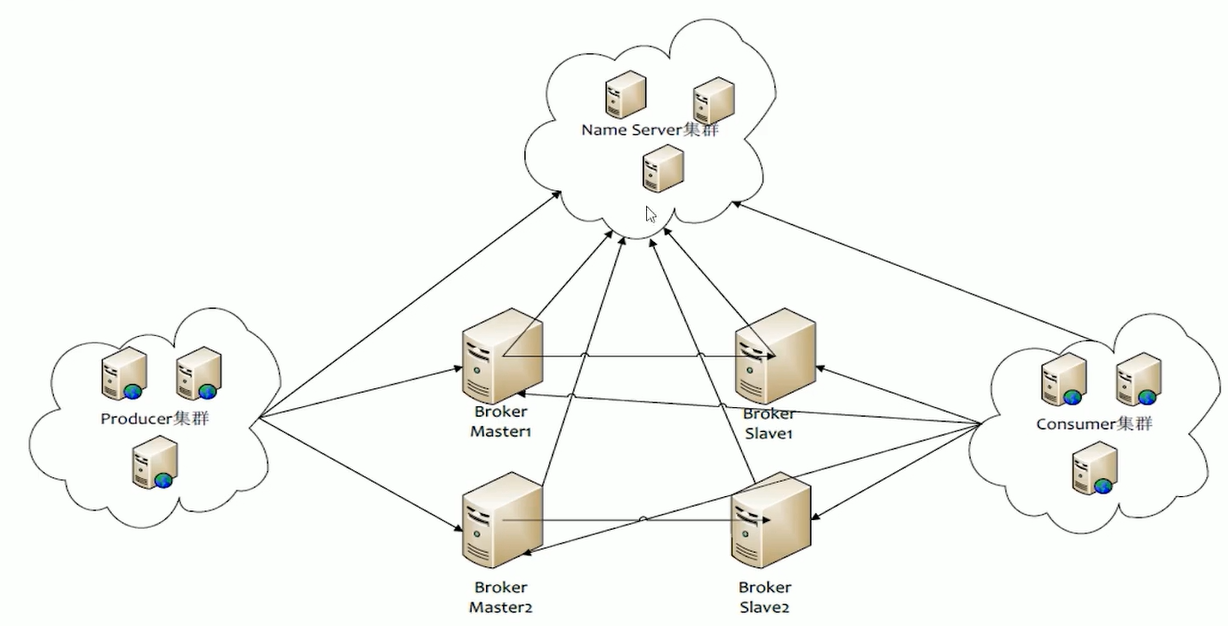

3、RocketMQ

特点:

纯Java开发,具备高吞吐量(10W级别)、高可用性、适合大规模分布式系统应用的特点。思路起源于kafka,对事务的可靠性传递和事务性

进行优化,在阿里巴巴广泛应用于交易、充值、流计算、消息推送、日志流式处理、binglog分发等场景,但是商业版收费

MQ功能较为完善,拓展性好,因为是分布式的,接口简易,支持复杂的MQ业务场景,本身是阿里出品,品质有所保障

社区维护一般,没有特别活跃,而且万一像之前的Dubbo一样,没人维护了,就凉了(Dubbo现在已经重新维护,接连发布很多版本)

集群:

master-slave、2M-2S、多主多从等

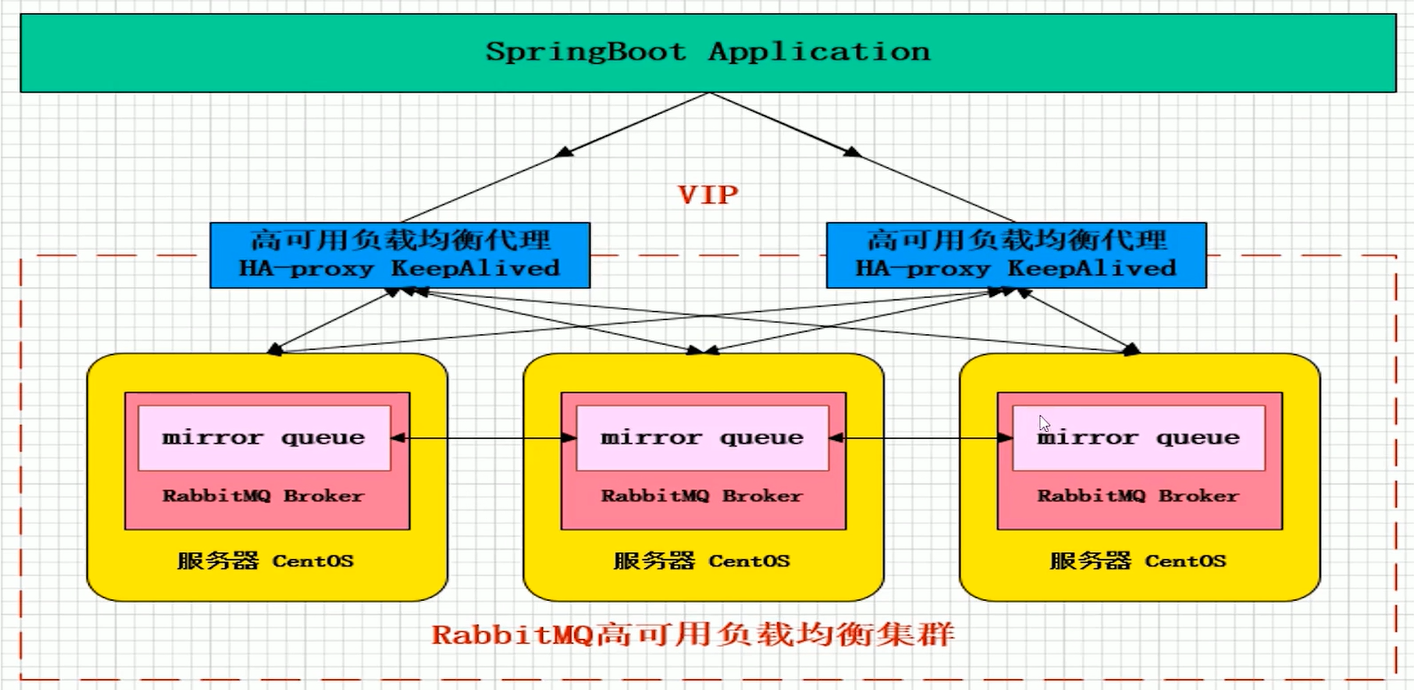

4、RabbitMQ

特点:

开源的消息代理和队列服务器,在普通协议在不同的应用之间共享数据,使用Erlang编写(Erlang进行数据交换的性能很好,和原生socket

一样好的延迟响应效果),遵守AMQP协议,AMQP主要特征是面向消息、队列、路由(点对点的发布/订阅)、可靠性、安全。适合对数据一致性、

稳定性(100%消息投递)和可靠性要求很高的场景,对性能和吞吐量的要求其次。

优点:

能达到几万级别的吞吐量(和具体的机器配置有关),但是相比kafka和RocketMQ差了不少,因为采用Erlang,时延性是微秒级别,

最重要的是有专门的可视化界面,很方便进行管理,社区非常活跃,功能很完备

缺点:

吞吐量的问题,因为是Erlang语言开发,很难去查看源码。如果存在什么问题,只能等官方去解决,对其掌控度很低,但是社区活跃

度很高,这个影响也不大的

综上:

- ActiveMQ 的社区算是比较成熟,但是较目前来说,ActiveMQ 的性能比较差,而且版本迭代很慢,不推荐使用。

- RabbitMQ 在吞吐量方面虽然稍逊于 Kafka 和 RocketMQ ,但是由于它基于 erlang 开发,所以并发能力很强,性能极其好,延时很低,达到微秒级。但是也因为 RabbitMQ 基于 erlang 开发,所以国内很少有公司有实力做erlang源码级别的研究和定制。如果业务场景对并发量要求不是太高(十万级、百万级),那这四种消息队列中,RabbitMQ 一定是你的首选。如果是大数据领域的实时计算、日志采集等场景,用 Kafka 是业内标准的,绝对没问题,社区活跃度很高,绝对不会黄,何况几乎是全世界这个领域的事实性规范。

- RocketMQ 阿里出品,Java 系开源项目,源代码我们可以直接阅读,然后可以定制自己公司的MQ,并且RocketMQ 有阿里巴巴的实际业务场景的实战考验。RocketMQ 社区活跃度相对较为一般,不过也还可以,文档相对来说简单一些,然后接口这块不是按照标准 JMS 规范走的有些系统要迁移需要修改大量代码

- kafka 的特点其实很明显,就是仅仅提供较少的核心功能,但是提供超高的吞吐量,ms 级的延迟,极高的可用性以及可靠性,而且分布式可以任意扩展。同时 kafka 最好是支撑较少的 topic 数量即可,保证其超高吞吐量。kafka 唯一的一点劣势是有可能消息重复消费,那么对数据准确性会造成极其轻微的影响,在大数据领域中以及日志采集中,这点轻微影响可以忽略这个特性天然适合大数据实时计算以及日志收集。

四、使用消息队列带来的问题

- 系统可用性降低: 系统可用性在某种程度上降低,为什么这样说呢?在加入MQ之前,你不用考虑消息丢失或者说MQ挂掉等等的情况,但是,引入MQ之后你就需要去考虑这些问题

- 系统复杂性提高: 加入MQ之后,你需要保证消息没有被重复消费、处理消息丢失的情况、保证消息传递的顺序性等等问题!

- 一致性问题: 我上面讲了消息队列可以实现异步,消息队列带来的异步确实可以提高系统响应速度。但是,万一消息的真正消费者并没有正确消费消息怎么办?这样就会导致数据不一致的情况了!

参考详见:

浙公网安备 33010602011771号

浙公网安备 33010602011771号