Inception

Inception v1

动机:

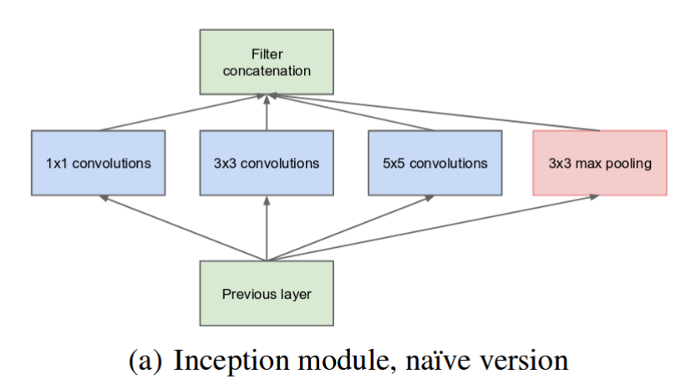

目标不同图像中存在较大的尺度变化。

大的核能看到全局,小的能看到部分,能不能在同一个level存在多个尺度的卷积核???因此作者开始搞更wider的网络

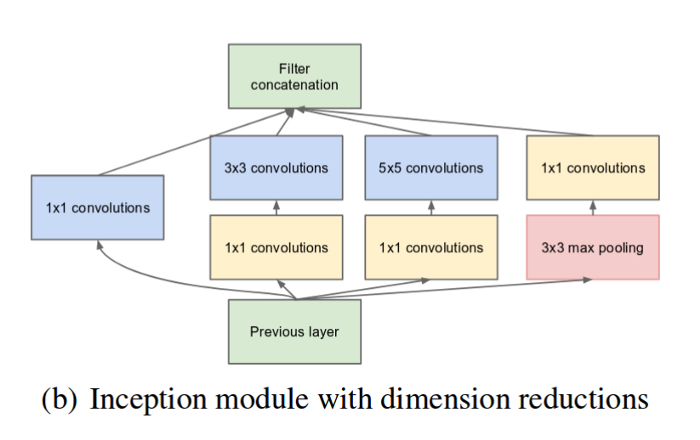

除此之外,作者还在池化之后用1*1的核来降低输入的维度,削减计算量

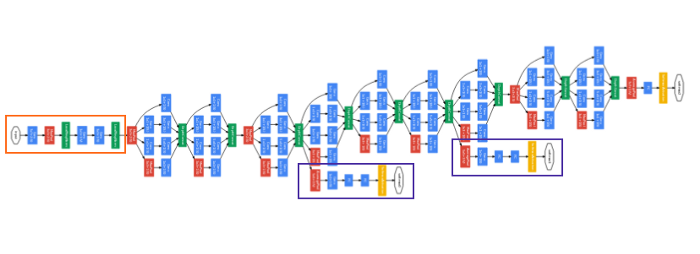

网络深了就难免梯度消失,中间神经元死掉的问题,因此作者采取了中间监督的策略(此时还没有大神的resnet)

total_loss = real_loss + 0.3 * aux_loss_1 + 0.3 * aux_loss_2

Inception v2 and Inception v3.---- one paper

动机:

- 减少表示瓶颈

经验表明,网络没如果在某地方维度下降太快,可能会导致表示瓶颈,即信息丢失。因此我们希望网络的维度变化能更缓和 - 降低计算量

做法:

-

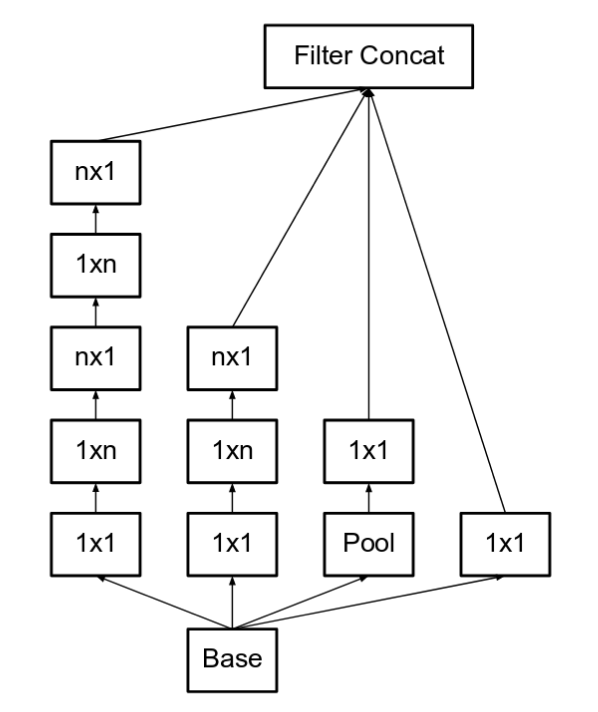

将 5x5 用两个 3x3 代替

-

将 nxn 用 1xn+nx1 代替

Inception v3

作者证明了中间监督附加件仅仅在模型快收敛的时候才起作用,起到正则化的作用,尤其是其中包含BN层时;然后探讨了不大改V2模型的前提下提升效果的可能性

RMSProp Optimizer.

Factorized 7x7 convolutions.

BatchNorm in the Auxillary Classifiers.

Label Smoothing (A type of regularizing component added to the loss formula that prevents the network from becoming too confident about a class. Prevents over fitting).

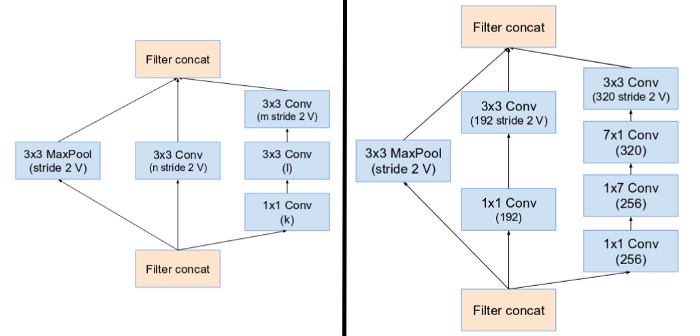

Inception v4 and Inception-ResNet---- one paper

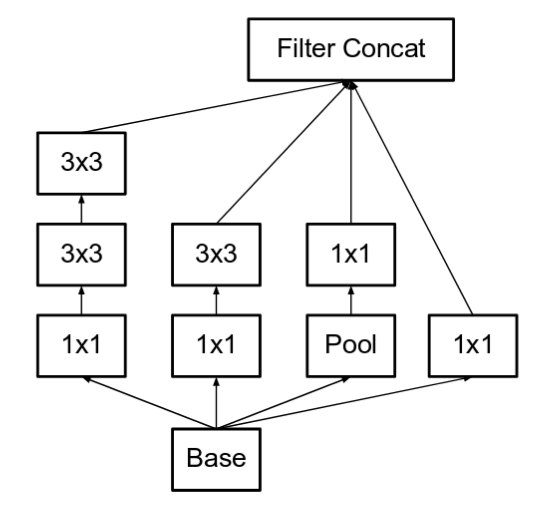

Inception v4

显式的加入了降维块

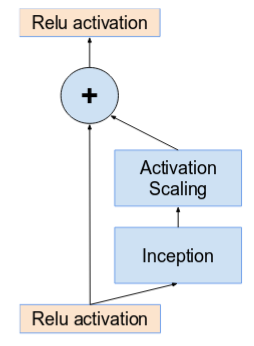

Inception-ResNet

如果过滤器的数量超过1000,则较深的网络会导致“死亡”。因此,为了提高稳定性,作者将残差的激活值的范围限定到0.1~0.3。

浙公网安备 33010602011771号

浙公网安备 33010602011771号