MacOS 本地部署 Ollama

什么是 Ollama?

Ollama 是一款开源工具,能够帮助非技术用户以最便捷的方式在本地运行大语言模型(Large Language Model, LLM)。它具有系统资源占用少、API 设计简洁易用的优点。此外,Ollama 官方还提供了一系列预训练好的大模型,这些模型已进行适当量化,用户可直接下载并使用。

Ollama 本地部署

首先进入这个网站下载并安装 Ollama 应用:

https://ollama.com/download

在完成 Ollama 应用的安装之后应该显示这样一个软件界面:

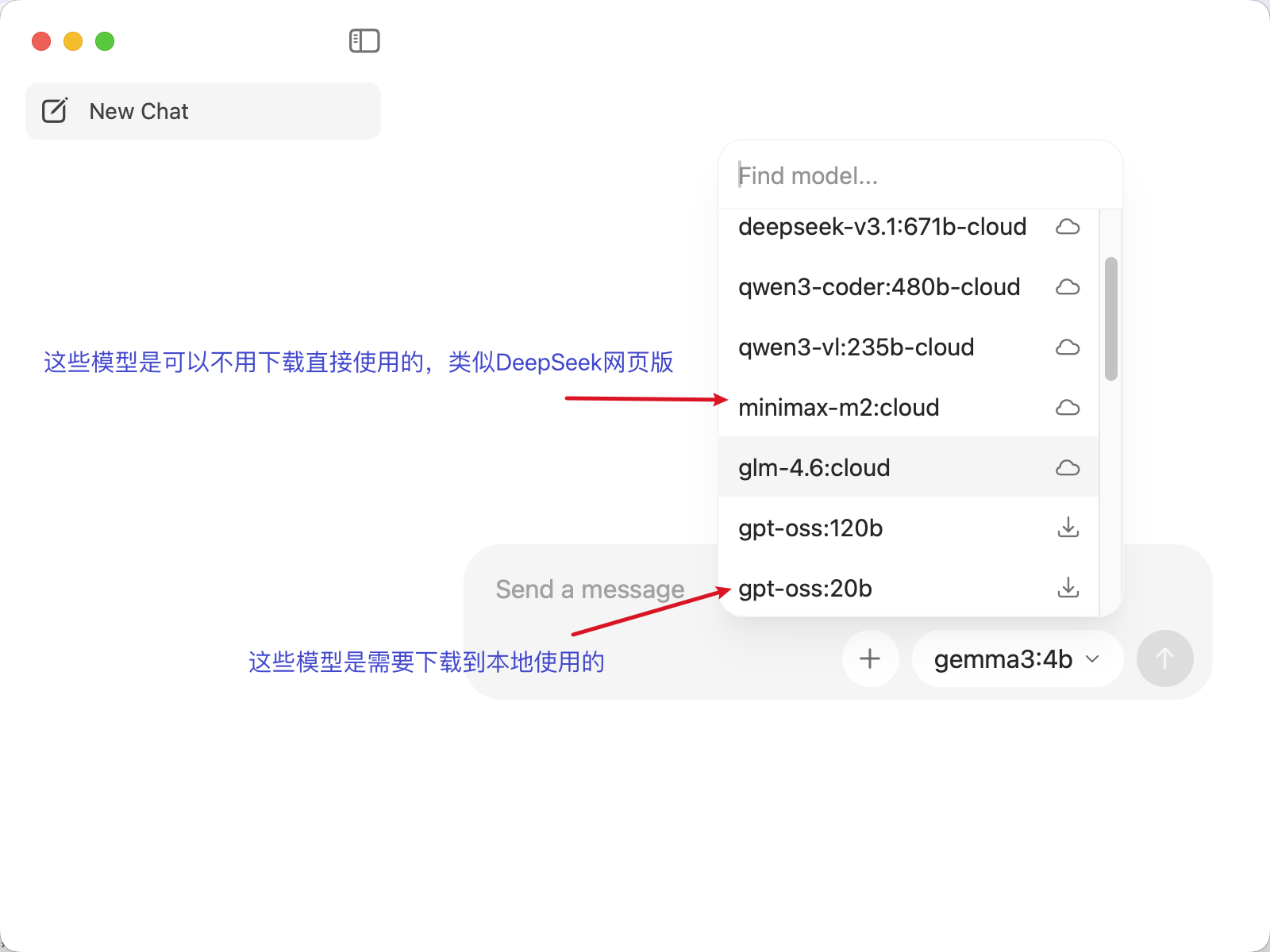

既然是本地部署,我们就以一个小模型 gemma3:1b 为例,简单的演示如何使用:

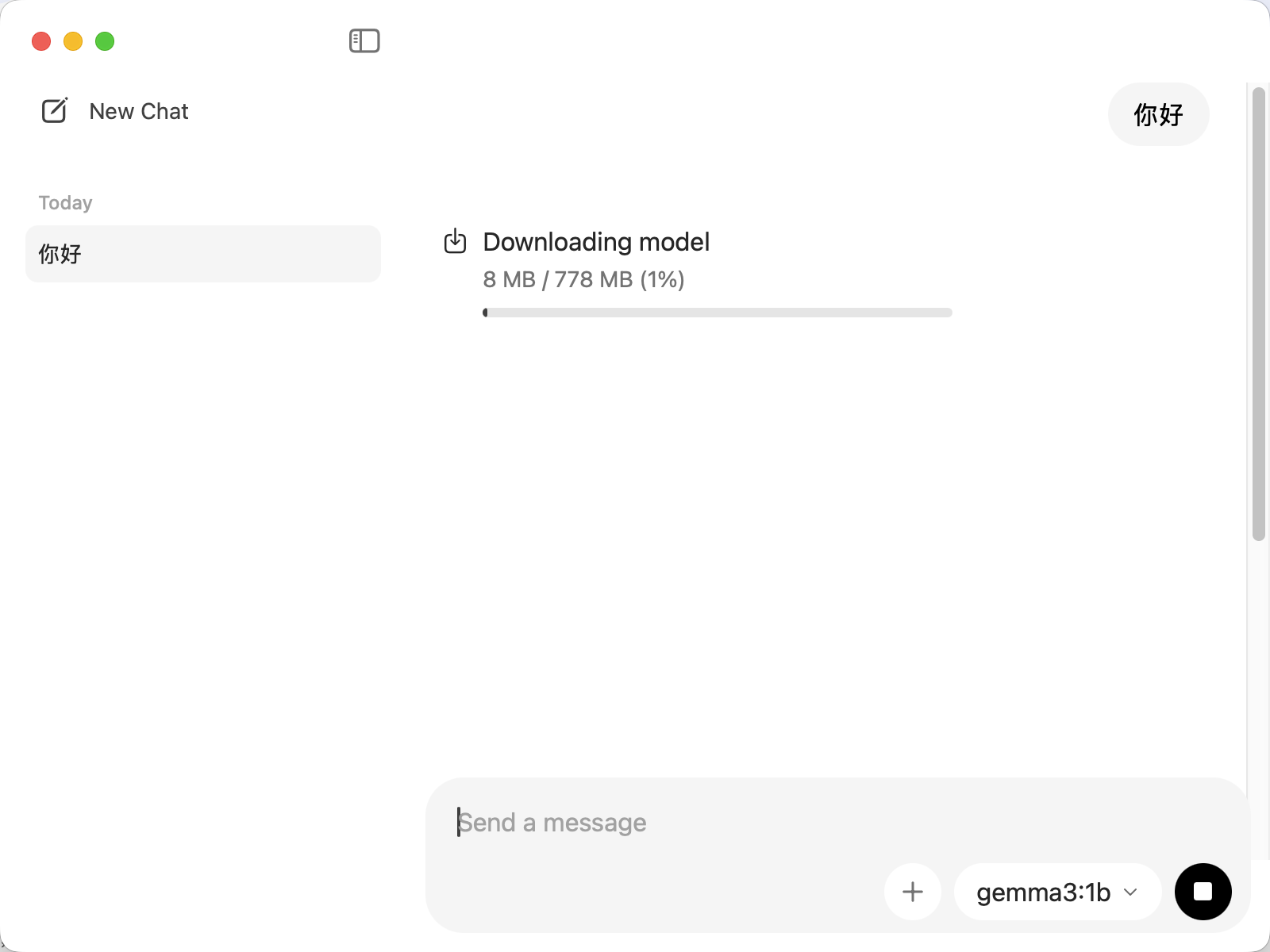

在第一个使用模型时,会先下载模型权重,在完成模型的下载之后就可以进行模型的使用了。

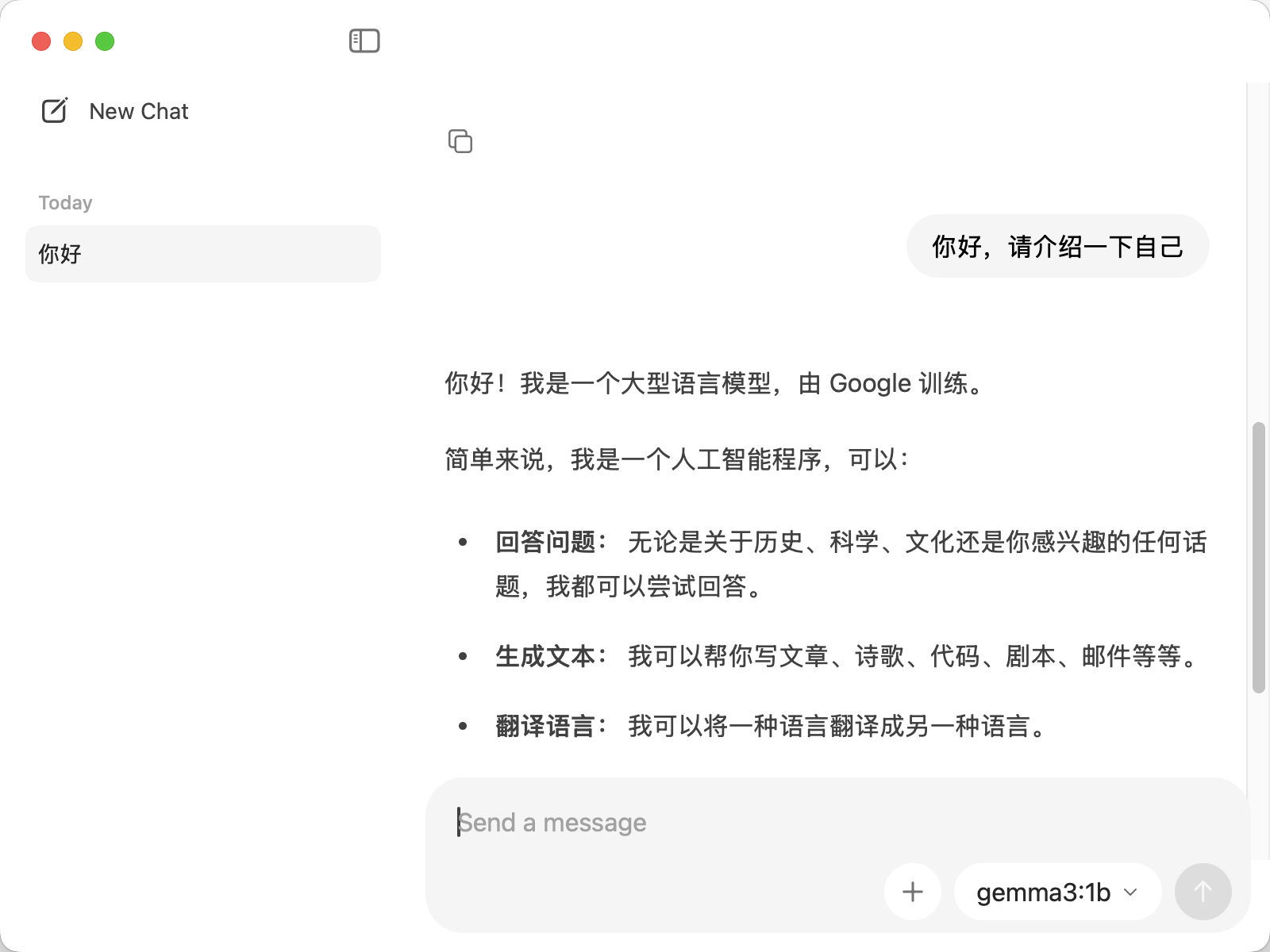

对于这种小参数量的模型来说,输出速度还是非常快的,可以帮助处理一些简单任务,比如文字排版、文本分类或者翻译等。

下一篇文章我将介绍如何使用 LLaMA-Factory 进行模型微调。

浙公网安备 33010602011771号

浙公网安备 33010602011771号