Optimizing Federated Learning on Non-IID Data with Reinforcement Learning

Optimizing Federated Learning on Non-IID Data with Reinforcement Learning

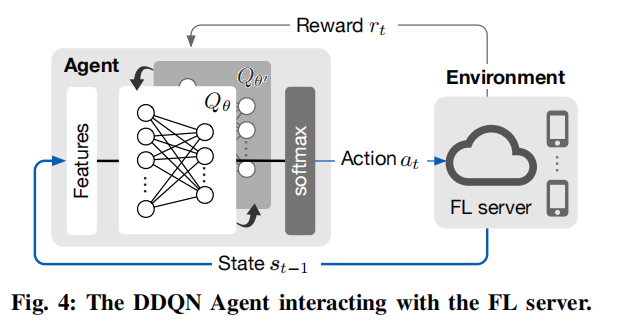

这张示意图和对应的文字描述了一个 双深度Q学习网络(Double DQN, DDQN) 智能体如何与 联邦学习(FL)服务器 交互。以下是详细解读:

图中主要组件:

-

智能体(Agent):

- 智能体负责根据当前状态选择行动(Action)。它利用一个双深度Q学习网络(DDQN)计算 Q 值(Q-value),这些值代表每个可能行动的预期回报。

- 它的输入是当前的“状态”(\(s_{t-1}\)),通过 DDQN 神经网络处理后输出各行动的概率分布(通过 softmax 层)。

-

环境(FL 服务器):

- FL 服务器充当智能体的环境。当智能体选择了一个行动(\(a_t\),即选择了某些设备)后,服务器基于这些设备的训练效果返回一个奖励(\(r_t\))。

-

状态转移:

- 智能体与 FL 服务器的交互导致状态转移,即状态从 \(s_{t-1}\)(当前状态)在执行行动 \(a_t\) 后转移到新的状态 \(s_t\)。

交互工作流程:

-

输入(状态):

- 智能体观察当前状态 \(s_{t-1}\),状态可能包括描述环境的特征(如设备性能、网络条件等)。

-

行动选择:

- 智能体利用 DDQN 计算所有可能行动的 Q 值。DDQN 由两个神经网络组成:

- 在线网络(\(\theta\)):评估当前 Q 值。

- 目标网络(\(\theta'\)):在固定的时间步(如 \(M\) 步)内保持不变,用于稳定 Q 值更新。

- 智能体基于 Q 值(如通过 \(\text{argmax}\) 或 softmax 分布)选择行动 \(a_t\)。

- 智能体利用 DDQN 计算所有可能行动的 Q 值。DDQN 由两个神经网络组成:

-

与环境交互:

- 智能体将选定的行动 \(a_t\) 发送至 FL 服务器。服务器基于这些设备执行联邦学习,并将奖励 \(r_t\) 返回给智能体。

-

学习与更新:

- 智能体在与环境交互后,收集一系列经验样本(\((s_t, a_t, r_t, s_{t+1})\)),并通过以下损失函数更新 DDQN 参数 \(\theta\):\[\mathcal{L}(\theta) = \left(Y_t^{\text{DoubleQ}} - Q(s_t, a_t; \theta)\right)^2 \]其中:\[Y_t^{\text{DoubleQ}} = r_t + \gamma Q(s_{t+1}, \arg\max_a Q(s_{t+1}, a; \theta); \theta') \]

- \(Y_t^{\text{DoubleQ}}\):目标 Q 值,结合即时奖励 \(r_t\) 和下一步最优 Q 值计算得出。

- \(\gamma\):折扣因子,用于权衡未来奖励的重要性。

- 智能体在与环境交互后,收集一系列经验样本(\((s_t, a_t, r_t, s_{t+1})\)),并通过以下损失函数更新 DDQN 参数 \(\theta\):

-

目标网络的作用:

- 目标网络(\(\theta'\))的参数更新较慢(每隔 \(M\) 步),从而保证目标值 \(Y_t^{\text{DoubleQ}}\) 的稳定性,减轻了传统 Q 学习中因快速变化引发的不稳定问题。

双深度Q学习(DDQN)的核心思想:

- DDQN 的创新点在于将 行动选择(通过在线网络 \(\theta\))与 目标值计算(通过目标网络 \(\theta'\))分离。这种分离显著减少了传统 Q 学习中因过高估计引发的不稳定性问题。

在联邦学习场景中使用 DDQN 的优势:

-

减少波动(jittering):

- 目标网络的引入使 Q 值的更新更加平稳,智能体的行为决策更稳定。

-

更精准的行动值评估:

- DDQN 提高了 Q 值的估计准确性,有助于智能体在动态联邦学习环境中做出更优决策。

总结:

这张图展示了 DDQN 智能体如何通过观察状态、选择行动、与 FL 服务器交互(获得奖励)以及学习更新 Q 值,不断优化其行动策略。DDQN 的稳定性和精准性使其在联邦学习这样复杂的动态环境中表现更优。

是的,这里的Agent并不是客户端本身,而是一个独立的智能体,它的主要功能是从全局的角度对客户端设备进行选择和分配。这点与通常联邦学习场景中客户端本身进行决策的情况有所不同。

以下是更详细的分析:

Agent的角色定位:

-

独立智能体:

- Agent 是一个位于联邦学习系统之上的智能决策层,它通过观察当前系统的状态(例如设备状态、网络条件等)来选择合适的客户端设备参与下一轮联邦训练。

- 它并不是某个具体的客户端设备,而是一个全局管理者,负责在系统级别优化联邦学习的资源分配和性能。

-

与客户端的关系:

- Agent 的行动(Action)是选择客户端设备参与训练。选择的结果会发送到联邦服务器,服务器据此协调设备的实际训练。

- 客户端设备在这一流程中是被动的,它们执行服务器的指令进行模型训练,而不直接与智能体交互。

智能体的核心任务:

-

优化客户端选择:

- 在联邦学习中,并非所有客户端设备都适合参与每一轮训练(例如,可能有设备性能低、网络条件差或者数据质量不佳的情况)。

- 智能体通过深度强化学习(使用DDQN)在所有可能的客户端组合中进行选择,最大化整体训练性能(例如更快的收敛速度、更高的准确性等)。

-

通过强化学习不断改进策略:

- 智能体通过与环境(FL服务器)交互获得奖励(例如某一轮联邦训练后的模型性能提升或计算延迟),并不断更新其决策策略。

- 这种强化学习方式使得智能体可以适应动态环境,例如客户端性能波动或数据分布的变化。

Agent并非客户端的原因:

-

从控制视角:

客户端只是系统中的执行单元,负责数据存储和模型训练。它们并不具备全局视角,也不会主动做出全局的资源分配决策。 -

从架构视角:

Agent 独立于客户端和服务器,是一个额外的逻辑层,类似于系统管理员,负责在整个客户端设备池中做出智能化选择。 -

从任务目标:

客户端的目标是本地优化(例如本地训练模型),而智能体的目标是全局优化(例如选择哪些客户端以提升整个联邦学习系统的表现)。

总结:

在这篇文章的设计中,Agent并不是客户端,而是一个独立的智能层,负责在联邦学习过程中选择设备并优化训练策略。它通过与FL服务器交互获得奖励,不断改进设备选择的质量,从而增强联邦学习的效率和效果。

在这个框架中,客户端的训练主要是通过与 联邦学习服务器(FL Server) 的交互来参与,客户端并不是直接与智能体(Agent)交互,而是通过服务器来间接协作。以下是具体的解读和客户端在这一框架中的角色:

客户端的参与方式:

-

客户端本地训练:

- 客户端接收到 FL 服务器的指令后,使用其本地数据进行模型训练。

- 每个客户端的训练过程是独立的,并且依赖于其本地的计算资源和数据分布。

-

上传模型更新:

- 客户端在完成本地训练后,会将本地模型的更新(例如,梯度或权重更新)上传给服务器,而不是上传其本地数据。这一过程保持了数据的隐私性。

-

服务器聚合模型:

- 服务器会基于客户端上传的更新进行聚合(例如,使用联邦平均算法FedAvg),并更新全局模型。

- 聚合后的全局模型再下发给客户端,用于下一轮训练。

客户端与智能体(Agent)的关系:

-

间接关系:

- 客户端并不直接与智能体交互,客户端只是执行服务器分配的任务(例如模型训练)。

- 智能体通过选择合适的客户端组合,间接影响客户端的参与。例如,某些客户端可能会被选中参与某一轮训练,而其他客户端则不会被选择。

-

信息传递链条:

- 客户端与智能体的交互是通过服务器实现的:

- 客户端 → 服务器:上传本地模型更新(例如,权重或梯度)。

- 服务器 → 智能体:提供客户端的状态信息(例如设备性能、计算能力、网络状况等),这些信息成为智能体的输入状态 \(s_t\) 的一部分。

- 智能体 → 服务器:根据状态选择客户端,并将选择结果反馈给服务器。

- 服务器 → 客户端:通知被选中的客户端参与下一轮训练。

- 客户端与智能体的交互是通过服务器实现的:

智能体如何利用客户端信息:

智能体通过服务器获取关于客户端的信息,这些信息被用作其决策的依据,具体包括:

-

客户端状态信息:

- 设备计算能力(如CPU/GPU性能)。

- 网络条件(如带宽、延迟)。

- 数据特征(如数据量、标签分布)。

-

全局环境信息:

- 当前全局模型的收敛情况。

- 已选择客户端的训练效果(如奖励 \(r_t\))。

这些信息构成智能体的状态 \(s_t\),智能体基于状态进行决策,选择最优的客户端组合参与训练。

客户端在这一框架中的角色总结:

-

主要任务:

- 客户端的主要职责是执行本地模型训练,并将模型更新上传至服务器。

- 客户端不参与决策,而是作为执行单元,根据服务器的指令完成训练任务。

-

通过服务器间接与智能体交互:

- 客户端将其训练数据的抽象信息(如性能指标)通过服务器传递给智能体。

- 智能体利用这些信息做出优化决策,选择哪些客户端参与训练。

-

客户端对整体框架的贡献:

- 客户端的本地训练结果和状态信息为整个联邦学习框架提供了基础数据,是智能体优化决策的核心依据。

总结:

在这个框架中,客户端通过与服务器交互参与联邦学习。智能体的任务是利用客户端提供的状态信息进行设备选择,并优化整体联邦学习的性能。客户端的角色是被动执行任务,而智能体则是负责全局优化的决策者。这种分工不仅保护了数据隐私,还通过智能体的强化学习决策提升了联邦学习的效率和效果。

Double DQN(DDQN)和单个 Q 函数(即传统 Q-learning)的损失计算的主要区别在于目标值的计算方式。让我们具体对比这两种方法的损失计算过程。

1. 单个 Q 函数(传统 Q-learning)

损失函数:

传统 Q-learning 的损失函数定义为:

\(

L(\theta) = \left( Y_t^{\text{Q}} - Q(s_t, a_t; \theta) \right)^2,

\)

其中:

\(

Y_t^{\text{Q}} = r_t + \gamma \max_a Q(s_{t+1}, a; \theta).

\)

目标值 $ Y_t^{\text{Q}} $ 的计算:

- 当前奖励 $ r_t $:代表即时回报。

- 折扣未来奖励 $ \gamma \max_a Q(s_{t+1}, a; \theta) $:未来奖励估计是通过直接选择 $ \max_a Q(s_{t+1}, a; \theta) $ 实现的,即:

- 使用 同一个网络 $ \theta $ 既选择下一步最优行动 $ a^* $,又计算该行动的 Q 值。

- 最终目标值:

\( Y_t^{\text{Q}} = r_t + \gamma \max_a Q(s_{t+1}, a; \theta). \)

问题:

- 单个 Q 函数使用同一个网络 $ \theta $ 来同时选择最优行动 $ \arg\max_a $ 和评估其 Q 值 $ Q $,这可能导致 过高估计问题。

- 过高估计发生在由于预测误差或噪声,导致选择的行动实际并不是最优的。

- 这种不稳定性会使得 Q 值学习发散或不准确。

2. 双 Q 函数(Double DQN, DDQN)

损失函数:

Double DQN 的损失函数也是基于目标值的平方误差:

\(

L(\theta) = \left( Y_t^{\text{DoubleQ}} - Q(s_t, a_t; \theta) \right)^2,

\)

其中:

\(

Y_t^{\text{DoubleQ}} = r_t + \gamma Q(s_{t+1}, \arg\max_a Q(s_{t+1}, a; \theta); \theta').

\)

目标值 $ Y_t^{\text{DoubleQ}} $ 的计算:

-

行动选择(使用在线网络 $ \theta $):

- 在线网络 $ \theta $ 用来选择下一步状态 $ s_{t+1} $ 中的最优行动:

\( a^* = \arg\max_a Q(s_{t+1}, a; \theta). \) - 仅负责选择,而不负责评估目标值。

- 在线网络 $ \theta $ 用来选择下一步状态 $ s_{t+1} $ 中的最优行动:

-

目标评估(使用目标网络 $ \theta' $):

- 使用目标网络 $ \theta' $ 来评估行动 $ a^* $ 的 Q 值:

\( Q(s_{t+1}, a^*; \theta'). \)

- 使用目标网络 $ \theta' $ 来评估行动 $ a^* $ 的 Q 值:

-

最终目标值:

\( Y_t^{\text{DoubleQ}} = r_t + \gamma Q(s_{t+1}, \arg\max_a Q(s_{t+1}, a; \theta); \theta'). \)

核心区别:

- 分离的选择与评估:

- 在线网络 $ \theta $ 负责选择下一步最优行动。

- 目标网络 $ \theta' $ 负责对选择的行动进行评估。

- 降低过高估计风险:

- 通过目标网络 $ \theta' $ 提供更稳定的目标 Q 值估计,减少了传统 Q-learning 中单网络同时选择和评估导致的过高估计问题。

对比总结:

| 特点 | 传统 Q-learning | Double DQN |

|---|---|---|

| 目标值计算 | $ Y_t^{\text{Q}} = r_t + \gamma \max_a Q(s_{t+1}, a; \theta) $ | $ Y_t^{\text{DoubleQ}} = r_t + \gamma Q(s_{t+1}, \arg\max_a Q(s_{t+1}, a; \theta); \theta') $ |

| 使用网络 | 单一网络 $ \theta $ | 两个网络:在线网络 $ \theta $ 和目标网络 $ \theta' $ |

| 行动选择和评估 | 同一个网络负责行动选择和评估 | 在线网络选择,目标网络评估 |

| 是否存在过高估计风险 | 较高 | 显著降低 |

| 稳定性 | 较差,可能发散 | 更高的稳定性 |

示例对比:

假设 $ Q(s_{t+1}, a; \theta) $ 的输出是:

- $ Q(s_{t+1}, a_1; \theta) = 5.0 $,

- $ Q(s_{t+1}, a_2; \theta) = 6.0 $,

- $ Q(s_{t+1}, a_3; \theta) = 5.5 $.

在传统 Q-learning 中:

- 直接选择 $ \max_a Q(s_{t+1}, a; \theta) $,即选择 $ a_2 \(,并用相同网络评估:

\)

Y_t^{\text{Q}} = r_t + \gamma Q(s_{t+1}, a_2; \theta) = r_t + \gamma \cdot 6.0.

$

在 Double DQN 中:

- 使用在线网络 $ \theta $ 选择最优行动:

\( a^* = \arg\max_a Q(s_{t+1}, a; \theta) = a_2. \) - 然后使用目标网络 $ \theta' $ 评估该行动的 Q 值,例如:

\( Q(s_{t+1}, a_2; \theta') = 5.8. \) - 最终目标值:

\( Y_t^{\text{DoubleQ}} = r_t + \gamma Q(s_{t+1}, a_2; \theta') = r_t + \gamma \cdot 5.8. \)

结论:

- 传统 Q-learning:直接使用同一个网络进行选择和评估,可能高估未来奖励。

- Double DQN:通过分离选择和评估,降低了过高估计的风险,提高了学习的稳定性和准确性,尤其在复杂环境中效果更好。

TrajFM: A Vehicle Trajectory Foundation Model for Region and Task Transferability

以下是论文中提到的公式的整理和简化,按顺序列出:

公式 1:空间模态的归一化坐标

其中 \(s_x = s_y = 4000\),UTM 是通用横轴墨卡托投影函数。

公式 2:轨迹点的嵌入向量

其中 \(e_i^s, e_i^t, e_i^p\) 分别是空间、时间和兴趣点 (POI) 模态的嵌入向量。

公式 3:可学习的时空旋转矩阵

其中:

公式 4:注意力机制的查询、键和值

公式 5:注意力层的隐藏状态

公式 6:点积计算的展开式

公式 7:层输出的归一化和前馈网络

公式 8:空间和时间模态的损失函数

空间模态损失:

时间模态损失:

公式 9:特殊标记的交叉熵损失

其中 \(r = 1\) 表示真实模态为特殊标记 \([e]\),否则 \(r = 0\)。

这些公式涵盖了论文中关键模块的数学定义与计算过程,包括轨迹点的嵌入、注意力机制、旋转矩阵以及损失函数。

在论文中,轨迹点的 \(x\) 和 \(y\) 的预测过程是在 4.2.4 Trajectory Modality Prediction 部分中实现的。以下是具体说明:

预测 \(x\) 和 \(y\) 的位置

-

模块位置:

轨迹点的空间模态预测是 STRFormer 模型的最后一步(轨迹模态预测模块)的一部分。这个模块的主要任务是对每个轨迹点的模态(包括空间模态)进行预测。 -

预测方法:

对于每个轨迹点 \(p_i\),其空间模态的预测通过一个线性投影层实现:\[\hat{x}_i, \hat{y}_i = \text{Linear}(z_i) \]其中 \(z_i\) 是通过 STRFormer 处理后的轨迹点的隐藏状态(latent vector)。线性投影的输出是两个值,分别表示轨迹点的预测 \(x\) 和 \(y\) 坐标。

-

归一化逆操作:

在预测的 \(x\) 和 \(y\) 坐标的基础上,通过反归一化操作将预测值转换回原始的地理坐标(经纬度):\[\text{lng}_i = \text{UTM}^{-1}(\hat{x}_i \cdot s_x + \text{UTM}(\text{lng}_{\text{cen}})) \]\[\text{lat}_i = \text{UTM}^{-1}(\hat{y}_i \cdot s_y + \text{UTM}(\text{lat}_{\text{cen}})) \] -

损失函数:

模型通过监督学习优化预测结果,损失函数为均方误差 (MSE),用于衡量预测值 \((\hat{x}_i, \hat{y}_i)\) 和真实值 \((x_i, y_i)\) 之间的差距:\[L_i^s = (\hat{x}_i - x_i)^2 + (\hat{y}_i - y_i)^2 \]

具体流程总结

- STRFormer 提取轨迹点的嵌入 \(z_i\)。

- 线性投影层从 \(z_i\) 输出预测的归一化坐标 \((\hat{x}_i, \hat{y}_i)\)。

- 通过逆归一化将预测值转换为原始地理坐标。

- 使用真实值和预测值计算损失,并优化模型。

模块功能

这部分模块的功能是让模型学会从输入的轨迹点特征中,准确预测轨迹点的空间坐标(经纬度),并将其应用于任务如轨迹补全或预测未来的轨迹点位置。

旋转矩阵的核心作用

论文中的旋转矩阵 $ R_{\Phi(x, y)} $ 是 时空关系建模 的核心组件,专注于捕获轨迹点之间的 相对空间关系 和 时空特性。它的设计灵感来自于时空注意力机制,通过引入旋转矩阵,增强模型对轨迹点的空间特性和区域迁移能力的理解。

以下是详细解释:

1. 什么是旋转矩阵?

旋转矩阵 $ R_{\Phi(x, y)} $ 是一种数学工具,用来对向量进行旋转或变换。论文中这个矩阵不是简单的几何旋转,而是通过可学习的 时空特征变换 提取轨迹点之间的相对关系。

在论文中,轨迹点 \(p_i\) 的空间坐标为 \((x_i, y_i)\)。旋转矩阵通过坐标的变换嵌入额外的频率特征,从而在注意力计算中引入时空相关性。

2. 公式具体含义

旋转矩阵的形式:

其中:

- $ \phi_k(x, y) $ 是由轨迹点的空间坐标 \((x, y)\) 计算得出的频率信息。

- $ \theta_k = 10000^{-2k/d} $ 是频率的缩放因子,类似于 Transformer 中的位置编码。

- $ d $ 是嵌入向量的维度。

这个矩阵用 \(\sin\) 和 \(\cos\) 函数构造,通过频率变换对轨迹点的时空特性进行编码。

3. 它的作用是什么?

旋转矩阵的主要作用是将轨迹点的空间坐标映射到频率空间,生成可用于注意力机制的 相对时空位置特征。它解决了以下问题:

1) 捕获轨迹点的相对关系

当两个轨迹点 \(p_i\) 和 \(p_j\) 相距很远时,它们的旋转矩阵差异较大,这种差异通过注意力机制体现在点间的相对重要性上。例如,点 \(p_i\) 和 \(p_j\) 在距离较近时会具有更高的相关性,而较远点的权重会被抑制。

2) 提高模型的区域迁移能力

旋转矩阵中的可学习部分 (\(\Phi(x, y)\)) 提取了轨迹点的相对时空信息,而不是绝对位置。这种相对信息能更好地适应不同区域的轨迹数据,因为相对关系是可迁移的,而绝对坐标可能因区域变化而失效。

3) 避免模型过拟合到特定区域

传统的绝对位置编码可能让模型对特定区域的数据分布产生依赖。引入旋转矩阵后,模型学习的是轨迹点之间的相对关系,而非具体的空间位置,从而具备更强的泛化能力。

4. 在注意力机制中的具体使用

论文将旋转矩阵应用于注意力机制的查询 (\(q\)) 和键 (\(k\)) 的生成中:

当计算轨迹点 \(p_i\) 和 \(p_j\) 的注意力权重时,会用到 \(q_i^\top \cdot k_j\),展开为:

- $ R_{\Phi(x_i, y_i) - \Phi(x_j, y_j)} $ 提取了 \(p_i\) 和 \(p_j\) 的相对空间信息。

- 权重计算会更关注两点的相对位置,而非具体坐标。

5. 直观理解

可以把 $ R_{\Phi(x, y)} $ 看作一个动态的位置编码器,它把轨迹点的坐标转换为包含时空关系的特征向量。在注意力机制中,这些向量用来衡量轨迹点之间的相关性。

例如:

- 对于一条轨迹 \(T = \{p_1, p_2, p_3\}\),旋转矩阵可以帮助模型捕获点 \(p_1\)-\(p_2\)、\(p_2\)-\(p_3\) 的相对距离和方向。

- 如果 \(p_1\) 和 \(p_3\) 的相对空间关系很大,模型会调整注意力权重,聚焦于更有意义的点。

6. 总结

旋转矩阵 $ R_{\Phi(x, y)} $ 是一种创新的位置编码方法,用来增强轨迹点之间的时空关系建模。它的主要作用是:

- 捕获点之间的相对空间关系。

- 提高模型的泛化能力和区域迁移性。

- 避免模型过度依赖绝对坐标。

在轨迹数据中,它帮助模型理解轨迹点的时空依赖性,使得模型能够更好地预测轨迹的动态行为。

论文中的旋转矩阵 $ R_{\Phi(x, y)} $ 的生成是通过一部分 神经网络 和一部分 直接计算 结合完成的。以下是具体分析:

1. 直接计算的部分

旋转矩阵的核心计算部分依赖于以下公式:

关键点:

- $ W_\Phi $ 是一个可学习的映射矩阵,由模型训练得到。

- $ x || y $ 表示将轨迹点的坐标 $ x $ 和 $ y $ 拼接成一个向量。

这个公式表示:

- 输入点的坐标 \((x, y)\) 被映射到一个向量 \(\Phi(x, y)\)。

- 这个映射是通过简单的线性变换完成的,所以对于每个点,这部分是 直接可计算的,只需要一个点的 \((x, y)\) 坐标。

之后,利用这个向量 \(\Phi(x, y)\) 生成旋转矩阵 $ R_{\Phi(x, y)} $:

其中:

- \(\phi_k\) 是从 \(\Phi(x, y)\) 得到的频率特征。

- \(\sin(\cdot)\) 和 \(\cos(\cdot)\) 是直接计算的数学函数。

所以:

- 旋转矩阵的生成过程是高度计算化的,只需要点的 \((x, y)\) 坐标和一个训练好的矩阵 $ W_\Phi $。

2. 神经网络的部分

虽然旋转矩阵本身的计算是基于直接公式的,但其中的关键组件 $ W_\Phi $ 是通过神经网络 训练得到 的。在训练过程中,模型通过优化轨迹任务(如轨迹预测)的损失函数,不断调整 $ W_\Phi $ 的参数。

具体流程:

- 输入数据: 将轨迹点的 \((x, y)\) 输入到公式中,得到 \(\Phi(x, y)\)。

- 生成旋转矩阵: 基于 \(\Phi(x, y)\) 的值,构造旋转矩阵 $ R_{\Phi(x, y)} $。

- 注意力计算: 使用旋转矩阵对查询 (\(q\)) 和键 (\(k\)) 向量进行变换,从而捕获点之间的相对关系。

- 优化过程: 通过任务损失函数(如轨迹预测误差)优化整个模型,包括 $ W_\Phi $ 的参数。

3. 是否可以直接对一个点进行转换计算?

是的,旋转矩阵的计算是直接的,以下是具体步骤:

- 将轨迹点的 \((x, y)\) 输入到线性变换 $ \Phi(x, y) = W_\Phi (x || y) $。

- 根据 \(\Phi(x, y)\) 的值,使用 \(\sin\) 和 \(\cos\) 函数生成矩阵 $ R_{\Phi(x, y)} $。

- 应用矩阵 $ R_{\Phi(x, y)} $ 到查询或键向量上,用于注意力计算。

前提:

- 需要训练好的 $ W_\Phi $。

- 这些操作在推理阶段不需要额外训练,仅需执行前向计算。

4. 为什么结合了神经网络和直接计算?

- 直接计算: 提高效率,适合在推理阶段快速生成旋转矩阵。

- 神经网络: 提供可学习的灵活性,能适应不同任务和数据分布。

这种设计让模型可以同时具备高效性和适应性,能够从不同区域的轨迹数据中学习相对时空关系。

总结

- 直接计算: 旋转矩阵的生成对每个点都是直接可计算的(公式依赖点的 \((x, y)\) 坐标)。

- 神经网络参与: 映射矩阵 $ W_\Phi $ 是可学习参数,由模型训练优化得到。

这意味着旋转矩阵的生成是一个轻量级操作,非常适合实时轨迹数据处理场景。

$ x || y $ 表示将轨迹点的坐标 $ x $ 和 $ y $ 拼接成一个向量。根据论文中的描述,这里的处理是针对单个轨迹点进行的,而不是对多个轨迹点的直接操作。

为什么是单个轨迹点?

-

公式背景:

- 在论文的 4.2.3 Learnable Spatio-Temporal Rotary Position Embedding (STRPE) 部分中,轨迹点的空间模态首先被嵌入到一个向量表示。

- $ x || y $ 拼接的目的是生成单个轨迹点的时空表示,用于构造旋转矩阵 $ R_{\Phi(x, y)} $。

-

处理粒度:

- 每个轨迹点 $ p_i = (x_i, y_i) $ 都需要单独计算旋转矩阵 $ R_{\Phi(x_i, y_i)} $。

- 这个矩阵用于点 $ p_i $ 的查询 (\(q_i\)) 和键 (\(k_i\)) 生成,进而通过注意力机制计算点之间的相关性。

多个轨迹点如何关联?

虽然拼接 $ x || y $ 是针对单个轨迹点的,但多个轨迹点的旋转矩阵在注意力机制中会一起参与运算,从而捕获点之间的关系。具体来说:

-

每个点的旋转矩阵:

对于一条轨迹 $ T = {p_1, p_2, \ldots, p_n} $,每个点 $ p_i $ 都会单独计算旋转矩阵 $ R_{\Phi(x_i, y_i)} $。 -

点间关联:

在注意力机制中,轨迹点之间的关系通过以下公式捕获:\[q_i^\top \cdot k_j = e_i^\top W_q^\top R_{\Phi(x_i, y_i) - \Phi(x_j, y_j)} W_k e_j \]这里的 $ R_{\Phi(x_i, y_i) - \Phi(x_j, y_j)} $ 反映了点 $ p_i $ 和点 $ p_j $ 的相对关系。

总结

- 对单个点: $ x || y $ 表示拼接单个轨迹点的坐标,生成该点的旋转矩阵。

- 对多个点: 每个点的旋转矩阵参与注意力机制,点与点之间的关系通过旋转矩阵差异捕获。

这种设计实现了对单点特性和多点关系的双重建模,非常适合处理轨迹数据的时空依赖性。

每个点都有一个旋转矩阵 \(R_{\Phi(x, y)}\),这些矩阵的作用贯穿于注意力机制的计算过程,用于捕获轨迹点之间的时空关系。以下是旋转矩阵在模型后续流程中的具体用途和计算细节:

1. 旋转矩阵在注意力机制中的作用

旋转矩阵 \(R_{\Phi(x, y)}\) 的核心作用是对轨迹点的嵌入向量进行变换,使模型能够捕获点与点之间的 相对空间和时间信息。

查询(Query)、键(Key)、值(Value)的生成

对于轨迹点 \(p_i = (x_i, y_i)\),通过旋转矩阵生成其注意力机制所需的查询、键和值向量:

- \(e_i\):轨迹点的嵌入向量(经过轨迹模态混合后生成)。

- \(W_q, W_k, W_v\):可学习的线性投影矩阵,用于生成 \(q\)、\(k\)、\(v\)。

- \(R_{\Phi(x, y)}\):通过旋转矩阵对 \(q\) 和 \(k\) 的生成进行调整,加入相对位置信息。

注意力权重的计算

注意力权重通过查询 (\(q_i\)) 和键 (\(k_j\)) 的点积计算得到:

- 查询和键的点积会用到旋转矩阵的差异:\[q_i^\top k_j = e_i^\top W_q^\top R_{\Phi(x_i, y_i) - \Phi(x_j, y_j)} W_k e_j \]

- \(R_{\Phi(x_i, y_i) - \Phi(x_j, y_j)}\) 提取了轨迹点 \(p_i\) 和 \(p_j\) 之间的相对时空关系。

2. 隐藏状态的更新

注意力权重用来加权值向量 \(v_j\),计算点 \(p_i\) 的隐藏状态 \(h_i\):

- 隐藏状态 \(h_i\) 是轨迹点 \(p_i\) 的全局表示,融合了所有轨迹点的信息,同时保留了相对空间位置的影响。

3. 旋转矩阵在多层 Transformer 中的作用

层间关联

旋转矩阵 \(R_{\Phi(x, y)}\) 不仅用于一个注意力层,而是贯穿整个多层 Transformer 的过程:

- 每一层的输出 \(h_i'\) 是通过以下公式更新的:\[h_i' = \text{LayerNorm}(\text{FFN}(\text{LayerNorm}(h_i + e_i)) + h_i) \]

- 在下一层中,\(h_i'\) 被重新用作查询、键和值生成的输入,继续捕获更复杂的点间关系。

跨层不共享参数

每层的旋转矩阵计算会引入不同的参数(例如不同的 \(W_\Phi\) 和权重矩阵),进一步增强模型对轨迹点时空关系的建模能力。

4. 输出层:轨迹模态预测

经过多层 Transformer 后,轨迹点的隐藏状态 \(z_i\) 被用于预测各模态(如空间坐标、时间特性):

- 空间模态预测:\[(\hat{x}_i, \hat{y}_i) = \text{Linear}(z_i) \]

- 时间模态预测:\[\hat{t}_i = \text{Linear}(z_i) \]

这些预测值与真实值计算损失(如均方误差 MSE),指导模型优化。

5. 旋转矩阵的最终作用总结

-

捕获点间的相对时空关系:

\(R_{\Phi(x, y)}\) 提取了轨迹点之间的相对空间位置和时间特性,不依赖绝对坐标。 -

增强注意力机制:

将点间关系编码进注意力机制的查询 (\(q\)) 和键 (\(k\)) 中,调整注意力权重。 -

提高区域迁移能力:

相对关系具有区域不变性,旋转矩阵帮助模型泛化到不同地理区域。

6. 具体流程概述

- 单点旋转矩阵生成:

对每个点计算 \(R_{\Phi(x, y)}\),用来生成查询、键。 - 点间相对关系建模:

注意力机制通过旋转矩阵的差值捕获点间时空相关性。 - 轨迹特征融合:

通过多层 Transformer,将所有点的时空特性融合成全局表征。 - 模态预测:

最终用于任务(如轨迹预测、时间估算)中的模态输出。

旋转矩阵的引入让模型能够高效地建模轨迹点之间的动态关系,既捕获了单点特性,又处理了全局轨迹结构。

Trajectory Anomaly Detection with Language Models

是的,文章中的条件概率 \(P(l_i \mid l_{<i})\) 是由一个神经网络模型通过学习生成的。这是一个自回归生成模型,利用轨迹的历史上下文信息来预测下一个位置点的概率分布。

以下是条件概率 \(P(l_i \mid l_{<i})\) 的计算过程和实现细节:

1. 条件概率的定义

条件概率 \(P(l_i \mid l_{<i})\) 表示在已知历史轨迹点 \(l_{<i}\) 的情况下,当前位置 \(l_i\) 的概率。具体来说:

- 模型学习整个轨迹的概率分布:\[P(T) = P(l_1) \cdot P(l_2 \mid l_1) \cdot P(l_3 \mid l_1, l_2) \cdots P(l_i \mid l_{<i}) \]

- 目标是最大化所有轨迹点的条件概率,反映模型对轨迹生成规律的掌握程度。

2. 条件概率的计算过程

神经网络(基于 Transformer)是用来学习 \(P(l_i \mid l_{<i})\) 的核心工具,以下是主要计算步骤:

2.1 输入编码:嵌入层

- 每个轨迹点 \(l_i\) 表示为一个离散或连续值(如 GPS 坐标、兴趣点编号、活动标签等)。

- 使用嵌入层将轨迹点映射为高维向量:\[e_i = \text{Embedding}(l_i) \]

- 对离散值(如编号、网格索引):使用嵌入矩阵。

- 对连续值(如 GPS 坐标):可以先归一化,再投影到高维空间。

2.2 位置编码:顺序信息

- 为了保留轨迹点的顺序信息,模型使用位置嵌入(Positional Embedding):\[e_i^{\text{pos}} = e_i + \text{PosEmbedding}(i) \]

- \(e_i\):轨迹点的嵌入向量。

- \(\text{PosEmbedding}(i)\):第 \(i\) 个位置的嵌入,通常使用正弦和余弦函数生成。

2.3 条件建模:Transformer 的自回归机制

- 输入所有轨迹点的嵌入序列 $ {e_1^{\text{pos}}, e_2^{\text{pos}}, \ldots, e_{i-1}^{\text{pos}}} $。

- 使用 Transformer 模型捕获轨迹点间的依赖关系:

- 查询 (Query):当前轨迹点的嵌入 \(Q = e_i^{\text{pos}}\)。

- 键 (Key) 和 值 (Value):历史轨迹点的嵌入 \(\{e_1^{\text{pos}}, \ldots, e_{i-1}^{\text{pos}}\}\)。

- 计算注意力权重:\[\text{Attention}(Q, K, V) = \text{softmax}\left(\frac{Q K^\top}{\sqrt{d_k}}\right)V \]

- 通过多头注意力机制聚合历史信息,生成当前点的上下文表示。

2.4 条件概率预测

- Transformer 的输出是一个上下文向量 \(c_i\),表示 \(l_{<i}\) 的上下文信息。

- 使用线性变换和 Softmax 函数生成当前点的条件概率分布:\[P(l_i \mid l_{<i}) = \text{Softmax}(W \cdot c_i + b) \]

- \(W\):投影矩阵。

- \(b\):偏置向量。

- 输出是一个多分类概率分布(离散值)或概率密度函数(连续值)。

3. 通过神经网络学习条件概率

训练目标

模型通过最大化对数似然估计来学习条件概率:

- \(\theta\):模型参数(包括嵌入矩阵、投影矩阵和 Transformer 权重)。

- 训练过程优化 \(P(l_i \mid l_{<i})\) 的准确性,使得模型能够更好地预测轨迹点的概率分布。

训练数据

- 输入:轨迹数据集 \(D = \{T_1, T_2, \ldots, T_m\}\)。

- 每条轨迹分解为多个条件概率训练样本 \((l_i, l_{<i})\)。

优化方法

- 损失函数:对数似然损失函数(或交叉熵损失)。

- 优化器:通常使用 Adam 优化器。

4. 条件概率的作用总结

- 核心目标: 模型通过神经网络学习 \(P(l_i \mid l_{<i})\),并将其作为基础,用于轨迹生成、预测和异常检测。

- 在生成模型中的作用:

- 生成轨迹: 从初始点开始,逐点预测下一点。

- 预测下一点: 给定历史轨迹,预测下一个轨迹点的分布。

- 在异常检测中的作用:

- 困惑度: 基于条件概率 \(P(l_i \mid l_{<i})\) 评估轨迹的生成难度。

- 定位异常点: 条件概率低的点 \(l_i\) 被认为是异常点。

5. 条件概率与模型的关系

条件概率 \(P(l_i \mid l_{<i})\) 是模型的输出,是整个轨迹生成和异常检测的基础。它通过 Transformer 模型和自回归生成机制学习,结合了轨迹点的嵌入、顺序信息以及轨迹点间的依赖关系。

Online Anomalous Subtrajectory Detection on Road Networks with Deep Reinforcement Learning

你的理解是正确的,这篇论文确实将整条轨迹拆分成多个子轨迹,然后逐段地判断每个子轨迹的状态,最终输出一个标签来表示该子轨迹的异常与否。这种逐段处理和标签预测的方法将轨迹异常检测分解成了多个局部决策,而整体结果是这些决策的累积。

全局和局部的关系

1. 全局的含义

在这里,全局指的是对整条轨迹的异常性进行评价,但它是通过逐段检测的子轨迹状态累积得到的结果。

- 全局奖励 \(r^{\text{global}}\):衡量当前决策(所有子轨迹的标签预测)是否提升了整个模型对轨迹异常的检测能力。

- 如果所有的子轨迹状态预测(标签)更加符合真实轨迹分布,则全局奖励更高,反之则更低。

2. 局部的含义

局部指的是针对单个子轨迹(或单个道路段)进行状态评估和动作选择。每个子轨迹都有自己的状态表示,模型为每个子轨迹单独做决策。

- 局部奖励 \(r^{\text{local}}\):鼓励标签在局部连续(减少频繁的标签切换)。

- 每个局部动作(例如将一个子轨迹标记为异常或正常)都会影响最终的全局评价。

轨迹分解与状态标签的过程

1. 轨迹分解

轨迹被逐段处理,每个道路段(或子轨迹)被看作一个独立的单元。例如:

- \(T = \langle e_1, e_2, e_3, e_4, e_5 \rangle\)

- 每个 \(e_i\) 是一段道路。

- 子轨迹可以是简单的单段 \(e_i\) 或者两段连接 \(\langle e_i, e_{i+1} \rangle\)。

2. 状态构建

每个子轨迹(或道路段)对应一个状态 \(s_i\),它的定义为:

- \(z_i\):RSRNet 提取的当前道路段的特征嵌入。

- \(v(e_{i-1}.l)\):前一段道路的标签,用于表示局部历史。

3. 动作选择

针对每个状态 \(s_i\),ASDNet 通过策略网络选择一个动作 \(a_i\):

- \(a_i = 0\):当前子轨迹标记为正常。

- \(a_i = 1\):当前子轨迹标记为异常。

动作的选择受以下因素影响:

- 当前状态的特征 \(s_i\)。

- 策略网络 \(\pi_\theta(a \mid s)\)。

- 累计奖励(结合局部和全局奖励)。

4. 标签输出

最终,ASDNet 输出每段道路的标签 \(e_i.l\):

- 通过组合这些标签,形成轨迹中所有子轨迹的异常标记。

- 异常子轨迹可以被整合为连续的异常段,作为检测结果输出。

流程总结

- 轨迹分解:

- 将整条轨迹 \(T\) 分解为多个子轨迹(通常以道路段为单位)。

- 状态构建:

- 每个子轨迹都有自己的状态 \(s_i\),由特征嵌入 \(z_i\) 和前一段的标签历史 \(v(e_{i-1}.l)\) 组成。

- 动作选择:

- 对每个状态 \(s_i\),选择动作 \(a_i\) 来决定当前子轨迹的标签(正常或异常)。

- 奖励反馈:

- 局部奖励: 鼓励标签的连续性,减少频繁切换。

- 全局奖励: 衡量所有标签是否提升模型对整条轨迹异常检测的能力。

- 标签汇总:

- 输出每段的标签,整合连续的异常子轨迹作为结果。

你的理解与扩展

- 逐段处理: 将轨迹拆分成多个子轨迹,每个子轨迹的状态通过 RSRNet 提取的特征嵌入表示。

- 动作和标签: 动作选择是对每个子轨迹状态的标签判断,最终生成全轨迹的标签序列。

- 全局奖励: 是对整条轨迹检测效果的综合评价,而局部奖励用于优化每个子轨迹的标签选择。

这种逐段检测的方式使得模型可以灵活处理在线轨迹,并通过强化学习优化标签选择策略,从而实现精准的异常检测。

ITPNET: TOWARDS INSTANTANEOUS TRAJECTORY PREDICTION FOR AUTONOMOUS DRIVING

以下是这篇论文中涉及的公式的整理和归纳,按模块和功能分类:

3.2 Backward Forecasting

公式 1:观察轨迹的潜在特征提取

从两点观察轨迹 \(X_{\text{obs}} = \{x_1, x_2\}\) 中提取潜在特征表示:

- \(\Phi\):轨迹特征提取网络(如 HiVT, LaneGCN),参数为 \(\phi\)。

- \(v_i \in \mathbb{R}^d\):轨迹点 \(x_i\) 的潜在特征。

公式 2:未观察轨迹潜在特征的重建损失

通过自监督学习目标,将重建的未观察特征与真实未观察特征对齐:

- \(V_{\text{unobs}} = \Phi(X_{\text{unobs}}; \phi)\):真实未观察特征。

- \(\hat{V}_{\text{unobs}} = \Psi(V_{\text{obs}}; \psi)\):预测的未观察特征。

公式 3:未观察特征的预测

利用 LSTM 网络 \(\Psi\) 预测未观察特征:

- 初始值为:

公式 4:Smooth L1 损失

用于优化重建损失 \(L_{\text{rec}}\) 的平滑 L1 损失:

- 平滑 L1 损失函数 \(\delta(v)\):

公式 5:对比学习损失

为了增强未观察特征的表示能力,使用正负样本对的对比损失:

- \(\Delta\):间隔(margin)。

3.4 Noise Redundancy Reduction Former (NRRFormer)

公式 6:第一层自注意力模块

NRRFormer 的第 \(l\) 层通过自注意力机制过滤未观察特征中的噪声:

- \(Q_l\):查询嵌入。

- \(\hat{V}_l^{\text{unobs}}\):输入的未观察特征。

- \(\theta_{l,1}\):自注意力参数。

公式 7:第二层自注意力模块

将观察特征 \(V_{\text{obs}}\) 与过滤后的未观察特征结合:

- \(\theta_{l,2}\):自注意力参数。

- \(V_{\text{obs}}^*\):观察特征的更新版本。

公式 8:前馈网络更新查询表示

将过滤后的特征进一步通过前馈网络更新:

- \(\theta_{l,3}\):前馈网络的参数。

公式 9:未来轨迹预测

通过解码器基于最后一层输出的查询嵌入预测未来轨迹:

- \(\Omega\):解码器模块,参数为 \(\omega\)。

3.5 总损失函数

总损失函数结合重建损失 \(L_{\text{rec}}\)、对比学习损失 \(L_{\text{cts}}\)、回归损失 \(L_{\text{reg}}\) 和分类损失 \(L_{\text{cls}}\):

- \(\alpha, \beta\):权衡参数。

总结

| 公式编号 | 功能 | 对应模块 |

|---|---|---|

| 1 | 提取观察轨迹的潜在特征 | 特征提取 |

| 2, 3, 4 | 重建未观察特征,优化重建损失 | Backward Forecasting |

| 5 | 对比学习增强未观察特征表示能力 | Backward Forecasting |

| 6, 7, 8 | 去噪、整合观察与未观察特征,更新查询嵌入 | NRRFormer |

| 9 | 基于查询嵌入预测未来轨迹 | Trajectory Prediction |

| 10 | 总损失函数,结合多任务优化 | Optimization |

通过这些公式,论文将两点观察轨迹扩展为完整轨迹的预测,解决了信息不足和噪声冗余的问题,同时通过模块化设计提升了方法的适应性和通用性。

在 Transformer 中,对于 连续值输出(如坐标) 的任务,模型的最终阶段需要将嵌入(embedding)转换为具体的数值。这通常通过以下步骤实现:

1. 从 Transformer 输出到坐标值的转换流程

Step 1: Decoder 的输出是嵌入表示

- 在 Transformer 的 Decoder 中,生成的输出是一组嵌入表示 \(Q_L\) 或类似的特征向量,维度为 \(d_{\text{model}}\)。

- 这些嵌入并不能直接表示连续值(如坐标),它们是高维特征表示,需要进一步转换。

Step 2: 线性层将嵌入映射到坐标空间

-

使用一个 全连接线性层 (Linear Layer),将嵌入从高维空间映射到目标的维度。

-

具体公式如下:

\[\mathbf{x} = W \cdot \mathbf{Q}_L + b \]- \(\mathbf{Q}_L \in \mathbb{R}^{d_{\text{model}}}\):Decoder 输出的嵌入向量。

- \(W \in \mathbb{R}^{d_{\text{output}} \times d_{\text{model}}}\):线性变换矩阵。

- \(b \in \mathbb{R}^{d_{\text{output}}}\):偏置向量。

- \(\mathbf{x} \in \mathbb{R}^{d_{\text{output}}}\):映射后的输出。

例如:

- 对于二维坐标预测,\(d_{\text{output}} = 2\),即 \(x\) 和 \(y\) 的值。

Step 3: 激活函数(可选)

- 如果需要约束输出值的范围(例如归一化坐标),可以在全连接层后添加激活函数。

- 例如:

- 使用 \(\text{tanh}\) 将输出值压缩到 \([-1, 1]\)。

- 使用 \(\text{sigmoid}\) 将输出值压缩到 \([0, 1]\)。

- 例如:

2. 示例:从嵌入到坐标的完整过程

假设的输入:

- Decoder 的最终输出嵌入:\(\mathbf{Q}_L = [0.3, -0.5, 1.2, \ldots] \in \mathbb{R}^{d_{\text{model}}}\),假设 \(d_{\text{model}} = 128\)。

- 目标是预测二维坐标 \((x, y)\)。

转换过程:

-

线性映射:

\[\mathbf{x} = W \cdot \mathbf{Q}_L + b, \quad \text{其中 } W \in \mathbb{R}^{2 \times 128}, \, b \in \mathbb{R}^2 \]- 输出结果为二维向量,例如 \([12.5, -3.2]\)。

-

激活函数(如果需要):

- 如果需要限制坐标范围,例如归一化:\[\mathbf{x} = \text{tanh}(\mathbf{x}) \quad \text{或 } \mathbf{x} = \text{sigmoid}(\mathbf{x}) \]

- 如果需要限制坐标范围,例如归一化:

-

最终输出:

- 模型输出最终坐标 \((x, y) = (12.5, -3.2)\)。

3. Transformer Decoder 中如何预测连续值?

在 Decoder-Only 模型(如 GPT 或类似 Transformer)中,通常使用 Cross-Attention 从输入序列(例如编码器输出或历史观察特征)中提取上下文信息。生成连续值的过程如下:

-

预测连续值的上下文依赖性:

- Decoder 在每一步都利用 Cross-Attention 提取与历史特征相关的信息。

- Decoder 输出嵌入 (\(\mathbf{Q}_L\)) 捕获了目标连续值(如坐标)所在空间的特征。

-

解码为连续值:

- 使用上述的线性变换将 Decoder 的输出嵌入直接解码为目标值。

-

自回归预测(如需要):

- 如果任务是逐步预测(如轨迹点坐标),可以采用自回归策略:

- 每次将上一步的预测结果 \((x_i, y_i)\) 作为下一步输入,Decoder 生成下一时刻的嵌入。

- 逐点生成完整轨迹。

- 如果任务是逐步预测(如轨迹点坐标),可以采用自回归策略:

4. 为什么嵌入能表示连续值?

- 嵌入(embedding)本质上是高维特征表示,它捕获了输入数据的语义和上下文信息。

- 对于连续值任务(如坐标预测),嵌入空间会通过训练学习到与坐标映射关系的特征表示。

- 线性变换的作用:

- 嵌入是高维特征,经过线性层,模型可以将这些特征映射到实际的坐标空间。

- 损失函数(如回归损失 \(L_{\text{reg}}\))会指导模型调整嵌入,使其能够精确预测目标值。

5. 总结:从嵌入到数值的关键步骤

- 嵌入提取: Decoder 输出高维特征表示 \(Q_L\)。

- 线性映射: 使用线性层将嵌入维度从 \(d_{\text{model}}\) 转换为目标维度 \(d_{\text{output}}\)。

- 激活约束(可选): 使用激活函数对输出范围进行约束(如归一化坐标)。

- 目标值: 最终输出预测值(如坐标 \((x, y)\))。

这种方法的关键是线性映射的参数 \(W\) 和 \(b\) 是通过训练学习得到的,能够将高维特征嵌入准确映射到连续值目标空间。

是的,判断注意力机制是交叉注意力 (Cross-Attention) 还是自注意力 (Self-Attention) 的关键在于 查询 (Query, Q) 和 键/值 (Key/Value, K/V) 是否来自同一个特征空间(同质),或者来自不同特征空间(异质)。以下是详细分析:

1. 判断依据

-

同质 (Homogeneous):

- \(Q\)、\(K\)、\(V\) 都来自同一个特征空间,或者同一个输入序列。

- 这种情况下,注意力机制是自注意力 (Self-Attention)。

- 典型场景:

- 在 Transformer 编码器中,输入序列的嵌入表示会进行自注意力运算,\(Q, K, V\) 均为该序列自身的特征。

-

异质 (Heterogeneous):

- \(Q\) 来自一个特征空间,\(K\)、\(V\) 来自另一个不同的特征空间。

- 这种情况下,注意力机制是交叉注意力 (Cross-Attention)。

- 典型场景:

- 在 Transformer 解码器中,\(Q\) 是解码序列的嵌入,\(K, V\) 来自编码器的输出。

2. Self-Attention 的定义和特点

- 定义: \(Q, K, V\) 都是从同一个输入生成的特征。

- 计算过程:\[\text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^\top}{\sqrt{d_k}}\right)V \]

- 这里,\(Q, K, V\) 通常是输入序列嵌入表示的不同投影。

- 应用场景:

- 自注意力主要用于捕获序列中不同位置间的依赖关系。

- 输入序列自我关联,没有外部序列参与。

3. Cross-Attention 的定义和特点

- 定义: \(Q\) 来自一个特征空间,\(K, V\) 来自另一个特征空间。

- 计算过程:\[\text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^\top}{\sqrt{d_k}}\right)V \]

- 公式上和自注意力相同,但特征来源不同:

- \(Q\):通常是解码序列的特征(目标)。

- \(K, V\):通常是编码序列的特征(上下文)。

- 公式上和自注意力相同,但特征来源不同:

- 应用场景:

- 在机器翻译等任务中,解码器通过交叉注意力从编码器输出中提取信息。

- 模型需要将不同来源的信息进行融合。

4. 在 NRRFormer 中的应用

NRRFormer 的注意力机制在不同阶段的特征来源是:

-

第一阶段(去噪 Self-Attention):

- \(Q, K, V\):均来自未观察特征 \(V_{\text{unobs}}\)。

- 属于 自注意力 (Self-Attention),因为它只处理未观察特征。

-

第二阶段(融合 Cross-Attention):

- \(Q\):来自去噪后的未观察特征 \(Q_l^{\text{unobs}}\)。

- \(K, V\):来自观察特征 \(V_{\text{obs}}\)。

- 属于 交叉注意力 (Cross-Attention),因为 \(Q\) 和 \(K, V\) 来自不同的特征空间。

5. 判断注意力类型的原则

总结来说:

- 如果 \(Q, K, V\) 同质,属于 Self-Attention。

- 如果 \(Q\) 与 \(K, V\) 异质,属于 Cross-Attention。

这种判断的核心在于注意力的功能:

- 自注意力用于序列内部的自我关联。

- 交叉注意力用于序列之间的信息融合。

6. 示例总结

- Transformer Encoder: 自注意力,因为输入序列中的所有特征是同质的。

- Transformer Decoder: 同时包含自注意力和交叉注意力:

- 自注意力:处理解码器内部的特征关系。

- 交叉注意力:从编码器的输出中提取相关信息。

- NRRFormer: 两阶段分别使用自注意力(去噪)和交叉注意力(融合观察与未观察特征)。

从论文框架和描述来看,Noise Redundancy Reduction Former (NRRFormer) 模块中使用的 Transformer 模块似乎在不同阶段使用了自注意力 (Self-Attention) 和交叉注意力 (Cross-Attention) 的机制。以下是对该模块中注意力机制的具体分析:

1. Self-Attention 用于去噪

在 NRRFormer 的第一阶段:

NRRFormer 的每个 NRRBlock 首先对未观察特征 $ \hat{V}_{l}^{\text{unobs}} $ 进行去噪处理,并生成中间的查询嵌入 \(Q_l^{\text{unobs}}\):

- 这里的 \(Q_l\)(查询)和 \(\hat{V}_l^{\text{unobs}}\)(键和值)是通过同一潜在特征空间生成的,即它们是同质的。

- 用途: 这种自注意力机制的目标是对未观察特征进行去噪和冗余信息压缩。

注意:

- \(Q_l\) 是上一层的输出查询嵌入。

- \(\hat{V}_l^{\text{unobs}}\) 是当前层的未观察特征。

- 查询 (Q)、键 (K)、值 (V) 在这一步是同质的,因为它们都源自未观察特征。

2. Cross-Attention 用于特征融合

在 NRRFormer 的第二阶段:

为了融合观察到的特征 \(V_{\text{obs}}\) 和去噪后的未观察特征,使用交叉注意力:

- 这里的 \(Q_l^{\text{unobs}}\) 是去噪后的查询嵌入,来源于未观察特征。

- \(V_{\text{obs}}\) 是从观察轨迹提取的潜在特征表示,与未观察特征是异质的。

- 用途: 这种交叉注意力的目标是让观察特征 \(V_{\text{obs}}\) 和未观察特征 \(Q_l^{\text{unobs}}\) 之间相互补充,并生成融合后的查询嵌入 \(Q_l^{\text{unobs, obs}}\)。

注意:

- 查询 (Q) 来自未观察特征 \(Q_l^{\text{unobs}}\)。

- 键 (K) 和 值 (V) 来自观察特征 \(V_{\text{obs}}\)。

- 这里使用的是交叉注意力,因为查询和键/值在潜在语义上是异质的。

3. Transformer 的整体性质

从框架和公式可以看出,NRRFormer 中的 Transformer 模块是结合了自注意力和交叉注意力的:

- 第一阶段 (Self-Attention):

- \(Q, K, V\) 均来自未观察特征 \(V_{\text{unobs}}\),是同质的。

- 目标是去噪和压缩未观察特征。

- 第二阶段 (Cross-Attention):

- \(Q\) 来自未观察特征,而 \(K, V\) 来自观察特征 \(V_{\text{obs}}\),是异质的。

- 目标是融合观察和未观察特征,生成更有效的查询嵌入。

总结

- 是否是交叉注意力 (Cross-Attention)?

- 在 NRRFormer 的第一阶段:使用的是自注意力 (Self-Attention),特征同质。

- 在 NRRFormer 的第二阶段:使用的是交叉注意力 (Cross-Attention),特征异质。

- Q, K, V 是否异质?

- 第一阶段:\(Q, K, V\) 来自同一特征空间,同质。

- 第二阶段:\(Q\) 来自未观察特征,\(K, V\) 来自观察特征,异质。

这种设计充分结合了自注意力和交叉注意力的优点,分别在去噪和特征融合两个阶段发挥作用。

根据论文的描述和提供的框架图,Decoder 模块的设计并没有明确强调是否使用自回归方法,而是保持与之前的轨迹预测模型(如 HiVT 或 LaneGCN)一致。以下是对 Decoder 的分析:

Decoder 的作用

Decoder 的主要任务是根据 Noise Redundancy Reduction Former (NRRFormer) 输出的最终查询嵌入 $Q_L),生成 $K) 条未来轨迹的预测:

- $\Omega):Decoder 模块,参数为 $\omega)。

- $Q_L):NRRFormer 的最终输出查询嵌入,包含观察特征和未观察特征的信息。

Decoder 的实现方式

-

非自回归生成:

- 如果采用非自回归方式,Decoder 会将 $Q_L) 映射到整个未来轨迹的分布,直接预测 $K) 条完整轨迹(每条轨迹长度为 $M))。

- 这种方式更快,因为只需要一次前向传播,但可能对复杂轨迹的捕获能力不足。

-

自回归生成:

- 如果采用自回归方式,Decoder 会逐点生成轨迹,每次利用上一个时刻的输出作为下一个时刻的输入,直到生成完整的轨迹。

- 优点是能够更精确地建模时间相关性和不确定性,但推理速度较慢。

从论文的推断

论文中强调了方法的通用性和可移植性,Decoder 可以采用现有轨迹预测模型的结构(如 HiVT、LaneGCN)。这些模型中:

- HiVT 使用 Transformer,通常直接预测整个轨迹(非自回归)。

- LaneGCN 可以逐点生成轨迹(自回归)。

根据论文未明确提到自回归机制,结合其 Plug-and-Play 的设计理念,更有可能采用非自回归生成方法,这样可以更好地适配不同的轨迹预测模型,并减少推理时间。

总结

- Decoder 更可能采用非自回归方式,直接基于 $Q_L) 生成 $K) 条完整轨迹。

- 如果需要逐点生成轨迹,可以通过将自回归模型集成到 Decoder 中,这在框架上是可行的,但未明确提到这种实现方式。

浙公网安备 33010602011771号

浙公网安备 33010602011771号