K8S脉络整理(010)-Service

学习 Service。

我们不应该期望 Kubernetes Pod 是健壮的,而是要假设 Pod 中的容器很可能因为各种原因发生故障而死掉。

Deployment 等 controller 会通过动态创建和销毁 Pod 来保证应用整体的健壮性。

换句话说,Pod 是脆弱的,但应用是健壮的。

每个 Pod 都有自己的 IP 地址。当 controller 用新 Pod 替代发生故障的 Pod 时,新 Pod 会分配到新的 IP 地址。

这样就产生了一个问题:

如果一组 Pod 对外提供服务(比如 HTTP),它们的 IP 很有可能发生变化,那么客户端如何找到并访问这个服务呢?

Kubernetes 给出的解决方案是 Service。

创建 Service

Kubernetes Service 从逻辑上代表了一组 Pod,具体是哪些 Pod 则是由 label 来挑选。

Service 有自己 IP,而且这个 IP 是不变的。

客户端只需要访问 Service 的 IP,Kubernetes 则负责建立和维护 Service 与 Pod 的映射关系。

无论后端 Pod 如何变化,对客户端不会有任何影响,因为 Service 没有变。

来看个例子,创建下面的这个 Deployment,httpd.yml:

apiVersion: apps/v1beta1

kind: Deployment

metadata:

name: httpd

spec:

replicas: 3

template:

metadata:

labels:

run: httpd

spec:

containers:

- name: httpd

image: httpd

ports:

- containerPort: 80

我们启动了三个 Pod,运行 httpd 镜像,label 是 run: httpd,Service 将会用这个 label 来挑选 Pod。

daweij@master:~/stady01/httpd$ kubectl apply -f httpd.yml deployment "httpd" created daweij@master:~/stady01/httpd$ kubectl get pod -o wide NAME READY STATUS RESTARTS AGE IP NODE httpd-7448fc6b46-4q649 1/1 Running 0 1h 10.233.102.141 node1 httpd-7448fc6b46-82fhz 1/1 Running 0 1h 10.233.75.11 node2 httpd-7448fc6b46-99q7w 1/1 Running 0 1h 10.233.74.79 node4

Pod 分配了各自的 IP,这些 IP 只能被 Kubernetes Cluster 中的容器和节点访问。

daweij@master:~/stady01/httpd$ curl 10.233.102.141 <html><body><h1>It works!</h1></body></html> daweij@master:~/stady01/httpd$ curl 10.233.75.11 <html><body><h1>It works!</h1></body></html> daweij@master:~/stady01/httpd$ curl 10.233.74.79 <html><body><h1>It works!</h1></body></html>

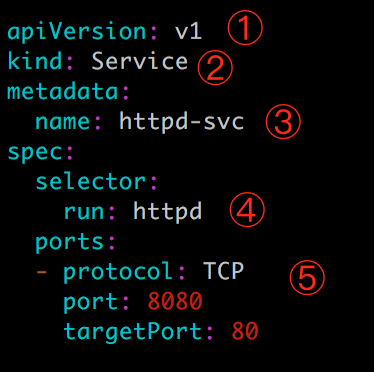

接下来创建 Service,其配置文件httpd-svc.yml如下:

apiVersion: v1

kind: Service

metadata:

name: httpd-svc

spec:

selector:

run: httpd

ports:

- protocol: TCP

port: 8080

targetPort: 80

① v1 是 Service 的 apiVersion。

② 指明当前资源的类型为 Service。

③ Service 的名字为 httpd-svc。

④ selector 指明挑选那些 label 为 run: httpd 的 Pod 作为 Service 的后端。

⑤ 将 Service 的 8080 端口映射到 Pod 的 80 端口,使用 TCP 协议。

执行 kubectl apply 创建 Service httpd-svc。

daweij@master:~/stady01/httpd$ kubectl apply -f httpd-svc.yml service "httpd-svc" created daweij@master:~/stady01/httpd$ kubectl get service NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE httpd-svc ClusterIP 10.233.60.170 <none> 8080/TCP 6s

httpd-svc 分配到一个 CLUSTER-IP 10.233.60.170。可以通过该 IP 访问后端的 httpd Pod。

daweij@master:~/stady01/httpd$ curl 10.233.60.170:8080 <html><body><h1>It works!</h1></body></html>

根据前面的端口映射,这里要使用 8080 端口。

另外,除了我们创建的 httpd-svc,还有一个 Service kubernetes,Cluster 内部通过这个 Service 访问 kubernetes API Server。

daweij@master:~/stady01/httpd$ kubectl get service NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE httpd-svc ClusterIP 10.233.60.170 <none> 8080/TCP 6s kubernetes ClusterIP 10.233.0.1 <none> 443/TCP 34d

通过 kubectl describe 可以查看 httpd-svc 与 Pod 的对应关系。

daweij@master:~/stady01/httpd$ kubectl describe service httpd-svc

Name: httpd-svc

Namespace: default

Labels: <none>

Annotations: kubectl.kubernetes.io/last-applied-configuration={"apiVersion":"v1","kind":"Service","metadata":{"annotations":{},"name":"httpd-svc","namespace":"default"},"spec":{"ports":[{"port":8080,"protocol":"TC...

Selector: run=httpd

Type: ClusterIP

IP: 10.233.60.170

Port: <unset> 8080/TCP

TargetPort: 80/TCP

Endpoints: 10.233.102.141:80,10.233.74.79:80,10.233.75.11:80

Session Affinity: None

Events: <none>

Endpoints 罗列了三个 Pod 的 IP 和端口。

Service Cluster IP

我们知道 Pod 的 IP 是在容器中配置的,那么 Service 的 Cluster IP 又是配置在哪里的呢?CLUSTER-IP 又是如何映射到 Pod IP 的呢?

答案是 iptables,我们下节讨论。

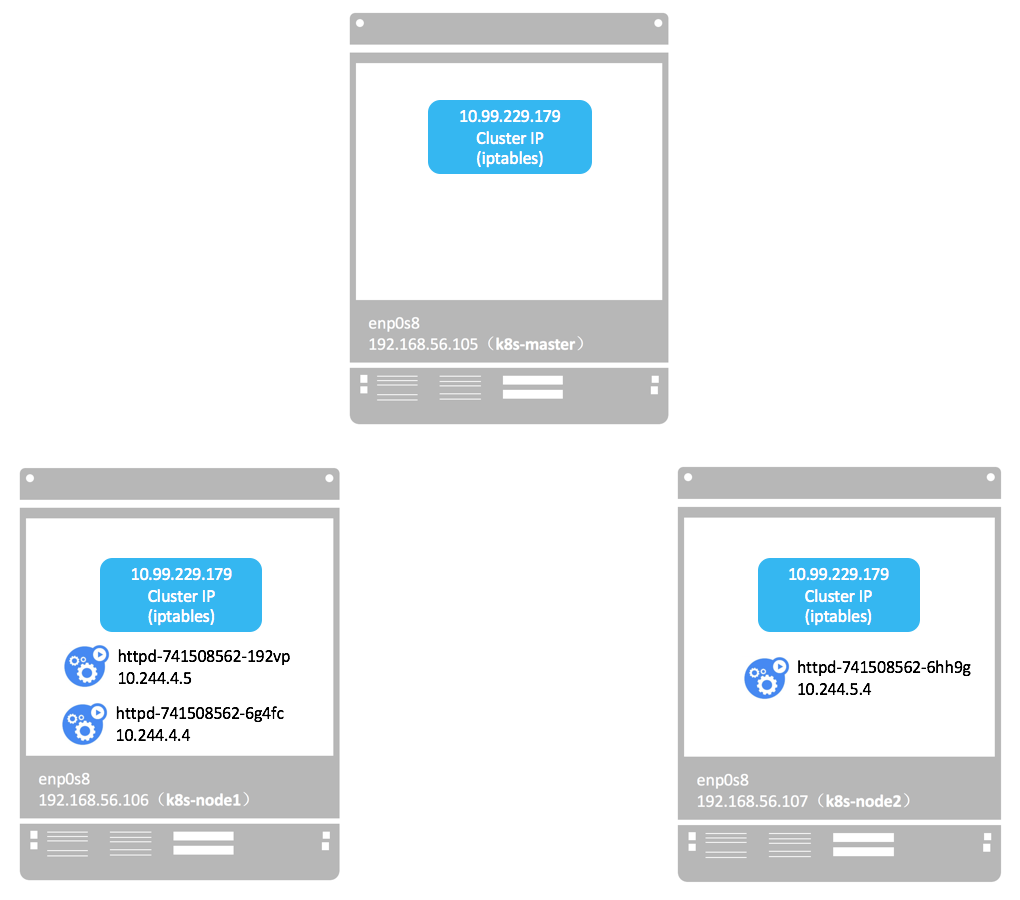

Service Cluster IP 是一个虚拟 IP,是由 Kubernetes 节点上的 iptables 规则管理的。

可以通过 iptables-save 命令打印出当前节点的 iptables 规则,因为输出较多,这里只截取与 httpd-svc Cluster IP 10.233.60.170 相关的信息:

root@master:~# iptables-save | grep 10.233.60.170 -A KUBE-SERVICES ! -s 10.233.64.0/18 -d 10.233.60.170/32 -p tcp -m comment --comment "default/httpd-svc: cluster IP" -m tcp --dport 8080 -j KUBE-MARK-MASQ -A KUBE-SERVICES -d 10.233.60.170/32 -p tcp -m comment --comment "default/httpd-svc: cluster IP" -m tcp --dport 8080 -j KUBE-SVC-RL3JAE4GN7VOGDGP

这两条规则的含义是:

-

如果 Cluster 内的 Pod(源地址来自10.233.64.0/18)要访问

httpd-svc,则允许。 -

其他源地址访问

httpd-svc,跳转到规则KUBE-SVC-RL3JAE4GN7VOGDGP。

KUBE-SVC-RL3JAE4GN7VOGDGP 规则如下:

root@master:~# iptables-save | grep KUBE-SVC-RL3JAE4GN7VOGDGP :KUBE-SVC-RL3JAE4GN7VOGDGP - [0:0] -A KUBE-SERVICES -d 10.233.60.170/32 -p tcp -m comment --comment "default/httpd-svc: cluster IP" -m tcp --dport 8080 -j KUBE-SVC-RL3JAE4GN7VOGDGP -A KUBE-SVC-RL3JAE4GN7VOGDGP -m comment --comment "default/httpd-svc:" -m statistic --mode random --probability 0.33332999982 -j KUBE-SEP-OFJZQ2YXMDGM5ICL -A KUBE-SVC-RL3JAE4GN7VOGDGP -m comment --comment "default/httpd-svc:" -m statistic --mode random --probability 0.50000000000 -j KUBE-SEP-D2L6UYYGJQ3QAHJI -A KUBE-SVC-RL3JAE4GN7VOGDGP -m comment --comment "default/httpd-svc:" -j KUBE-SEP-5Z4HI2MMVKWFUCLI

-

1/3 的概率跳转到规则 KUBE-SEP-OFJZQ2YXMDGM5ICL 。

-

1/3 的概率(剩下 2/3 的一半)跳转到规则 KUBE-SEP-D2L6UYYGJQ3QAHJI 。

-

1/3 的概率跳转到规则 KUBE-SEP-5Z4HI2MMVKWFUCLI。

上面三个跳转的规则如下:

root@master:~# iptables-save | grep -E 'KUBE-SEP-OFJZQ2YXMDGM5ICL|KUBE-SEP-D2L6UYYGJQ3QAHJI|KUBE-SEP-5Z4HI2MMVKWFUCLI' :KUBE-SEP-5Z4HI2MMVKWFUCLI - [0:0] :KUBE-SEP-D2L6UYYGJQ3QAHJI - [0:0] :KUBE-SEP-OFJZQ2YXMDGM5ICL - [0:0] -A KUBE-SEP-5Z4HI2MMVKWFUCLI -s 10.233.75.11/32 -m comment --comment "default/httpd-svc:" -j KUBE-MARK-MASQ -A KUBE-SEP-5Z4HI2MMVKWFUCLI -p tcp -m comment --comment "default/httpd-svc:" -m tcp -j DNAT --to-destination 10.233.75.11:80 -A KUBE-SEP-D2L6UYYGJQ3QAHJI -s 10.233.74.79/32 -m comment --comment "default/httpd-svc:" -j KUBE-MARK-MASQ -A KUBE-SEP-D2L6UYYGJQ3QAHJI -p tcp -m comment --comment "default/httpd-svc:" -m tcp -j DNAT --to-destination 10.233.74.79:80 -A KUBE-SEP-OFJZQ2YXMDGM5ICL -s 10.233.102.141/32 -m comment --comment "default/httpd-svc:" -j KUBE-MARK-MASQ -A KUBE-SEP-OFJZQ2YXMDGM5ICL -p tcp -m comment --comment "default/httpd-svc:" -m tcp -j DNAT --to-destination 10.233.102.141:80

即将请求分别转发到后端的三个 Pod。

通过上面的分析,我们得到如下结论:

iptables 将访问 Service 的流量转发到后端 Pod,而且使用类似轮询的负载均衡策略。

另外需要补充一点:Cluster 的每一个节点都配置了相同的 iptables 规则,这样就确保了整个 Cluster 都能够通过 Service 的 Cluster IP 访问 Service。

DNS 访问service

除了直接通过 Cluster IP 访问到 Service,DNS 是更加便捷的方式。

在 Cluster 中,除了可以通过 Cluster IP 访问 Service,Kubernetes 还提供了更为方便的 DNS 访问。

kubeadm 部署时会默认安装 kube-dns 组件。

root@master:~# kubectl get deployment --namespace=kube-system

NAME DESIRED CURRENT UP-TO-DATE AVAILABLE AGE

kube-dns 2 2 2 2 34d

kubedns-autoscaler 1 1 1 1 34d

kubernetes-dashboard 1 1 1 1 34d

kube-dns 是一个 DNS 服务器。

每当有新的 Service 被创建,kube-dns 会添加该 Service 的 DNS 记录。

Cluster 中的 Pod 可以通过 <SERVICE_NAME>.<NAMESPACE_NAME> 访问 Service。

比如可以用 httpd-svc.default 访问 Service httpd-svc。

root@master:~# kubectl run busybox --rm -ti --image=busybox /bin/sh If you don't see a command prompt, try pressing enter. / # wget httpd-svc.default:8080 Connecting to httpd-svc.default:8080 (10.233.60.170:8080) index.html 100% |*********************************************************| 45 0:00:00 ETA

如上所示,我们在一个临时的 busybox Pod 中验证了 DNS 的有效性。

另外,由于这个 Pod 与 httpd-svc 同属于 default namespace,可以省略 default 直接用 httpd-svc 访问 Service。

/ # wget httpd-svc:8080 Connecting to httpd-svc:8080 (10.233.60.170:8080) index.html 100% |*********************************************************| 45 0:00:00 ETA / #

用 nslookup 查看 httpd-svc 的 DNS 的信息。

/ # nslookup httpd-svc Server: 10.233.0.3 Address 1: 10.233.0.3 kube-dns.kube-system.svc.cluster.local Name: httpd-svc Address 1: 10.233.60.170 httpd-svc.default.svc.cluster.local

DNS 服务器是 kube-dns.kube-system.svc.cluster.local,这实际上就是 kube-dns 组件,它本身是部署在 kube-system namespace 中的一个 Service。

httpd-svc.default.svc.cluster.local 是 httpd-svc 的完整域名。

如果要访问其他 namespace 中的 Service,就必须带上 namesapce 了。

kubectl get namespace 查看已有的 namespace。

daweij@master:~$ kubectl get ns

NAME STATUS AGE

default Active 34d

kube-public Active 34d

kube-system Active 34d

在 kube-public 中部署 Service httpd2-svc,配置如下(deployment service写入一个yml文件:httpd2.yml):

apiVersion: apps/v1beta1 kind: Deployment metadata: name: httpd namespace: kube-public spec: replicas: 3 template: metadata: labels: run: httpd2 spec: containers: - name: httpd2 image: httpd ports: - containerPort: 80 --- apiVersion: v1 kind: Service metadata: name: httpd2-svc namespace: kube-public spec: selector: run: httpd2 ports: - protocol: TCP port: 8080 targetPort: 80

通过 namespace: kube-public 指定资源所属的 namespace。

多个资源可以在一个 YAML 文件中定义,用 --- 分割。

执行 kubectl apply 创建资源;

查看 kube-public 的 Service:

daweij@master:~/stady01/httpd$ kubectl apply -f httpd2.yml deployment "httpd" created service "httpd2-svc" created daweij@master:~/stady01/httpd$ kubectl get service --namespace=kube-public NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE httpd2-svc ClusterIP 10.233.17.137 <none> 8080/TCP 33s

在 busybox Pod 中访问 httpd2-svc:

daweij@master:~$ kubectl run busybox --rm -ti --image=busybox /bin/sh daweij@master:~$ kubectl get pods -o wide NAME READY STATUS RESTARTS AGE IP NODE busybox-7c6c97f7cb-jnh4f 1/1 Running 0 1m 10.233.71.15 node3 daweij@master:~$ kubectl exec busybox-7c6c97f7cb-jnh4f wget httpd2-svc:8080 wget: bad address 'httpd2-svc:8080' command terminated with exit code 1 daweij@master:~$ kubectl exec busybox-7c6c97f7cb-jnh4f wget httpd2-svc.kube-public:8080 Connecting to httpd2-svc.kube-public:8080 (10.233.17.137:8080) index.html 100% |*******************************| 45 0:00:00 ETA

因为属于不同的 namespace,必须使用 httpd2-svc.kube-public 才能访问到。

Kubernetes 集群内部可以通过 Cluster IP (service-vip)和 DNS ( <SERVICE_NAME>.<NAMESPACE_NAME> )访问 Service.

集群外部如何访问

除了 Cluster 内部可以访问 Service,很多情况我们也希望应用的 Service 能够暴露给 Cluster 外部。

Kubernetes 提供了多种类型的 Service,默认是 ClusterIP。

ClusterIP

Service 通过 Cluster 内部的 IP 对外提供服务,只有 Cluster 内的节点和 Pod 可访问,这是默认的 Service 类型,前面实验中的 Service 都是 ClusterIP。

NodePort

Service 通过 Cluster 节点的静态端口对外提供服务。Cluster 外部可以通过 <NodeIP>:<NodePort> 访问 Service。

LoadBalancer

Service 利用 cloud provider 特有的 load balancer 对外提供服务,cloud provider 负责将 load balancer 的流量导向 Service。

目前支持的 cloud provider 有 GCP、AWS、Azur 等。

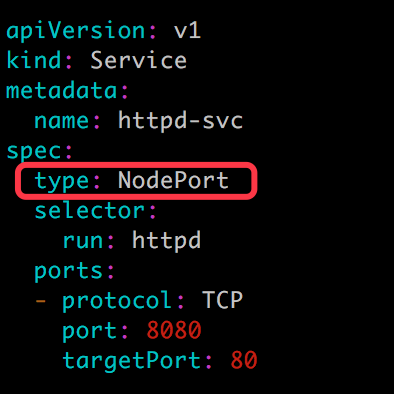

下面我们来实践 NodePort,Service httpd-svc 的配置文件修改如下:

apiVersion: v1 kind: Service metadata: name: httpd-svc spec: type: NodePort selector: run: httpd ports: - protocol: TCP port: 8080 targetPort: 80

添加 type: NodePort,重新创建 httpd-svc。

daweij@master:~/stady01/httpd$ kubectl apply -f httpd-svc.yml service "httpd-svc" configured daweij@master:~/stady01/httpd$ kubectl get service httpd-svc NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE httpd-svc NodePort 10.233.60.170 <none> 8080:32224/TCP 1h

Kubernetes 依然会为 httpd-svc 分配一个 ClusterIP,不同的是:

-

EXTERNAL-IP为nodes,表示可通过 Cluster 每个节点自身的 IP 访问 Service。 -

PORT(S)为8080:32224。8080是 ClusterIP 监听的端口,32224则是节点上监听的端口。

Kubernetes 会从 30000-32767 中分配一个可用的端口,每个节点都会监听此端口并将请求转发给 Service。

daweij@master:~/stady01/httpd$ netstat -an | grep 32224 tcp6 0 0 :::32224 :::* LISTEN

下面测试 NodePort 是否正常工作。

daweij@master:~$ kubectl get service httpd-svc -o wide NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR httpd-svc NodePort 10.233.60.170 <none> 8080:32224/TCP 1h run=httpd daweij@master:~$ kubectl get pod -o wide NAME READY STATUS RESTARTS AGE IP NODE httpd-7448fc6b46-4q649 1/1 Running 0 2h 10.233.102.141 node1 httpd-7448fc6b46-82fhz 1/1 Running 0 2h 10.233.75.11 node2 httpd-7448fc6b46-99q7w 1/1 Running 0 2h 10.233.74.79 node4 daweij@master:~$ curl 172.28.2.210:32224 <html><body><h1>It works!</h1></body></html> daweij@master:~$ curl 172.28.2.211:32224 <html><body><h1>It works!</h1></body></html> daweij@master:~$ curl 172.28.2.212:32224 <html><body><h1>It works!</h1></body></html> daweij@master:~$ curl 172.28.2.213:32224 <html><body><h1>It works!</h1></body></html> daweij@master:~$ curl 172.28.2.214:32224 <html><body><h1>It works!</h1></body></html>

通过master和四个节点 IP + 32224 端口都能够访问 httpd-svc。

接下来我们深入探讨一个问题:Kubernetes 是如何将 <NodeIP>:<NodePort>映射到 Pod 的呢?

与 ClusterIP 一样,也是借助了 iptables。

与 ClusterIP 相比,每个节点的 iptables 中都增加了下面两条规则:

root@master:~# iptables-save | grep 32224 -A KUBE-NODEPORTS -p tcp -m comment --comment "default/httpd-svc:" -m tcp --dport 32224 -j KUBE-MARK-MASQ -A KUBE-NODEPORTS -p tcp -m comment --comment "default/httpd-svc:" -m tcp --dport 32224 -j KUBE-SVC-RL3JAE4GN7VOGDGP

规则的含义是:访问当前节点 32224 端口的请求会应用规则 KUBE-SVC-RL3JAE4GN7VOGDGP,内容为:

root@master:~# iptables-save | grep KUBE-SVC-RL3JAE4GN7VOGDGP :KUBE-SVC-RL3JAE4GN7VOGDGP - [0:0] -A KUBE-NODEPORTS -p tcp -m comment --comment "default/httpd-svc:" -m tcp --dport 32224 -j KUBE-SVC-RL3JAE4GN7VOGDGP -A KUBE-SERVICES -d 10.233.60.170/32 -p tcp -m comment --comment "default/httpd-svc: cluster IP" -m tcp --dport 8080 -j KUBE-SVC-RL3JAE4GN7VOGDGP -A KUBE-SVC-RL3JAE4GN7VOGDGP -m comment --comment "default/httpd-svc:" -m statistic --mode random --probability 0.33332999982 -j KUBE-SEP-OFJZQ2YXMDGM5ICL -A KUBE-SVC-RL3JAE4GN7VOGDGP -m comment --comment "default/httpd-svc:" -m statistic --mode random --probability 0.50000000000 -j KUBE-SEP-D2L6UYYGJQ3QAHJI -A KUBE-SVC-RL3JAE4GN7VOGDGP -m comment --comment "default/httpd-svc:" -j KUBE-SEP-5Z4HI2MMVKWFUCLI

其作用就是负载均衡到每一个 Pod。

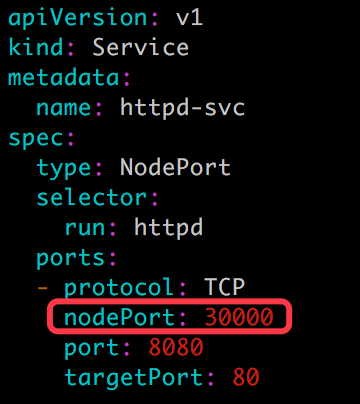

NodePort 默认是的随机选择,不过我们可以用 nodePort 指定某个特定端口。

apiVersion: v1 kind: Service metadata: name: httpd-svc spec: type: NodePort selector: run: httpd ports: - protocol: TCP nodePort: 30000 port: 8080 targetPort: 80

现在配置文件中就有三个 Port 了:nodePort 是节点上监听的端口。port 是 ClusterIP 上监听的端口。targetPort 是 Pod 监听的端口。

最终,Node 和 ClusterIP 在各自端口上接收到的请求都会通过 iptables 转发到 Pod 的 targetPort。

应用新的 nodePort 并验证:

daweij@master:~/stady01/httpd$ kubectl apply -f httpd-svc.yml service "httpd-svc" configured daweij@master:~/stady01/httpd$ kubectl get service httpd-svc NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE httpd-svc NodePort 10.233.60.170 <none> 8080:30000/TCP 1h daweij@master:~/stady01/httpd$ curl 172.28.2.210:30000 <html><body><h1>It works!</h1></body></html> daweij@master:~/stady01/httpd$ curl 172.28.2.211:30000 <html><body><h1>It works!</h1></body></html> daweij@master:~/stady01/httpd$ curl 172.28.2.214:30000 <html><body><h1>It works!</h1></body></html>

nodePort: 30000 已经生效了。

小结

本章我们讨论访问应用的机制 Service,学习了如何创建 Service;

Service 的三种类型 ClusterIP/DNS(内部访问)、NodePort (外部访问)和 LoadBalancer(暂未涉及),以及它们各自的适用场景。

浙公网安备 33010602011771号

浙公网安备 33010602011771号