【论文笔记-2】Semantics Driven Multi-View Knowledge Graph Embedding for Cross-Lingual Entity Alignment

结构

摘要:

跨语言实体对齐(EA)任务中,基于图卷积和预训练的模型,利用了图结构和辅助语义信息,取得了突破性能。

然而现有EA方法严重依赖人工设计“图结构与辅助语义信息”的交互,不具有泛用性。

因此提出一个简单但有效的语义驱动的多视图知识图谱嵌入方法。

动机:

知识图谱对齐已经从基于TransE的方法过渡到基于图卷积网络(GCN)的方法。

但是基于GCN的方法依赖预对齐的机器翻译质量,因此有研究人员利用预训练语言模型(PLM)如Bert等来帮助嵌入

但是这种方法依然存在问题。

挑战:

- 这些方法使用GCN或其变体来聚合结构特征,这并没有很好地解决KGs中结构异质性的问题,也缺乏有效的交互策略。

- 这些方法依赖于可能并不总是可用的额外属性信息。

解决方法:

提出语义驱动的多视图知识图谱嵌入方法SDMKGE。

首先,是一种将拓扑特征转换为结构语义特征的策略。使得这些特征能够用于提取实体的邻域信息。

然后,使用两个基于预训练模型的独立孪生网络分别编码实体语义和结构语。有效地克服了基于GCN的方法中手动设计交互策略的局限性,而且还在不使用额外属性信息的情况下丰富了实体语义信息。

最后,设计了一种保持语义独立的决策策略,有效地利用实体语义和结构语义的语义相似性进行EA。

相关工作:

早期基于TransE(MTransE): 受到限制即\(h+r=t\),无法捕捉复杂关系。

之后基于GCN: 准确性受限于预对齐的机器翻译技术质量

最近GCN+PLM: 见挑战

结论:

略<会议论文,只复述了实验结果>

未来工作:

无

数据集:

DBP15K

其它:

无

技术细节

会议论文,描述的很粗略。

模型结构:知识图谱嵌入(实体语义嵌入,结构语义嵌入),知识图谱对齐

实体语义嵌入

-

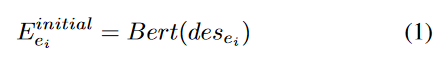

根据文本描述从BERT中得到实体的初始嵌入,参考原文中的文献[9]。

-

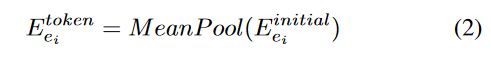

但不同于文献[9]使用[CLS]标记作为实体嵌入,这里使用平均池化操作来获取实体嵌入。

-

最后利用多层感知机层来获取最终嵌入。

结构语义嵌入

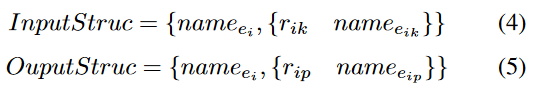

首先定义实体的输入与输出上下文信息如下,这里输入和输出代表实体关系的指向。

输入={实体名字,{输入关系,头实体}}。输出={实体名字,{输出关系,尾实体}}

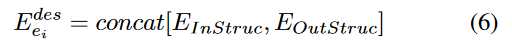

然后使用与实体语义嵌入相似的网络来获取结构语义嵌入(不共享参数),但是得到两个嵌入(输入嵌入和输出嵌入),最后将得到的两个嵌入连接。

知识图谱对齐

暂略

跨语言知识图谱嵌入前沿: 图卷积+预训练模型的方法

跨语言知识图谱嵌入前沿: 图卷积+预训练模型的方法

浙公网安备 33010602011771号

浙公网安备 33010602011771号