AI 智能

MiniMax 语音:让灵感声声悦耳-数据魔法师

灵感

【主歌1·符号歌】 说话写字用引号,单双都一样(''"") 叫人干活圆括号,像喊邻居来相帮(()) 装果装菜方括号,筐里啥都能装([]) 点的用法像“的”字,pandas读表超顺当(.) 【主歌2·数据分析】 请出pandas来帮忙(import pandas as pd) CSV文件钻进框(pd.read_csv) 列名是钥匙开箱(data['列名']) 条件筛出真与假(np.where) value_counts数谁旺(统计数量) len(data)看有几行逛(总行数) pd.cut切数据像切糖(数值分段) groupby分组算强弱(分组计算)

[verse]

引文字符在说话 单双都是它

圆括号像叫邻居 来帮忙一下

方括号装满了数据 就像大筐它

点点滴滴是关联 顺畅通天下

[pre-chorus]

从零开始不发愁 键盘敲出新宇宙

数据世界多自由 逻辑指引往前走

[chorus]

数据魔法师 代码变魔法

海量数据我拆解 洞察世界真潇洒

逻辑结构是我的家 让信息开花

[verse]

Pandas出场真威风 CSV文件它能懂

列名是钥匙一把 秘密箱子已开封

条件筛选真假辨 数值统计看谁红

总行数一目了然 分段切割好轻松

[pre-chorus]

从零开始不发愁 键盘敲出新宇宙

数据世界多自由 逻辑指引往前走

[chorus]

数据魔法师 代码变魔法

海量数据我拆解 洞察世界真潇洒

逻辑结构是我的家 让信息开花

[bridge]

从零到一的飞跃 思维清晰不打结

数据背后有故事 等待我去解读它

每一次分析 每一次探索 都是新的启发

[chorus]

数据魔法师 代码变魔法

海量数据我拆解 洞察世界真潇洒

逻辑结构是我的家 让信息开花

MiniMax 语音:让灵感声声悦耳 - 数据代码魂

数据代码魂

Electronic

Focused

Coding

灵感

请出pandas来帮忙(import pandas as pd) CSV文件钻进框(pd.read_csv) 列名是钥匙开箱(data['列名']) 条件筛出真与假(np.where) value_counts数谁旺(统计数量) len(data)看有几行逛(总行数) pd.cut切数据像切糖(数值分段) groupby分组算强弱(分组计算) 数字乱码变乖巧(pd.to_numeric) 标准化穿新衣裳(fit_transform) train_test_split切两半(划分数据集) 读Excel也不犯难(pd.read_excel) Q1Q3找分界(分位数) IQR扫走异常草(处理异常值) info()看表啥模样(信息结构) rename改名列名亮(修改列名)

[verse]

请出pandas来帮忙 import pd它站岗

CSV钻进框 read_csv数据海洋广

列名钥匙开箱 data真假细筛选

np.where判断出 value_counts数谁旺

[chorus]

数据切糖 pd.cut分段放

groupby分组算强弱 不慌张

数字乱码to_numeric 新衣裳

fit_transform标准化 洞察光芒

[bridge]

len data看几行 train_test_split两半切

Excel读入不犯难 Q1Q3 IQR扫异常

info看表啥模样 rename列名亮

MiniMax 语音:让灵感声声悦耳-数据心跳

数据心跳

Electronic

Energetic

Coding

灵感

Logistic建小房(Logistic回归) model.fit喂数据忙(模型训练) dump存起小模型(保存模型) predict测测准不准(预测) smote撒种补空档(重新采样) Pipeline串工序强(创建管道) 随机森林种成行(RandomForest) get_dummies转数字(类别转换) onnx加载模型脑(ort.InferenceSession) 图片读成RGB貌(Image.open) softmax算概率高(获取概率) argsort排座次妙(数组排序) 代码行行像心跳,数据开花结果好~

[verse]

Logistic建小房 模型喂数据忙

倾注心血让它成长

[verse]

Dump存起小模型 Predict测测准不准

细心打磨每个可能

[pre-chorus]

Smote撒种补空档 Pipeline串工序强

一步一步走向远方

[chorus]

随机森林种成行 Get dummies转数字光

代码行行像心跳 数据开花结果好

智慧火花在闪耀

[bridge]

Onnx加载模型脑 图片读成RGB貌

Softmax算概率高 Argsort排座次妙

每行逻辑都精准 构筑未来新生命

[chorus]

代码行行像心跳 数据开花结果好

智慧火花在闪耀

祖传代码 (legacy code)

-- 1. 先给 name 加唯一索引(确保判断唯一性)

ALTER TABLE t ADD UNIQUE INDEX idx_name (name);

-- 2. 批量插入/更新(示例批量插入3条数据)

INSERT INTO t (name, tags)

VALUES

('张三', '["Java","MySQL"]'),

('李四', '["Python","Redis"]'),

('张三', '["Spring","MySQL"]') -- 与张三原有标签重复,需合并

ON DUPLICATE KEY UPDATE

-- 合并逻辑:用 JSON_MERGE_PRESERVE 合并数组,再用 JSON_TABLE 去重

tags = (

SELECT JSON_ARRAYAGG(DISTINCT tag)

FROM JSON_TABLE(

JSON_MERGE_PRESERVE(t.tags, VALUES(tags)),

'$[*]' COLUMNS (tag VARCHAR(50) PATH '$')

) AS temp

);

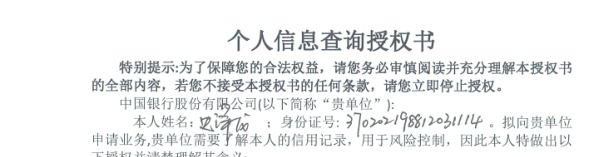

370202198812031114山东省 青岛市 市南区

性别 男

出生日期 1988年12月03日

年龄 36

校验结果 身份证号码校验位正确

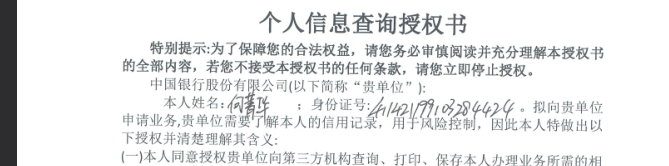

411421199103284424河南省 商丘市 民权县

性别 女

出生日期 1991年03月28日

年龄 34

校验结果 身份证号码校验位正确

考前复习

浙公网安备 33010602011771号

浙公网安备 33010602011771号