下载 Hugging Face 中的模型

免费、免魔法下载 Hugging Face 模型。可直接下载到无 GUI 的 Linux 服务器中。

先决条件

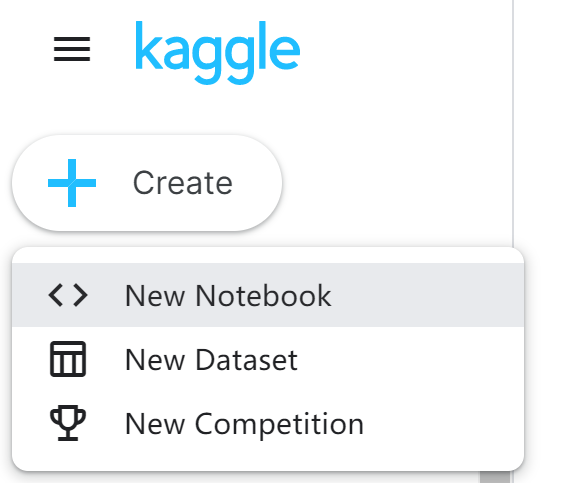

第一步 在 Kaggle 中下载模型

- 在 Kaggle 首页点击左上角的 Create 按钮,创建一个笔记本。

![]()

- 删除任何已有的代码。

- 在右侧控制栏开启 Internet。

![]()

- 插入并执行代码单元格:

from transformers import BertTokenizer, BertModel # 这里改成你要使用的分词器和模型 - 插入并执行代码单元格:

tokenizer = BertTokenizer.from_pretrained('*') # 这里改成你要使用的分词器名称 model = BertModel.from_pretrained('*') # 这里改成你要使用的模型名称 - 插入并执行代码单元格:

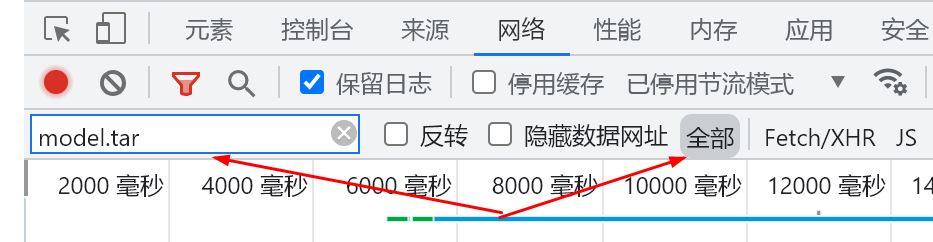

%%bash cd ~/.cache/huggingface/hub/ export NAME=$(ls | grep models--) tar -czvf /kaggle/working/model.tar.gz $NAME - 按 F12 打开开发人员工具,切换到“网络”或“Network”选项卡。在过滤项中输入“model.tar”,类别选择“全部”。

![]()

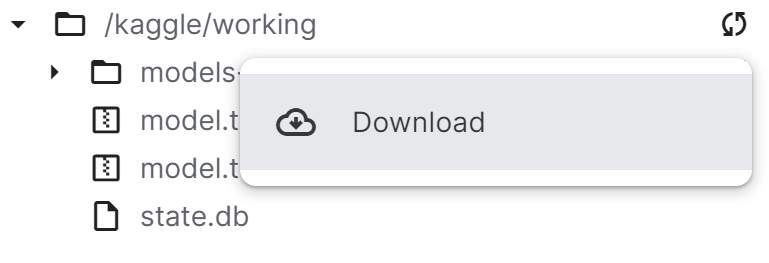

- 在右侧 Data 下的 Output 中找到 model.tar.gz,点击“Download”。

![]()

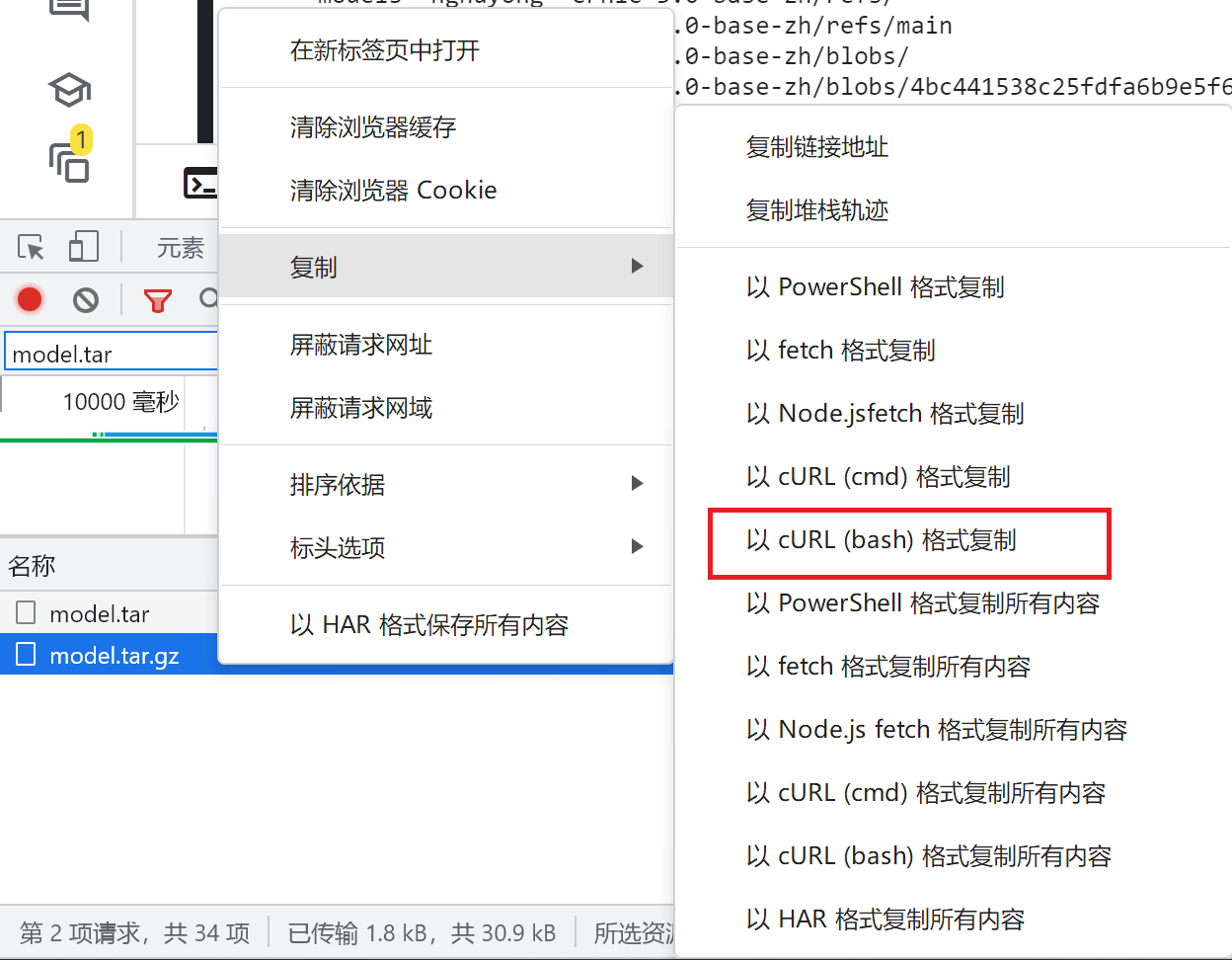

- 在开发人员工具中右击 model.tar.gz,复制,以 cURL (bash) 格式复制。

![]()

第二步 部署到目标位置

- 打开目标服务器的终端或使用 SSH 等连接到目标服务器。

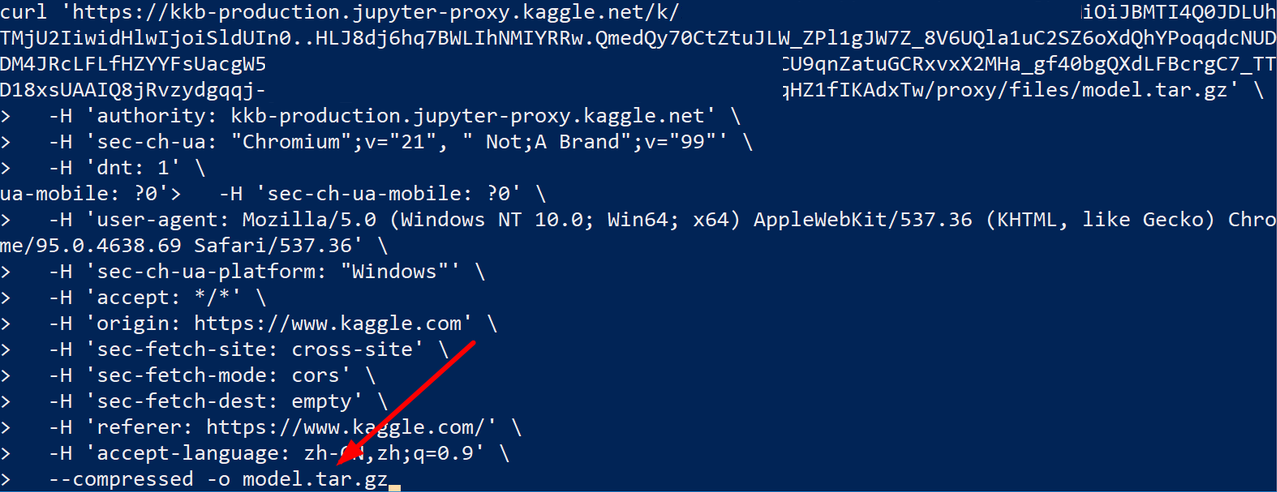

- 在终端中粘贴刚才复制的内容,并在其后附加

-o model.tar.gz![]()

- 解压到 Hugging Face 库所使用的目录

tar -xzvf model.tar.gz -C ~/.cache/huggingface/hub/ - 解压后删除压缩包

rm model.tar.gz

使用

通知 Transformers 库其处于离线状态

export TRANSFORMERS_OFFLINE=1

或在 Python 中导入 transformers 库前:

import os

os.environ["TRANSFORMERS_OFFLINE"] = "1"

或设置整个 conda 的环境变量:

conda env config vars set TRANSFORMERS_OFFLINE 1

然后重新激活该环境。

像在线一样使用

from transformers import BertTokenizer, BertModel # 这里改成你要使用的分词器和模型

tokenizer = BertTokenizer.from_pretrained('*') # 这里改成你要使用的分词器名称

model = BertModel.from_pretrained('*') # 这里改成你要使用的模型名称

浙公网安备 33010602011771号

浙公网安备 33010602011771号