论文解读(GRCCA)《 Graph Representation Learning via Contrasting Cluster Assignments》

论文信息

论文标题:Graph Representation Learning via Contrasting Cluster Assignments

论文作者:Chun-Yang Zhang, Hong-Yu Yao, C. L. Philip Chen, Fellow, IEEE and Yue-Na Lin

论文来源:2021, ArXiv

论文地址:download

论文代码:download

1 Introduction

将 cluster-local 一致性转换成节点级交叉熵。

2 Method

框架如下:

在本节中,将分两部分详细阐述所提出的 GRCCA。第一部分介绍 GRCCA 的总体框架,包括图的增强策略和模型结构。第二部分详细描述了该学习算法。

2.1 Data Argumentations

本文的数据增强策略:【数据增强策略的要求:既可以生成多个视图,又不会产生噪声】

-

- Graph Diffusion (GD) 关注全局视图

- Removing Edges (RE) 关注局部视图

2.1.1 Graph Diffusion (GD)

Graph diffusion 研究了超过 $\text{1-hop}$ 的信息传递,从而可以获得节点的长期依赖。

图扩散过程定义为:

$S=\sum\limits _{k=0}^{\infty} \theta_{k} T^{k}\quad\quad\quad(1)$

其中:

-

- $T$ 代表广泛的转移矩阵,$\mathbf{T}=\mathbf{D}^{-1 / 2} \mathbf{A} \mathbf{D}^{-1 / 2}$ ;

- ${\theta }_{k}$ 代表了权重参数,${\theta }_{k}=\alpha(1-\alpha)^{k}$,$\sum\limits _{k=0}^{\infty} \theta_{k}=1$, $\theta_{k} \in[0,1]$;

PPR kernel 可以由下式表达:

$S=\alpha\left(I-(1-\alpha) D^{-1 / 2} A D^{-1 / 2}\right)^{-1} \quad\quad\quad\quad(2)$

其中:

-

- $\alpha \in(0,1)$ 是随机游走的传送概率

2.1.2 Removing Edges (RE)

给定一个邻接矩阵 $A$ 和边删除概率 $P_{r e}$,随机去除现有的边:

$\widetilde{A}_{i j}=\left\{\begin{array}{ll} 1, & b_{i j}<P_{r e} \text { and } A_{i, j}=1 \\ 0, & \text { otherwise } \end{array}\right.\quad\quad\quad(3)$

其中,$ \widetilde{A} $ 是局部水平的增强,$b$ 表示从均匀分布$ U(0,1)$中抽样的随机数。

2.1.3 Masking Nodes Features (MNF)

给定一个属性矩阵 $X$ 和掩蔽矩阵 $P_{m n f}$ ,随机选择属性的维数来掩蔽:

$\tilde{X}_{i}=X_{i} \odot M\quad\quad\quad\quad(4)$

其中$ \tilde{X}$ 是属性增强矩阵,$ M \in\{0,1\}^{F}$是一个 $P_{m n f}$ 中一个百分比为零的向量。

该策略不会破坏多个视角之间的关系,也不会带入新噪声。

2.2 Encoder

本文采用 GCN Encoder 获得节点嵌入$H=f_{\theta}(X, A) $ :

$H=\sigma\left(\hat{D}^{-1 / 2} \hat{A} \hat{D}^{-1 / 2} X \Theta\right)\quad\quad\quad(6)$

进一步利用一个非线性投影仪 MLP,将节点嵌入转移到一个度量空间中,即 $Z=g_{\theta}(H) \in \mathbb{R}^{N \times F^{\prime}}$。

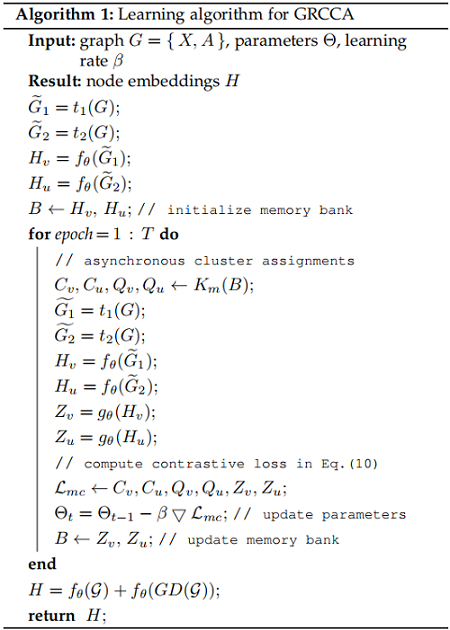

2.3 Learning Algorithm

获得两个视图的表示 $Z_{v}$ 和 $Z_{u}$ 后,应用 k-means ,得到各自聚类中心 $C_{v} \in \mathbb{R}^{K \times F^{\prime}}$ 和 $C_{u} \in \mathbb{R}^{K \times F^{\prime}} $($K$ 代表 cluster 数目),然后可以计算两个视图的聚类分配矩阵 $Q_{v}$ 和 $Q_{u}$。

给定任意一对相同的节点 $v_i$ 和 $u_i$,节点 $v_i$ 和节点 $u_i$ 的聚类分配 $Q_{u_{i}}$ 之间的一致性可以定义为:

$p_{v_{i}}=\operatorname{softmax}\left(z_{v_{i}} C_{u}^{\mathrm{T}} / \tau\right)\quad\quad\quad(7)$

GRCCA 将对比学习和聚类算法结合在一起,从两个增强视图最大化相同节点之间的 cluster-level 的一致性。

通过最小化交叉熵损失,保证了节点之间的一致性:

$\ell\left(q_{u_{i}}, p_{v_{i}}\right)=-q_{u_{i}} \log p_{v_{i}}\quad\quad\quad(8)$

因此,对比聚类损失可以定义为:

$\mathcal{L}_{c}=\frac{1}{N} \sum\limits _{i=0}^{N}\left[\ell\left(q_{v_{i}}, p_{u_{i}}\right)+\ell\left(q_{u_{i}}, p_{v_{i}}\right)\right]\quad\quad\quad(9)$

其中,

-

- $N$ 为节点数;

GRCCA采用了 多聚类策略 来增加 cluster-level 信息的多样性。具体来说,对两个视图分别抽取 $h$ 个聚类中心 $C_{v}^{i}$ 、$C_{u}^{i}$,然后分别计算 $h$ 个 聚类分配矩阵 $Q_{v}^{i}$、$Q_{u}^{i}$ 。因此,总损失:

$\mathcal{L}_{m c}=\frac{1}{h} \sum_{i=0}^{h} \mathcal{L}_{c}^{i}\quad\quad\quad(10)$

其中,$h$ 为对比材料的个数。

算法如 Algorithm 1:

3 Experiments

数据集

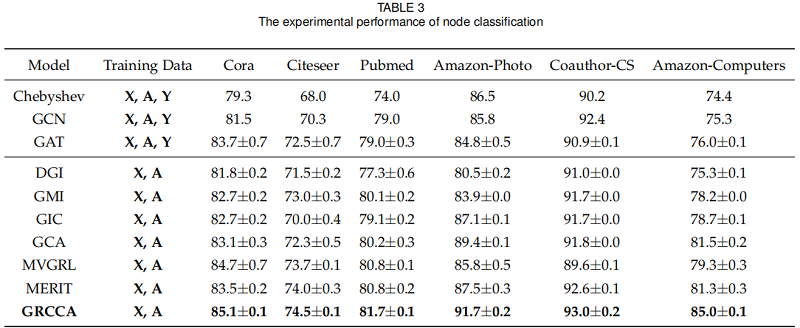

节点分类

无监督模型:DGI、GMI、MVGRL、GIC、GCA、MERIT,3个经典的GNN模型:ChebyshevGCN、GCN、GAT 作为基线。

对于三个引文网络,我们对每个类随机抽取20个节点来形成训练集,1000个节点作为测试集。而对于其他三个数据集,我们对每个类分别随机选择30个节点进行训练和验证,其余的节点用于测试。

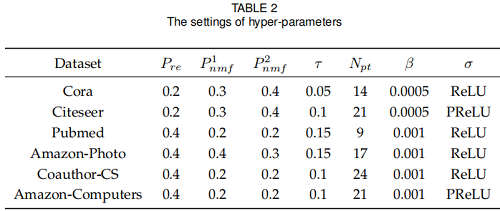

超参数设置:

结果:

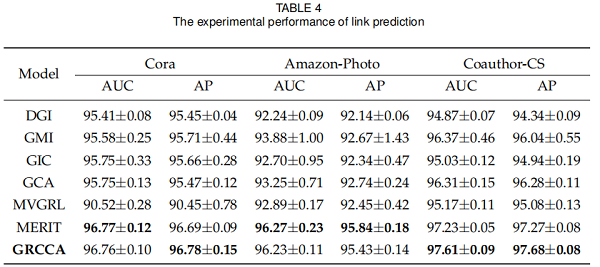

链接预测

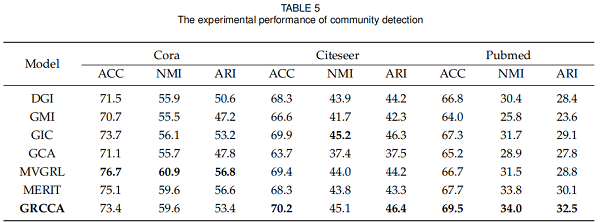

社区检测

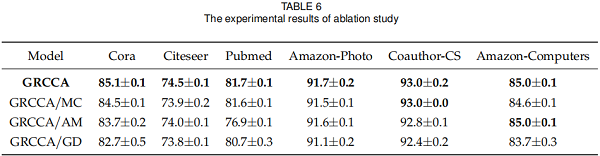

消融实验

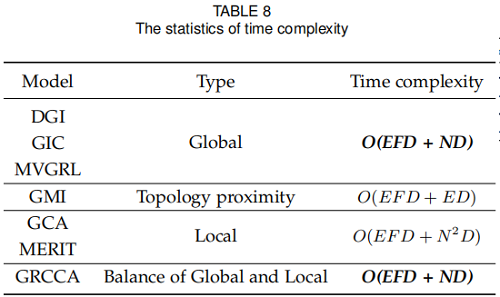

复杂度分析

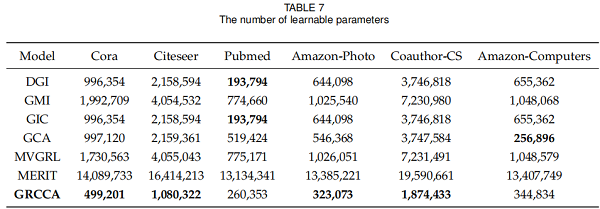

可学习参数的数量

4 Conclusion

想法挺不错,实验分析做的也不错,值得学习。

修改历史

2021-04-06 创建文章

2022-06-13 精读

因上求缘,果上努力~~~~ 作者:别关注我了,私信我吧,转载请注明原文链接:https://www.cnblogs.com/BlairGrowing/p/16107569.html

浙公网安备 33010602011771号

浙公网安备 33010602011771号