Rethinking Transformer for Long Contextual Histopathology Whole Slide Image Analysis

Rethinking Transformer for Long Contextual Histopathology Whole Slide Image Analysis

LongMIL:构建高秩且稀疏的掩码,从而减少自注意力的计算复杂度

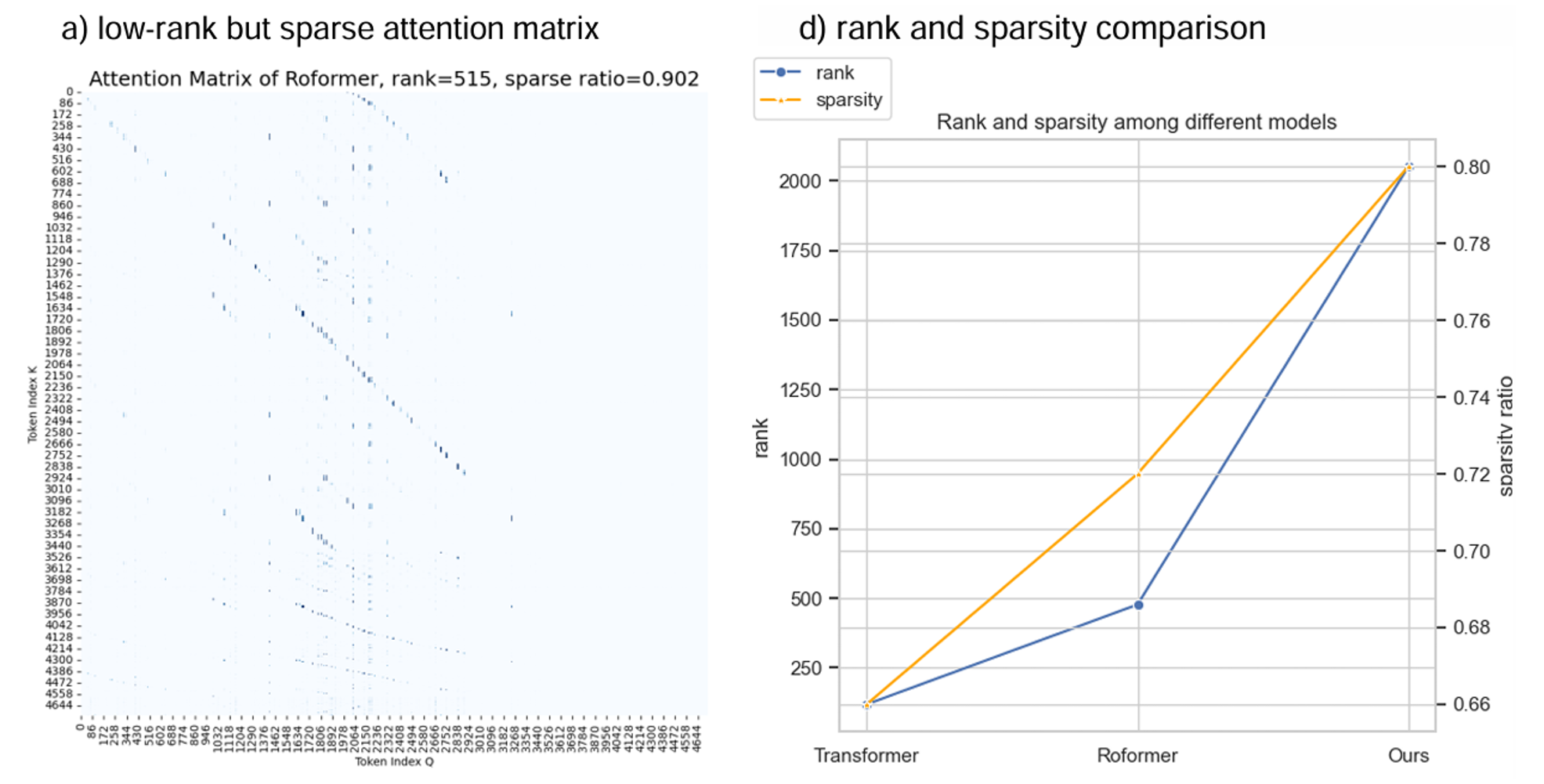

动机

病理图片WSI分析可以看作一个长序列问题。

当序列长度远大于特征长度时(\(n \gg d\)),transformer的浅层注意力更关注局部的上下文,而深层注意力更关注全局。然而,注意力矩阵的秩依然小,使得全局与局部层面的注意力交互混乱。\(2dn\)的点难以建模\(n\times n\)的关系。

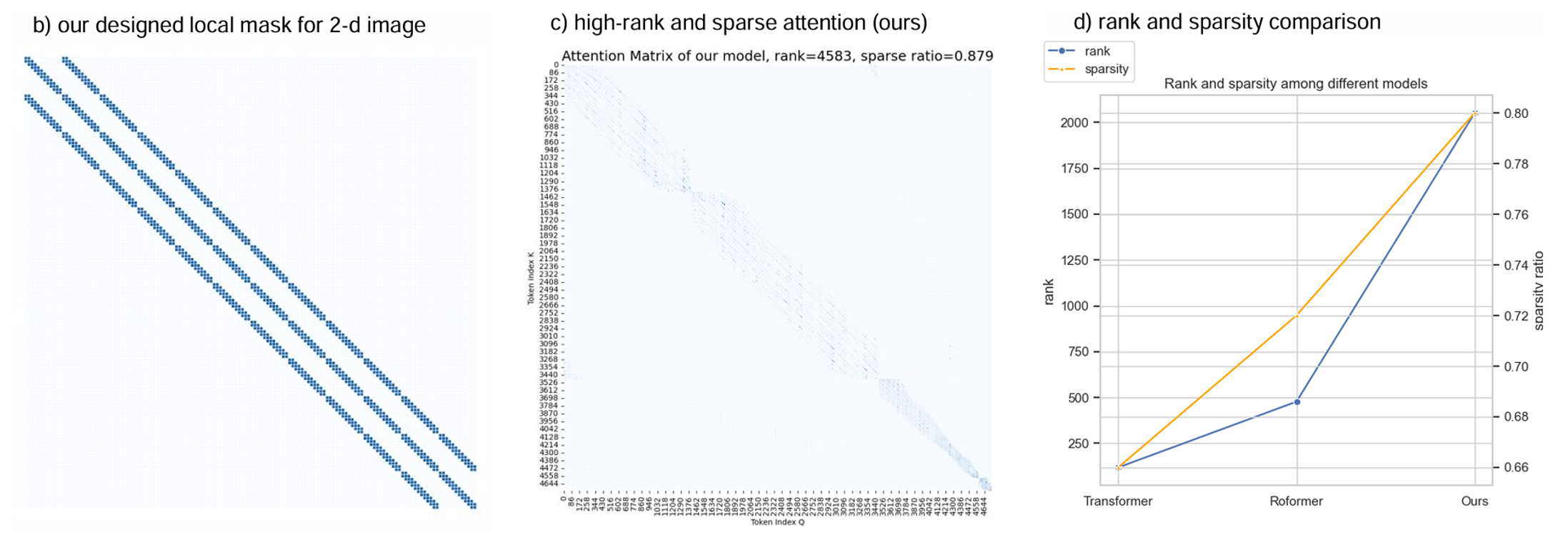

方法

每一层只关注局部的上下文关系 \(\rightarrow\) 高秩、更稀疏

最终整体的网络结构如图:

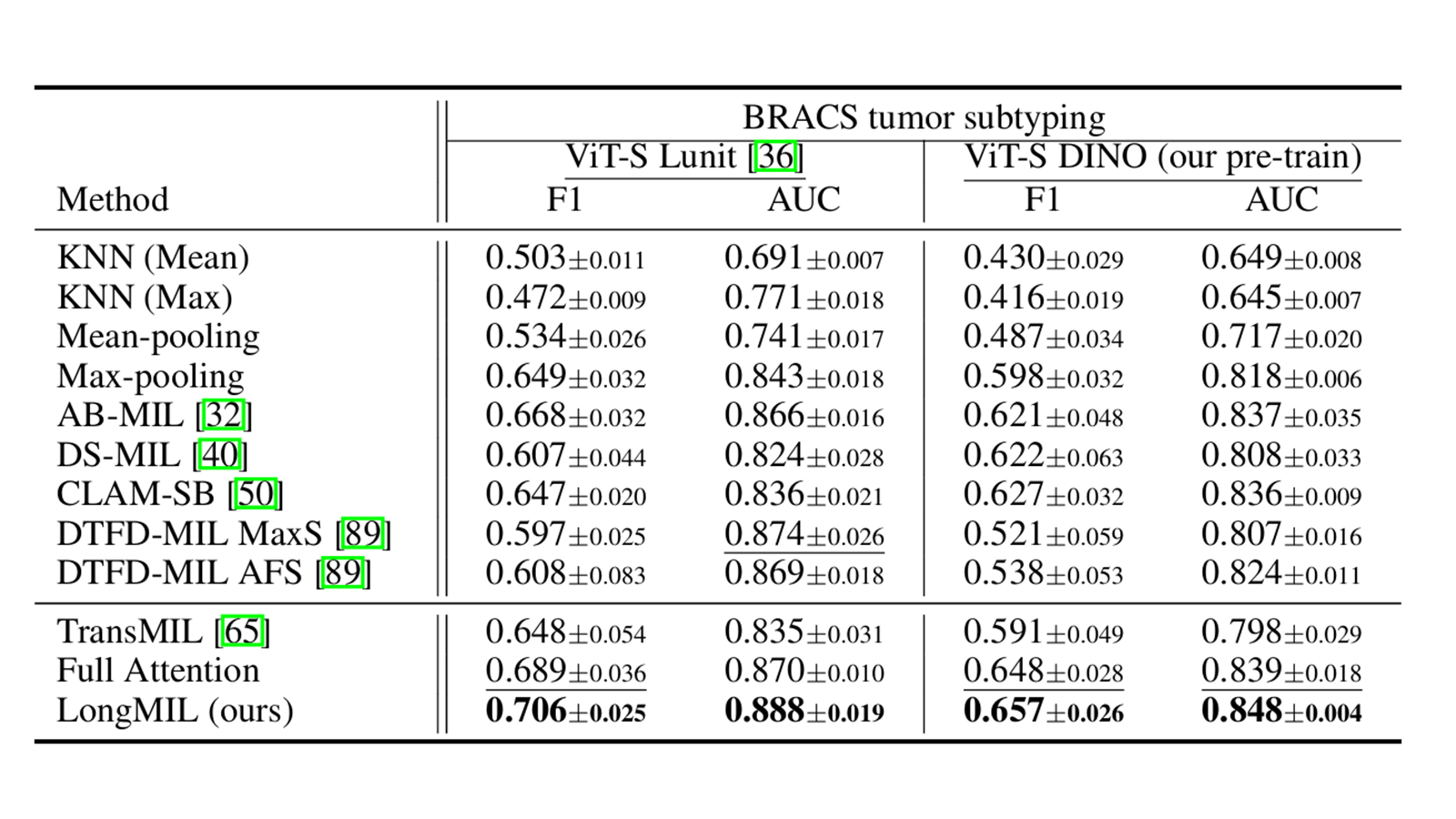

实验

总结

本文人工设计了一种自注意力掩码用于减少长序列场景下的Transformer计算复杂度。虽然没有经过严谨推导,但是本文方法的计算复杂度应该为\(\mathcal{O}(nd)\)。

浙公网安备 33010602011771号

浙公网安备 33010602011771号