深度学习基础(常见的网络2)

LeNet:基于渐变的学习应用于文档识别

AlexNet:具有深卷积神经网络的ImageNet分类

ZFNet:可视化和理解卷积网络

VGGNet:用于大规模图像识别的非常深的卷积网络

NiN:网络中的网络

GoogLeNet:卷入更深入

Inception-v3:重新思考计算机视觉的初始架构

ResNet:图像识别的深度残差学习

Stochastic_Depth:具有随机深度的深层网络

WResNet:非常深的网络的加权残差

Inception-ResNet:Inception-v4,inception-resnet以及剩余连接对学习的影响

Fractalnet:没有残差的超深层神经网络

WRN:宽残留网络

ResNeXt:深层神经网络的聚合残差变换

DenseNet:密集连接的卷积网络

PyramidNet:深金字塔残留网络

DPN:双路径网络

SqueezeNet:AlexNet级准确度,参数减少50倍,模型尺寸小于0.5MB

MobileNets:用于移动视觉应用的高效卷积神经网络

ShuffleNet:移动设备极高效的卷积神经网络

又可以这样分类:

CNN:

总结:利用权值共享【卷积操作】将神经网络本来的全连接层替换为非全连接层,使输入可以为尺度可变的张量。

可用结构:

(Max, mean)Pooling:降维;

全连接层:分类;

长短期记忆网络(LSTMs)-- 推荐文章

长期短期记忆 - 这是一种循环型神经网络(RNN),允许数据在网络中向前和向后流动。

LSTM适合于处理和预测时间序列中间隔和延迟非常长的重要事件,隐马尔可夫模型和其他序列学习方法给LSTM带来了优势 。

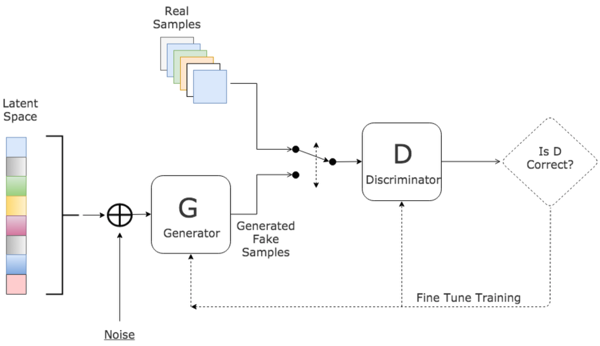

GAN:

总结:利用两个网络对抗生成模型,生成器与辨别器,生成器输入图像,生成所需图像,辨别器辨别所需图像与生成图像,使生成器的生成图像骗过辨别器。

可用结构:

CNN;(Recursive)Residual Network(残差(递归)网络);FCN(全卷积网络);convolutional LSTM;

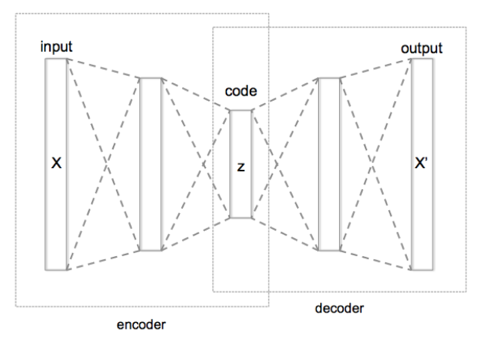

Autoencoder:

是一种人工神经网络,用于高效编码的无监督学习。

与GAN一样,并不是单纯的网络结构,只是类似PCA一样的东西,在无监督学习中的框架,利用conv与deconv降维升维来进行学习,分别叫做encoder与decoder编码解码,一般基于卷积网络,encoder后相当于学习到了特征,而decoder后相当于还原了图像,既可以用输入图像进行训练,训练好一层加深一层。再可以利用有监督微调,从而达到分类或者图像转换的目的。

可用结构:

CNN;Residual Network;

自动编码器的目的是学习一组数据的表示(编码),通常用于降维。 近来,自动编码器概念已经越来越广泛地应用于数据生成模型的学习当中。

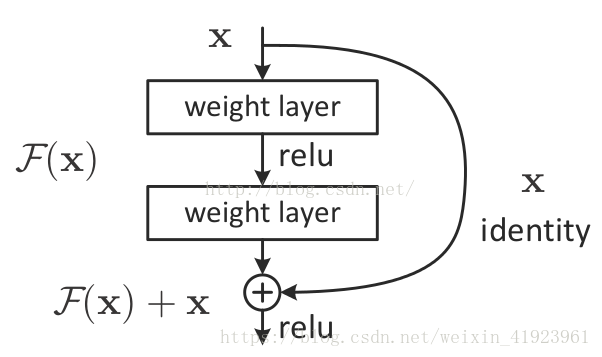

残差网络Resnet:

利用上一级的输入与结果相加来使深层网络效果更好(一个残差块一般不小于两层)。

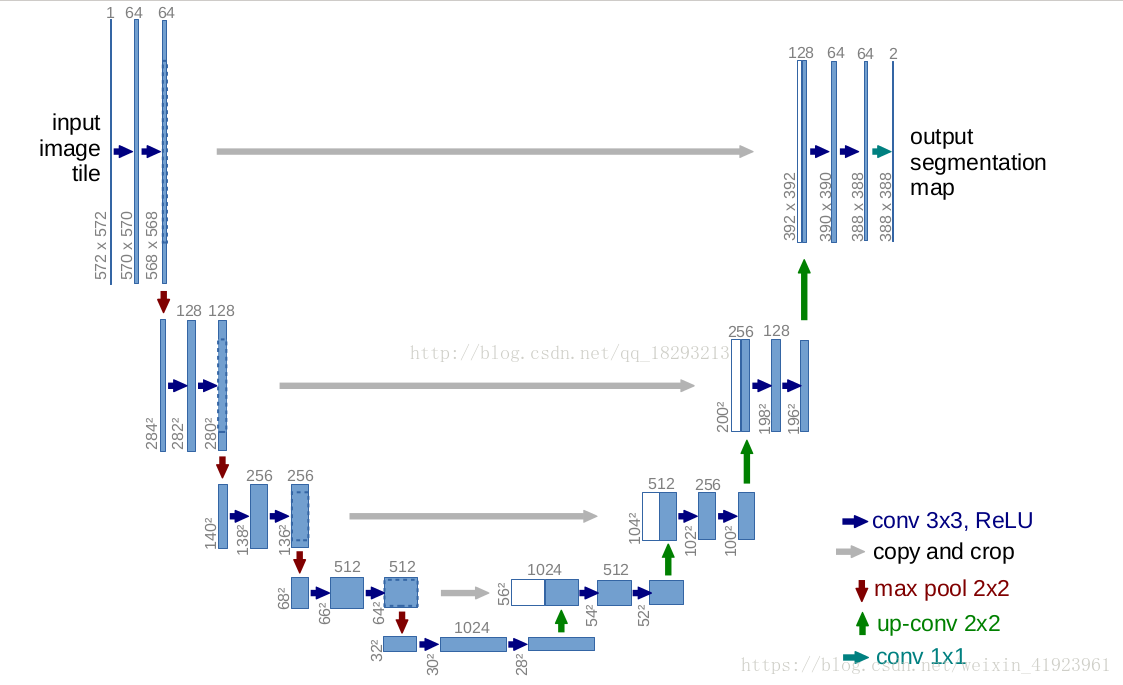

U-NET

也是encoder-decoder,利用前一encoder的信息与decoder信息结合,两者一一对应,共享信息。

[深度]强化学习 -- 推荐文章与 推荐文章

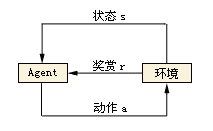

强化学习是智能系统从环境到行为映射的学习,以使奖励信号(强化信号)函数值最大,强化学习中由环境提供的强化信号是对产生动作的好坏作一种评价(通常为标量信号)

它的原理是:如果Agent的某个行为策略导致环境正的奖赏(强化信号),那么Agent以后产生这个行为策略的趋势便会加强。Agent的目标是在每个离散状态发现最优策略以使期望的折扣奖赏和最大。

浙公网安备 33010602011771号

浙公网安备 33010602011771号