吴恩达机器学习视频笔记——3

5、逻辑回归

5.1、分类问题

在分类问题中,你要预测的变量 𝑦 是离散的值,我们将学习一种叫做逻辑回归 (Logistic Regression) 的算法,这是目前最流行使用最广泛的一种学习算法。

我们从二元的分类问题开始讨论。我们将因变量(dependent variable)可能属于的两个类分别称为负向类( negative class)和正向类( positive class),则因变量 ,其中 0 表示负向类, 1 表示正向类。

,其中 0 表示负向类, 1 表示正向类。

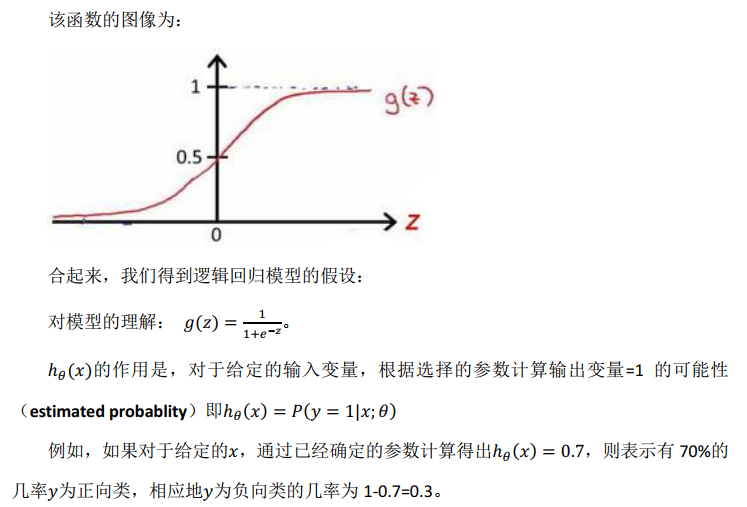

我们引入一个新的模型,逻辑回归,该模型的输出变量范围始终在 0 和 1 之间。 逻辑回归模型的假设是:  其中: 𝑋 代表特征向量 𝑔 代表逻辑函数( logistic function)是一个常用的路基函数为S形函数(Sigmoid function),公式为:

其中: 𝑋 代表特征向量 𝑔 代表逻辑函数( logistic function)是一个常用的路基函数为S形函数(Sigmoid function),公式为:

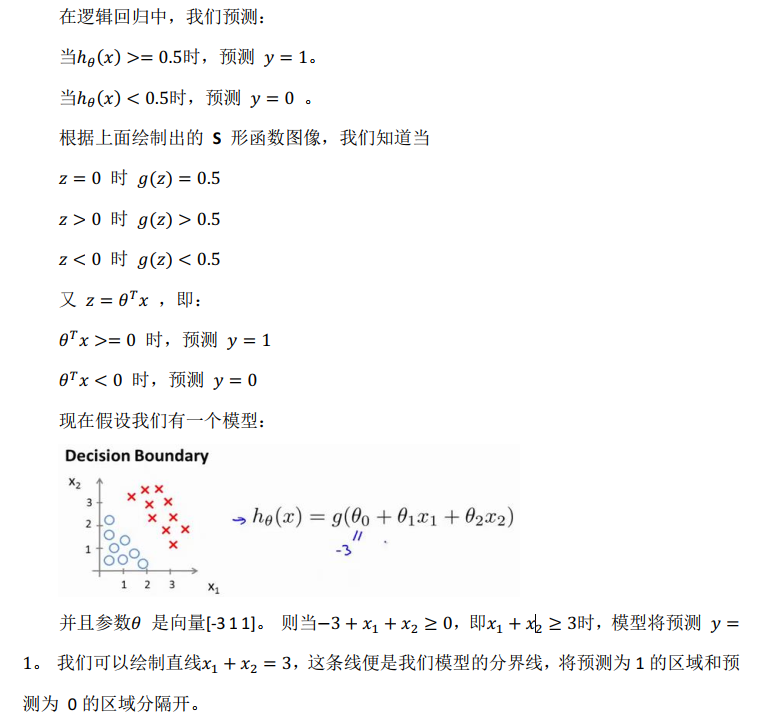

5.2、决策边界(Decision Boundary 判定边界)

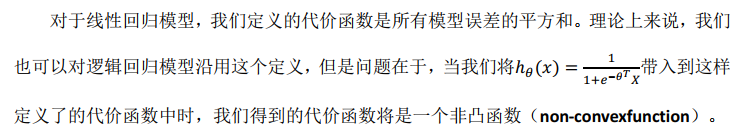

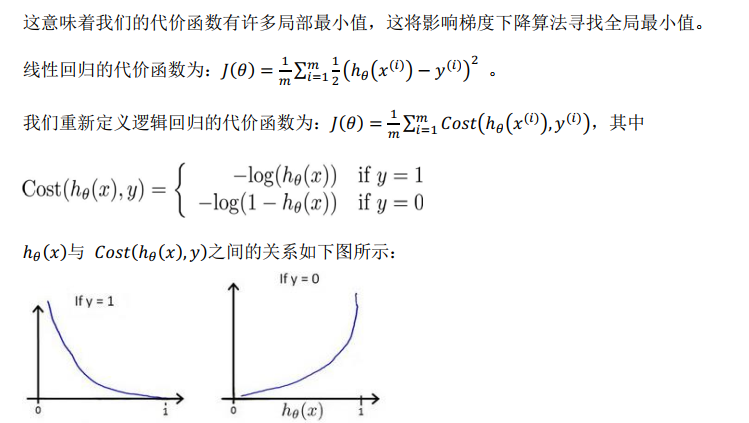

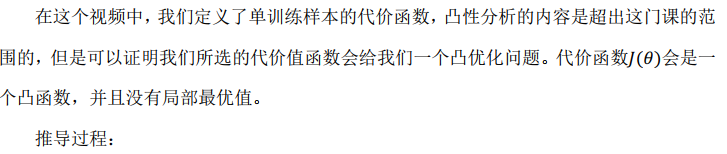

5.3、代价函数(Cost Function)

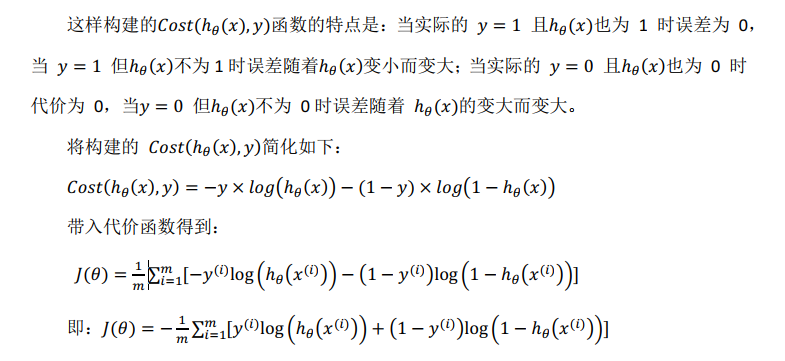

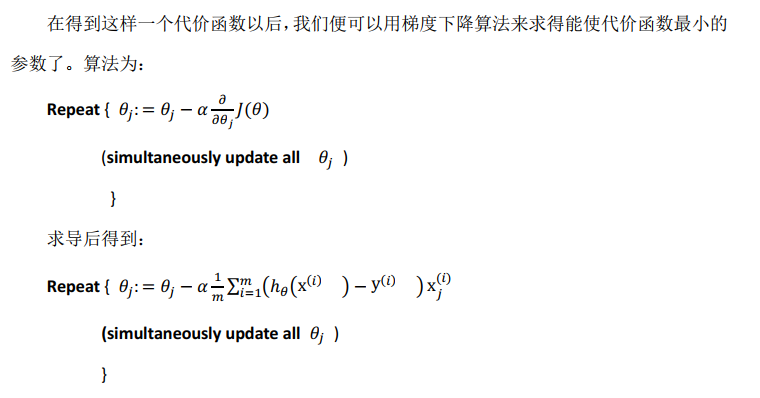

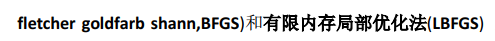

5.4、简化的成本函数和梯度下降

参考视频: 6 - 5 - Simplified Cost Function and Gradient Descent (10 min).mkv

5.5、高级优化概念及方法

参考视频: 6 - 6 - Advanced Optimization (14 min).mkv

梯度下降并不是我们可以使用的唯一算法,还有其他一些算法,更高级、更复杂。

计算导数项,然后使用比梯度下降更复杂的算法来最小化代价函数。

计算方面的专家。

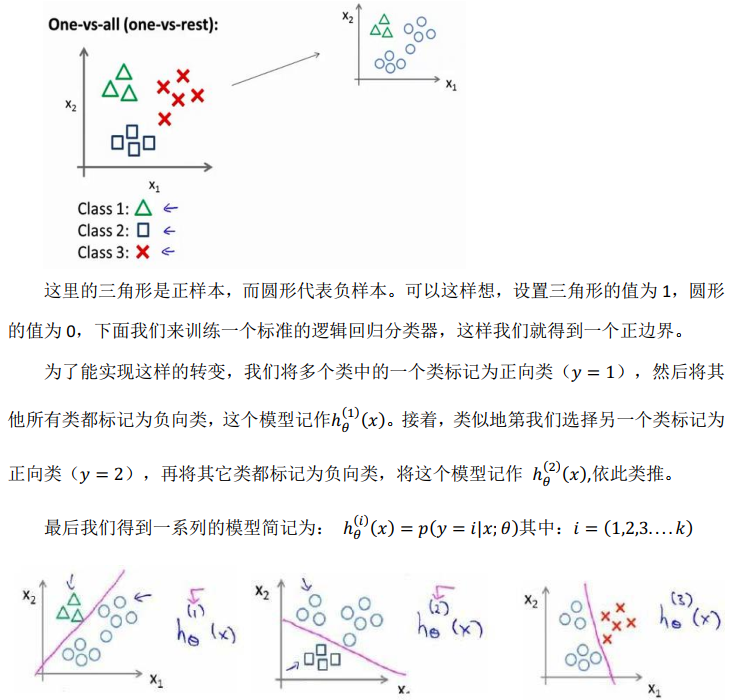

5.6、多分类问题

参考视频: 6 - 7 - Multiclass Classification_ One-vs-all (6 min).mkv

5.7、实例计算

实例计算部分可参见黄海广博士所附代码。

本博客主要引用文章如下:

作者:黄海广

链接:斯坦福大学2014机器学习教程个人笔记(V5.4)

来源:PDF

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

浙公网安备 33010602011771号

浙公网安备 33010602011771号