tensorRT安装

TensorRT (Tensor Runtime)是一款用于高性能深度学习推理的 SDK。它旨在与 TensorFlow、PyTorch 和 MXNet 等训练框架互补工作。它专注于在 NVIDIA 硬件上快速高效地运行已训练好的网络。

TensorRT 包含一个深度学习推理优化器和运行时,可为深度学习推理应用提供低延迟和高吞吐量。NVIDIA TensorRT 的核心是一个 C++ 库,用于在 NVIDIA GPU 上实现高性能推理。TensorRT 采用一个经过训练的网络(包含一个网络定义和一组经过训练的参数),并生成一个高度优化的运行时引擎来执行该网络的推理。

TensorRT处理模型参数得到engine,仅支持在单机单卡上运行,如果需要在多卡多机上,需要使用基于tensorRT开发的推理框架:tensorRT-LLM。相较于常见的推理框架vLLM,tensorRT不支持GPU以外的计算芯片,且部分代码使用C++。

查看服务器的基本参数

uname -a

#

Linux x 5.15.0-88-generic #98-Ubuntu SMP Mon Oct 2 15:18:56 UTC 2023 x86_64 x86_64 x86_64 GNU/Linux

nvidia-smi

#

Fri Mar 28 13:24:23 2025

+-----------------------------------------------------------------------------+

| NVIDIA-SMI 525.125.06 Driver Version: 525.125.06 CUDA Version: 12.0 |

在官网找到合适的版本下载,需要登录nvidia账号

TensorRT Download | NVIDIA Developer

我选择安装:TensorRT 10.9 GA for Linux x86_64 and CUDA 12.0 to 12.8 TAR Package

安装后得到压缩包:TensorRT-10.9.0.34.Linux.x86_64-gnu.cuda-12.8.tar.gz

解压:

tar -zxvf TensorRT-10.9.0.34.Linux.x86_64-gnu.cuda-12.8.tar.gz

测试下是否正常,进入目录并make:

cd TensorRT-10.9.0.34/samples/sampleOnnxMNIST

make

设置环境变量:

export LD_LIBRARY_PATH=/home/x/download/TensorRT-10.9.0.34/lib

运行测试下:

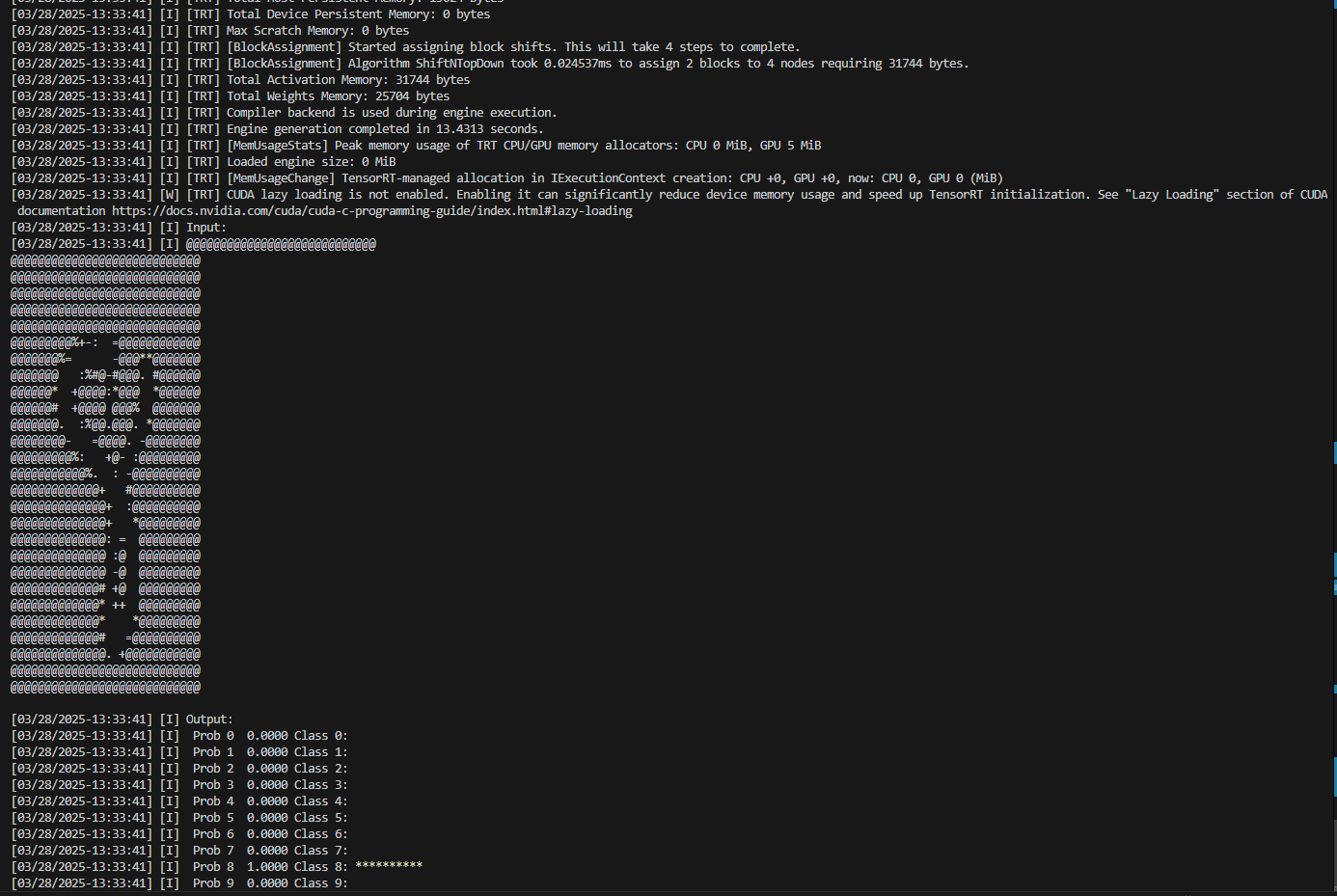

/home/x/download/TensorRT-10.9.0.34/bin/sample_onnx_mnist

浙公网安备 33010602011771号

浙公网安备 33010602011771号