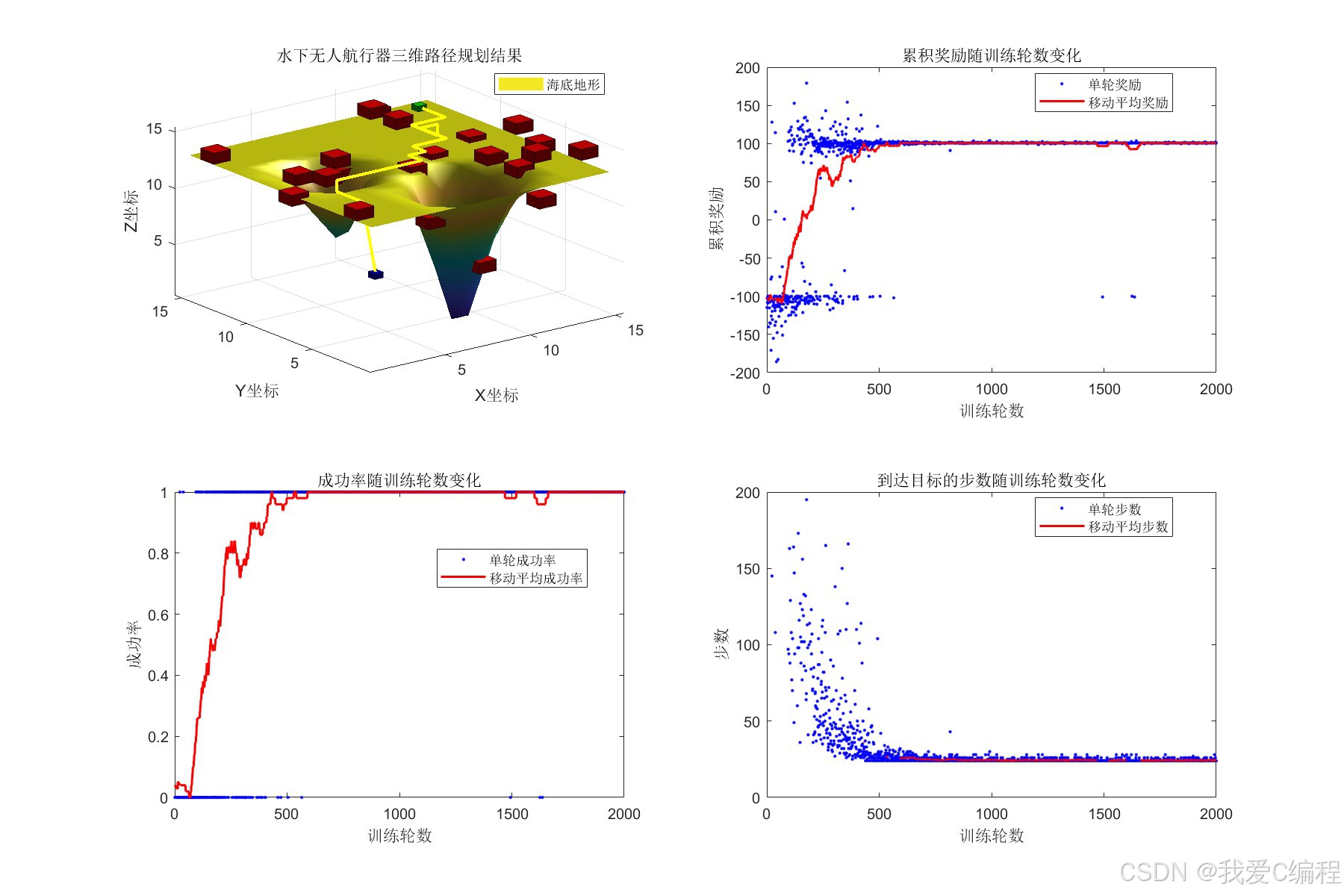

基于Qlearning强化学习的水下无人航行器三维场景路径规划与避障系统matlab性能仿真

1.引言

水下无人航行器(Unmanned Underwater Vehicle, UUV)的三维路径规划与避障是海洋工程领域的核心问题,其目标是在复杂水下环境(含礁石、沉船等静态障碍物及洋流等动态干扰)中,自主生成一条从起点到目标点的最优路径(满足最短距离、最低能耗等约束),并实时避开障碍物。强化学习(Reinforcement Learning, RL)中的Q-learning算法因无需预先建模环境动态特性、具备自主学习能力,成为解决该问题的有效方法。

2.算法仿真效果演示

3.数据集格式或算法参数简介

gridSize = 15; % 环境网格大小(三维) startPos = [2, 2, 8]; % 起始位置 [x,y,z] goalPos = [13, 13, 14]; % 目标位置 [x,y,z] numObstacles = 30; % 障碍物数量 maxEpisodes = 2000; % 训练轮数 maxSteps = 200; % 每轮最大步数 learningRate = 0.1; % 学习率 discountFactor = 0.99; % 折扣因子 explorationRate = 1.0; % 探索率 minExplorationRate = 0.01; % 最小探索率 explorationDecay = 0.995; % 探索率衰减率 collisionPenalty = -100; % 碰撞惩罚 goalReward = 100; % 到达目标奖励 distanceWeight = 0.05; % 距离奖励权重

4.算法涉及理论知识概要

强化学习的核心是智能体(Agent)与环境(Environment)的交互学习。在UUV路径规划中:

智能体:UUV 本身,负责感知环境状态并执行动作;

环境:三维水下空间,包含起点、目标点、静态/动态障碍物、洋流等;

状态(State, s):UUV在环境中的位置、姿态、与障碍物的相对距离等信息;

动作(Action, a):UUV的运动决策(如前进、后退、上升、下降等);

奖励(Reward, r):环境对动作的反馈(如靠近目标得正奖、碰撞障碍物得负奖);

策略(Policy, π):智能体从状态到动作的映射(即 “在状态s下选择动作a的概率”)。

UUV的目标是通过不断与环境交互,学习到最优策略π*,使从起点到目标点的累积奖励最大化。

浙公网安备 33010602011771号

浙公网安备 33010602011771号