虚拟化 -- kvm简介

一、虚拟化kvm发展史

2006 年 10 月由以色列的 Qumranet 组织开发的一种新的“虚拟机”方案,并将其贡献给开源世界

2007 年 2 月于 Linux Kernel-2.6.20 中第一次包含了 KVM

2008 年 9 月,红帽收购了 Qumranet ,由此入手了 KVM 的虚拟化技术。在之前红帽决是将Xen 加入到自己的默认特性当中——那是 2006 年,因为当时Xen技术脱离了内核的维护方式,也许是因为采用 Xen 的 RHEL 在企业级虚拟化方面没有赢得太多的市场,也许是因为思杰跟微软走的太近了,种种原因,导致其萌生了放弃 Xen。而且在正式采用 KVM 一年后,就宣布在新的产品线中彻底放弃 Xen ,集中资源和精力进行 KVM 的工作。

2009 年 9 月,红帽发布其企业级 Linux 的 5.4 版本( RHEL5.4 ),在原先的 Xen 虚拟化机制之上,将 KVM 添加了进来

2010 年 11 月,红帽发布其企业级 Linux 的 6.0 版本( RHEL6.0 ),这个版本将默认安装的 Xen 虚拟化机制彻底去除,仅提供 KVM 虚拟化机制

2011 年初,红帽的老搭档 IBM 找上红帽,表示 KVM 这个东西值得加大力度去做。于是到了 5 月, IBM 和红帽,联合惠普和英特尔一起,成立了开放虚拟化联盟( Open Virtualization Alliance ),一起声明要提升 KVM 的形象,加速 KVM 投入市场的速度,由此避免 VMware 一家独大的情况出现。联盟成立之时,红帽的发言人表示, 大家都希望除 “ VMware 之外还有一种开源选择。未来的云基础设施一定会基于开源。

自 Linux 2.6.20 之后逐步取代 Xen 被集成在Linux 的各个主要发行版本中,使用 Linux 自身的调度器进行管理。

二、KVM -- 基于内核的虚拟机(Kernel-based Virtual Machine)

KVM是一个开源软件,基于内核的虚拟化技术,实际是嵌入系统的一个虚拟化模块,通过优化内核来使用虚拟技术,该内核模块使得 Linux 变成了一个Hypervisor,虚拟机使用 Linux 自身的调度器进行管理。

KVM 是基于虚拟化扩展(Intel VT 或者 AMD-V)的 X86 硬件的开源的 Linux 原生的全虚拟化解决方案。KVM 中,虚拟机被实现为常规的 Linux 进程,由标准 Linux 调度程序进行调度;虚机的每个虚拟 CPU 被实现为一个常规的 Linux 进程。这使得 KMV 能够使用 Linux 内核的已有功能。但是,KVM 本身不执行任何硬件模拟,需要客户空间程序通过 /dev/kvm 接口设置一个客户机虚拟服务器的地址空间,向它提供模拟的 I/O,并将它的视频显示映射回宿主的显示屏。目前这个应用程序是 QEMU。

三、Linux 上的用户空间、内核空间、虚机:

Guest:客户机系统,包括CPU(vCPU)、内存、驱动(Console、网卡、I/O 设备驱动等),被 KVM 置于一种受限制的 CPU 模式下运行。

KVM:运行在内核空间,提供CPU 和内存的虚级化,以及客户机的 I/O 拦截。Guest 的 I/O 被 KVM 拦截后,交给 QEMU 处理。

QEMU:修改过的为 KVM 虚机使用的 QEMU 代码,运行在用户空间,提供硬件 I/O 虚拟化,通过IOCTL /dev/kvm 设备和 KVM 交互。

kvm.ko:KVM的内核模块,只用于管理虚拟 CPU 和内存。IO 的虚拟化,就交给 Linux 内核和qemu来实现。

Libvirt: KVM 的管理工具(Libvirt 除了能管理 KVM 这种 Hypervisor,还能管理 Xen,VirtualBox 等;OpenStack 底层也使用 Libvirt),Libvirt包含 3 个东西:后台daemon程序libvirtd、API 库和命令行工具virsh。

(1)libvirtd是服务程序,接收和处理 API 请求;

(2)API 库使得其他人可以开发基于 Libvirt 的高级工具,比如 virt-manager,这是个图形化的 KVM 管理工具。

(3)virsh 是我们经常要用的 KVM 命令行工具。作为 KVM 和 OpenStack 的实施人员,virsh 和 virt-manager 是一定要会用的。

四、虚拟化VT开启确认

KVM 本身也有一些弱点,那就是相比裸金属虚拟化架构的 Xen、VMware ESX 和 HyperV , KVM 是运行在 Linux 内核之上的寄居式虚拟化架构,会消耗比较多的计算资源;不过针对这一点, Intel 、 AMD 已经在处理器设计上有专门的VT-x 和 AMD-V 扩展,这种特性在每次硬件更新的时候也会更新,往往每次更新后都对虚拟化性能和速度上有明显的提升,所以长远来看,也不是什么大问题。

KVM 的虚拟化需要硬件支持(需要处理器支持虚拟化:如 Intel 厂商的 Intel-VT ( vmx )技术&&AMD 厂商的 AMD-V ( svm )技术。是基于硬件的完全虚拟化。而 Xen 早期则是基于软件模拟的半虚拟化( Para-Virtualization ),新版本则是基于硬件支持的完全虚拟化。但 Xen 本身有自己的进程调度器,存储管理模块等,所以代码较为庞大。

1、如何查看当前的 CPU 是否支持 VT 技术?

(1) windows 可以使用 cpu-z 软件来进行测试

(2) Linux 可以查看CPU的相关信息来确定

2、CPU 虚拟化有哪些好处?

CPU 的虚拟化技术可以将单 CPU 模拟多 CPU 并行,允许一个平台同时运行多个操作系统,并且应用程序都可以在相互独立的空间内运行而互不影响,从而显著提高计算机的工作效率。

3、虚拟化技术与多任务超线程的技术有何区别?

虚拟化技术与多任务以及超线程技术是完全不同的。多任务是指在一个操作系统中多个程序同时并行运行,而在虚拟化技术中,则可以同时运行多个操作系统,而且每一个操作系统中都有多个程序运行,每一个操作系统都运行在一个虚拟的 CPU 或者是虚拟主机上;而超线程技术只是单 CPU 模拟双 CPU 来平衡程序运行性能,这两个模拟出来的 CPU 是不能分离的,只能协同工作

五、KVM虚拟化安装

1、安装kvm前准备工作

(1)确定处理器有 VT

grep vmx /proc/cpuinfo (INTEL 芯片 )

grep svm /proc/cpuinfo (AMD 芯片 )

cat /proc/cpuinfo | grep -e vmx -e nx -e svm

假如不知道芯片的生产厂商则输入:egrep '(vmx|svm)' /proc/cpuinfo

[root@localhost ~]# egrep '(vmx|svm)' /proc/cpuinfo flags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr pge mca

cmov pat pse36 clflush mmx fxsr sse sse2 ss syscall nx pdpe1gb rdtscp lm

constant_tsc arch_perfmon nopl xtopology tsc_reliable nonstop_tsc eagerfpu

pni pclmulqdq vmx ssse3 fma cx16 pcid sse4_1 sse4_2 x2apic movbe popcnt tsc

_deadline_timer aes xsave avx f16c rdrand hypervisor lahf_lm abm ssbd ibrs

ibpb stibp tpr_shadow vnmi ept vpid fsgsbase tsc_adjust bmi1 avx2 smep bmi2

invpcid xsaveopt arat spec_ctrl intel_stibp flush_l1d arch_capabilities

如上图所示:如果 flags:里有 vmx 或者 svm 就说明支持 VT ;如果没有任何的输出,说明你的 cpu 不支持,将无法成功安装 KVM 虚拟机。

(2)当你硬件本身支持虚拟化,但查询相应参数无果时,请检查 BIOS 设定,确认你的 BIOS 中开启了硬件支持虚拟化的功能,将如下选项设为Enabled

Intel(R) Virtualization Tech [Enabled]

2、安装 KVM 的相关要求

(1)64bitCPU( 支持虚拟化 VT-x or AMD-V)

(2)2G 以上空闲内存,确认内存大小

grep -e MemTotal /proc/meminfo

free -m

(3)6GB 空闲存储空间

3、安装 KVM 并检测

(1)YUM 安装 KVM

[root@localhost ~]# yum install kvm virt-manager libvirt libvirt-python python-virtinst libvirt-client qemu-kvm qemu-img

(2)YUM 安装 KVM( 简单版 )

[root@localhost ~]# yum install kvm virt-manager libvirt*

(3)如果无法连入互联网 , 可自行建立源来完成安装并避免各种关联。建立一个本地的 YUM 源:

[root@localhost ~]#vim /etc/yum.repos.d/kvms.repo

[kvms]

name=Red Hat

baseurl=file:///mnt/cdrom/

enabled=1

gpgcheck=0

(4)kvm虚拟化所需组件介绍

kvm: 核心套件

virt-manager: 图形化 KVM 管理软件

libvirt: 提供虚拟机与宿主相互通信的机制

libvirt-python: 允许使用 libvirt API

python-virtinst: CLI 下创建 KVM 的工具

libvirt-client: 提供 client 访问 kvm 服务器的机制 ,并包含 virsh 命令进行管理和控制 VMs

qemu-kvm: 提供用户级 KVM 环境

qemu-img: VMS磁盘管理

3.启动 KVM

(1)modprobe kvm 加载 kvm 模块

(2)lsmod | grep kvm 查看加载成功

(3)systemctl start libvirtd

(4)systemctl status libvirtd

4. 启动并检测 KVM

virsh list --all

如出现

Id Name State

-------------------------------------------------------

则安装成功

5. 在 GUI 模式下安装虚拟机,启动虚拟系统管理器

五、KVM网络模式设置

1. NAT ( 默认上网 ) :虚拟机利用 host 机器的 ip 进行上网 . 对外显示一个 ip,

virbr0 是 KVM 默认创建的一个 Bridge,其作用是为连接其上的虚机网卡提供 NAT 访问外网的功能,默认ip为192.168.122.1

2. 自带的Bridge : 将虚拟机桥接到 host 机器的网卡上 ,vm和 host 机器都通过 bridge 上网 . 对外有同网段的不通 ip,此种方式host却不能和vm联通

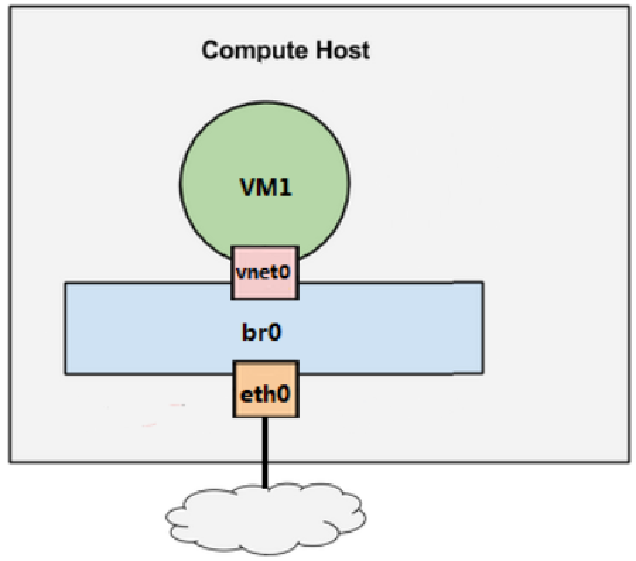

3. Linux Bridge : 基本原理就是创建一个桥接接口 br0 ,在物理网卡和虚拟网络接口之间传递数据。此种方式host却可以和vm联通

Linux Bridge 是 Linux 上用来做 TCP/IP 二层协议交换的设备,其功能大家可以简单的理解为是一个二层交换机或者 Hub。多个网络设备可以连接到同一个 Linux Bridge,当某个设备收到数据包时,Linux Bridge 会将数据转发给其他设备

(1)添加 br0 网卡的配置文件

cd /etc/sysconfig/network-scripts

cp ifcfg-eth0 ifcfg-br0

(2)修改网卡配置文件

Vim ifcfg-eth0

TYPE=Ethernet

NAME=eth0

DEVICE=eth0

ONBOOT=yes

BRIDGE=br0

Vim ifcfg-br0

TYPE=Bridge

NAME=br0

DEVICE=br0

ONBOOT=yes

BOOTPROTO=none

IPADDR=192.168.254.20

PREFIX=24(NETMASK=255.255.255.0)

GATEWAY=192.168.254.1

DNS=192.168.254.251

(3)重启host:reboot

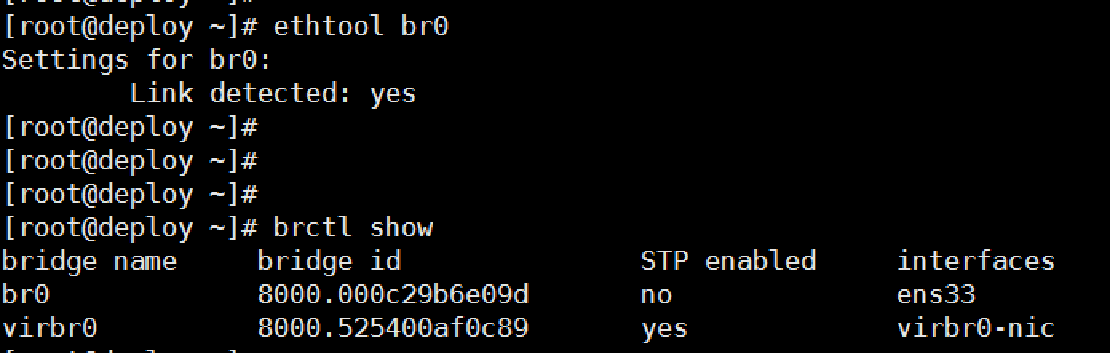

(4)检查

# ethtool br0

# brctl show

# ifconfig br0

浙公网安备 33010602011771号

浙公网安备 33010602011771号