寒假自学进度2

今天主要进行了spark的安装 本来这部分是比较简单的 但是由于自己之前使用的jdk版本是1.7导致Spark的安装出现了问题(jdk版本较低造成的)然后我接下来进行了jdk版本的升级,以及解决了一些由于操作不当出现的新问题,关于spark的伪分布式集群部署还在学习,请见后续.

1.没有卸载jdk1.7直接下载了jdk1.8

sudo yum install java-1.8.0-openjdk java-1.8.0-openjdk-devel

vim ~/.bashrc

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk

这是我自己的 上面的是官方配置(可能还有其它处需要配置)(注意看下载之后的版本是啥进行相应替换)

source ~/.bashrc# 使变量设置生效

echo $JAVA_HOME # 检验变量值

java -version

$JAVA_HOME/bin/java -version # 与直接执行 java -version 一样

如果设置正确的话,$JAVA_HOME/bin/java -version 会输出 java 的版本信息,且和 java -version 的输出结果一样

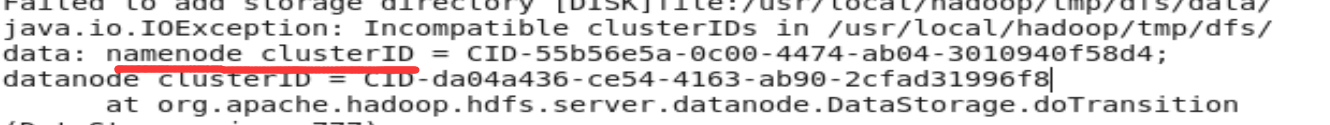

2.执行多次(./bin/hdfs namenode -format)NameNode格式化(应该执行一次即可) 然后启动Hadoop出错

jps显示进程 发现没有DataNode解决如下:

查看DataNode日志/usr/local/hadoop/logs/hadoop-hadoop-datanode-什么什么以.log结尾。注意:

- 每一次的启动日志都是追加在日志文件之后,所以得拉到最后面看,看下记录的时间就知道了。

- 一般出错的提示在最后面,也就是写着 Fatal、Error 或者 Java Exception 的地方。

我的出错信息为(一般由于多次格式化NameNode导致。在配置文件中保存的是第一次格式化时保存的namenode的ID,因此就会造成datanode与namenode之间的id不一致。)

解决办法为 进入/usr/local/hadoop/tmp/dfs/data/current/version

将clusterID 替换为 上述红线标的id即可

3.然后spark的简单安装 参考http://dblab.xmu.edu.cn/blog/804-2/即可较为简单

关于集群部署目前只参考了http://dblab.xmu.edu.cn/blog/1187-2/

浙公网安备 33010602011771号

浙公网安备 33010602011771号